Actualités du mois de janvier 2010 (Matériel)

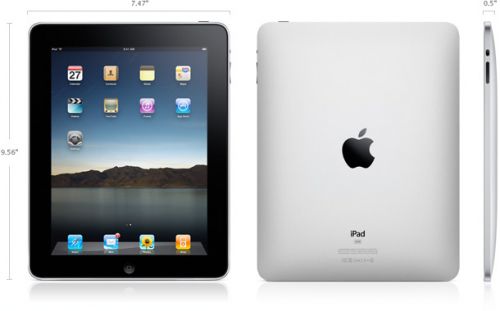

Annoncée par de nombreuses rumeurs depuis des mois et très attendue par la communauté Apple, la tablette tactile du constructeur à la pomme a été présentée en baptisée officiellement aujourd'hui : il faudra désormais l'appeler iPad.

Ressemblant à un gros iPod Touch, l'iPad est finalement sans grande surprise, conformer à la plupart des rumeurs, mais pas forcément les plus optimistes... Commençons par le matériel. L'iPad se présente sous la forme d'une fine tablette de 1.34cm d'épaisseur pour 24.3cm de long et 19cm de large. Le gros de la surface supérieure est occupé par un écran 9.7" d'une résolution de 1024x768. Il est bien entendu tactile multitouch. Par contre, point d'OLED ici, puisqu'il s'agit d'un écran IPS à rétroéclairage LED.

À l'intérieur, on trouve une puce SoC conçue par Apple (probablement via sa filiale P.A. Semi) et cadencée à 1 GHz, 16 à 64 Go d'espace de stockage flash, une puce Wi-Fi 802.11a/b/g/n, une puce Bluetooth 2.1+EDR, un magnétomètre (boussole), des accéléromètres et une imposante batterie de 25 Wh assurant 10h d'autonomie en surf via Wi-Fi. En option, l'iPad peut également être équipée d'une connectivité cellulaire (GSM/EDGE quadri-bande et UMTS/HSDPA tri-bande) et d'une puce A-GPS. Curieusement, cette version cellulaire ne pourra se connecter qu'à un réseau de données, pas à un réseau voix. La connectique et les boutons sont pour leur parts identiques à ceux de l'iPhone.

La partie logicielle risque également d'en décevoir plus d'un. En effet, nombreux sont ceux qui espéraient (sans trop y croire...) une tablette fonctionnant sous Snow Leopard, qui irait concurrencer les tablettes PC sous Windows 7, mais la tablette présentée par Apple tournera finalement comme prévu sous un système dérivé de celui de l'iPhone, avec toutes les restrictions que ça implique : accès très limité au système de fichiers, applications obligatoirement distribuées via l'App Store, pas de multitâches... Apple a par contre comme à son habitude porté beaucoup de soin à l'ergonomie des applications, en tirant bien partie de la plus grande taille de l'écran. Les applications iPhone existantes pourront fonctionner sur l'iPad, tandis que les nouvelles applications pourront être développées dans des versions spécifiques à l'iPad, grâce au nouveau SDK publié aujourd'hui. Apple donne d'ailleurs l'exemple avec une version de la suite iWork spécialement adaptée à l'iPad, qui sera vendue à raison de 10$ par logiciel (Pages, Numbers et Keynote).

Enfin, Apple pour accompagner l'iPad, Apple se lance dans la vente en ligne de livres numériques, via l'iBook Store et proposera également différents accessoires : un dock classique, un dock intégrant un clavier de taille standard, des lecteurs de cartes mémoire, etc...

Terminons avec le côté douloureux de la tablette : les tarifs ! Le modèle d'entrée de gamme (16 Go sans réseau cellulaire) sera proposé à 499$, le modèle 32 Go à 599$ et le modèle 64 Go à 699$. Il faudra encore rajouter 130$ pour bénéficier de la connectivité cellulaire, quelque soit la capacité, soit un prix total de 829$ pour le modèle le plus haut de gamme. L'appareil devrait être disponible dans moins de deux mois aux USA, et au début de l'été dans le reste du monde.

Posté par Matt le 27/01/2010 à 23h17

7 commentaires

Si la comparaison des processeurs à leur fréquence commerciale est la plus intéressante pour le consommateur, afin de savoir ce qu'il aura pour son argent, il existe une autre comparaison intéressante pour les amateurs de matériel : la comparaison à fréquence égale, permettant de mettre en évidence l'efficacité des différentes architectures. C'est la comparaison à laquelle s'est attelée notre confrère Tom's Hardware...

Pour ce faire, notre confrère a comparé quatre processeurs cadencés à 2.8 GHz : un bon vieux Core 2 Quad (Q9550s), un AMD Phenom II X4 (965), un Intel Core i5 (750) et un Intel Core i7 (920). Sans surprise, c'est le Core i7 qui s'en sort le mieux, avec une légère avance sur le Core i5. Un bon cran derrière, on retrouve le Core 2 Quad, suivit par le Phenom II X4. Notez tout de même que ce dernier est celui qui dispose de la fréquence commerciale la plus élevée (3.4 GHz), même si celle-ci reste insuffisante pour recoller avec les puces haut de gamme d'Intel.

Les choses se compliquent encore un peu pour AMD lorsqu'on se penche sur la consommation, le Phenom se classant seulement 3ème, juste devant le Core i7, tant que la consommation au repos que sur la consommation en pleine charge. Il termine par contre dernier sur la consommation moyenne pendant un ensemble de test, mais aussi sur la consommation totale durant cet ensemble de test, avec un écart encore plus marqué que sur la consommation moyenne (du fait que le test dure plus longtemps, en plus de consommer plus). Ainsi, sur une passe de PCMark Vantage, le Phenom II X4 consomme 70% d'énergie en plus par rapport au Core i5, tout en étant sensiblement plus lent !

Si AMD a fait de gros progrès avec ses Phenom II X4, en arrivant à un niveau de performance proche de celui des Core 2 Quad, il montre également que le fondeur a encore de gros progrès à faire en termes de consommation pour reprendre le leadership à Intel.

Posté par Matt le 25/01/2010 à 23h51

Aucun commentaire

Source : Tom's Hardware

Il y a quelques semaines, nous évoquions l'arrivée du boîtier Orange Box, un nouveau décodeur TV à coupler à la Live Box, et qui intégrera un lecteur de disques Blu-ray et pourra être utilisé comme console de jeu. On en sait désormais un peu plus sur la configuration matérielle de la bestiole.

Surprise : selon le CEO d'Intel en personne, ce nouveau décodeur sera basé sur une architecture x86 et, plus précisément, sur une puce Intel Atom CE4100 "Sodaville". Cette puce est un SoC (System on a chip) basé comme son nom l'indique sur l'architecture Atom. Le CE4100 embarque un cœur Atom à 1.2 GHz, un cœur graphique GMA 500 (avec sortie HDMI 1.3a), 512 Ko de cache L2, deux décodeurs vidéo capables de traiter chacun un flux 1080p compressé en H.264, un contrôleur mémoire DDR2/DDR3, ainsi que les habituels SATA 3 Gbits/s et USB 2.0.

Cette puce pourrait donc contenir quasiment tout le nécessaire pour l'Orange Box, puisqu'il ne manquerait apparemment que l'interface réseau et les convertisseurs nécessaires pour proposer des sorties autres que l'HDMI. Par contre, avec un GMA à 200 MHz, il ne faudra pas s'attendre à des performances exceptionnelles dans le domaine des jeux vidéos, où l'Orange Box ne rivalisera probablement même pas avec les consoles d'anciennes génération. Mais il est vrai qu'en termes de jeux vidéos sur box ADSL, la concurrence n'a pour l'instant pas mis la barre très haut...

Posté par Matt le 21/01/2010 à 10h20

Aucun commentaire

Source : Tom's Hardware

C'est bien connu, les geeks de base sont des individus mâles débordants d'hormones, et il suffit de leur faire présenter un produit par une charmante demoiselle pour déclencher une vague d'achat compulsifs... C'est en tout cas ce que semble croire le département marketing de Cooler Master, avec le lancement de CMHD.tv.

Comme son nom l'indique, ce site est destiné à héberger des présentations en vidéo HD des produits Cooler Master. Mais les présentations n'y seront pas effectuées par des techniciens ou des ingénieurs un peu disjonctés (ou des acteurs se faisant passer pour...) comme c'est souvent le cas chez les constructeurs informatiques, mais plutôt par des demoiselles sans doute plus habituées aux magazines masculins qu'aux magazines informatiques... C'est ainsi que Amanda Gift, miss janvier du site, se retrouve à nous expliquer la différence entre les boîtiers CM 690 II et un CM 690 II Advanced :

Si la demoiselle vous a convaincu, le CM 690 II est disponible chez notre partenaire Materiel.net. Il y a aussi des vidéos présentées par des techos, mais c'est tout de suite beaucoup moins vendeur :

Posté par Matt le 19/01/2010 à 22h48

2 commentaires

Source : PCWorld

Quelques mois à peine après le lancement de la Playstation 3 Slim, Sony commence déjà à évoquer la prochaine génération de console. Mais au lieu de promesses sur les performances ou les fonctionnalités de la machine, le constructeur a plutôt évoqué le support utilisé pour les jeux...

Alors qu'on aurait pu s'attendre à des "simples" Blu-ray, ou même carrément à l'absence de support physique, comme sur la récente PSP Go, le vice président responsable du développement de Sony a révélé que la prochaine console de salon du nippon pourrait embarquer un nouveau format de disques optiques, technologiquement proches du Blu-ray, mais offrant une capacité supérieure.

En effet, selon lui les 50 Go d'espace offerts par le Blu-ray pourraient être insuffisants pour les jeux futurs, certains titres actuels étant déjà proches des limites de ce support, tandis qu'avec un tel volume de données, une dématérialisation reste totalement inenvisageable, la majorité des joueurs n'étant pas équipés de connexions Internet suffisamment rapide.

Si Sony respecte son rythme habituel de lancement, la Playstation 4 pourrait voir le jour en 2012 ou 2013, mais aucune date n'a été annoncée pour l'instant par Sony.

Posté par Matt le 14/01/2010 à 22h48

Aucun commentaire

Source : Tom's Guide via Ptit_boeuf

Depuis que MSI s'est lancé dans la course à l'autonomie avec sa gamme de netbooks Wind, une autonomie de 12h ne parait plus forcément un exploit, surtout avec la nouvelle génération de processeurs Atom, encore plus sobres, et avec les deux batteries fournies par certains constructeurs. Sauf que l'annonce d'Asus ne concerne ici ni un netbook, ni une machine livrée avec deux batteries...

Le UL80JT - c'est son petit nom - est en effet un ordinateur portable 13" embarquant un processeur Intel Core i7 de dernière génération (double cœur Arrandale 32nm) et même un véritable GPU, le GeForce 310M de nVidia, équivalent moderne le la 8400M GT. Et le tout pour moins de 1000$.

Pour arriver à cette économie exceptionnelle, Asus a implémenté une gestion très fine de l'alimentation et du fonctionnement des composants. Ainsi, la fréquence du processeur est ajustée chaque seconde en fonction de la charge (la fréquence maximale étant de 1.73 GHz quand un seul cœur est sollicité et 1.2 GHz quand les deux le sont...), tandis que l'affichage bascule de façon totalement transparente entre le GMA intégré au Core i7 et le GPU nVidia GeForce 310M. Comme pour le processeur, ce basculement se fait en fonction de la charge, mesurée toutes les secondes, et de façon totalement transparente pour l'utilisateur.

Bien entendu, cette machine ne sera tout de même pas un monstre de puissance, avec son processeur ne dépassant pas 1.2 GHz sur deux cœurs et son GPU très modeste, mais il s'agit tout de même d'une configuration nettement plus puissante qu'un netbook, sans faire de compromis sur l'autonomie.

Posté par Matt le 12/01/2010 à 22h29

Aucun commentaire

Source : Gizmodo via Ptit_boeuf

Ancienne gloire du graveur CD haut de gamme à l'époque où ils étaient encore réservés à une petite minorité d'utilisateurs, Plextor a perdu beaucoup de sa superbe avec la démocratisation de ces produits qui l'a poussé à ne plus concevoir ses propres modèles, et à se diversifier (clés USB, disques durs externes, NAS, produits vidéo...). Nouvelle étape de cette diversification : les SSD.

Le japonais vient en effet d'annoncer ses premiers SSD, qui seront sans surprise basés sur un contrôleur tiers, et non un nouveau contrôleur développé par Plextor, qui rejoint donc la longue liste des constructeurs de SSD "clients". Le contrôleur utilisé est un contrôleur Marvell, probablement le même que dans le V-Series 30 Go récemment annoncé par Kingston. Épaulé par 64 Mo de mémoire cache, il offre malheureusement des performances très modestes, avec seulement 110 Mo/s en lecture et 65 Mo/s en écriture... Voilà qui ne devrait pas aider Plextor à retrouver son image de marque d'il y a dix ans...

Le prix et la date de lancement n'ont pas encore été annoncés, mais ce SSD qui sera lancé en versions 64 et 128 Go ne devrait pas trop tarder, et ses performances devraient garantir un prix de vente relativement réduit.

Posté par Matt le 11/01/2010 à 21h33

Aucun commentaire

Source : Tom's Hardware

Fermi est la prochaine architecture de GPU de nVidia, qui a été présentée par le caméléon il y a un peu plus de trois mois. Déjà à l'époque, nVidia avait fortement axé sa communication sur le calcul scientifique plus que sur le jeu vidéo, ce qui n'avait pas manquer de soulever des doutes sur cette nouvelle architecture...

Et depuis, les choses ne se sont visiblement pas améliorées... D'abord, il y a eu les problèmes de rendement à la fabrications, puis le retards (Fermi n'est toujours pas disponible...), etc... À l'occasion du CES qui se tient en ce moment à Las Vegas, nVidia n'aurait pas été bien bavard au sujet de sa nouvelle architecture, ce qui en soit est déjà mauvais signe. Mais en plus, une nouvelle information inquiétante semble se confirmer : Fermi serait un véritable gouffre énergétique !

En effet, selon notre confrère PCWorld, plusieurs constructeurs de boîtiers auraient présenté des modèles spécifiques, certifiés par nVidia pour leur compatibilité avec un SLI de cartes à base de Fermi. Pour obtenir une telle certification, les constructeurs ont dû mettre en place des systèmes de refroidissement spécifiquement conçus pour ventiler au mieux les deux cartes. La dissipation thermique serait telle que les constructeurs ont même éprouvé quelque difficultés à obtenir la certification, les premiers prototypes de boîtiers ayant été rejetés par nVidia ! Autant dire qu'il ne sera pas la peine d'espérer faire tourner un SLI de Fermi dans un boîtier classique...

La consommation d'une carte seule serait de l'ordre de 300W, la consommation maximale autorisée par le PCI-Express (75W via le slot PCI-Express, 75W via un connecteur d'alimentation 6 points et 150W via un connecteur d'alimentation 8 points). À titre de comparaison, la Radeon HD 5970 (qui embarque deux GPU Radeon 5870 aux fréquences légèrement diminuées) nécessite 275W, tandis que la Radeon HD 5870 se contente de 188W.

2010 pourrait donc être une excellente année pour ATI, dont les Radeon 5000 offrent un excellent niveau de performances, tout en conservant une consommation raisonnable.

Posté par Matt le 09/01/2010 à 17h12

Aucun commentaire

Source : PCWorld

Le transistor est l'élément de base qui constitue la plupart des puces électroniques. Il est actuellement principalement réalisé à base de silicium, mais ce matériau approche de ses limites en termes de finesse de gravure. De nombreuses équipes de recherche travaillent donc à trouver des alternatives...

Parmi elles, une équipe constituée de chercheurs issus de l'université de Yale (États-Unis) et de l'institut de science et technologie de Gwangju (Corée du Sud) vient de réaliser un bel exploit, en construisant ce qui est à ce jour le plus petit transistor jamais construit. Et pour cause, celui-ci est constitué d'une seule molécule ! Les chercheurs ont en effet observé qu'une molécule de benzène connectée à des contacts en or pouvait se comporter comme un transistor de silicium. Les applications pratiques de cette découvertes ne sont toutefois pas attendue avant plusieurs dizaines d'années.

Apple aurait-elle été en avance sur son temps avec ses Mac Pro parfum benzène ?

Posté par Matt le 05/01/2010 à 22h29

Aucun commentaire

Source : EETimes via Ptit_boeuf

Il y a quelques mois, j'avais écrit un article sur les SSD pour le compte de notre confrère Macbidouille. Je vous avais alors promis qu'il arriverait ici plus tard, dans une version remise au goût du jour pour tenir compte des dernières évolutions.

Alors que nous entrons en 2010 et que les SSD devraient encore se démocratiser un peu plus cette année, il est donc temps de tenir cette promesse, pour vous aider à mieux comprendre ce qui vous attends si vous sautez le pas.