Les mini PC portables à bas prix ont le vent en poupe, c'est le moins que l'on puisse dire. Après Asus, Belinea, Packard Bell, Everex et Dell, c'est désormais au tour de GeCube d'annoncer son modèle. Jusqu'à présent surtout connu pour ses cartes graphiques GeCube a en effet présenté au CeBIT un petit portable de 7", mais avec une petite originalité par rapport à ses concurrents...

En effet, alors que les ordinateurs portables embarquent normalement leurs composants sous le clavier, le Genie PC embarque ses composants derrière l'écran. Le clavier se présente pour sa port sous la forme d'une station d'accueil. Ainsi, l'appareil peut se tenir en main à la manière d'un UMPC (un dispositif de pointage est présent au dos de l'écran), être utilisé comme cadre photo numérique (il intègre un support permettant de le faire tenir debout) ou être posé sur sa base et s'utiliser comme un ordinateur portable classique.

Photo : Matbe

Annoncé pour 300€, comme son concurrent, il embarque toutefois une configuration plus basique : processeur x86 à seulement 300 MHz, 256 Mo de RAM, 2 Go d'espace de stockage, webcam et WiFi en option... L'ensemble fonctionne sous Linux et pèse moins de 1 kg en incluant la batterie 3 cellules qui lui offre environ 3h30 d'autonomie.

Le clavier amovible risque toutefois d'être une spécificité insuffisante pour compenser les caractéristiques techniques nettement inférieures à celles de l'EEE PC, d'autant plus que l'absence d'écran tactile risque de rendre l'utilisation sans clavier relativement ardue. L'utilisation comme cadre numérique pourrait lui conférer un intérêt supplémentaire, mais il souffrira alors du mauvais positionnement de sa fiche d'alimentation, sur le côté de l'appareil, alors que pour une telle utilisation il serait préférable qu'elle se situe à l'arrière, afin de masquer le câble.

Posté par Matt le 05/03/2008 à 22h48

Aucun commentaire

Source : Matbe

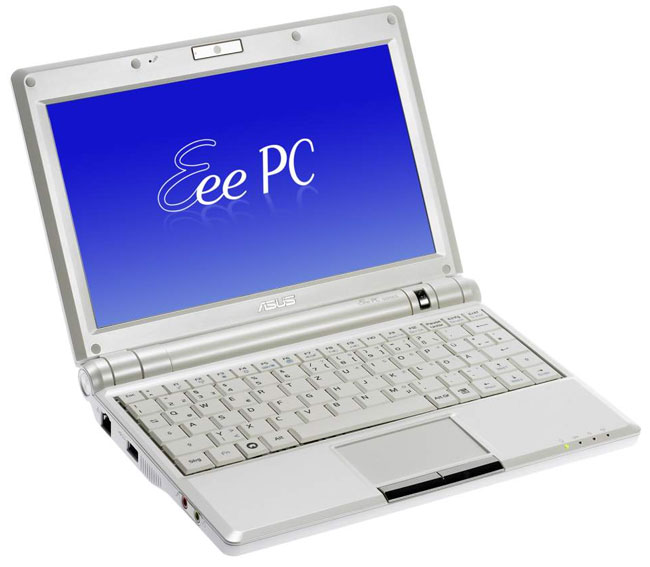

Fort du succès de son ultra-portable low cost, l'EEE PC 701, Asus a profité du CeBIT pour dévoiler une nouvelle version de celui-çi, l'EEE PC 900. Comme son nom le laisse entendre, celui-ci se distingue du modèle original par une taille supérieure, l'écran étant désormais un 9" (ou plutôt 8.9"). Il complètera la gamme EEE PC dont nous vous parlions il y a un mois.

Taille de l'écran oblige, ce nouvel EEE grossit un peu, les premières photos laissant deviner une profondeur supérieure d'environ 2cm. Il gagne

aussi quelques millimètres en épaisseur. L'écran perd au passage sa large bordure noire, ce qui rend l'EEE 900 plus esthétique, et lui confère un look plus classique pour un ordinateur portable.

Au niveau des caractéristiques techniques, Asus donne pour l'instant très peu d'informations. L'EEE PC 900 sera toujours basé sur une plateforme Intel, mais sans plus de précision. La quantité de mémoire par défaut sera portée à 1 Go, tandis que l'espace de stockage passera à un maximum de 12 Go. De quoi offrir un peu plus de libertés à ceux qui désirent stocker des fichiers multimédias ou installer Windows XP sur leur EEE. La webcam intégrée gagne quelques

pixels (on passe de 0.3MP à 1.3MP, soit une résolution qui passe de 640x480 à 1280x1024), tout comme l'écran, qui profite de ces deux pouces supplémentaires pour monter en résolution, offrant désormais un 1024x600 qui devrait permettre un surf bien plus agréable, de nombreux sites étant conçus pour une largeur minimale de 1024 pixels. Le trackpad gagne également quelques centimètres carrés, mais le clavier reste le même, puisque la largeur de la machine est identique. Le système sera bien entendu toujours sur une base Linux Xandros.

Du côté des mauvaises nouvelles, on notera la batterie à priori identique, laissant donc supposer une autonomie au mieux égale, mais probablement plutôt inférieure, du fait de l'augmentation de la taille de l'écran, mais on retiendra surtout la hausse de prix, puisque ce nouveau modèle sera proposé pour 100€ de plus, soit environ 400€. On peut donc se demander si l'EEE PC 900 ne s'écarte pas un peu trop de la cible initiale. Ceux qui ont été séduits par le prix et la compacité de l'EEE PC 701 risquent en effet d'avoir du mal à accepter un prix 33% supérieur pour une machine un peu moins compacte et pas vraiment plus puissante ou plus autonome.

Posté par Matt le 03/03/2008 à 23h57

Aucun commentaire

Source : BlogeEEE

Le constructeur de cartes mères MSI a développé un système de ventilation original pour ses prochaines cartes : un ventilateur fonctionnant sans électricité ! La source d'énergie utilisée est tout simplement la chaleur dégagée par la puce à refroidir, qui est convertie en énergie mécanique pour mettre en mouvement le rotor du ventilateur.

Pour parvenir à ce résultat, MSI a utilisé un concept de moteur connu depuis bien longtemps : le moteur de Stirling. Contrairement à la plupart des moteurs, celui-ci a la particularité de pouvoir fonctionner avec n'importe quelle source de chaleur en s'appuyant sur les règles de la thermodynamique : le gaz contenu dans le cylindre est chauffé, puis de détend en poussant un piston, puis est refroidi et compressé à nouveau. Le mouvement longitudinal du piston est ensuite converti en mouvement rotatif par une bielle et un vilebrequin.

Les avantages de ce système pourraient être multiples : tout d'abord, une économie d'énergie. L'ensemble des ventilateurs d'un PC consomme 2 à 3W, et en généralisant ce système à tous les ventilateurs, on pourrait donc économiser 1 à 2% d'énergie. C'est peu, mais c'est toujours ça de pris. Ensuite, la source d'énergie étant le composant à refroidir, ce système contribue au refroidissement, en plus de la contribution apportée par la rotation du ventilateur. Enfin, le régime de fonctionnement d'un moteur de Stirling varie en fonction de la température de la source de chaleur. Ce ventilateur serait donc thermorégulé sans qu'il soit nécessaire de mettre en place de système électronique de mesure de température et de régulation de vitesse.

Par contre, cette technologie est probablement plus chère et plus encombrante qu'un ventilateur classique, et on en sait encore très peu sur la fiabilité d'un tel système. Il fait également perdre en souplesse, puisque l'utilisateur n'aura plus la possibilité de régler lui même son système de ventilation en fonction de ses priorités (efficacité ou bruit). Enfin, MSI ne communique pas sur le niveau de bruit du ventilateur, dont on peut tout de même espérer qu'il ne sera pas plus bruyant qu'un ventilateur classique.

Ce système devrait prochainement être introduit sur le marché, sur une carte mère nVidia.

Posté par Matt le 01/03/2008 à 17h10

Aucun commentaire

Source : Gizmodo

Une fois n'est pas coutume, Apple a renouvelé hier l'ensemble de sa gamme de portables, aussi bien en versions Pro

qu'en versions grand public. Seul le tout récent MacBook Air échappe à ce refresh

.

Du côté des MacBook, on passe au Penryn, avec des fréquences revues à la hausse : 2.1 GHz au lieu de 2.0 Ghz pour l'entrée de gamme, 2.4 GHz au lieu de 2.2 GHz pour le haut de gamme. Penryn oblige, le cache passe de 4 Mo à 3 Mo sur tous les modèles. Les disques durs gagnent également en capacité, avec 120 Go en entrée de gamme, 160 Go en milieu de gamme et 250 Go en haut de gamme. Les prix sont pour leur part légèrement revus à la baisse en Europe, en raison de la chute du dollars. Tous les modèles voient ainsi leur tarif diminuer de 50€, mais par contre il vous faudra désormais vous acquitter de 19€ supplémentaire pour acquérir l'Apple Remote, désormais en option.

On notera également que le modèle d'entrée de gamme est toujours livré avec seulement 1 Go de mémoire et une unité optique Combo

d'un autre temps, ne gravant toujours pas les DVD. Enfin, le coup de peinture noire sur le modèle haut de gamme est toujours facturé à prix d'or, puisque la différence entre le modèle milieu de gamme avec option disque dur de 250 Go et le modèle haut de gamme noir est de 110€, pour des caractéristiques techniques strictement identiques...

Pour les MacBook Pro, c'est également le Penryn qui prend les commandes, avec là encore des changements de fréquences et de quantités de cache : 2.4 GHz / 3 Mo au lieu de 2.2 GHz / 4 Mo en entrée de gamme et 2.5 GHz / 6 Mo au lieu de 2.4 GHz / 4 Mo sur le reste de la gamme, avec en option un 2.6 GHz / 6 Mo sur le modèle 17". Les disques durs prennent également de l'embonpoint (200 Go en entrée de gamme, 250 Go pour les autres), mais restent à 5400 RPM, tandis que la mémoire vidéo est doublée (256 Mo pour l'entrée de gamme, 512 Mo pour le reste). Comme sur les MacBook, les tarifs sont revues à la baisse, d'environ 100€, mais avec l'Apple Remote en option.

Le trackpad multitouch des MacBook Air, très attendu sur les modèles standards, fait son apparition sur les MacBook Pro, mais pas sur les MacBook.

Grâce à l'adoption du Penryn sur toute la gamme, l'autonomie devrait progresser. Toutefois, ayant changé ses méthodes de mesure, Apple annonce désormais une autonomie plus faible, mais plus réaliste. En pratique, selon les premiers tests, il y aurait bien un gain d'autonomie, celui-ci pouvant atteindre jusqu'à 25% sur certains modèles.

Au final, Apple signe là un refresh

homogène qui permet de rendre l'ensemble de sa gamme un peu plus compétitive face à la concurrence, mais sans réelle nouveauté, ce qui risque de ne pas satisfaire les attentes de certains aficionados

de la pomme, qui sont nombreux à attendre un nouveau design, en particulier pour les MacBook Pro dont le design hérité des Powerbook est vieux de quelques années...

Posté par Matt le 27/02/2008 à 10h46

Aucun commentaire

Alors que le très attendu Service Pack 1 de Windows Vista était passé en RTM (Release To Manufacturer, c'est-à-dire une version finale distribuée aux constructeurs un peu avant la diffusion publique), la distribution de celui-çi a été interrompue depuis quelques jours...

En cause, une des mises à jour qui doivent être installées préalablement à l'installation du SP1, qui provoquerait des redémarrages en boucle. Pire, certains utilisateurs victimes de ce problème ont perdu toutes leurs données en tentant de le corriger. Suite à ce problème, il y a de bonnes chances que le SP1 arrive un peu plus tard que prévu, le temps de corriger et de relancer une campagne de tests.

Même s'il est vrai que les phases de tests alpha, beta et RC ne permettent pas de tester sur une gamme de machines aussi diversifiée que l'ensemble des PC sous Vista, on peut également s'interroger une nouvelle fois sur le sérieux des procédures de validation de Microsoft. Il me semble en effet assez inquiétant qu'un bug aussi majeure dans l'installation d'une mise à jour puisse passer toutes les étapes de validation et arriver en RTM...

Heureusement que ce bug a tout de même été détecté avant la diffusion à grande échelle sur Windows Update, car il aurait pu faire des ravages chez le grand public, tout le monde n'ayant pas forcément les compétences pour rafistoler le problème sans perdre ses données...

Posté par Matt le 22/02/2008 à 09h19

Aucun commentaire

Source : NDFR.net

La rumeur se faisait de plus en plus insistantes ces derniers jours. C'est désormais officiel : Toshiba a décidé de mettre fin à son format de disque haute-définition, le HD-DVD. Malgré ses qualités, il n'aura donc pas survécu à la vague de déploiement du Blu Ray suite au lancement de la Playstation 3.

Annoncé cette nuit lors d'une conférence de presse au Japon, l'arrêt officiel du HD-DVD met donc fin à une longue agonie, qui avait vue les parts de marché de ce format passer de 70% à 10% en l'espace de quelques mois, le Blu Ray étant dopé par les ventes de Playstation 3. Il s'est en effet vendu plus de lecteurs Blu Ray dans les PS3 que de lecteurs HD-DVD tous types confondus (Xbox 360, PC, platines, enregistreurs...).

Même si cette annonce est plutôt positive pour la démocratisation des lecteurs HD, on aura tout de même une petite pensée émue pour les quelques 730 000 lecteurs HD-DVD qui se retrouvent orphelins et pourront rejoindre les lecteurs Betamax, V2000, Laser Disc et autres Super Audio CD... Cette affaire

aura au moins le mérite de nous montrer une fois encore qu'en matière de nouvelles technologies, il n'est pas bon de se ruer aveuglément sur les nouveaux formats.

Posté par Matt le 19/02/2008 à 13h04

Aucun commentaire

Source : Engadget

Depuis les premiers Celeron lancés début 1998, les processeurs Celeron ont toujours été des versions allégées

des processeurs de la gamme standard

d'Intel : moins de cache, moins de fonctionnalités, mais cœur d'exécution identique. En particulier, il manquait une fonctionnalité qui est pourtant essentielle de nos jour : le Speedstep, qui réduit automatiquement la fréquence du processeur en cas de faible activité afin de réduire la consommation du processeur. Ainsi, au repos, les Celeron avaient une fâcheuse tendance à consommer plus que leurs grands frères. Mais les nouveaux Celeron vont enfin changer la donne !

Baptisés Celeron E1200, la nouvelle famille de Celeron dérive bien sûr des Core 2 Duo et Pentium E. Elle se distingue de la précédente génération de Celeron (Celeron 400) essentiellement sur deux points : les Celeron E1200 sont les premiers Celeron Dual Core, et surtout, les premiers Celeron à intégrer le Speedstep, ou, plus précisément, l'EIST (Enhanced Intel Speedstep). Contrairement aux récents Core 2 Duo E8000, ces Celeron sont toujours gravés en 65nm est sont basés sur le core Conroe, mais n'embarquent que 512 Ko de cache L2 partagé. Ils ne se distinguent donc des Pentium E2000 et des Core 2 Duo E4000 que par cette différence de quantité de mémoire cache. Le premier modèle est cadencé à 1.6 GHz, avec un FSB à 800 MHz.

Passé entre les mains de Matbe, ce nouveau Celeron se révèle plutôt intéressant dans le cadre d'une machine premier prix. En effet, même si les performances sont en retrait par rapport aux Pentium E2000, elles sont nettement supérieures à celles des Celeron 400, tandis que la consommation est au plus bas : au repos, le Celeron E1200 à 1.6 GHz consomme quasiment 10W de moins qu'un Pentium E2140 de même fréquence, tandis que le gain dépasse les 30W en pleine charge, le Celeron étant sans doute aidé par un processus de fabrication encore un peu plus optimisé. Enfin, ce nouveau Celeron ne remet pas en cause la réputation d'overclockabilité

dont jouissent les Celeron : en poussant un peu la tension d'alimentation, nos confrères ont atteint un overclocking de 100%.

Avec toutes ces qualités, le E1200 pourrait donc bien devenir le prochain best-seller des processeurs d'entrée de gamme, son plus gros défaut étant finalement le positionnement tarifaire des Pentium E2000 et Core 2 Duo E4000, dont on pourrait presque dire qu'ils ne sont pas assez cher

, laissant bien peu de places aux Celeron, cantonnés à des tarifs inférieurs à 50$.

Posté par Matt le 18/02/2008 à 21h56

Aucun commentaire

Source : Matbe

Vous l'avez peut-être constaté par vous même : Infobidouille était inaccessible toute la journée de vendredi et une partie du week-end. Une petite explication s'impose...

Jeudi soir, vers 22h30, le site a été victime d'une attaque de hacker. Au niveau du site, l'intrus n'avait modifié que les fichiers index, pour défacer

le site. Mais le système était compromis en profondeur, et nous n'avions plus le contrôle sur la machine (accès root impossible).

Nous avons donc été contraints de redémarrer le serveur sur le système de secours le temps d'effectuer des sauvegardes (un malheur n'arrivant jamais seul, nos procédures de sauvegarde automatiques étaient apparemment HS depuis quelques jours...) et de réinstaller le système.

Le site a été remis en ligne samedi dans l'après-midi, sans pertes de données (contrairement à l'attaque de novembre 2006) et la configuration de sécurité a été renforcée, en particulier au niveau d'Apache (filtrage de certaines requêtes avec blocage automatique des IP au comportement suspect) et de PHP (blocage des accès à des fichiers distants), ce qui nous a permis de repérer et de contrer une nouvelle attaque émanant du même hacker dimanche après-midi.

Nous avons identifié deux failles utilisées par le pirate pour introduire du code malicieux sur le serveur (une au niveau d'un blog Dotclear non à jour, une dans le scripts de statistiques Les Visiteurs 2

) et nous révisons actuellement notre code PHP pour vérifier que les scripts sont sécurisés. Les systèmes de monitoring ont également été renforcés, et notamment le monitoring des processus de sauvegarde, afin de détecter au plus vite la moindre anomalie.

Posté par Matt le 18/02/2008 à 13h09

Aucun commentaire

![]()

Présent depuis longtemps sur le marché de l'open source, Sun continue d'étendre ses secteurs d'activité, en rachetant Innotek, l'éditeur du fameux VirtualBox, le logiciel de virtualisation qui fait beaucoup parler de lui depuis un peu plus d'un an, en étant une alternative libre et performantes aux ténors du marché.

Rendue grand public

par Parallels Desktop sur Mac Intel, la virtualisation connait depuis environ deux ans une popularité croissante. Par ce rachat, Sun se positionne en acteur majeur du secteur de la virtualisation grand public, alors qu'il n'était pour l'instant présent sur le marché de la virtualisation qu'avec son offre professionnelle Sun xVM, destiné à la virtualisation de serveurs.

Posté par Matt le 13/02/2008 à 22h31

Aucun commentaire

Source : Sun

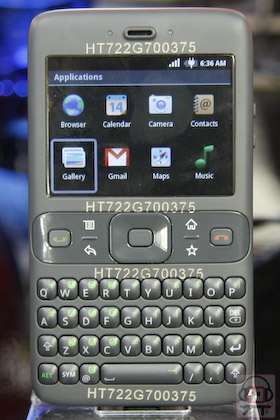

L'été dernier nous évoquions l'intérêt de Google pour le marché de la téléphonie mobile. Les rumeurs allaient alors bon train sur l'arrivée prochaine d'un Google Phone destiné à concurrence l'iPhone d'Apple. Depuis, Google a annoncé ne pas vouloir lancer de téléphone portable, mais travailler au développement d'un système d'exploitation libre basé sur Linux et destinés aux appareils mobiles : Android.

La Mobile World Conference 2008 se tient en ce moment à Barcelone, et Texas Instrument à profité de l'occasion pour dégainer le premier prototype de smartphone fonctionnant sous Google Android. De la taille d'un PDAphone, il présente un clavier complet et un écran au format paysage, à la manière des Blackberry. A l'intérieur, on trouve un processeur ARM à 500 MHz, ce qui devrait conférer de bonnes performances à l'appareil, ce type de processeur étant généralement plutôt proposé sur les gros

PDA. L'épaisseur semble pour sa part plutôt raisonnable, ce qui est un bon point par rapport à certains smartphone sous Windows Mobile.

On n'en sait pas beaucoup plus sur les caractéristiques techniques de l'appareil, mais la partie applicative trahi la présence d'un appareil photo (le contraire aurait tout de même été surprenant...) et laisse espérer un support du WiFi, de nombreuses applications très orientées Internet étant présentes : navigateur, Gmail, Google Chat, Google Maps, YouTube... Le WiFi ne serait bien entendu pas indispensable à ces applications, mais vu le coût des transferts data en GPRS ou en UMTS, l'absence du WiFi leur ferait perdre une grande part de leur intérêt.