Actualités du mois de mars 2010

![]()

Maintenant que les autorités européennes ont validé le rachat de Sun par Oracle, à la suite des autorités américaines, le rachat du constructeur de serveurs par l'éditeur de SGBD est entériné, et les premières mesures induites par ce rachat semblent prendre forme...

Difficile en effet de ne pas mettre sur le compte d'Oracle un changement majeur qui vient d'intervenir au niveau de Solaris 10, le système d'exploitation Unix que Sun propose à ses clients : l'utilisation du système au delà d'une période d'essai de 90 jours nécessitera désormais la souscription à un contre de service, alors que le système était jusqu'à présent utilisable indéfiniment et gratuitement sans un tel contrat.

OpenSolaris, la version libre de Solaris, reste pour sa part entièrement gratuite, mais Oracle n'a pris aucun engagement sur les évolutions futures de ce système, et à même au contraire déjà affirmé que les nouveautés futures de Solaris ne seraient pas forcément portées dans OpenSolaris...

Espérons que MySQL ne prenne pas la même voie une fois qu'Oracle ne sera plus soumis aux engagements formulés en fin d'année dernière. À noter que dans cette éventualité, la résistance s'organise déjà : le créateur de MySQL a lancé un nouveau projet open-source, MariaDB, qui restera basé sur MySQL tant que ce sera possible, et pourra continuer ensuite à vivre de son côté si Oracle décidait de fermer MySQL.

Posté par Matt le 31/03/2010 à 22h42

2 commentaires

Source : Tom's Hardware

La 3D est aujourd'hui devenue la nouvelle mode pour attirer le public dans les salles obscures, mais aussi pour pousser au renouvellement du matériel vidéo domestique. Nos confrères de chez Tom's Hardware proposent à leur lecteur un guide original pour passer à la 3D sans investir dans du matériel dernier cri.

Leur solution utilise un système de projection basé sur la polarisation de la lumière, assez similaire à celui utilisé dans la plupart des cinéma. L'avantage de ce système est qu'il ne nécessite pas un équipement de projection spécifique (contrairement aux systèmes à lunettes occultantes, qui nécessitent un projecteur capable d'afficher à haute fréquence et de se synchroniser avec les lunettes) : le guide de Tom's Hardware vous permettra de réaliser un système de projection 3D à partir de deux projecteurs classiques.

Il suffit en effet de monter sur chacun des projecteur un filtre polarisant et de projeter vers un écran spécifique, qui conserve la polarisation, et le tour est joué.

Malheureusement, il ne faut pas s'attendre pour l'instant à une véritable solution low cost, puisque malgré le côté "bidouillé à la maison" de cette solution, il faudra tout de même compter environ 400$ de filtres polarisant et 150$ d'écran, en plus du coût des deux projecteurs et d'un PC de salon, indispensable pour piloter les deux appareils.

Posté par Matt le 31/03/2010 à 11h11

Aucun commentaire

Les habitués des CD-R et des DVD-R le savent sans doute : ces supports de stockage ne sont pas des modèles de fiabilité dans le temps, ceux-ci ayant une certaine tendance à devenir illisible plus ou moins rapidement... Une étude de l'Académie des Sciences confirme ce manque de fiabilité, et le quantifie pour la première fois.

Ainsi, selon cette étude, 8% des CD inscriptibles seraient illisibles au bout de seulement 4 ans. Pire, les supports de certaines marques ne tiennent parfois même pas un an, alors que les meilleurs frisent une durée de vie de 20 ans ! Du fait de leur densité plus élevée, les supports plus modernes, tels que le DVD-R et le BD-R seraient encore moins à l'aise dans le temps. Sachant qu'environ 10 milliards de galettes sont vendues par an, le volume de données en danger de disparition a de quoi donner le vertige...

Alors, vers quoi se tourner ? Les disques durs ? Échec ! L'étude de l'Académie des Sciences dresse également un portrait plutôt sombre de ces derniers. En effet, la majorité des disques durs rendraient l'âme au bout de seulement cinq années d'utilisation. Et comme pour les supports optiques, les supports les plus denses sont les moins durables, accentuant encore la gravité de la situation, puisque les volumes de données perdus sont d'autant plus grands...

Les mémoires flash ? Pas mieux ! On le sait depuis longtemps, les mémoires flash stockent les données sous forme de charges électriques, chargent qui ont tendance à disparaitre avec le temps à cause des courants de fuite.

Le stockage en ligne ? S'il apparait très séduisant, en détachant l'utilisateur de toutes les indispensables tâches de maintenance, le stockage en ligne ne serait en fait pas non plus viable, en raison de l'énorme volume de données à stocker, qui nécessiterait d'investir des sommes phénoménales dans les serveurs.

La solution est donc finalement surtout de rester très attentif à l'état de ses données, en les copiant régulièrement sur de nouveaux supports, et surtout, en gardant toujours plusieurs exemplaires des données les plus importantes.

Les auteurs de l'étude espèrent également que leurs conclusions pousseront certains industriels à se lancer dans la recherche de nouvelles solutions de stockage plus durables, pour assurer la sauvegarde à long terme des données numériques.

Posté par Matt le 30/03/2010 à 22h59

7 commentaires

Sources : PCWorld et ZDNet via Ptit_boeuf

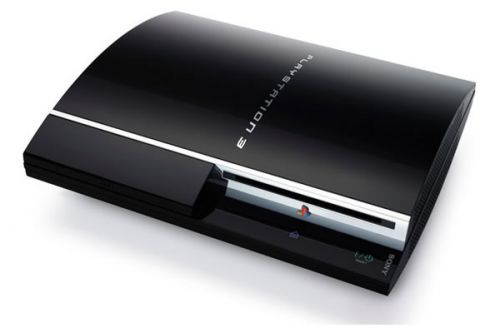

Des trois principaux constructeurs de consoles, Sony a longtemps été le plus ouvert, en autorisant l'installation de systèmes d'exploitation alternatifs, principalement sur base Linux, sur les PlayStation 2 et les PlayStation 3, ce qui permettait de les utiliser comme de vrais ordinateurs. Mais après l'abandon de cette possibilité sur les derniers modèles (PS3 Slim), Sony vient d'annoncer une bien mauvaise nouvelle pour les adeptes de Linux sur PS3...

En effet, le nippon va diffuser à partir de jeudi le firmware 3.21 de sa console, firmware qui supprimera la possibilité d'installer un OS alternatif sur tous les modèles de PlayStation 3, et qui effacera d'office les installations existantes. Ce choix aurait été fait pour des raisons de sécurité, une faille matérielle dans le gestionnaire de mémoire risquant d'autoriser au système Linux un accès un peu trop libre à la mémoire de la console... Difficile de ne pas faire un lien entre cette annonce et une autre, émanant de GeoHot il y a quelques semaines, qui annonçait avoir réussi à prendre la main sur l'hyperviseur de la console et avoir ainsi obtenu un accès complet à la mémoire. Plus que la sécurité des utilisateurs de la console, ce serait donc en fait la protection du mécanisme anti-copie qui motiverait Sony...

Bien entendu, comme chaque mise à jour de la console, cette mise à jour ne sera pas obligatoire. Toutefois, Sony prévient d'ores et déjà que certaines fonctionnalités ne pourront plus fonctionner sans la mise à jour, et leur absence risque de faire perdre beaucoup de son intérêt à la console :

- plus d'accès aux PlayStation Network, et donc à tous les services qui y son liés (chat, jeu en ligne, téléchargement de démos et de mises à jour de jeux, etc...),

- les jeux à venir ne pourront pas fonctionner.

Le refus de la mise à jour sera donc surtout réservée à ceux qui ont acheté une PlayStation 3 sans la moindre intention d'utiliser les fonctionnalités prévues par Sony, comme par exemple certains laboratoires de recherche qui ont exploité la grande puissance de calcul de la PS3 pour monter des clusters à moindre coût.

Posté par Matt le 30/03/2010 à 10h18

Aucun commentaire

Source : PCInpact

Présente quasiment depuis toujours dans les téléphones mobiles, la carte SIM permet d'identifier la ligne associée au téléphone sur le réseau de son opérateur de rattachement. Mais elle sert aussi, par le biais de son identifiant opérateur, à restreindre l'usage d'un terminal donné sur un réseau donné, en configurant simplement le téléphone pour qu'il n'accepte que les cartes dotées du bon identifiant opérateur.

Un verrouillage qui n'est aujourd'hui clairement pas dans l'intérêt de l'utilisateur. En effet, s'il pouvait se justifier dans le cas d'un mobile subventionné par l'opérateur mais non assorti d'un forfait avec engagement de durée, ce type d'offre n'existe quasiment plus, les grosses subventions étant aujourd'hui toujours associées à des engagements d'un à trois ans, tandis que les offres sans engagement sont cantonnées à des mobiles peu ou pas du tout subventionnés.

Partant de ce constat et de la gêne induite par ce système de verrouillage, en particulier pour les utilisateurs se déplaçant régulièrement à l'étranger, et qui auraient donc tout intérêt à se doter d'une carte SIM prépayée de leur pays de destination pour éviter les coûts exorbitants du roaming, le ministère japonnais de la communication serait en train d'étudier la possibilité d'interdire ce verrouillage.

Une bonne nouvelle pour les utilisateurs japonnais, qui seront sans doute ravis de constater que leur gouvernement est encore capable de privilégier l'utilisateur plutôt que les opérateurs. Si ce projet abouti, espérons qu'il donnera des idées en France et en Europe...

Posté par Matt le 29/03/2010 à 22h59

Aucun commentaire

Source : Clubic

Depuis quelques jours, c'est le printemps, et avec lui, l'arrivée de la saison des barbecue. nVidia a donc pensé aux joueurs amateurs de viande grillée, en lançant ce week-en ses nouvelles cartes graphiques haut de gamme aux spécifications hors du commun, les GeForce GTX 480 et 470.

Comme nous vous l'annoncions il y a quelques jours, les GeForce GTX 480 et 470 sont toutes deux basées sur la nouvelle puce GF100 (Fermi) et ses 3 milliards de transistors, cadencée respectivement à 700 MHz et 607 MHz. Elle est dotée de 480 cœurs à 1401 MHz dans la GTX 480, contre 448 cœurs à 1215 MHz dans la GTX 470, le tout épaulé respectivement par 1.5 Go de GDDR5 à 924 MHz sur bus 384 bts et 1.25 Go de GDDR5 à 837 MHz sur bus 320 bits.

Les premiers tests montrent que la GeForce GTX 480 permet à nVidia de sauver l'honneur, en proposant à nouveau le GPU le plus puissant du marché, grâce à une avance moyenne de l'ordre de 5 à 20% par rapport au GPU haut de gamme actuel d'ATI, le Radeon HD 5870. Mais le canadien garde tout de même la palme de la carte la plus performante du marché avec sa Radeon HD 5970, dotée de deux GPU, qui surpasse assez largement la GTX 480, tout en offrant un rapport performances/prix beaucoup plus avantageux, grâce à un tarif conseillé de 599$, contre 499$ pour la GTX 480.

Le rapport avec le barbecue ? En plus d'offrir un rapport performances/prix très moyen, ces nouvelles GeForce se permettent également d'être des gouffres énergétiques, en réclamant près de 300W en pointe (malgré un TDP annoncé à "seulement" 250W par nVidia...). Résultat des courses, malgré une bruyante turbine de refroidissement, la carte atteint des températures très élevées. Et comme elle est surmontée d'une plaque métallique striée, elle devrait être idéale pour les grillades, pour peu que vous disposiez d'un boîtier "tête en bas".

Enfin, on notera que ces cartes seront disponibles au compte goutte, avec des quantités extrêmement réduites (on parle d'à peine 200 unités pour la France), ce qui ne devrait pas aider à voir les prix baisser rapidement. Il faudra donc probablement attendre une nouvelle révision de la puce GF100 pour qu'nVidia puisse offrir des cartes plus sobres et plus abordables, mais aussi des déclinaisons d'entrée et de milieu de gamme, marchés bien plus demandeurs que le haut de gamme. En attendant, on peut d'ores et déjà considérer que, après avoir largement perdu la bataille sur la première génération de cartes DirectX 10, AMD a gagné la première bataille du DirectX 11, avec sa gamme Radeon HD 5000, qui domine désormais de l'entrée au haut de gamme, en passant par le milieu de gamme.

Posté par Matt le 29/03/2010 à 21h48

Aucun commentaire

Après les iPod, les iPhone et bientôt les iPad, la prochaine étape du développement d'Apple dans le secteur du divertissement numérique sera-t-il une "iTV", sorte de super TV dopée au jus de pomme ? C'est en tout cas l'opinion de Piper Jaffray, qui pense qu'un tel produit pourrait arriver d'ici deux à quatre ans.

En effet, pour ce cabinet d'analystes habitué à étudier Apple, le marché de la TV multi-fonctions connectée à Internet pourrait être la prochaine étape pour la pomme, en surfant sur la popularité de ses périphériques multimédia. Selon les analystes, une telle solution pourrait combiner en un seul appareil les fonctions actuellement confiées à une demi-douzaine de produits connectés ensembles. Une intégration qui apporterait beaucoup en simplicité, tout en permettant éventuellement des économies sur le prix d'achat.

Ainsi, Apple pourrait proposer une TV 40" pour un peu moins de 1999$. Celle-ci intégrerait un disque dur pour réaliser des enregistrements stocker des fichiers achetés sur l'iTunes Store, mais aussi un véritable petit ordinateur permettant d'exécuter des applications en provenance de l'App Store, et en particulier des jeux. Apple pourrait également proposer un abonnement iTunes TV, d'un montant estimé de 50 à 90$ par mois, qui donnerait accès à des chaînes payantes, aux service de catch-up TV et à la VOD. En plus de la simplicité d'un tout en un, une telle solution serait plus économique, puisque Piper Jaffray estime qu'un ensemble de service et de fonctionnalités équivalent coûterai 2065$ à l'achat (via 6 appareils distincts), assortis de différents abonnements, pour un total mensuel de 97$.

Gardons tout de même à l'esprit qu'il s'agit pour l'instant uniquement de fantasmes d'analyses, et on est donc encore loin d'un produit annoncé officiellement par Apple.

Posté par Matt le 25/03/2010 à 10h41

Aucun commentaire

Source : MacWorld

Après avoir envahi à peu près tous les moyens de transport motorisés, de l'avion à la voiture en passant par le train, l'informatique est en train de faire son entrée dans les moyens de transport non motorisées, via les VTT...

En effet, le constructeur américain Cannondale vient d'annoncer une suspension informatisée pour son nouveau VTT, le Simon. Dotée d'un capteur optique et d'accéléromètres, cette suspension analyse en permanence l'état du chemin et la vitesse du VTT et en déduit le réglage idéal de la valve électro-hydraulique située dans l'amortisseur, ce qui permet de moduler la réponse de celui-ci, en le rendant par exemple plus rigide sur route et plus souple sur terrain très accidenté.

Et pour cette première, Cannondale n'a pas fait le choses à moitié, puisque le dispositif est déjà d'une précision redoutable : l'ouverture de la valve peut s'ajuster au micron près, et la latence du dispositif n'est que de 7ms ! Il aura donc fallu à peine plus de 20 ans entre la première suspension semi-active sur une voiture de série (Mitsubishi Galant de 1987) et l'arrivée d'un tel système sur un VTT. À quand l'ABS et l'ESP ?

Posté par Matt le 24/03/2010 à 23h00

2 commentaires

Source : Best Of Micro

![]()

À l'occasion de la présentation de son bilan annuel 2009, le groupe Iliad a évoqué le futur de ses différentes marques, et en particulier la plus connue d'entre elle, le FAI Free.

L'information à plus court terme concerne la loi HADOPI. Et cette nouvelle risque de ne pas faire plaisir aux instigateurs de cette loi : le FAI est bien décidé à ne mettre en place aucune des procédures de filtrage et de surveillance prévues par la loi tant que ça ne sera pas l'État qui mettra la main au portefeuille pour les financer. Le coût de ces mesures serait de l'ordre de 70 millions d'euros pour l'ensemble des FAI, une somme qui est pour l'instant prévue pour être à la charge des FAI.

Du côté des services, le FAI devrait prochainement proposer un service de "catch-up TV" (permettant de visualiser en différé les programmes). Cette offre devrait reprendre les programmes de TF1 et M6, qui ont déjà donné leur accord, tandis que Free négocie actuellement les droits pour les programmes France Télévisions. Aucune information n'a pour l'instant été communiquée sur la date de lancement et la tarification éventuelle de ce service.

Enfin, Iliad a évoqué les deux grands chantiers, dont le montant devrait se chiffrer à environ 2 milliards d'euros : le développement du réseau fibre et du réseau Free Mobile. Pour le premier, l'objectif est d'avoir 14 millions de logements raccordables d'ici à 2012, grâce à un déploiement massif en 2011 après une monté en charge progressive en 2010.

Du côté de Free Mobile, les choses semblent plutôt bien se passer, puisque l'opérateur a bien avancé dans ses négociations pour louer des "points hauts", nécessaires à l'installation de ses antennes relais, que Free annonce comme étant des modèles dernier cri, déjà prêtes à évoluer vers le protocole LTE, qui représente la 4ème génération de téléphonie mobile. Les négociations sont également en cours pour signer des accords de roaming avec les opérateurs déjà en place, afin que Free puisse lancer son offre avec une couverture acceptable, en exploitant les réseaux existants là où il n'aura pas encore déployé son propre réseau. Les premières offres commerciales seront lancées début 2012, comme prévu.

Posté par Matt le 23/03/2010 à 23h05

Aucun commentaire

Source : PCWorld

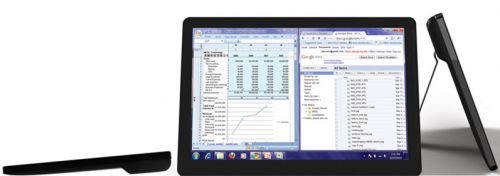

Il y a quelques mois, nous vous parlions du DZ6KHE16E , un netbook proposant un intéressant concept de double écran. Grâce à MEDL Technology, vous allez peut-être bientôt pouvoir appliquer ce concept à votre propre ordinateur, sans avoir à le remplacer.

La start-up hongkongaise va en effet lancer d'ici peu son premier produit, babptisé The Panel, qui consiste en un petit moniteur LCD de 13.3" destiné principalement aux utilisateurs nomades, puisqu'il embarque une batterie lui assurant jusqu'à 5 heures d'autonomie. La dalle affiche une résolution de 1280x800, classique pour cette diagonale, une luminosité de 300 cd/m² grâce à un rétroéclairage par LED et un taux de contraste de 400:1.

L'écran pourra être alimenté en images via une connectique plutôt riche : mini-HDMI, VGA, composantes, S-Video, DVI et même mini-USB. Cette dernière connectique permettra d'utiliser The Panel sur un ordinateur portable n'offrant aucune sortie vidéo, à condition qu'il fonctionne sous Windows (XP ou supérieur) ou Mac OS X (à partir de la version 10.4).

L'ensemble mesure 32cm de large, 22cm de haut et 2.5cm d'épaisseur et pèse environ 1kg, batterie incluse. Un pied rabattable permet de maintenir l'écran debout lorsqu'il est posé sur une table.

Posté par Matt le 23/03/2010 à 10h00

Aucun commentaire

Source : Le Journal du Geek

À cinq jours du lancement officiel de la nouvelle génération de cartes graphiques nVidia GeForce, les détails des spécifications de ces cartes commencent à se préciser sur le net, même si, en raison du NDA, toutes ces informations restent pour l'instant à considérer comme des rumeurs.

La gamme GeForce 400 sera dans un premier temps composée de deux cartes, la GTX 480 et le GTX 470, toutes deux positionnées sur le haut de gamme. La GeForce GTX 480, la plus haut de gamme de deux, serait dotée d'un GPU Fermi GF100. Doté de 480 shaders actives (sur les 512 que comporte l'architecture Fermi), il serait cadencé à 1401 MHz du coté des shaders et 700 MHz pour les autres unités (notamment 48 ROPs). La mémoire serait de la GDDR5 à 1848 MHz, adressée sur un bus de 384 bits. La consommation atteindrait 250W, voir 295W selon certaines sources, soit le maximum autorisé par un port PCI-Express et deux connecteurs d'alimentation (6 et 8 pins).

Plus modeste, la GTX 470 se contenterait d'un GPU à 607 MHz et de shaders (au nombre de 448) à 1215 MHz. Le nombre de ROPs serait également revu légèrement à la baisse (40), tout comme la largeur du bus mémoire (320 bits) et la fréquence de cette dernière (GDDR5 à 1674 MHz). Le TDP ne serait du coup "que" de 225W.

Côté performances, les premières fuites évoquent une GTX 480 5 à 10% plus rapide que la Radeon HD 5870. Ce sera suffisant pour permettre à nVidia de reprendre le leadership sur les cartes mono-GPU, mais ATI conservera à priori largement l'avantage sur le rapport performances/consommation.

Posté par Matt le 22/03/2010 à 23h10

Aucun commentaire

Source : Tom's Hardware

Peu après le lancement du "ballot screen", destiné à inciter les utilisateurs de Windows à choisir leur navigateur par défaut, plutôt que d'utiliser systématiquement Internet Explorer, Opera avait annoncé un triplement de son nombre de téléchargement. L'éditeur du navigateur alternatif publie désormais des chiffres plus précis, confirmant l'impact positif du "ballot screen".

En effet, le lancement du "ballot screen" coïncidant à peu près avec le lancement d'Opera 10.50, on pouvait supposer qu'une part de cette augmentation des téléchargements était due à cette nouvelle version plutôt qu'au "ballot screen". Il était donc nécessaire de déterminer plus précisément l'impact de ce dernier, et c'est désormais chose faite, Opera ayant analysé cette fois non pas simplement l'augmentation du nombre de téléchargements, mais aussi la part de ces téléchargements qui provient de l'écran de choix du navigateur.

Voici les résultats obtenus dans différents pays européens, entre le 12 et le 14 mars :

| Pays | Taux d'augmentation | Part due au "ballot screen" |

|---|---|---|

| Pologne | 328% | 77% |

| Espagne | 215% | 68% |

| Italie | 202% | 67% |

| Danemark | 198% | 66% |

| Pays-Bas | 157% | 61% |

| Portugal | 157% | 59% |

| Belgique | 123% | 55% |

| France | 117% | 54% |

| Suède | 111% | 53% |

| Suisse | 109% | 52% |

| Grèce | 93% | 48% |

| Autriche | 85% | 46% |

| Royaume-Uni | 85% | 46% |

| République Tchèque | 64% | 39% |

| Allemagne | 64% | 39% |

| Norvège | 57% | 37% |

| Hongrie | 53% | 35% |

| Moyenne européenne | 130% | 53% |

Au final, le "ballot screen" serait donc responsable de "seulement" 130% d'augmentation du nombre de téléchargement, ce qui est déjà une excellente nouvelle pour Opera, qui espère maintenant une généralisation de ce "ballot screen" à l'ensemble des copies de Windows, et non pas seulement aux versions européennes.

Posté par Matt le 19/03/2010 à 12h58

Aucun commentaire

Source : Generation-NT

Microsoft vient de publier une version "preview" d'Internet Explorer 9 ou, plus précisément, de son moteur de rendu, puisque l'interface graphique du navigateur n'est pas encore incluse dans cette première pré-version.

Au programme de cette nouvelle version, le support du HTML5 et du CSS3, avec notamment la propriété CSS border-radius, dont le support permettra enfin aux visiteurs d'Infobidouille de profiter des rondeurs de l'interface sous IE, alors qu'elles n'étaient pour l'instant supportées que sous Firefox, Chrome, Safari et Opera. De plus, une partie des fonctionnalités apportées par HTML5 seront accélérées par le GPU pour un rendu plus rapide, grâce à Direct2D.

Infobidouille sous IE8 (gauche) et sous IE9 (droite)

Cette nouvelle version atteint désormais 55/100 au test Acid3, soit presque le tripe du score d'IE8 (20/100) et fait d'énormes progrès au test SunSpider (performances JavaScript), en exécutant le test 6 fois plus vite qu'IE8, ce qui permet à IE9 de se positionner entre Firefox 3.6 et les très rapides Safari/Chrome. Le test CSS3 Selectors Test passe pour sa part totalement (578/578), alors qu'Internet Explorer 8 était encore assez loin du compte (349/578).

Pour tester Internet Explorer 9, rendez-vous sur cette page : Internet Explorer 9: Platform Demos.

Posté par Matt le 18/03/2010 à 11h55

2 commentaires

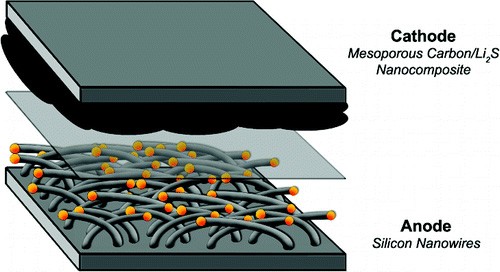

Avec la multiplication des appareils mobiles, de plus en plus petit, il est nécessaire de trouver des solutions pour fabriquer des batteries offrant plus de densité énergétique que les batteries actuelles, afin de pouvoir les miniaturiser. C'est ainsi que les chercheurs de l'université de Standford, aux États-Unis, ont mis au point un procédé permettant de quadrupler la capacité.

Pour ce faire, les américains ont amélioré un procédé qu'ils avaient mis au point en 2007, avec une anode composée de nano-fils de silicium en l'associant à une cathode composée de nano-structures de sulfure de lithium et de carbone. En plus d'avoir une capacité quadrupler , ces nouvelles batteries seraient également bien plus sûres, en présentant beaucoup moins de risque de surchauffe et d'explosion. De quoi offrir de quoi travailler deux jours de suite sur un ordinateur portable sans recharger et en toute sérénité !

Malheureusement, il faudra sans doute encore quelques années avant que de telles batteries arrivent sur le marché — si elles y arrivent un jour. En effet, cette nouvelle technique souffre encore d'un énorme défaut : alors qu'une batterie lithium-ion supporte généralement près de 500 cycles de recharge et une batterie lithium-polymère le double, les batteries lithium-sulfure ne supportent pour l'instant qu'une petite cinquantaine de cycles.

Posté par Matt le 17/03/2010 à 22h27

Aucun commentaire

Source : Engadget via Ptit_boeuf

Comme nous vous le disions il y a quelques jours, les relations ne sont actuellement pas au beau fixe entre Google et les autorités chinoises, à tel point que l'existence même de Google.cn serait désormais menacée.

En cause, les problèmes de censure d'Internet en Chine. Pendant longtemps, le moteur de recherche de Google était totalement bloqué pour les internautes chinois. Cédant aux exigences des autorités en termes de censure, Google avait fini par lancer Google.cn, une version conforme aux règles chinoises, et la seule accessible pour les internautes de l'empire du milieu. Mais depuis quelques temps, les relations entre le géant de l'Internet et la Chine se sont fortement dégradées.

En effet, Google conteste de plus en plus la censure exigée par la Chine, ce qui a mis le moteur de recherche dans le collimateur des autorités. Certains vont même jusqu'à affirmer que les attaques massives effectuées depuis la Chine vers les services Google en début d'année auraient été initiées par les autorités. Une théorie qui n'a pas contribué à l'amélioration des relations entre Google et le gouvernement.

Aujourd'hui, les négociations seraient totalement bloqué, chacun campant sur ses positions. À tel point que, après que Google ait menacé de fermer Google.cn, le gouvernement chinois serait resté fermement sur ses positions, annonçant ne pas être prêt à s'assouplir pour éviter la fermeture. Selon certaines sources proches du dossier, les chances que Google ferme effectivement son service de recherche en Chine serait supérieures à 99%...

Si une telle fermeture intervenait également, peut-être aura-t-elle le mérite d'éveiller un peu plus le reste du monde sur le problème de la censure en Chine.

Posté par Matt le 15/03/2010 à 23h17

Aucun commentaire

Source : Ère Numérique

Avec une petite dizaine de mobiles Android à son catalogue, Motorola pouvait avoir un petit air de partenaire idéal pour Google, en particulier avec le Droid, qui est l'un des mobiles Android les plus aboutis techniquement. Mais le constructeur américain s'apprête à faire un joli pied de nez à Google sur le marché chinois...

En effet, Google n'étant pas en odeur de sainteté auprès des autorités chinoises (ce qui est plutôt un point positif pour Google...), Motorola vient de signer un accord avec Microsoft concernant les mobiles Motorola commercialisés en Chine. Mais pas question de laisser tomber Android au profit de Windows Mobile : cet accord ne concerne pas le système d'exploitation, il se limite en fait... au moteur de recherche par défaut !

Lorsqu'il entrera en effet, d'ici à quelques semaines, cet accord va donc mener à une situation plutôt cocasse : Motorola va commercialiser des appareils utilisant le système d'exploitation du leader mondial de la recherche et le moteur de recherche du leader mondial du système d'exploitation. Au moins, on ne pourra pas accuser Motorola de favoriser les positions dominantes !

Cette annonce fait par ailleurs suite à plusieurs informations plus ou moins officielles selon lesquelles Microsoft chercherait également à évincer Google au profit de Bing comme moteur de recherche par défaut de Safari, tant dans sa version Windows que dans sa version Mac OS X et iPhone OS. Depuis que Google est venu marché sur les plates bandes de Microsoft avec Android, le géant de Redmond semble bien décidé à lui rendre la pareil en déployant une stratégie de conquête agressive sur le secteur de la recherche.

Posté par Matt le 12/03/2010 à 10h40

Aucun commentaire

Source : PCInpact

Le succès de la Wii fait des envieux chez Sony et Microsoft... Ce succès étant principalement dû au gameplay offert par le couple Wiimote/Nunchuck, Microsoft et Sony cherchent à amener un gameplay du même type sur leurs consoles respectives. Du côté de Sony, c'est désormais chose faite, avec le Playstation Move.

Alors que Microsoft s'est lancé dans un système ambitieux (Project Natal), à base de commandes vocales et d'analyse des mouvements du joueur par des caméras, sans que le joueur n'ai à tenir un accessoire dans sa main, Sony a opté pour une solution intermédiaire entre Project Natal et la Wiimote.

En effet, avec la solution Playstation Move, l'utilisateur aura bien une manette en main, aux fonctionnalités très similaires à celles de la Wiimote, et celle-ci pourra être complété d'un Nunchuck (mais sans le fil reliant les deux, chaque élément étant indépendant de l'autre), le Sub Controller. La manette Playstation Move se distingue par contre par la grosse boule lumineuse colorée qui la surmonte. C'est cette boule qui permettra l'analyse des mouvements de la manette, en étant suivie par une caméra Playstation Eye, comme sur Project Natal. Un tel système de suivi devrait permettre des mouvements plus précis qu'avec le système à base d'accéléromètres proposé par la Wiimote.

Par contre, l'addition risque d'être salée, comme souvent avec les accessoires Sony. En effet, la manette Playstation Move sera vendue 100€ avec un jeu, mais sans le Sub Controller, et peut-être même sans la caméra ! De plus, certains jeux pourraient nécessiter l'utilisation de deux Playstation Move par joueur, comme le montre la vidéo de présentation :

Le Playstation Move sera commercialisé d'ici à la fin de l'année, et Sony promet au moins 20 titres l'exploitant avant avril 2011.

Posté par Matt le 12/03/2010 à 00h26

Aucun commentaire

Source : Gamepro

Annoncé l'été dernier, Chrome OS, le système d'exploitation orienté web de Google devrait arriver en version finale dans le courant de l'année, ce qui devrait lancer une vague d'appareils mobiles embarquant ce système.

Jusqu'ici surtout connu pour avoir fourni pendant un temps des processeurs PowerPC à Apple, l'américain Freescale est l'un des premiers à dégainer un produit pour Chrome OS, sous la forme d'une tablette tactile. Dotée d'un écran tactile de 7", elle embarquera un processeur maison, de la famille i.MX51. Celui-ci est un SoC basé sur un cœur ARM Cortex A8 cadencé à 800 MHz, accompagné d'un contrôleur vidéo 3D, d'un décodeur vidéo 720p, de différents contrôleurs d'entrées/sorties (dont l'USB et l'Ethernet) et d'une unité de traitement pour l'acquisition d'images.

Elle sera proposée pour 199$ aux clients OEM de Freescale, mais aucune information n'a été communiquée sur une éventuelle sortie sur le marché du détail.

Posté par Matt le 09/03/2010 à 23h30

Aucun commentaire

Source : Le Journal du Geek

Lancé il y a quelques jours à peine, le "browser ballot screen" imposé à Microsoft par la Commission Européenne pour aider au développement de la concurrence entre navigateurs Internet fait déjà se soulever quelques voix...

En effet, si les éditeurs des quatre principaux navigateurs alternatifs (Mozilla, Google, Apple et Opera) ont de quoi être satisfait, puisque cet écran de choix du navigateur place leurs produits au même niveau qu'Internet Explorer, parmi les cinq navigateurs principaux, affichés dans un ordre aléatoire, on ne peut pas en dire autant des éditeurs de Avant Browser, Flock, GreenBrowser, Maxthon, SlimBrowser et Sleipnir, six des sept navigateurs secondaires proposés par cet écran (le septième étant K-Meleon).

La cause ? Par défaut, quelque soit la taille de la fenêtre, seuls les cinq navigateurs principaux sont visibles, et il faut faire défiler la fenêtre de droite à gauche pour révéler les navigateurs secondaires. Mais les petits éditeurs se plaignent du manque de clarté de l'opération, la page d'accueil n'indiquant pas de façon suffisamment claire le fait que d'autres navigateurs sont disponibles. Les six éditeurs auraient donc déposé un recours auprès de la commission pour faire modifier cet écran de choix avec un peu plus d'équité vis à vis des petits navigateurs.

Il faut dire que les positions du top 5 doivent faire envie... En effet, selon Opera, le nombre de téléchargements de son navigateur aurait été multiplié par trois depuis le lancement de cet écran de choix. Des chiffres qui sont toutefois à prendre avec des pincettes, puisqu'une nouvelle version d'Opera vient de sortir, ce qui a probablement contribué à doper les téléchargements.

Posté par Matt le 09/03/2010 à 10h11

Aucun commentaire

Gandi.net est un prestataire français spécialisé dans l'enregistrement de noms de domaines et, depuis peu, de l'hébergement de sites web. Pour ses dix ans, il offre l'enregistrement de 55 000 noms de domaine en .fr, .tel, .com, .net, .info, .me, .mobi, .uk, .be et .eu. Nous avons obtenu pour vous huit codes promotionnels pour profiter de cette offre.

- 10YRS-53D5-A034-8999,

- 10YRS-3583-21B0-A15E,

- 10YRS-2988-9343-6253,

- 10YRS-DB56-83F3-8C15,

- 10YRS-034D-1752-1FD0,

- 10YRS-22A2-B137-6362,

- 10YRS-F67D-CFE8-FC0F,

- 10YRS-A83F-4429-79CF.

Pour utiliser un de ces bons, rendez vous sur Gandi.net et suivez la procédure d'enregistrement d'un domaine. Au moment du choix du moyen de paiement, saisissez le code dans le champ prévu à cet effet en bas de la page. Les codes sont valables jusqu'au 31 mars 2010.

Attention : ces codes sont bien entendus à usage unique, et sont donc proposés ici sur le principe du "premier arrivé, premier servi" !

Posté par Matt le 06/03/2010 à 16h20

4 commentaires

![]()

Si le CeBIT est normalement pour la plupart des constructeurs l'occasion d'annoncer les produits à venir, OCZ a eu une petite touche d'originalité en "désannoncant" un des ses produits : le SSD Vertex 2 Pro, basé sur le contrôleur Sandforce SF-1500.

En effet, ce SSD, qui devait être lancé dans les semaines à venir va finalement rester dans les cartons d'OCZ, qui n'envisage plus de le commercialiser. La faute au contrôleur SF-1500. Rassurons tout de suite ceux qui attendent avec impatience ce nouveau contrôleur aux excellentes performances : la raison de cet abandon est purement économique, et non pas technique. En effet, Sandforce facturerait la puce et son firmware (puisque seul le firmware diffère entre le SF-1200 et le SF-1500) environ 100$, ce qu'OCZ considère comme excessif pour un SSD grand public à base de mémoire MLC.

Le constructeur va donc se contenter du SF-1200 pour le haut de sa nouvelle gamme grand public, qui devrait se décliner ainsi, de l'entrée vers le haut de gamme :

- Onyx : Indilinx Amigos/ECO,

- Solid 2 : Indilinx Barefoot, mémoire "lente",

- Agility 2 : Sandforce SF-1200 bridé logiciellement,

- Vertex 2 : Sandforce SF-1200.

Le Vertex Limited Edition, disponible actuellement chez notre partenaire Materiel.net pourrait donc vite devenir collector, en étant le seul SSD OCZ grand public à base de SF-1500, avec une production limitée à 5000 exemplaires.

Posté par Matt le 04/03/2010 à 23h43

Aucun commentaire

Source : PCWorld

Après avoir collecté de nombreuses proposition de design pour la nouvelle page d'accueil de Firefox 4.0 via un concours, la fondation Mozilla a révélé le choix réalisé par plus de 3000 votants, qui préfigure ce que sera l'ergonomie du futur Firefox. C'est le travail présenté par l'américain Yartrik Solanki qui a remporté les suffrages.

Cette nouvelle page d'accueil reprendra le concept de vignettes des sites récemment visités, déjà utilisé dans Opera et Safari, mais également proposé par certaines extensions de Firefox. Les sites sur lesquels une identification est possible seront automatiquement reconnus lors de leur ajout aux favoris, et le navigateur proposera alors de stocker également les identifiants dans le favori, permettant directement d'accéder au site et de s'y identifier en un seul clic.

Elle proposera également un équivalent natif de l'extension Session Manager, qui permet d'enregistrer l'ensemble des onglets ouverts pour les relancer plus tard. Cette possibilité sera offerte directement depuis la page d'accueil, avec la possibilité de sauvegarder plusieurs sessions, par exemple pour créer une organisation thématique. Enfin, cette page intégrera un champ de recherche amélioré, doté d'un système d'aperçu dynamique des résultats au fil de la frappe.

Pour plus de détails sur l'ergonomie, vous pouvez visionner la vidéo commentée par son auteur :

Posté par Matt le 04/03/2010 à 16h11

3 commentaires

Source : PCInpact

Depuis que Western Digital avait racheté SiliconSystems pour se lancer sur le marché des SSD, il y a bientôt un an, le constructeur n'avait sorti aucun nouveau modèle de SSD, s'étant jusqu'à présent contenté de vendre sous sa marque les SiliconDrive III de SiliconSystems, destinés au marché professionnel. Mais les choses bougent enfin !

En effet, le constructeur vient d'annoncer le lancement des SiliconEdge Blue, sa première gamme de SSD grand public. Probablement basés sur un contrôleur maison, ces SSD embarquent de la mémoire SSD dans un packaging SATA 3 Gbits/s 2.5". Les débits annoncés sont dans la norme des SSD haut de gamme d'aujourd'hui, avec 250 Mo/s en lecture séquentielle et 170 Mo/s en écriture séquentielle, mais sans plus de précision sur les débits en accès aléatoire. Dommage, ce sont bien souvent eux qui font la différence entre un mauvais SSD et un excellent SSD... Le TRIM est bien entendu présent pour optimiser les performances sur la durée.

Les SiliconEdge Blue seront dans un premier temps proposés en 64, 128 et 256 Go, pour des prix allant de 250 à 800€, avec une garantie de 3 ans.

Western Digital devient ainsi le premier spécialiste du disque dur à véritablement sauter le pas du SSD. En effet, si Samsung et Toshiba, présents depuis longtemps sur le marché des SSD sont également des fabricants de disques durs, ils ne tiraient qu'une faible part de leurs revenus de l'activité disque dur, contrairement à Western Digital ou Seagate.

Mise à jour le 04/03/2010 à 11h40 : Des informations supplémentaires ont filtré au sujet de ce SSD. Le contrôleur ne serait finalement pas un contrôleur maison, mais un JMF612, toutefois doté d'un firmware spécifique, très différent de celui des autres SSD utilisant ce contrôleur.

En lectures et écritures aléatoires, le SiliconEdge Blue atteignent environ 5000 IOPS, soit 20 Mo/s et les premiers tests révèlent des bonnes performances, mais qui n'égalent pas celles des ténors du marché.

Actu originale le 04/03/2010 à 9h10.

Posté par Matt le 04/03/2010 à 11h40

Aucun commentaire

Sources : Clubic et PCWorld

En fin d'année dernière, nous vous parlions du label 80 Plus Platinum, destiné à récompenser les alimentations pour serveur capable d'assurer un rendement supérieur à 90 pour une charge comprise entre 20 et 100% de la capacité nominale. En l'absence de label pour les alimentations classiques, Thortech Power a décidé d'en inventer un....

En effet, ce constructeur propose sur son stand une alimentation de 800W, la Thunderbolt, sur laquelle le constructeur a apposé un logo "90 Plus Efficiency", très largement inspiré du logo "80 Plus Gold", également apposé sur ce modèle. Même si, n'étant pas officiel, ce logo n'engage en rien le constructeur, on peut raisonnablement supposer qu'il est là pour signaler que cette alimentation dépasse les 90% de rendement sur une plage de rendement plus large que celle imposée par la certification 80 Plus Gold, qui ne requiert qu'une petite pointe à 90% autour des 50% de charge (et un rendement supérieur à 87% sur la plage 20-100%).

Peut-être le précurseur d'un véritable label 90 Plus ?

Posté par Matt le 03/03/2010 à 13h41

Aucun commentaire

Source : Revioo

![]()

Sans surprise, le CeBIT 2010, qui se tient en ce moment à Hannovre, en Allemagne, est l'occasion pour les constructeurs de SSD de présenter de nouveaux modèles. Cette année, ce sont les très attendus contrôleurs Sandforce SF-1200 et SF-1500 qui ont été choisis par OCZ, G.skill et Patriot.

Le premier a en effet présenté un nouveau modèle à base de contrôleur SF-1200, le Agility 2, qui va prendre la relève du Agility, qui embarque un contrôleur Indilinx Barefoot. Tout comme le Agility était un Vertex doté de mémoire un peu moins performante, le Agility 2 est un Vertex 2 embarquant une mémoire légèrement plus lente, mais aussi et surtout, moins onéreuse. Il pourrait être proposé à un prix au Go proche de celui des SSD à base de Barefoot. En effet, le Vertex LE est disponible en France à environ 4€ le Go, alors qu'il embarque un contrôleur SF-1500, plus onéreux, contre un peu moins de 3€ le Go pour les Vertex. Comme la plupart des SSD à base de Sandforce, il sera décliné en multiples de 50 Go : 50, 100, 200 et 400 Go. OCZ annonce des débits de 275 Mo/s en lecture séquentielle et 265 Mo/s en écriture séquentielle et 10 000 IOPS en écritures aléatoire de 4 Ko (soit 40 Mo/s).

MàJ le 03/03/2010 à 10h30 : Finalement, la différence entre le Agility 2 et le Vertex 2 ne se ferait pas au niveau des puces mémoires, mais simplement au niveau du firmware, qui briderait les performances du contrôleur. Selon OCZ, le firmware serait également la seule différence entre le SF-1200 et le SF-1500.

Chez G.skill, c'est le SF-1500 qui se montre, au sein du Phoenix. Il sera proposé dans des capacités de 50, 100, 200 et 400 Go, et sera très probablement plus cher que l'Agility 2. En contrepartie, il offrira des performance encore plus élevées en accès aléatoires, comme en attestent les benchmarks présentés par le constructeur, avec près de 75 Mo/s en écritures aléatoires de 4 Ko.

Enfin, du côté de Patriot, ce sont le SF-1500 et le Jmicron JMF612 qui seront de la partie (ou de la patrie :-) ), embarqués respectivement dans le Inferno (50, 100 ou 200 Go) et le Zephyr (64, 128 ou 256 Go).

Actu originale : 02/03/2010 à 23h55

Posté par Matt le 03/03/2010 à 10h30

Aucun commentaire

Sources : 59 Hardware, Revioo et PCWorld

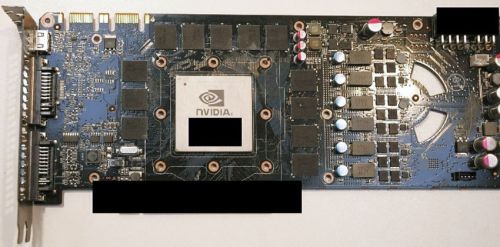

nVidia et ses partenaires ont profité du CeBIT 2010 pour faire quelques démonstration des nouvelles cartes graphiques du caméléon, la GeForce GTX 470 et la GeForce GTX 480, toutes deux basées sur Fermi, la toute nouvelle architecture d'nVidia.

Si nVidia n'a pas voulu montrer de trop près ces cartes graphiques, dont le lancement est prévu pour le 26 mars, en ne présentant que des machines complètes bien fermées, des photos de la GTX 480 démontée ont fait leur apparition sur certains forums. L'occasion de découvrir son imposant PCB :

Ce PCB révèle l'utilisation probable d'un bus mémoire 384 bits (12 puces mémoire de 32 bits) et confirme la consommation supposée très élevée de cette carte, puisque on peut noter la présence de deux connecteurs d'alimentation, un 8 pins et un 6 pins. Une configuration généralement réservée aux cartes bi-GPU... Enfin, on peut constater la présence d'une troisième sortie vidéo, qui prend la forme d'un connecteur mini-HDMI.

Afin d'évacuer la chaleur dégagée par le GPU, celui-ci sera bien entendu surmonté d'un imposant ventirad en aluminium doté de 4 heat-pipes.

Posté par Matt le 03/03/2010 à 09h30

Aucun commentaire

Source : Le Comptoir du Hardware

La gestion des dates est présentes dans les appareils informatiques depuis de très nombreuses années. Et pourtant, les problèmes au niveau de cette gestion font régulièrement parler d'eux dans l'actualité. C'est aujourd'hui au tour de la Playstation 3 d'en faire les frais...

En effet, nombreux sont les joueurs se plaignant aujourd'hui de gros dysfonctionnements de leur console : impossibilité de se connecter au Playstation Network, jeux refusant de se lancer, trophées disparus... Le bug se caractérise par le code d'erreur 8001050F lors de toute tentative de connexion au PSN et par une réinitialisation de la date système de la console au 1er janvier 2000, sans possibilité de la corriger. Il semble affecter la plupart des consoles Playstation 3 antérieures à 2009, mais épargne la récente Playstation 3 Slim.

Selon Sony, qui travaille actuellement à la correction du problème, il s'agirait d'un bug au niveau de l'horloge interne de la console, qui ne supporterait pas correctement le passage au premier mars 2010. Aucune solution de contournement simple n'est encore proposée pour l'instant, la seule solution semblant être une réinitialisation complète de la console en retirant sa pile de sauvegarde, opération qui nécessite le démontage de la Playstation et annule sa garantie.

Vu la date à laquelle le problème est survenu, on ne peut s'empêcher d'imaginer qu'il s'agit d'un problème de gestion des années non bissextiles, même s'il ne s'est pas produit en 2007 et 2009 (il est possible que le problème ait été introduit par une mise à jour postérieure à mars 2009). Un tel bug avait déjà provoqué le blocage des baladeurs Microsoft Zune à la fin de l'année 2008, mais le contournement était à l'époque plus aisé, puisqu'il suffisait de laisser la batterie de l'appareil se décharger, puis de le redémarrer le lendemain.

Sur son blog, Sony recommande de ne pas utiliser la console tant que le problème n'est pas résolu, pour limiter le risque de pertes de données.

MàJ le 02/03/2010 à 15h39 :

Finalement, le contournement de ce bug est aussi simple que pour celui qui avait affecté le Zune il y a un peu plus d'un an, puisqu'en ce 2 mars 2010, les Playstation 3 fonctionnent à nouveau normalement, l'horloge interne bugée étant passée au 1er mars 2010 (après l'inexistant 29 février 2010), une date certes incorrecte, mais qui a tout de même l'avantage d'être valide, rendant à nouveau le système pleinement utilisable, et la date réglable pour la repositionner au 2 mars.

Le composant à l'origine de la panne serait en fait le même que dans le Zune. Espérons donc que, maintenant que le problème est passé, Sony proposera tout de même un correctif logiciel, afin d'éviter que le problème ne se reproduise le 1er janvier prochain ou le 1er mars 2011...

Actu originale : 01/03/2010 à 23h31

Posté par Matt le 02/03/2010 à 15h39

Aucun commentaire

Source : Gamepro

Si le tarif des accès Internet mobiles ont largement diminué depuis l'arrivée des smartphones connectés (iPhone, Android...), permettant de trouver des offres illimitées pour une trentaine d'euros, il existe toujours un point douloureux : la facture en cas d'utilisation de l'accès en roaming à l'étranger. Un point sur lequel la commission européenne s'est penchée pour aider au développement de ce type d'accès.

Ainsi, après une première mesure, il y a quelques mois, qui a imposé un plafonnement de la tarification des accès Internet en roaming, qui ne peuvent plus être facturés plus d'1€ par Mo (un tarif qui devrait d'ailleurs être revu à la baisse dans les prochains temps), les opérateurs européens doivent dès aujourd'hui se plier à une nouvelle mesure : la coupure automatique de la connexion à partir d'une certaine consommation.

Le principe est simple : l'abonné décide d'un montant mensuel maximum de communication qu'il est prêt à se voir facturer pour les accès Internet en roaming. Une fois ce montant fixé, la connexion sera automatiquement coupée si l'utilisateur atteint sa limite. L'opérateur devra également le prévenir lorsque celle-ci aura été consommée à 80%, comme ils le font généralement déjà pour la limite du "fair-use" des forfaits illimités.

La mise en place de cette limitation est optionnelle à partir du 1er mars, et deviendra obligatoire dès le 1er juillet, avec un plafond fixé par défaut à 50€ (soit au minimum 50 Mo) pour les abonnées n'ayant pas communiqué la limite qu'ils souhaitent.