Actualités du mois d'avril 2010

Alors que Google s'est attaqué frontalement au cœur de métier de la fondation Mozilla en lançant son navigateur Chrome, qui a déjà grignoté plus de 6% du marché des navigateurs, Mozilla "riposte" en lançant une version mobile de Firefox pour Android.

Déjà disponible depuis le début de l'année sur Maemo, l'environnement utilisé sur certains smartphones Nokia, Fennec 2.0 (Firefox Mobile) vient en effet d'arriver en version pre-alpha pour Android.

Si vous avez un appareil sous Android, vous pouvez dès à présent télécharger Fennec en version pre-alpha, mais cette version souffrirait encore de sérieux problèmes de stabilité. Vous pourrez ensuite communiquer vos retours à l'équipe de développement via le groupe Google prévu à cet effet.

Posté par Matt le 29/04/2010 à 15h22

Aucun commentaire

Source : Infos du Net

Après P.A. Semi, spécialiste du processeur PowerPC basse consommation il y a deux ans, c'est au tour du rachat d'Intrinsity d'être officialisé par Apple, pour la modique somme de 121 millions de dollars...

Basée à Austin, Intrinsity était une start-up qui s'était spécialisée dans l'optimisation des processeurs de type ARM, ceux là même qu'Apple utilise dans tous ses produits mobiles, de l'iPod Shuffle à l'iPad en passant par l'iPhone. Les rumeurs qui circulaient depuis plusieurs semaines laissaient d'ailleurs entendre que le processeur Apple A4, premier processeur Apple, avait bien été conçu en collaboration avec Internity, et pas seulement avec P.A. Semi.

Il ne fait donc désormais plus aucun doute qu'Apple a bien l'intention d'équiper la plupart de ses produits mobiles de processeurs maisons dans un futur proche. Une mauvaise nouvelle pour Samsung, qui était le fournisseur des processeurs des produits phares d'Apple, l'iPod Touch et l'iPhone. Le Coréen continuera toutefois à assurer la fabrication des puces Apple, la pomme ne disposant pas de chaînes de fabrication de puces.

Mais pour combien de temps ? Dans sa volonté de devenir de moins en moins dépendant de ses fournisseurs, il ne serait pas forcément étonnant qu'Apple finisse par avoir sa propre usine de processeurs, et ce d'autant plus que les besoins d'Apple en la matière pourrait largement justifier une usine dédiée : en 2009, Apple a écoulé plus de 20 millions d'iPhone et 54 millions d'iPod.

Posté par Matt le 29/04/2010 à 10h41

Aucun commentaire

Source : PCInpact

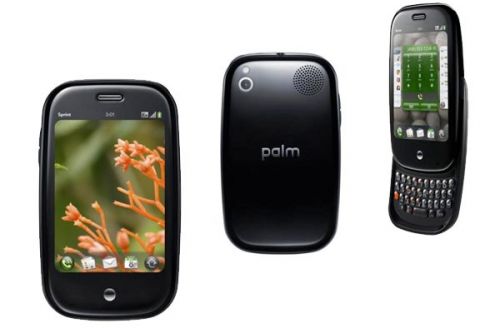

La nouvelle vient tout juste de tomber sur le site de Hewlett-Packard : le constructeur américain vient de racheter Palm pour 1.2 milliards de dollars en cash. Palm était annoncé comme étant en vente depuis quelques temps, mais les rumeurs évoquaient plutôt un rachat par Lenovo, le groupe chinois qui avait déjà acheté l'activité PC d'IBM il y a quelques années.

Pionnier des PDA, Palm avait connu son heure de gloire à la fin des années 1990, avant de rater le virage des PDA vers les smartphones, précipitant l'entreprise dans une mauvaise passe. Elle avait tenté récemment de se relancer avec son smartphone Pre et son système d'exploitation webOS, mais sans succès, les ventes n'ayant pas décollé, malgré le capital sympathie dont disposait encore l'entreprise auprès du public.

La fusion entre Palm et HP devrait débuter en juillet prochain, et on devrait d'ici là en savoir un peu plus sur les projets du géant américain.

Posté par Matt le 28/04/2010 à 23h24

Aucun commentaire

Source : PCInpact

Très attendu par les amateurs de Formule 1, le jeu F1 2010 de Codemasters devrait arriver en fin d'année sur nos écrans (PC, Xbox 360 et PS3). Mais connaissant l'historique des jeux de titine de chez Codemasters, et en particulier les séries Toca/Race Driver et Colin McRae, on aurait pu s'attendre à un gameplay très (trop...) orienté arcade, puisque les deux séries phares de l'éditeur ont dévié vers l'arcade au fil des années...

Heureusement, l'éditeur a mis en ligne une vidéo de présentation qui indique clairement que le jeu va sérieusement pencher du côté de la simulation. Afin d'obtenir un maximum de réalisme, l'éditeur a d'ailleurs engagé comme consultant le britannique Anthony Davidson, ancien pilote de Grand Prix, et pilote d'essai de l'écurie BrawnGP l'année dernière, lorsqu'elle a remporté les deux titres mondiaux.

Le jeu devrait être disponible au mois de septembre. Sur PC, il mettra fin à une période de huit ans sans jeu de Formule 1, tandis qu'il sera le tout premier jeu de F1 sur Xbox. Je sens qu'il y a un G25 qui va chauffer cet automne !

Posté par Matt le 28/04/2010 à 22h42

2 commentaires

Source : Le comptoir du hardware

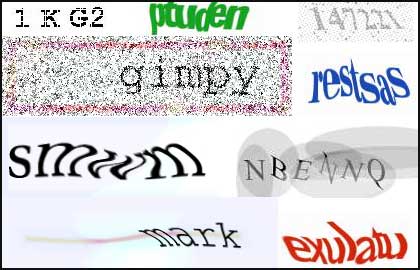

Si vous avez fréquenté Internet ces dernières années, vous êtes quasi forcément tombés plus d'une fois sur des codes captchas, ces systèmes qui vous demandent de recopier un texte parfois quasiment illisible. Leur but est de tromper les logiciels de reconnaissance de caractère, pour empêcher les inscriptions automatisées, souvent utilisées par les spammeurs...

L'intérêt de ces systèmes de plus en plus complexes est que, même si la reconnaissance de caractères reste éventuellement possible, elle nécessite une certaine puissance de calcul, qui peut rendre le cassage peu rentable, en devenant plus coûteux que ce que peut rapporter le compte utilisateur ainsi créé...

Mais les spammeurs auraient finalement trouvé une parade à ces problèmes, en exploitant la pauvreté de certains pays : puisque les captchas sont censés être facilement déchiffrables pour un humain, ils les font déchiffrer par des humains, payés pour le faire... Ainsi, en Chine ou en Inde, des gens sont prêts à passer leur temps à déchiffrer des captchas pour toucher quelques dollars.

Selon le New York Times, les captchas déchiffrés se négocieraient ainsi entre 80cts et 1$20 les mille sur des sites spécialisés dans la mise en relation de travailleurs freelance avec des clients potentiels. Certains auraient même créé des entreprises spécialisées dans le domaine, mais sans grand succès pour l'instant.

Mais loin de remettre en cause l'efficacité des captchas, ces pratiques seraient au contraire la preuve de leur efficacité selon un ingénieur de chez Google : le but des captchas est de rendre la création automatisée de comptes moins rentable pour les spammeurs, ce qui est forcément le cas dans la mesure où ils doivent payer pour pouvoir créer ces comptes.

Posté par Matt le 28/04/2010 à 16h40

2 commentaires

Source : Generation NT

C'est un fait bien connu : les consoles de jeu commencent bien souvent leur carrière en étant vendues à pertes, pour faciliter leur pénétration sur le marché, le constructeur faisant ensuite sa marge sur les jeux et les accessoires, puis, une fois que la production tourne à plein régime, les économies d'échelle et la baisse de prix des composants permettent de vendre sans perte. La PlayStation 3 aurait désormais atteint ce stade, grâce à une nouvelle révision.

Portant la référence CECH-2100A (contre CECH-2000A pour la première PS3 Slim), cette nouvelle révision de la console nippone se distingue de la précédente par son GPU nVidia RSX, qui est désormais gravés en 40nm, contre 65nm précédemment, le CPU Cell restant pour sa part en 45nm. En plus de permettre une réduction du coût de fabrication de la puce elle-même, ce procédé de gravure plus fin permet une réduction de consommation de l'ordre de 15%, ce qui induit indirectement des économies sur d'autres composants, comme par exemple le système de refroidissement et le bloc d'alimentation, qui ont tous deux vu leur poids réduit de moitié par rapport à la PS3 première du nom.

Grâce à ces économies, la console actuellement vendue 300$ serait donc enfin rentable. Il est loin le temps où Sony vendait 500$ une Playstation 3 20 Go qui lui en coûtait 800 !

Posté par Matt le 28/04/2010 à 11h21

Aucun commentaire

Source : Tom's Hardware

À peine quelques semaines après le lancement des premiers processeurs Intel à six cœurs, le Core i7 980X et les Xeon C3600/5600, c'est au tour d'AMD de lancer ses deux premiers processeurs hexacore, les Phenom II X6 1055T et 1090T.

Positionnés à des tarifs très agressifs (190€ le 1055T, 290€ le 1090T), ils ne permettent toujours pas à AMD de reprendre la main sur le haut de gamme, mais l'autorisent à espérer des jours meilleurs, en attaquant Intel sur le plan du rapport performances/prix pour certains usages. En effet, si le 1090T offre des performances moyennes un peu plus faibles que celles du Core i7 920, vendu un peu moins cher, il le surpasse parfois assez nettement, lorsque l'application utilisée est capable de tirer parti des six cœurs. Le Core i7 980X reste bien entendu inatteignable, mais il ne faut pas oublier qu'il est vendu plus de trois fois plus cher...

AMD a également fait de gros efforts sur la consommation de ses nouveaux processeurs, notre confrère PCWorld ayant mesuré sur un X6 1090T à 3.2 GHz une consommation très légèrement inférieure à celle d'un Phenom II X4 965 à 3.4 GHz, soit un rapport performance/consommation en net progrès.

Ces deux processeurs introduisent également chez AMD la technologie Turbo Core, clone du Turbo Boost d'Intel, qui permet d'augmenter automatiquement la fréquence du processeur quand peu de cœurs sont utilisés. Ainsi, le 1055T pourra passer de 2.8 GHz à 3.3 GHz lorsqu'au moins trois cœurs se tournent les pouces, tandis que le 1090T pourra passer de 3.2 à 3.6 GHz.

Notons également que le Phenom II X6 1090T est un processeur "Black Edition", ce qui permet de modifier son coefficient multiplicateur à la hausse, facilitant l'overclocking. Un domaine où il excelle d'ailleurs, PCWorld ayant atteint 4.4 GHz en refroidissement à air (+37.5%) et 6 GHz en refroidissement à l'azote liquide (+87.5% !).

Après être sorti de l'eau côté cartes graphiques, avec les ATI Radeon 5000, le constructeur texan pourrait donc bien être enfin en train d'approcher de la surface du côté des processeurs.

Posté par Matt le 27/04/2010 à 21h59

Aucun commentaire

Source : PCWorld

Non, ne vous inquiétez pas, nous n'allons pas vous parler d'un nième projet de flicage d'Internet, nous allons vous parler ici de polices de caractère. Ceux qui ont un jour voulu faire un site web au design un peu original ont sans doute déjà eu affaire à la problématique des polices : comment s'assurer que le visiteur du site disposera sur sa machine de toutes les polices nécessaires ? C'est le but du format WOFF 1.0, récemment soumis au W3C.

Ce format concurrent du bon vieux TrueType, ou du plus récent OpenType, vise à définir un format standard et libre pour les polices sur Internet (WOFF est l'acronyme de Web Open Font Format). L'idée est de pouvoir référencer dans une page web des polices à ce format, qui seront téléchargées (sous forme compressée) automatiquement par le navigateur de l'utilisateur pour assurer un rendu fidèle des pages visitées.

Microsoft avait déjà tenté de répondre à cette problématique des polices Web il y a deux ans avec son Embedded OpenType, propriétaire et DRMisé, heureusement sans succès. Mais le WOFF pourrait bien réussir là où l'Embedded OpenType avait échoué, grâce à des soutiens de premier choix. En effet, le format WOFF 1.0 a été soumis au W3C par Microsoft, Mozilla et Opera, qui à eux trois cumulent près de 90% du marché des navigateurs... Ils pourraient également être rejoints par Google, qui aurait déjà commencé à implémenter le WOFF dans Chromium, la base open source de Chrome.

Si ce standard venait à être validé, il pourrait également avoir une influence sur le format Flash, qui était justement parfois utilisé pour la réalisation de sites utilisant des polices exotiques, qui étaient alors incluses dans l'application Flash.

Posté par Matt le 27/04/2010 à 16h21

2 commentaires

Source : Generation NT

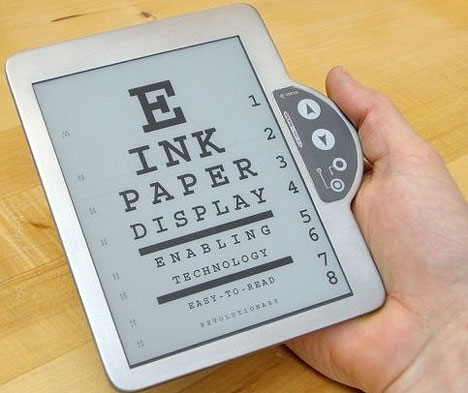

Stars des lecteurs d'e-books, les écran e-paper ont de nombreux avantages pour la lecture, mais ont été quelques peu éclipsés par les écrans LCD depuis l'annonce de l'iPad et autres tablettes tactiles multimédia du même acabit. Mais E-Ink, le constructeurs des écrans e-paper, n'a pas dit son dernier mot...

En effet, il devrait proposer en fin d'année une nouvelle génération d'écrans, affichant des spécifications un peu plus avancées, avec par exemple un taux de contraste pouvant monter jusqu'à 12:1 (le double du taux de contraste d'un journal imprimé, alors que les anciens écrans avaient un contraste inférieur au papier), un affichage sur 16 niveaux de gris et un temps de rafraichissement amélioré, atteignant "seulement" 0.74 secondes...

Des caractéristiques qui peuvent paraitre un peu légère comparées à celles des écrans LCD (les meilleurs approchent les 3000:1 de contraste, avec des temps de réaction de quelques ms et sont capables d'afficher des millions de couleurs...). Mais il ne faut pas oublier qu'ils sont avant tout destinés à la lecture, un domaine dans lequel ils excellent, grâce à un rendu très proche du papier, sans rétro-éclairage, parfaitement lisible en pleine lumière et ne consommant de l'énergie que lors des changements d'image.

Reste à voir si les lecteurs d'e-books parviendront à tirer parti de ces atouts pour garder leur place sur le marché, où s'ils seront totalement dominés par les tablettes, moins adaptées à la lecture mais bien plus polyvalentes. À moins que ce soient finalement les solutions hybrides qui s'imposent, avec des écrans tels que ceux proposés par Pixel-Qi, qui peuvent fonctionner au choix en mode LCD ou en mode e-paper, pour profiter des avantages des deux technologies.

Posté par Matt le 27/04/2010 à 11h01

Aucun commentaire

Source : Presence-PC

Depuis plusieurs années, les fournisseurs d'accès Internet français proposant des offres TV payent une taxe pour contribuer à l'industrie audiovisuelle, taxe en contrepartie de laquelle ils sont autorisés à ne payer la TVA qu'à 5.5% au lieu de 19.6% sur la moitié de leur chiffre d'affaire. Une réduction qui n'est pas au goût de la Commission Européenne...

En effet, la commission a mis la France en demeure de supprimer cet avantage fiscal, qui contreviendrait selon elle à sept articles de la directive européenne sur la TVA. En particulier, la commission critique le fait que certains FAI appliquent ce taux réduit à tous leurs abonnés, y compris ceux qui ne sont techniquement pas en mesure de profiter d'une offre TV.

Cette missive européenne pourrait donc déclencher le mouvement haussier des tarifs d'abonnements Internet, dont l'arrivée prochaine avait déjà été évoquée par Xavier Niel. À noter que, même sans celà, les abonnements auraient probablement augmentés, puisque Nicolas Sarkozy avait déjà évoqué une modification des tranches (45% à 5.5% et 55% à 19.6%) dans le but de financer la Carte musique jeunes.

Posté par Matt le 26/04/2010 à 22h30

Aucun commentaire

Source : Generation NT

Lancé il y a quelques mois, le tuner Elgato EyeTV Netstream DTT joue la carte de l'originalité, en se connectant via le réseau au lieu de l'habituel port USB, ce qui permet de le partager entre plusieurs machines et de le placer au plus près des prises antennes.

Mais ce mode de connexion n'a-t-il pas un impact négatif sur la qualité d'image ou sur la facilité d'utilisation ? C'est ce que nous avons vérifié dans notre test.

Posté par Matt le 26/04/2010 à 10h11

Aucun commentaire

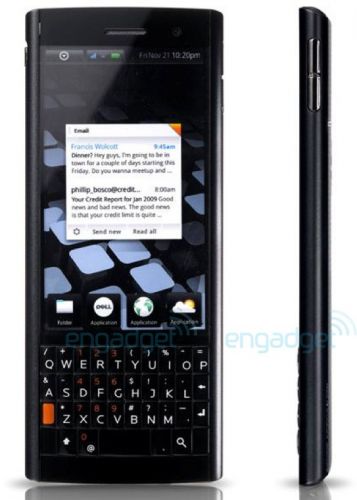

Après une entrée timide sur le marché du smartphone chinois avec le Mini 3, l'américain Dell, jusqu'ici surtout connu pour ses ordinateurs, s'apprêterait à lancer une grosse offensive sur le marché des smartphones et des MID (Mobile Internet Devices), avec pas moins de six appareils dans ses cartons.

Du côté des smartphones, ce sont quatre modèles qui seraient prévus. Tout d'abord, le Lightning, qui devrait être un smartphone sous Windows Mobile 7, occupant le haut de gamme Dell. Il embarquera un écran 4.1" OLED WVGA (800x480) cachant un clavier physique coulissant en mode portrait (façon clavier BlackBerry). Il serait animé par un processeur Qualcomm Snapdragon QSD8250 à 1 GHz, couplé à 512 Mo de RAM et 1 Go d'espace de stockage (extensible par micro-SD). La connectivité réseau sera bien entendu 3G+ (HSDPA et HSUPA), mais aussi Wi-Fi N et Bluetooth 2.1. Comme tout smartphone récent qui se respecte, il sera également doté d'un appareil photo numérique 5 millions de pixels, d'un GPS, d'un magnétomètre (boussole), d'accéléromètres, de capteurs de luminosité et de proximité, mais aussi, et c'est plus rare, d'un tuner FM. Il est attendu pour le dernier trimestre 2010.

Les trois autres smartphones seront dotés d'Android 2.2 et seront compatibles Flash 10.1, mais ils n'arriveront que début 2011. Le plus haut de gamme sera le Dell Thunder, qui devrait reprendre les caractéristiques du Lightning, mais avec un APN 8 MP et sans le clavier coulissant.

Le Flash occupera pour sa part le milieu de gamme. Plus compact avec son écran LCD de seulement 3.5" (mais toujours en 800x480), il se contentera d'un processeur Qualcomm MSM7230 à 800 MHz et de 512 Mo d'espace de stockage, le reste des caractéristiques étant inchangées.

Enfin, le Dell Smoke reprendra les caractéristiques du Flash, mais avec un écran 2.8" et un clavier complet, en mode portrait, comme sur le Lightning, mais non coulissant, ce qui donne un téléphone au design assez original, avec un combiné très allongé.

Du côté des MID, le texan prévoit deux tablettes sous Android 2.1. La première, qui devrait être disponible au troisième trimestre 2010 s'appellera Streak, et se présentera sous la forme d'une tablette 5". Dotée d'un processeur Snapdragon 1 GHz, elle proposera une connectivité 3G et Wi-Fi, mais un modèle Wi-Fi uniquement serait également prévu. Elle proposera également un capteur photo 5MP et un GPS.

Plus grande, la tablette Looking Glass 7" est prévue pour le dernier trimestre 2010. Elle s'appuiera sur la plateforme nVidia Tegra 2 T20 épaulée par 4 Go de RAM. Le stockage se fera dans les 4 Go de mémoire flash interne ou sur une carte SD. La connectivité inclura la 3G+, le Wi-Fi N et le Bluetooth 3.0, mais aussi un port USB 2.0 maître, qui devrait par exemple permettre la connexion d'une clé USB. Elle sera également dotée d'une camaré 1.3 MP en façade pour la visioconférence, d'accéléromètres, d'un magnétomètre et d'un récepteur GPS. Le tout dans seulement 12.8mm d'épaisseur (pour 20cm de long et 13 de large) et 500 grammes. En option, elle pourra également accueillir un tuner TV numérique compatible avec l'ATSC (Amérique du Nord) et le DVB-T (Europe, Russie, Moyen-Orient, Afrique, Asie du Sud, Océanie...).

Posté par Matt le 23/04/2010 à 11h31

Aucun commentaire

Sources : PC Inpact et Clubic

Il y a deux ans, Apple s'offrait P.A. Semi, un petit constructeur de processeur, alors spécialisé dans les processeurs PowerPC basse consommation, et qui est probablement à l'origine du processeur A4 qu'Apple a développé pour son iPad.

Mais ce rachat n'avait pas été au goût de tout le monde, et plusieurs cadres importants de P.A. Semi avaient alors quitté le navire pour créer une nouvelle entreprise, Agnilux. Sans qu'on sache réellement sur quoi travaille cette jeune entreprise (les rumeurs évoquent toutefois une activité dans le domaine des serveurs), celle-ci a discrètement été rachetée par Google. Le nouveau meilleur ennemi d'Apple vient donc de mettre la main sur quelques perles, dont le fondateur de P.A. Semi, qui s'était illustré par le passé en étant le designers des processeurs StrongARM, qui ont été très utilisés dans les PDA.

Reste maintenant à voir pourquoi Google a réalisé cette acquisition. Le site d'Agnilux est désormais hors ligne, mais celui-ci ne renseignait pas particulièrement sur l'activité de la société, puisqu'il se contentait de signaler son changement d'adresse et l'origine de son nom, comme en atteste le cache de Google :

L'étymologie du nom Agnilux pourrait toutefois laisser imaginer quelque chose dans le domaine de la fibre optique ou peut-être même des processeurs optiques, mais ce n'est là que pure spéculation de notre part.

Indépendamment du domaine d'activité d'Agnilux, Google pourrait être intéressé par les compétences des anciens employés de P.A. Semi : les processeurs basse consommation et les architectures ARM. De quoi imaginer que Google pourrait, comme Microsoft, s'intéresser au puces ARM pour optimiser la consommation de ses nombreux serveurs, ou encore que le géant de la recherche envisage de se lancer dans une concurrence encore plus frontale avec Apple, en se mettant à fabriquer ses propres téléphones et tablettes Android, dotés de processeurs Google.

Espérons que Google annoncera rapidement la couleur.

Posté par Matt le 22/04/2010 à 22h19

Aucun commentaire

Source : PC Inpact

Alors qu'Intel dispose d'une marge confortable sur son concurrent AMD sur le plan du rapport performances/consommation de ses processeurs, le fondeur de Santa Clara ne semble pas vouloir se reposer sur ses lauriers, puisqu'il annonce de nouvelles baisse de TDP pour ses futurs processeurs.

Ainsi, du côté de la plateforme Atom, la prochaine génération (nom de code "Cedar"), qui sera gravée en 32nm et qui est prévue pour 2011 ne consommera plus que 5W pour la plateforme complète (CPU avec son GPU et son northbridge intégrés + southbridge), contre 7 à 8W pour l'actuelle plateforme Pine Trail et 12W pour la première génération d'Atom. En plus de permettre une augmentation sensible de l'autonomie des netbooks, cette consommation en baisse devrait permettre de multiplier les configuration entièrement passives.

Du côté des machines de bureau, les progrès pourraient être encore plus importants. En effet, le processeurs Sandy Bridge quadri-cœur, les successeurs des actuels Nehalem (Core i3, Core i5 et Core i7) devraient voir leur TDP réduit à 45W, et même 35W en version S. La gamme Nehalem actuel est proposée avec des TDP allant de 73W à 95W, tandis que les Core 2 étaient pour la plupart à 95W en quadri-cœur et 65W en double cœur. Cette baisse importante pourrait toutefois être due à une baisse de la marge que s'accorde Intel à ce niveau, qui est parfois importante. Par exemple, la plupart des Core 2 Quad consommaient en pratique moins de 65W en pleine charge, bien qu'Intel les ait annoncés avec un TDP de 95W.

Si ces chiffres se confirment, AMD risque d'avoir bien du mal à recoller à Intel, et pourrait être contraint à se contenter de proposer des puces d'entrée de gamme.

Posté par Matt le 22/04/2010 à 11h00

Aucun commentaire

Source : Tom's Hardware

![]()

Décidément, Oracle n'aura vraiment pas mis bien longtemps à annoncer la couleur après le rachat de Sun : le géant de la base de données à bien l'intention de tirer profit de son achat, en rentabilisant au maximum les produit de Sun... Ainsi, après avoir annoncé la fin de la gratuité de Solaris, Oracle fait désormais payer le plug-in ODF pour Office.

Distribué gratuitement par Sun depuis 2007, ce plug-in apportait à la suite bureautique de Microsoft (versions 2000, XP, 2003 et 2007) le support des différents formats de fichiers OpenDocument, un format de fichier libre et standardisé ISO, qui est le format de prédilection de la suite OpenOffice, la suite bureautique libre dérivée de StarOffice, qui fait partie des produits Sun appartenant désormais à Oracle.

Il en coûtera donc désormais 65€ pour profiter pleinement de l'ODF sous Office pour une durée illimitée. Oracle propose aussi des licences limitée dans le temps, pour des durées de 1 à 5 ans, à des prix compris entre 13 et 45€.

Posté par Matt le 21/04/2010 à 22h15

Aucun commentaire

Source : PCWorld

Le chinois Lenovo vient d'annoncer deux nouveaux modèles de Thinkpad dans sa série "L", en mettant l'accent sur le côté écologique de ces machines, que Lenovo n'hésite pas à considérer comme les ordinateurs portables les plus écologiques du marché (c'est Apple qui va pas être contente !).

Pour parvenir à ce résultat, Lenovo a conçu des machines conformes aux dernières normes environnementales (Energy Star 5 et EPEAT Gold) et les a construit en ayant recours à un maximum de matériaux recyclés. Ainsi, les plastiques recyclés à partir de bouteilles usagées représentent près de 20% du poids de la machine. Des efforts seront également faits sur l'emballage, quasiment entièrement recyclable, probablement en remplaçant les habituelles cales en polystyrène par des structures en carton maché.

Ces ordinateurs portables écologiques sont proposés dans un premier temps sous deux références, L412 en 14" et L512 en 15". Ils pourront être dotés de différents modèles de processeur basés sur l'architecture Arrandale (Celeron P4500, Core i3, Core i5) éventuellement épaulés par une carte graphique ATI, pour ceux qui ne pourraient pas se contenter du GMA intégré.

Il seront disponibles à partir du mois de mai, avec un prix d'entrée fixé à 649$.

Posté par Matt le 21/04/2010 à 12h41

Aucun commentaire

Source : Lenovo

Alors qu'Intel fait de gros efforts pour imposer ses architectures x86 dans mes appareils nécessitant des processeur basse consommation, via des déclinaisons de plus en plus sobres de sa puce Atom, Microsoft prend une direction qui risque de ne pas plaire au géant des semi-conducteurs...

En effet, pour réduire les coûts de fonctionnement de son moteur de recherche Bing, Microsoft désirerait opter pour des serveurs à base de SSD et des processeurs ARM. Bien que moins puissant que les processeur Atom, les processeurs ARM offrent généralement un rapport performances par W nettement plus favorables, ce qui les rend bien plus intéressant pour toutes les applications facilement parallélisables, pour lesquelles la multiplication des processeurs permet de compenser la plus faible puissance unitaire.

Et c'est typiquement le cas d'un moteur de recherche, qui traite des milliers de requêtes en parallèle, et qui peut donc très bien s'accommoder d'une multitude de processeurs peu puissants.

Pour la petite anecdote, Microsoft a déjà tenté l'expérience avec des serveurs dotés des processeurs Atom chers à Intel. Bien qu'elle se soit révélée concluante, cette expérience semble donc ne pas suffire à Microsoft, qui souhaite désormais réduire encore plus la consommation de ses machines. Il est vrai que la facture d'électricité d'un moteur de recherche comme Bing doit sans doute comporter un grand nombre de chiffre, ce qui doit être particulièrement motivant pour chercher à réduire la consommation.

Posté par Matt le 20/04/2010 à 23h40

3 commentaires

Source : Tom's Hardware

![]()

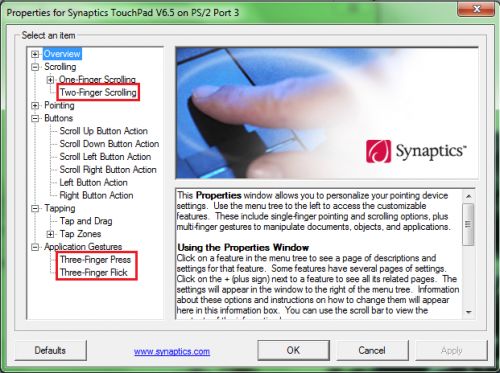

Développée par Synaptics, acteur majeur du marché des trackpads, la technologie multi-touch qui équipe le trackpad des Macbook et Macbook Pro était jusqu'alors quasiment réservée à Apple. Pourtant, le fabricant équipe de nombreux autres constructeurs d'ordinateurs portables, dont HP.

Et c'est justement sur le site d'HP que vient d'apparaître un nouveau driver Windows pour les trackpads Synaptics, qui devrait intéresser plus d'un possesseur d'ordinateur portable. En effet, l'américain a publié sur son site de nouveaux drivers pour ses ordinateurs portables dotés de trackpads Synaptics, drivers qui ont comme principale nouveauté d'activer des fonctionnalités multi-touch à deux et trois doigts sur ces trackpads.

Ces drivers fonctionneraient également sur les ordinateurs portables d'autres marques, pour peu qu'ils soient équipés eux aussi de trackpads de chez Synaptics.

Mise à jour le 20/04/2010 : après Windows, c'est au tour de Linux de bénéficier de drivers Synaptics supportant les actions multi-touch. Malheureusement, le constructeur a choisi de ne pas publier ses drivers sous licence libre et de ne les fournir qu'au constructeurs d'ordinateurs. Les drivers ne sont donc pas disponibles au téléchargement pour l'instant, mais les utilisateurs de machines Linux dotées d'un trackpad Synaptics ont intérêt à surveiller les forums dans les prochains temps, il ne serait pas surprenant de voir apparaitre un lien vers ces drivers, annoncés comme compatibles avec les distributions les plus courantes chez le "grand public" (Ubuntu, Xandros, Fedora, SUSE...).

Actu originale : 22/03/2010 @ 23h51

Posté par Matt le 20/04/2010 à 22h27

Aucun commentaire

Sources : Clubic et Tom's Hardware

Vous rêvez depuis longtemps d'avoir la vue sur la mer ou sur le Mont-Blanc le matin au réveil, sans pour autant avoir envie de quitter votre nid douillet en plein centre ville (ben oui, faut bien le haut-débit !) ? RationalCraft a pensé à vous !

Ce site propose en effet une solution originale pour palier à la pénurie d'appartements avec vue imprenable sur tel ou tel paysage : Winscape. Sous ce nom se cache un système de "fenêtre virtuelle", composée de deux téléviseurs plasma de 46" placés verticalement et maquillés en fenêtre et d'un Mac Pro pilotant les deux écrans pour y afficher la vue de vos rêves et contrôlable à distance via une application iPhone. Pas grand chose de plus qu'un gros cadre photo numérique me direz vous...

Mais en fait si : grâce à une Wiimote (qui est incontestablement le périphérique de jeu le plus souvent détourné de son usage...) interfacée avec le Mac Pro et à un collier infrarouge porté par l'utilisateur, le système détecte les mouvements de l'utilisateur en temps réel et adapte l'image en conséquence, donnant l'impression qu'il s'agit de véritables fenêtres. Il faut reconnaitre que le résultat est plutôt bluffant :

Ce système a toutefois certaines limitations... Tout d'abord, il est mono-utilisateur. Une seconde personne située dans la même pièce verra le même point de vue que la personne équipée du fameux collier. Ensuite, il y a le coût d'une telle installation : comptez au bas mot 1000€ par écran et 2000€ de Mac Pro... Enfin, il y a le coût à l'usage, avec une consommation électrique de plusieurs centaines de watts. Sans parler de l'impact sur la température de la pièce, à plus forte raison si elle est dépourvue de fenêtre...

Une solution qui restera donc sans doute encore très longtemps de l'ordre de la démo technologique, et qui ne remplacera donc pas de si tôt une vraie vue sur les montagnes :

Posté par Matt le 19/04/2010 à 22h19

Aucun commentaire

Source : Clubic

Si vous avez déjà travaillé dans un bureau partagé entre plusieurs personnes, vous avez forcément déjà eu le problème : plus il y a de personnes dans le bureau, plus le brouhaha de clics de souris se fait présent... Pas idéal pour la concentration.

Mais le constructeur asiatique JSCO a pensé à vous en lançant la Noiseless Mouse. Un mulot à l'apparence et aux fonctionnalités tout a fait classiques (deux boutons, une molette...), mais qui effectue son travail dans un parfait silence, comme son nom l'indique.

Reste à vérifier une chose avant de savoir si cette souris va pouvoir révolutionner la vie des open-space : l'utilisateur n'est-il pas trop perturbé par l'absence de retour auditif lorsqu'il clique ? On se souviendra que Apple a déjà réalisé des souris capables de cliquer sans bruit, mais qu'elles ont été dotées d'un haut parler reproduisant le son du clic...

Posté par Matt le 16/04/2010 à 11h40

Aucun commentaire

Source : Le Journal du Geek

Pour ceux qui désireraient sauter le pas vers les SSD, notre partenaire Materiel.net offre en ce moment, et jusqu'à dimanche une réduction de 5% sur tous ses SSD.

Vous trouverez ainsi les OCZ Vertex à partir de 125€, les RealSSD C300 à partir de 413€ ou encore les Intel X25 à partir de 123€.

Posté par Matt le 16/04/2010 à 00h34

Aucun commentaire

Oui oui, vous avez bien lu : une partie d'Infobidouille est désormais archivée à la bibliothèque nationale du Congrès, bibliothèque nationale des États-Unis et plus grande bibliothèque du monde.

Pourquoi ? Comment ? La bibliothèque du Congrès vient tout simplement d'annoncer qu'elle allait archiver l'intégralité des messages postés sur Twitter, passés et à venir. Ce qui inclus donc les quelques tweets de notre compte Twitter. La tâche s'annonce lourde pour la bibliothèque, puisqu'elle devra archiver pas moins de 55 millions de message par jour. Et ce, quelque soit la qualité ou la pertinence du contenu... Dans les archives numériques du congrès les "wesh je tweet 2pui mé chiotte" côtoieront donc les messages des twiters officiels des grands de ce monde ! De quoi faire rigoler les historiens dans quelques générations.

Cette décision d'archiver Twitter viendra compléter l'impressionnant dispositif d'archivage numérique de la bibliothèque du Congrès, qui sauvegarde inlassablement depuis une décennie des millions de pages web, qui représentent aujourd'hui pas moins de 167 To de données.

Posté par Matt le 15/04/2010 à 23h04

Aucun commentaire

Source : PCInpact

Apple a mis à jour aujourd'hui sa gamme de portable MacBook Pro. Une mise à jour très attendue par la communauté Apple, les portables de la marque n'ayant plus été mis à jour depuis fort longtemps (mi-2009), et commençant a être dépassés par la concurrence, dotée de processeurs Intel Core i5 et i7 depuis quelques mois.

Les modèles 13" devront par contre encore se contenter de Core 2 Duo 2.4 GHz (1149€) et 2.66 GHz (1449€), accompagnés d'un chipset graphique intégré nVidia GeForce 320M, une évolution du 9400M, offrant des performances environ 50% supérieures. Les deux versions embarquent également 4 Go de RAM, tandis que l'espace disque est de 250 Go en entrée de gamme et 320 Go en haut de gamme. En option, Apple propose 8 Go de RAM pour 360€ et des SSD de 128 Go à 512 Go, pour 270 à 1305€ (ouch !!!). Apple annonce également une impressionnante autonomie de 10 heures, un record pour un portable Apple.

La nouvelle gamme 15" comporte pour sa part trois modèles, proposés à 1749, 1949 et 2149€. Ils embarquent respectivement un Core i5 2.4 GHz, un Core i5 2.53 GHz et un Core i7 2.66 GHz, épaulés par 4 Go de RAM et alimentés par une batterie offrant 8 à 9h d'autonomie. La partie graphique est confiée à une GeForce GT 330M 256 Mo sur les deux premiers modèles et 512 Mo sur le troisième. Elle travaille de paire avec le GPU Intel intégré aux Core i5/i7, pour préserver l'autonomie en faible charge, sans sacrifier les performances. Les deux modèles haut de gamme on droit à un disque dur de 500 Go, contre 320 Go pour le "premier prix". Au niveau des options, on retrouve les 8 Go de RAM à 360€ et les SSD de 128 à 512 Go (de 180 à 1260€), mais aussi deux options écran : un 15" brillant de plus haute résolution (1680x1050 au lieu de 1440x900) pour 90€, et cette même dalle haute résolution déclinée en version matte pour 135€.

Enfin, le modèle 17" se retrouve désormais à peine plus cher que le 15" haut de gamme (2249€), mais, une fois n'est pas coutume, il est moins puissant que son petit fère, puisque sa configuration de base se contente d'un processeur Core i5 2.53 GHz, le reste de la configuration étant identique. En option, on pourra passer au i7 2.66 GHz pour 180€, à 8 Go de RAM pour 360€, à un SSD de 128 à 512 Go pour 180 à 1170€ et à une dalle matte pour 45€.

Le gros point fort de cette nouvelle gamme est clairement l'autonomie, qui progresse encore par rapport à la gamme précédente, qui avait déjà mis la barre très haut, mais elle laisse par contre un goût amer à une bonne partie de la communauté, en raison de sa tarification encore plus élitiste, particulièrement sur les modèles 15", dont le prix d'entrée passe de 1600 à 1750€.

Posté par Matt le 13/04/2010 à 21h38

3 commentaires

Source : Macbidouille

Alors que c'est cette année que la Formule 1 devrait - enfin ! - faire son retour sur PC, après près de dix ans de disette pour les amateurs du genre, Pacesetter propose déjà une alternative aux plus passionnés... et aux plus fortunés.

Reprenant le design arrière d'une Formule 1 Ferrari, dont le museau aurait été remplacé par un imposant système d'écran, le Pacesetter 8327 Grand Prix Simulator est un simulateur tout-en-un : siège, ordinateur, écrans, volant, pédalier, système audio 3D, retour de force, et même logiciel dédié, reprenant les tracés d'une quarantaine de circuits automobiles.

Comptez tout de même 25 000€ pour le modèle haut de gamme. Un prix un peu élevé, pour lequel vous n'aurez même pas droit à des écrans LCD, tandis que le siège baquet ne semble pas installé sur vérins, ce qui rend le titre de "World's Most Advanced Simulator" avancé par le constructeur un brin présomptueux...

Posté par Matt le 13/04/2010 à 11h40

Aucun commentaire

Source : Tom's Hardware Guide

![]()

Depuis quelques années, on observe chez les constructeurs de clés USB une différenciation des produits qui se base parfois non plus sur le produit lui même, mais sur le contenu pré-enregistré sur le support : albums musicaux, logiciels, films... Seagate tente désormais de transposer ce modèle aux disques durs externes, avec pas moins de 21 films préchargés sur son FeeeAgent Go de 500 Go.

Disponible pour l'instant uniquement aux États-Unis, cette offre n'est toutefois pas aussi alléchante qu'elle en a l'air. En effet, même si les 21 films (Star Trek, The Curious Case of Benjamin Button, GI Joe, Shooter, The Hunt for Red October, The Italian Job, Ghost, Patriot Games, Beowulf, Enemy at the Gates, The Spiderwick Chronicles, The Love Guru, Coach Carter, The Manchurian Candidate, Nacho Libre, Jackass 2.5, A Plumm Summer, Carriers, Dance Flick, Jimmy Neutron: Boy Genius et Sky Captain and the World of Tomorrow) sont bien préchargés sur le disque dur (et y occupent sans doute un espace conséquent...), seul le premier est accessible dès l'achat du disque.

Pour les autres, il faudra passer à la caisse pour obtenir une clé permettant de débloquer les fims, protégés par un système de DRM. Une clé qui sera facturée 9.99 ou 14.99$ selon le titre choisi. Une offre qui n'est donc finalement pas forcément très intéressante par rapport à un DVD, ou même un Blu-Ray, mais qui a au moins le mérite d'exister, et pourrait peut-être lancer une concurrence sur les prix.

Posté par Matt le 12/04/2010 à 23h28

1 commentaire

Source : Tom's Hardware

C'est désormais une habitude chez Hardware.fr : depuis plusieurs années, notre confrère publie des statistiques plutôt intéressantes, celles des taux de retour de différents composants informatiques. Comme d'habitude, la méthode consiste à relever le taux de retour SAV sur des produits âgés de 6 mois à 1 an (vendus entre avril 2009 et septembre 2009). Les statistiques sont calculées par marques (avec un minimum de 500 ventes), mais aussi par produits plus les plus vendus (minimum 100 exemplaires).

Du côté des cartes mères, c'est ASRock qui s'impose, avec seulement 2.21%, tandis que sa maison mère Asus occupe la quatrième et dernière place, avec 3.05%. Les quatres marques représentées (ASRock, Gigabyte, MSI et Asus) ont toutes connu une baisse significative de leur taux de panne, à l'exception d'MSI, en légère hausse, ce qui le fait passer de la 1ère à la 3ème place.

Au classement de la fiabilité des alimentations, neuf marques sont représentées, avec Antec en première position (1.2% contre 0.84% il y a 6 mois) et Hiper en dernier (4.75% contre 4.47% il y a 6 mois). Les sept marques intermédiaires sont toutes en progression sur la fiabilité, à l'exception de Seasonic (1.89% et 5ème contre 1.31% et 2ème) et Enermax (3.61% et 8ème contre 3.1% et 7ème).

Au niveau des barrettes de RAM, c'est toujours Kingston qui est en tête, mais moins nettement qu'auparavant, avec un taux de retour de 0.37%, contre 0.78% pour le second (Crucial), alors qu'il y a 6 mois Kingston affichait un taux de 0.47%, soit trois fois moins que G.skill, le second de l'époque, à 1.46%. OCZ reste dernier, avec un taux de 2.76% contre 2.56% il y a 6 mois.

Sur le marché des cartes graphiques, on retrouve au trois premières places trois des quatres fabricants de cartes mères (ASRock manque à l'appel, n'étant pas présent sur ce marché), mais dans le désordre : MSI à 1.24%, suivi de près par Gigabyte (qui divise son taux de retour par deux, de 2.63% à 1.28%) et Asus à 1.51%. Les autres constructeurs dépassent les 2%, et atteignent jusqu'au 3.35% pour Point of View, dernier malgré de bons progrès (4.67% il y a 6 mois). Les cartes subissant le plus de pannes sont celles à base de Radeon HD 4870 X2 (plus de 12% !), mais globalement, ATI reste plus fiable qu'nVidia.

Enfin Hardware.fr s'est penché sur le taux de panne des disques durs. Alors que ceux-ci ont une bien mauvaise réputation, ils s'avèrent en fait être parmi les plus fiables des composants étudiés, puisque seules les barrettes de mémoire font mieux. Mais une panne de disque dur est probablement une panne plus marquante pour l'utilisateur, ce qui explique la mauvaise réputation des disques. Western Digital perd sa première place au profit de Hitachi, mais les deux constructeurs restent dans un mouchoir (0.92% pour Hitachi, 0.99% pour Western Digital, contre 0.92% et 0.89% il y a 6 mois), tandis que Seagate reste bon dernier (cinquième), à 2.58% (contre 2.89%). Samsung progresse en fiabilité (1.93% contre 2.25%) mais perd une place (quatrième) au profit de Maxtor (3ème), dont la fiabilité progresse fortement (1.73% contre 2.79%). Les disque durs Seagate 7200.11 et Maxtor DiamondMax 22, qui partagent la même plateforme, sont à éviter à tout prix, puisque tous les modèles dépassant 5% de panne sont dans ces deux familles, avec une pointe à 39% pour le 7200.11 de 500 Go. Sur les disques d'1 To, la palme revient à Western Digital, qui place ses deux Caviar (Green et Black) ex-aeqo en tête du classement (0.7%), avec une confortable avance sur le troisième (Hitachi 7K1000.B, 1.2%).

Enfin, notre confrère conclut sur la liste des 10 produits à éviter, qui reprend les dix produits affichant le plus fort taux de retour sur les six premiers mois de vie, dont 5 produits dépassant 5% de retour. Parmi eux, on trouve 7 référence de RAM (dont 4 OCZ), une alimentation, une carte mère et un disque dur.

Posté par Matt le 12/04/2010 à 23h12

Aucun commentaire

L'information circule sur Internet depuis quelques temps : La Poste souhaiterait se lancer dans la téléphonie, comme au bon vieux temps des PTT, avant la séparation de La Poste et de France Télécom en deux entités. Ce retour aux sources se ferait via la téléphonie mobile, en mettant en place un MVNO.

Mais sur ce dossier, une information pour le moins surprenante a fait son apparition : parmi les quatre opérateurs mobiles (les trois déjà en place, Orange, SFR et Bouygues Télécom, et le nouveau, qui arrivera en 2012, Free Mobile) dont le réseau peut servir de base à l'établissement d'un MVNO, La Poste aurait finalement porté son choix vers... Free Mobile ! C'est-à-dire vers l'opérateur qui non seulement n'a pas encore de réseau, mais qui en plus fera passer une partie de son trafic par l'un des trois autres réseaux.

On peut supposer que l'opérateur a décidé de faire un cadeau à La Poste en rognant fortement sur ses marges, avec à la clé la possibilité d'amortir plus rapidement son réseau grâce au parc d'abonné de La Poste, qui vise jusqu'à 2 millions d'abonnés mobiles d'ici à 2015, avec une offre qui serait lancée en 2011.

Pour rappel, un MVNO (Mobile Virtual Network Operator) est un opérateur mobile "virtuel", qui ne dispose pas de réseau cellulaire propre. Pour assurer son service, il fait circuler l'intégralité de son trafic via les réseaux des "vrais" opérateurs. En France, tous les opérateurs mobiles autres que Orange, SFR et Bouygues sont des MVNO. Free Mobile aura pour sa part une position intermédiaire : il s'est engagé à couvrir un certain pourcentage de la population avec son propre réseau, et passera par le réseau d'un autre opérateur pour couvrir l'ensemble de la population, en attendant de développer suffisamment son propre réseau.

Posté par Matt le 09/04/2010 à 10h39

Aucun commentaire

Source : Tom's Hardware

Pendant que certains travaillent à améliorer la capacité des batteries grâce aux nano-technologies ou en utilisant de l'oxygène, Hitachi travaille de son côté sur la durée de vie des batteries (mais nul doute qu'il travaille également sur la capacité, comme tout le monde :-) ).

En effet, le nippon a annoncé avoir mis au point une technologie qui permettrait de doubler la durée de vie des batteries Lithium-Ion, qui sont parmi les plus utilisées actuellement, grâce à leur densité d'énergie. On les retrouve notamment dans les ordinateurs portables, les baladeurs, les téléphones mobiles, les appareils photos numériques, les voitures hybrides et les voitures électriques.

Grâce à son nouveau procédé, Hitachi pense pouvoir dépasser les dix ans de durée de vie, tout en réduisant les coûts de fabrication grâce à une diminution de la quantité de cobalt utilisée pour les électrodes.

Deux qualités qui seront particulièrement bienvenue pour les voitures électriques, qui ont besoin de batteries longue durée et dont le prix est aujourd'hui peu compétitif par rapport aux modèles essence ou diesel à cause du coût des batteries.

Posté par Matt le 09/04/2010 à 00h06

Aucun commentaire

Source : Tom's Guide

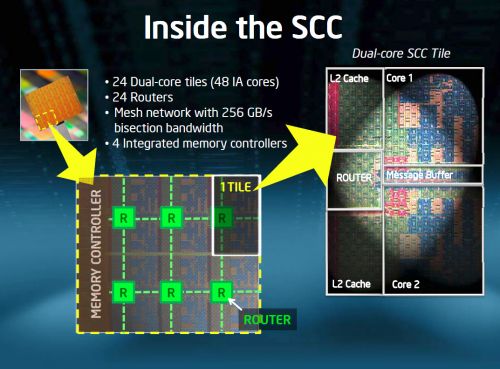

Dans le cadre se son projet Tera-scale, Intel avait fait la démonstration en 2007 de la puce Polaris, qui embarquait pas moins de 80 cœurs. Sa descendante, plus modeste ("seulement" 48 cœurs) devrait être distribuée par Intel dès ce trimestre.

Baptisée SCC (Single-chip Cloud Computer) et gravée en 45nm, cette puce est constituée de 24 blocs de traitement (dotés chacun de 2 cœurs et de leur cache L2 non partagé), de 6 contrôleurs mémoire DDR3 (partagé chacun entre 4 blocs de traitement). La communication entre les cœurs s'effectue via un réseau interne contrôlé par 24 routeurs (un par bloc de traitement), à des débits pouvant atteindre 256 Go/s. Le plus impressionnant est la consommation de la bête, puisqu'elle reste plutôt modeste compte tenu du nombre de cœur : 25 à 125W en fonction de la charge.

Cette puce sera distribuée par Intel dès ce trimestre. Loin d'être un produit commercial, elle restera sans doute réservée à quelques partenaires privilégiés et à des labos de recherche, qui pourront utiliser cette puce pour étudier les architectures massivement parallèles et construire ainsi le futur de l'informatique.

Posté par Matt le 08/04/2010 à 23h48

1 commentaire

Source : Hardware.fr

Il y a quelques jours, Sony a diffusé la mise à jour 3.21 du firmware de sa PlayStation 3. Comme annoncé, ce firmware supprime la possibilité de lancer un autre OS sur la console. La mise à jour étant obligatoire pour pouvoir continuer à profiter du PlayStation Network, voir de certains jeux à venir, ce firmware 3.21 était bien embêtant pour ceux qui utilisaient aussi leur PS3 comme ordinateur sous Linux...

Mais GeoHot à pensé à eux ! Ce petit génie s'était déjà illustré sur la scène du jailbreak de l'iPhone, mais aussi plus récemment en étant le premier à violer les protections de l'hyperviseur de la PS3. Il en remet aujourd'hui une couche en annonçant un firmware 3.21 "custom" pour la PS3, rétablissant la fonction "Other OS" supprimée par Sony.

Il redevient ainsi possible de profiter pleinement des fonctionnalités standard de la console, tout en installant un Linux à côté du système principale, ce qui permettra de continuer à profiter des applications non officielles conçues pour les PlayStation 3 sous Linux, et en particulier les lecteurs multimédia.

Le piratage des jeux reste par contre impossible pour l'instant. Une bonne nouvelle pour les éditeurs et pour Sony, qui ne devraient donc pas réagir de façon trop virulente au hack de GeoHot.

Posté par Matt le 07/04/2010 à 22h18

3 commentaires

Source : Generation NT

Lancé en 2001, via la gamme Itanium, l'architecture IA-64 était la première architecture 64 bits d'Intel. Initialement destinée aux serveurs et calculateurs, Intel prévoyait à l'époque d'étendre ensuite sa gamme IA-64 vers le grand public...

Mais la compatibilité réduite avec le code x86 des processeurs grand public, et le lancement par AMD d'une déclinaison 64 bits du x86 en 2003 ont eu raison de cette ambition, et l'Itanium a dès lors été confiné définitivement au marché professionnel. Mais même sur ce marché, l'Itanium peine à s'imposer, en partie à cause de son architecture très spécifique, nécessitant beaucoup de travail d'optimisation des logiciels, mais aussi en partie à cause de son coût élevé par rapport à des solutions dérivées des processeurs grand public, qui offrent généralement un rapport performances/prix bien plus intéressant.

Ainsi, l'Itanium perd petit à petit du terrain, en étant de moins en moins supporté par les éditeurs de logiciels et de moins en moins souvent intégrés dans les configurations des principaux constructeurs de serveurs. Aujourd'hui, Intel vient de perdre le support d'un partenaire de poids : Microsoft a annoncé que l'actuel Windows Server 2008 R2 serait son dernier système d'exploitation à supporter l'architecture IA-64.

Malgré l'arrivée prochaine des processeurs Itanium de nouvelle génération (nom de code Tukwila), l'avenir de cette architecture semble donc de plus en plus compromis.

Posté par Matt le 07/04/2010 à 08h21

Aucun commentaire

Source : Hardware.fr

Après avoir pas mal trainé pour intégrer la blogosphère, j'ai encore plus trainé à l'idée d'intégrer la "microblogosphère". Mais il faut savoir vivre avec son temps, surtout quand on fait un site sur l'actualité informatique... Les adeptes de Twitter seront donc ravis de retrouver Infobidouille sur leur plateforme de micro-blogging favorite.

Posté par Matt le 06/04/2010 à 22h07

3 commentaires

Lancé ce week-end aux États-Unis, l'iPad d'Apple aurait déjà fait plus de 300 000 heureux. Mais la tablette d'Apple a aussi déçu beaucoup de ceux qui l'attendaient, en raison de ses caractéristiques parfois assez limitées et de son OS très fermé, puisque dérivé de celui de l'iPhone. Pour ces déçus, la tablette Gemini d'ICD pourrait être le messie.

Dotée d'un écran 16/9ème de 11.2" (1366x768), cette tablette sous Android 2.1 est à peine plus volumineuse que l'iPad. Elle devrait par contre être bien plus puissante, grâce à l'utilisation de la plateforme nVidia Tegra 2, dotée de deux cœurs ARM Cortex A9 à 1 GHz (contre un seul Cortex A8 dans l'A4 d'Apple) et de 512 Mo de RAM (contre 256 Mo pour Apple). Embarquant, comme l'iPad, une connectique sans-fil Wi-Fi n, Bluetooth 2.1 et 3G, elle se distingue sur l'utilisation qu'elle peut faire de cette dernière : en plus de la connexion Internet, la tablette Gemini pourra exploiter le réseau cellulaire pour les appels vocaux, les SMS et les MMS. La visioconférence sera également possible, grâce à une caméra 2MP en façade, tandis qu'un second capteur 5MP doté d'un auto-focus s'occupera de prendre des photos.

Elle dispose bien entendu aussi d'un GPS, mais aussi d'un tuner FM et d'un slot SD, permettant d'étendre sa capacité de stockage, il est vrai un peu limitée par rapport à l'iPad, puisque la Gemini n'embarquera que 4 Go de flash. À propos de Flash, la Gemini sera capable d'afficher des pages web en contenant, contrairement à l'iPad, à qui le non support du Flash a souvent été reproché. Grâce à la puissance de la plateforme Tegra 2, la lecture de vidéo HD 1080p sera également possible, alors que l'iPad doit se contenter du 720p. Enfin, côté connectique, la Gemini offre un port micro-USB, qui pourra accepter des périphériques et un port infrarouge.

Reste à voir le prix, le poids et l'autonomie de la bête. Sur le dernier point, elle pourrait faire mieux que l'iPad, grâce à une batterie offrant 60% de capacité en plus (40 Wh), mais ceci risque de ce ressentir sur le poids.

Posté par Matt le 06/04/2010 à 22h02

2 commentaires

Source : Engadget

![]()

Freecom, le spécialiste allemand des supports de stockage externes vient de lancer un service qui pourrait en intéresser plus un, surtout après la publication de l'étude de l'Académie des Sciences sur la fiabilité des supports de stockage : une "assurance" récupération de données pour disque dur.

Le principe est simple : moyennant paiement de 29€95, le constructeur offre un service qui tentera de récupérer les données du disque dur en cas de panne pendant une période de trois ans. Il s'agit bien entendu d'une récupération en laboratoire, qui permet de récupérer bien plus de données qu'une récupération logicielle, et qui fonctionne même sur un disque dur fortement endommagé et qui n'est plus reconnu par l'ordinateur.

Ce genre de service est habituellement facturé plusieurs centaines d'euros par les entreprises spécialisées dans la récupération de données. En jouant sur la mutualisation et en pariant sur un taux de recours à la garantie suffisamment faible, Freecom offre donc un tarif particulièrement attractif, qui pourrait sauver à moindre coût ceux qui auraient oublié de faire des sauvegardes.

Cerise sur le gâteau, l'offre de Freecom est valable pour tous les modèles de disques durs, et non pas seulement ceux vendus sous sa propre marque.

Posté par Matt le 01/04/2010 à 22h32

5 commentaires

Source : Tom's Hardware

C'est indéniables, les systèmes Microsoft ont fait d'énormes progrès en termes de sécurité ces dernières années. Mais il reste toujours un problème important : le recours à des comptes utilisateurs disposant de droits administrateur. En effet, même avec l'UAC, ces comptes sont bien plus exposés que des comptes utilisateur classiques.

Si ce comportement est relativement logique, et concerne quasiment tous les systèmes existants, y compris Linux et Mac OS X, il affecte particulièrement Windows, qui proposent toujours un compte disposant des droits administrateur comme compte par défaut, alors que ses concurrents proposent (voir imposent...) depuis longtemps un compte utilisateur un peu plus restreint.

En analysant les vulnérabilités concernant les produits Microsoft en 2009 (environ 200 vulnérabilités), BeyondTrust, un éditeur de solutions de sécurité, a pu établir un bilan chiffré de l'impact des droits administrateurs sur la sécurité. Ainsi, dans 9 cas sur 10, les failles critiques touchant Windows 7 deviennent quasiment inoffensives si l'utilisateur ne dispose pas des droits administrateur. Sous Microsoft Office et Internet Explorer 8, on atteint même les 100% de failles atténuées par l'absence de droits administrateur. Globalement, sur l'ensemble des produits Microsoft, ce sont pas moins de 81% des failles critiques qui sont atténuées chez les utilisateurs limités, et 64% de l'ensemble des failles.

Malheureusement, l'héritage du passé étant ce qu'il est, de nombreux logiciels nécessitent encore des droits administrateur pour s'exécuter correctement. Mais conscient de ces problématiques de sécurité, Microsoft travaille avec les éditeurs pour rendre le recours à ces droits de moins en moins indispensable, ce qui devrait permettre de s'en passer d'ici quelques années. En attendant, il serait bon que Microsoft travaille sur un moyen un peu plus simple d'élever les privilèges en cas de besoin, à la façon de ce qui est fait sous Mac OS X ou Linux, ce qui permettrait de faciliter grandement la transition vers des comptes non administrateur.

Posté par Matt le 01/04/2010 à 10h57

Aucun commentaire

Source : Generation NT

Alors que l'HADOPI peine à se mettre en place, les internautes français n'auraient pas encore changé leurs habitudes de téléchargement. Au contraire même, certains auraient intensifié leur consommation de contenus illicites, par défiance envers la Haute Autorité... Mais la riposte s'organise, et elle risque de faire très mal !

En effet, une nouvelle entité serait à l'étude, pour éradiquer définitivement le problème du téléchargement illicite. Baptisée Autorité pour la Validation et la Régulation d'un Internet Légal, cette nouvelle autorité change radicalement de stratégie. En effet, plutôt que de s'attaquer aux fournisseurs de contenus, elle va instaurer des contrôles au niveau des tuyaux en partant d'un constat tout bête à la portée de n'importe quel adepte de la stratégie du moindre effort : pour rendre les offres légales plus attractives, il suffit de rendre les offres illicites moins attractives... Et pour ça, il existe un moyen tout simple : jouer sur les débits !

Sous le contrôle de cette nouvelle autorité, les FAI auront l'obligation de brider les débits de leurs abonnés en fonction de l'IP avec laquelle les échanges de données sont effectuées. Cette autorité publiera chaque mois trois listes d'IP correspondant à trois "zones" Internet, chacune bridée à une certaine vitesse :

- la zone 30 : elle comportera les IP identifiées comme hébergeant des sites susceptibles d'être visités par des mineurs. Afin de freiner la pédophilie, le débit sur ces sites sera limité à 30 Ko/s,

- les sites dont le contenu est contrôlé par les autorités locales ou par l'état (sites de communes, sites des ministères, presse...) : la vitesse y sera limité à 90 Ko/s,

- les sites de téléchargement légal : il s'agira des sites identifiés comme fournissant du contenu multimédia dans le respect des droits d'auteurs, soit sous forme gratuite, soit sous forme payante, facturée au Mo. Afin de favoriser les offres payantes, celles-ci ne seront limitées qu'à 130 Ko/s, contre 110 Ko/s pour les offres gratuites.

Un groupe d'artistes expatriés en Suisse et représenté par notre Johnny national négocierait également la mise en place d'un palier intermédiaire entre les sites de téléchargement gratuits et les sites payants, en proposant une offre particulièrement compétitive : le téléchargement à 120 Ko/s moyennant un forfait annuel facturé moins de 30€ !

Par défaut, les IP n'appartenant à aucune de ces zones seront limités à 50 Ko/s. Ainsi, télécharger illégalement un MP3 sera 2.6 fois plus long que de le télécharger sur un site payant, ce qui devrait convaincre certains utilisateurs de rentrer dans le droit chemin.

La nouvelle autorité va également profiter d'une autre leçon tiré d'HADOPI : afin d'éviter la grogne des opérateurs en raison des coûts élevés qu'impliqueraient la mise en place de telles limitations sur l'ensemble du réseau, ces limitations de débit ne s'appliqueront pas par bridage, mais sur la base de la bonne volonté de l'utilisateur. Les opérateurs pourront donc toujours vendre des offres allant bien au delà des vitesses autorisées, les utilisateurs pourront toujours atteindre ses vitesses... mais il pourront à tout moment être contrôlés via des systèmes automatisés !

En cas de dépassement avéré du débit autorisé, l'utilisateur sera puni d'une amende et de 1 à 6 mails d'avertissement, en fonction de la gravité de l'infraction (le titulaire de l'abonnement pourra toutefois contester les avertissements en indiquant l'identité de la personne qui utilisait sa connexion au moment de l'infraction). Au 12ème mail d'avertissement, il sera demandé au titulaire de ne plus se servir de sa connexion, et il s'exposera à de lourdes poursuites s'il ne respecte pas cette sanction, pouvant aller jusqu'à la saisie de son modem. Une dérogation pourra être obtenue sous condition, pour les personnes ayant impérativement besoin de leur accès Internet pour leur travail.

Reste à voir si ces nouvelles mesures seront plus efficaces que les précédentes... Il se pourrait que non, puisque le site Die Piratebahn aurait déjà annoncé avoir trouvé une faille dans le système de contrôle, et affirme être en mesure de proposer du téléchargement gratuit avec un débit illimité vers toutes les IP allemandes. Si Die Piratebahn tient ses promesse, cette nouvelle mesure risque donc une fois de plus de pénaliser les utilisateurs honnêtes en dégradant leur confort d'utilisation, tout en laissant passer les pirates entre les mailles du filets...