Actualités du mois de juin 2010

Si vous suivez l'actualité du matériel, vous avez forcément entendu parler des problèmes de condensateurs de faible qualité qui ont causé des pannes sur de nombreux composants informatiques, et qui ont fait qu'encore aujourd'hui, certains constructeurs utilisent comme argument marketing le fait de baser leur matériel sur des condensateurs à électrolyte solide, bien plus résistants. Aujourd'hui, cette affaire revient sur le devant de la scène, et c'est Dell qui en fait les frais...

En effet, le New York Times a mis la main sur des documents cités dans le cadre d'un procès intenté à Dell par un de ses clients professionnels, avec à la clé des révélations particulièrement mauvaises pour l'image du constructeur texan. En effet, entre mai 2003 et juillet 2005, le constructeur aurait écoulé dans sa gamme OptiPlex (PC de bureau pour entreprises) près de 12 millions d'ordinateurs équipés de ces tristement fameux condensateurs. Ceci ne serait pas forcément un problème si, comme d'autres constructeurs, le texan avait géré proprement la situation, en offrant prolongation de garantie, échange hors garantie, etc...

Mais non seulement, Dell n'a rien fait, ce qui lui a valu ce procès, mais en plus les documents obtenus par le New York Times prouvent que le constructeur a continué à commercialiser les machines défectueuses alors qu'il était parfaitement conscient de l'existence du problème. Une étude menée en interne chez Dell avait en effet révélé que 97% des machines en question risquaient de tomber en panne en moins de trois ans.

Voilà donc une information qui risque de faire beaucoup de mal à Dell, tant financièrement avec l'indemnisation des clients lésés qu'en termes d'image, beaucoup risquant de ne plus faire confiance à Dell après une telle affaire.

Posté par Matt le 30/06/2010 à 22h47

Aucun commentaire

Source : Generation NT

![]()

Annoncé il y a trois mois, lors de l'annonce des résultats financiers d'Iliad, le service de catch-up TV (permettant de revoir en différé les programmes télévisés) de Free vient d'être lancé sous le nom de TVReplay, et est en cours de déploiement auprès des abonnés.

Accessible gratuitement depuis la Freebox HD (sous réserve bien sûr d'avoir accès aux chaînes concernées, certaines n'étant pas incluses dans l'offre de base de Free), ce service permet dès à présent l'accès différé aux programmes de 22 chaînes (M6, Arte, W9, Gulli, NRJ 12, Game One, NT1, France 24, LCP, RTL9, AB1, AB Moteurs, Odyssé, Motors TV, Escales, Chasse et pêche, Toute l'histoire, Encyclopedia, Animaux, Boing Boomerang et TCM), qui seront complétées par 11 autres dès le mois d'août (BFM, Euronews, France 2, France 3, France 4, France 5, France ô, NRJ Paris, TV5, MCM et Mangas).

Absente de cette liste, bien qu'annoncée présente en mars dernier, TF1 devrait arriver plus tard, avec les mêmes contenus que sur le service MyTF1, disponible sur le site de la chaîne.

Posté par Matt le 29/06/2010 à 22h46

Aucun commentaire

Source : Macbidouille

Alors que les industriels de la musique et du cinéma ne cessent de mettre tous leurs maux sur le dos des pirates, une étude américaine vient casser leurs beaux arguments. Réalisé par deux chercheurs, dont l'un issu de la prestigieuse université de Harvard, cette étude démontre notamment que le piratage n'est pas la principale cause de la baisse des ventes.

Ainsi, en ayant compilé les résultats de plusieurs études datant de ces dernières années, les deux chercheurs ont estimé que le piratage ne serait responsable que de 20% de la baisse des ventes. Le plus gros responsable de la baisse des ventes de musique enregistrée serait en fait la hausse de la vente de places de concerts. Ainsi, entre 1997 et 2007, alors que les ventes de musique ont diminué de 15%, la somme des ventes de musique et de place de concerts a pour sa part augmenté de 5%.

Second argument mis à mal : le piratage nuit à la création. Sur ce point, les résultats de l'étude sont encore plus flagrants. En effet, malgré la hausse indéniable du piratage, l'étude révèle que de 2002 à 2007 le nombre annuel de nouveaux livres publiés à augmenté de 66%, que le nombre d'albums sortis par an a doublé depuis 2000, et que le nombre annuel de films produits a augmenté de 30% depuis 2003.

Pendant ce temps là, du côté de la France, la solution répressive incarnée par HADOPI se met petit à petit en place. On en a d'ailleurs appris un peu plus sur le fonctionnement de Trident Media Guard, la société en charge du "flashage" des mauvais internautes sur les réseaux P2P. Pour ce faire, l'entreprise utilisera une liste de 200 films et 10 000 musiques représentatifs des échanges (grands classiques, nouveautés...), afin de tenter de repérer un maximum de personnes. La surveillance sera limitée aux réseaux P2P, et ne ciblera dans un premier temps que les gros consommateurs : les internautes seront mis sous surveillance à partir de 50 fichiers échangés par jour, et l'artillerie sera déclenchée à partir de 500. À partir de 1000, l'internaute s'exposera à des poursuites pénales.

Enfin, on notera une annonce assez surprenante de la SACEM, qui laisse augurer des effets indésirables pour le consommateur en cas de succès de l'HADOPI : une hausse de la redevance copie privée. Pour rappel, cette redevance est destinée à compenser le manque à gagner dû au droit à la copie privée (donc des copies légales), et les ayants-droits s'étaient d'ailleurs déjà fait taper sur les doigts pour avoir inclus le piratage dans leurs estimations. Alors, pourquoi une hausse en cas de succès d'HADOPI ? Tout simplement parce que les ayants-droits font un raisonnement on ne peut plus simpliste : le succès d'HADOPI va engendrer une baisse des échanges illicites, donc une hausse des échanges licites... Par ailleurs, pour compenser le manque à gagner dû aux échanges illicites, une taxe sur les abonnements Internet reste à l'étude (mais baissera-t-elle en cas de succès d'HADOPI ?). Qui a dit "vaches à lait" ?

Posté par Matt le 28/06/2010 à 22h49

Aucun commentaire

Sources : PCInpact, Tom's Guide, et encore PCInpact

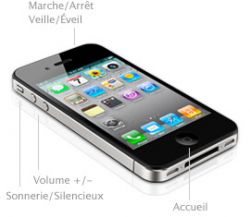

C'est aujourd'hui qu'Apple a lancé son iPhone 4, nouveau fer de lance de sa gamme de smartphone. Plus performant, plus fin, plus autonome... il surpasse son prédécesseur sur tous les points.

Les premières estimations font d'ailleurs état d'un succès sans précédent, avec plus de 600 000 unités pré-commandés dès la première journée, et probablement des difficultés pour en obtenir un pendant les semaines à venir, comme pour l'iPad. Mais aussi réussi soit-il, l'appareil n'est pas exempt de défaut, et quelques problèmes de jeunesse ont déjà été découverts...

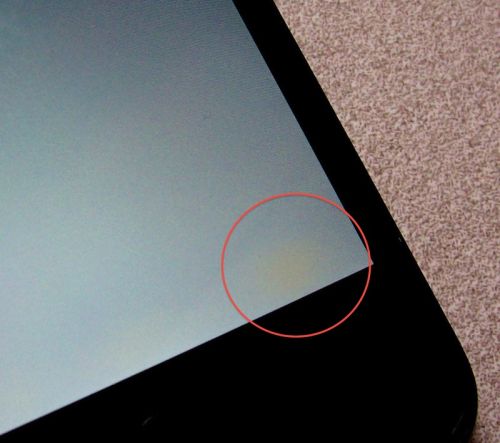

Commençons par le moins grave : sur certains exemplaires, des tâches jaunes apparaissent sur l'écran. Selon certains, il s'agirait simplement de la colle, qui n'aurait pas encore complètement séché, et le problème disparaitrait donc de lui même au bout de quelques jours. Dans le cas contraire, il s'agit là clairement d'un défaut de fabrication, qui semble pour l'instant assez minoritaire, et Apple ne devrait pas rechigner à échanger les iPhone affectés. Le second problème est par contre beaucoup plus gênant...

Souvenez vous : dans les présentations de l'iPhone 4, Apple expliquait fièrement que les pièces métalliques constituant le cadre de l'iPhone 4 jouaient le rôle d'antennes. Une solution censée permettre de réaliser un téléphone à châssis métallique sans que le châssis ne perturbe la qualité du signal. Hélas, l'iPhone semble souffrir d'un défaut de conception à ce niveau : si on met en contact certaines parties de ce cadre métallique (la partie inférieure et la partie gauche), la réception réseau chute fortement, allant parfois jusqu'à la perte totale du réseau. Et comme une main est conductrice, il suffit en fait de tenir l'iPhone de la main gauche pour mettre le défaut en évidence. Voici par exemple le résultat que j'ai observé, en jouant simplement sur la position de la main :

L'iPhone est donc le premier smartphone permettant à son utilisateur de simuler aisément un passage sous un tunnel. Selon certains, il s'agirait toutefois d'un problème purement logiciel, l'iPhone n'interprétant pas correctement la variation de signal provoquée par le contact de la main, ce qui l'induirait en erreur et le conduirait à sous-estimer le niveau de réception.

Pour la petit anecdote, on notera également que l'application Horloge est désormais pré-configurée avec les heures de Paris, Lyon et Marseille... qui sont bien entendu les mêmes :-)

Posté par Matt le 24/06/2010 à 23h57

Aucun commentaire

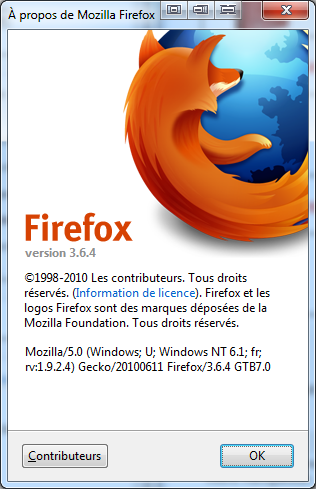

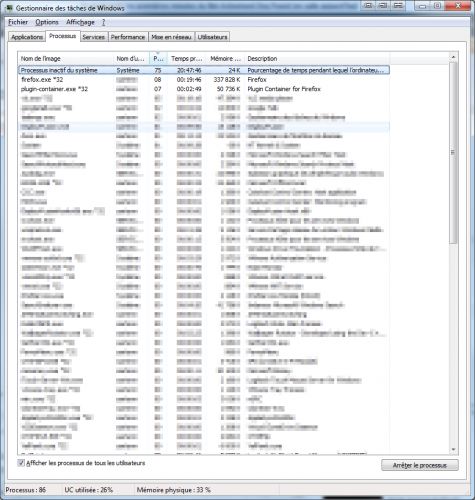

Introduit avec Google Chrome, puis Internet Explorer, le concept de navigateur multi-processus permet une meilleur isolation entre les différents éléments du navigateur, évitant ainsi de planter toute la session de navigation en cas d'erreur en un endroit. Après de longs mois de gestation, les prémices de ce mode de fonctionnement sont enfin arrivés dans Firefox, avec la version 3.6.4 du panda roux.

L'approche choisie par Mozilla est toutefois pour l'instant moins poussée que celle de Google. En effet, alors que dans Chrome, "tout est processus", chaque onglet, chaque plug-in et chaque extension ayant son propre processus, Firefox 3.6.4 se contente pour l'instant d'un processus général, contenant tous les onglets et les extensions, et d'un processus par plug-in utilisé (par exemple, un processus pour le plug-in Flash, un pour le plug-in Silverlight, etc...). Bien entendu, ce n'est qu'un début, et Mozilla va petit à petit étendre cette gestion multi-processus, pour isoler les extensions et les onglets.

Mais l'isolation des plug-ins est déjà un grand pas en avant, ceux-ci étant les plus gros responsables de plantages de navigateurs (je sais pas pour vous, mais de mon côté, j'ai particulièrement une dent contre le plug-in PDF d'Adobe, qui m'a causé un nombre incalculable de plantages, à tel point que j'avais fini par le désactiver...). Désormais, dans une telle situation, le navigateur se contentera de griser la section de la page contrôlée par le plug-in et d'afficher un message invitant l'utilisateur à recharger la page.

Ce message indiquant de plus le nom du plug-in concerné, il pourrait pousser les auteurs de ces plug-ins à faire quelques efforts pour stabiliser leur produit...

Posté par Matt le 23/06/2010 à 23h13

Aucun commentaire

Source : n'1formatik

Une montre qui fait téléphone, ça n'a rien d'exceptionnel, il s'agit d'un gadget classique, même s'il est encore peu répandu. Mais il existe tout de même quelques modèles assez exceptionnels, vu le niveau de miniaturisation atteint...

C'est le cas de la montre Q8, vendue un peu moins de 130$ en Chine. En effet, non contente de faire office de téléphone quad band, elle embarque deux slots SIM, permettant donc de gérer deux lignes en simultané, un écran tactile couleur de 1.33", un clavier numérique, une puce Bluetooth 2.0, un vibreur, et même un capteur 2MP capable de réaliser des photos et des vidéos.

Et malgré sa petite taille, induisant forcément une batterie minimaliste, elle affiche 5h d'autonomie en communication et 300h en veille. Bon par contre, c'est moche, probablement pas très ergonomique, et le visionnage de vidéos sur l'écran timbre poste ne doit pas être des plus confortables...

À quand une reprise du concept par Apple pour une iWatch ?

Posté par Matt le 23/06/2010 à 00h20

2 commentaires

Source : PCWorld

VLC, le lecteur multimédia libre fruit du travail du projet VideoLAN, vient de passer en version 1.1.0, avec quelques améliorations intéressantes à la clé, puisque cette nouvelle version supporte désormais l'accélération matérielle par le GPU.

Sous Windows, cette accélération est effectuée via l'API DxVA2, disponible dans Vista et 7, tandis que sous Linux, c'est l'API VAAPI qui effectuera ce travail. Dans les deux cas, l'accélération matérielle prend en charge les flux H.264, VC-1 (utilisé par certains disques Blu-Ray) et MPEG-2. De nouveaux codecs sont également supportés, et en particulier le VP8/WebM de Google, tant en encodage qu'en décodage.

Cette nouvelle versions promet également d'importants gains de performances, surtout en lecture HD, grâce à des décodeurs plus rapides, la réécriture partielle du moteur de rendu vidéo et à un gros travail d'optimisation du code, notamment en supprimant le code mort et en ajoutant des optimisations SSE3 et SSE4.

Une mauvaise nouvelle toutefois, le décodage accéléré par le GPU sous Windows ne fonctionne pour l'instant correctement qu'avec les GPU nVidia, en attendant qu'ATI daigne mettre à jour ses drivers.

VLC 1.1.0 est disponible en téléchargement sur le site du projet VideoLAN.

Posté par Matt le 22/06/2010 à 23h16

Aucun commentaire

Source : VideoLAN via Ptit_boeuf

Pour le geek linuxien, adepte de vi, de lynx et autres applications qui peuplent couramment les xterm, les applications web qui obligent à passer par le clicodrôme ne sont pas la panacée. Mais elles sont quand même bien utiles pour partager des choses avec le reste de la population. Heureusement, Google à pensé à eux !

En effet, le Google vient de lancer sur sa plateforme Google Code un nouveau projet : GoogleCL. CL, comme Command Line. Ce projet vise à fournir des interfaces en ligne de commande pour les principaux services de Google. Pour l'instant, les services supportés sont Picasa Web, Blogger, YouTube, Docs, Contacts et Calendar, ce qui est déjà un bon début.

Réalisé en Python, cette interface en ligne de commande est proposée "clés en main" aux linuxiens sous forme de paquets Debian, mais il est aussi possible de les installer sur des systèmes utilisant d'autres gestionnaires de paquets, mais aussi sous Windows, en suivant la procédure décrite sur le blog public int.

Voilà qui devrait ravir tous les adeptes des lignes de commandes, et devrait rapidement donner naissance à des collections de scripts s'appuyant sur ces commandes pour réaliser des choses de plus en plus complexes en un minimum de commandes :-)

Posté par Matt le 22/06/2010 à 10h41

Aucun commentaire

Source : Generation NT

Présenté il y a déjà un bon bout de temps, le service OnLive promettait de rendre accessible les jeux récents aux petites configuration, pour peu qu'elles soient dotées d'une bonne connexion Internet. Le principe ? Surfer sur la mode du "cloud computing", en exploitant cette technique pour faire tourner les jeux au sein d'une ferme de serveur, et renvoyer l'image au client, qui peut donc se contenter d'une machine de faible puissance.

À l'époque, j'avoue avoir été plutôt sceptique à propos de ce système, et le fait de ne plus en avoir entendu parler depuis me confortait dans mon idée. Mais OnLive m'a finalement donné tort, puisque le service a été lancé aux États-Unis la semaine dernière, avec pour l'instant une grosse dizaine de jeux au catalogue : Assassin's Creed 2, Batman : Arkham Asylum, Borderlands, Colin McRae : DiRT 2, Dragon Age Origins, Just Cause 2, Lego Harry Potter, Mass Effect 2, NBA 2K10, Prince Of Persia et Tom Clancy's Splinter Cell : Conviction. D'autres devraient rapidement arriver.

Côté tarif, il en coûtera 14$95 d'abonnement mensuel, auxquels il faudra ajouter entre 4 et 10$ de droit d'accès pour chaque jeu. Ce droit d'accès ne sera valable que tant que l'abonnement OnLive sera maintenu. Impossible donc de couper l'abonnement pendant un mois et de le reprendre plus tard : les droits d'accès et les sauvegardes seront irrémédiablement perdus. Voilà qui risque de faire perdre en partie l'argument financier de la plateforme...

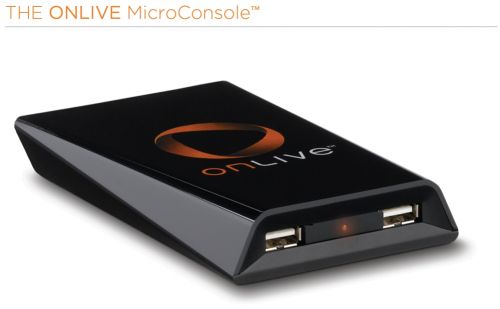

Le service fonctionne pour l'instant sur PC et Mac, mais devrait bientôt également être proposé sur TV via un petit boîtier baptisé MicroConsole, de la taille d'un disque dur externe 2.5". Réservé aux États-Unis, il devrait débarquer en Belgique et en Angleterre l'année prochaine. Aucune information n'a été communiquée sur une sortie en France.

Histoire de faire un peu de buzz, OnLive a également fait une démonstration de son service sur iPad, grâce à une application qui devrait prochainement être disponible :

Posté par Matt le 21/06/2010 à 23h54

Aucun commentaire

Source : Tom's Guide

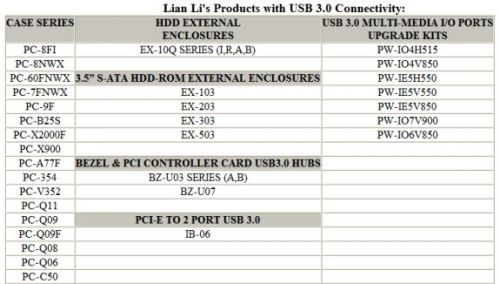

Lancé il y a quelques mois, l'USB 3.0 n'est pas sans poser de problème pour les connectiques en façade, puisqu'il existe des lignes supplémentaires au niveau du connecteur, empêchant donc les boîtiers proposant de l'USB 2.0 d'être compatibles avec la nouvelle norme USB. Chez Lian Li, ce sont toutefois pas moins de 17 modèles qui ont déjà été mis à jour pour supporter l'USB 3.0.

Le constructeur taïwanais spécialisé dans les boîtier haut de gamme se devait en effet de prendre en compte rapidement cette nouvelle norme dans sa gamme, vu son positionnement sur le marché. La liste de boîtiers supportant l'USB 3.0 couvre quasiment toute la gamme Lian Li, du petit mini-PC Q08 aux imposants boîtiers serveurs de la gamme A70, en passant par les moyennes tours et les boîtiers un peu plus "exotiques".

Par la même occasion, le constructeur annonce une grosse douzaine d'accessoires compatibles USB 3.0, notamment des boîtiers externes pouvant accueillir un ou plusieurs disques durs, mais aussi des cartes USB 3.0 au format PCI-Express, afin de pouvoir profiter de cette nouvelle connectique sans changement de carte mère.

Posté par Matt le 17/06/2010 à 23h24

Aucun commentaire

Source : DarkVision Hardware via Ptit_boeuf

Alors que Trident Media Group, la société en charge de la collecte des adresses IP dans le cadre de l'HADOPI, a obtenu il y a quelques jours le feu vert de la CNIL pour démarrer son activité, la ministre allemande de la justice, Sabine Leutheusser-Schnarrenberger a tenu lundi un discours sur le drois d'auteur où elle critique fortement les choix de la France.

Tout d'abord, la ministre a appuyé sur un point souvent reproché au majors, mais qui a été totalement ignoré lors des débats sur l'HADOPI : l'inadéquation du modèle commercial de la musique au monde actuel. Ce modèle commercial est en effet un vestige du passé, totalement inadapté à l'ère numérique. La ministre n'hésite pas d'ailleurs à dire que "leurs temps est écoulé", et que ce n'est pas à l'état de "créer un hôpital pour ces business models".

Allant jusqu'à citer Linus Torvalds, Sabine Leutheusser a ensuite expliqué pourquoi l'Allemagne n'allait pas s'orienter vers des solutions à la française, notre pays s'étant selon elle orienté vers "un mauvais chemin", notamment parce que la coupure de l'accès à Internet "constituerait une sévère interférence avec la liberté de communication". Pour elle, l'Allemagne devrait se limiter aux mails d'avertissement, qui prendraient "un effet éducatif", tandis que les FAI et ceux qui financent (essentiellement par le biais de la publicité) les sites dédiés au piratage devraient prendre leur part de responsabilité et œuvrer pour faire évoluer les choses en cessant de soutenir les activités illicites.

Enfin, la ministre allemande plaide pour une meilleure harmonisation des législation sur le droit d'auteur au sein de l'Union Européenne, et en particulier, une remise à plat des modes de fonctionnement des sociétés de gestion des droits d'auteur (SACEM en France). Espérons que son appel soit entendu, et que cette harmonisation ne se fasse pas sur le modèle répressif choisi par la France.

Posté par Matt le 16/06/2010 à 22h35

2 commentaires

Source : PCInpact

![]()

Le défaut le plus souvent reproché aux SSD est la durée de vie limitée de la mémoire flash, qui ne tolère qu'un certain nombre de cycles effacement-écriture, de l'ordre de 10 000 pour la MLC, ce qui oblige à réaliser des contrôleurs complexes pour répartir au mieux l'usure, au détriment des performances, qui ont du coup tendance à se dégrader avec le temps. Nouveau sur le marché des contrôleurs SSD, Anobit annonce une technologie permettant d'augmenter grandement ce nombre de cycles.

En effet, sur ses premiers SSD, les Genesis, le fabricant annonce pouvoir atteindre les 50 000 cycles sur de la mémoire MLC, grâce à sa technologie Memory Signal Processing. Une technologie dont le nom laisse entendre qu'elle s'attaque au traitement du signal électrique renvoyé par les puces mémoire, sans doute pour améliorer les capacités de distinction entre les différents niveau de signal, pour mieux distinguer les valeurs contenues dans les cellules.

Mieux, en appliquant cette technologie aux MLC 3BPC (stockant 3 bits par cellule, soit une densité accrue de 50%, au détriment de la durée de vie), le constructeur estime atteindre la même durée de vie que de la MLC classique. Cette technologie devrait donc permettre de réduire sensiblement le prix des SSD sans dégrader la durée de vie, ou d'améliorer la durée de vie à prix égale.

Côté performances, ce contrôleur serait dans la bonne moyenne, mais sans rivaliser avec les ténors du marché. Anobit annonce en effet 220 Mo/s en lecture séquentielle et 180 Mo/s en écriture séquentielles, avec 30 000 IOPS en lecture aléatoire et 20 000 IOPS en écriture aléatoire. Le Genesis sera proposé en versions 200 et 400 Go, mais le prix et la date de commercialisation n'ont pas encore été communiqués.

Posté par Matt le 16/06/2010 à 10h17

Aucun commentaire

Source : Hardware.fr

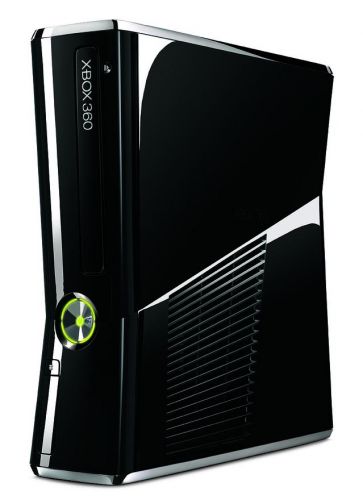

Après la Playstation 3 l'été dernier, c'est au tour de la console phare de Microsoft d'avoir droit à une nouvelle révision plus compacte, présentée par son fabricant au salon E3 2010, et disponible dès maintenant aux États-Unis et dans un mois en Europe.

Pas complètement "slim", cette nouvelle version semble en fait avoir une épaisseur proche de celle de l'originale, mais elle est un peu moins haute, et gagne en équipement, avec un disque dur de 250 Go (au lieu de 120 Go) et le Wi-Fi intégré de série (en 802.11n), et non plus en option. Elle sera commercialisée à 299$ aux USA, et devrait être proposée à 299€. Contrairement à ce qu'avait fait Sony avec le lancement de la PS3 Slim, les anciens modèles de la console Microsoft resteront pour l'instant au catalogue, avec une réduction de 50$, ce qui place la Xbox 360 Arcade à un tarif particulièrement agressif, à peine 150$ (mais rappelons qu'elle ne possède pas de disque dur, ce qui empêche donc d'installer les jeux).

En plus de la réduction de volume, la nouvelle version change assez nettement de design, avec une finition noire laquée, qui contraste fortement avec le blanc cassé mat de la version actuelle. Dommage que l'énorme bouton d'allumage reste éclairé de vert, un éclairage bleu aurait été plus adapté au niveau design. On notera également que le disque dur prend désormais place dans une baie accessible par l'arrière de la console, et non plus posée sur le dessus.

Au passage, Microsoft a également dévoilé un nouvel accessoire, le Kintec, qui n'est autre que le système de caméras qui était connu jusqu'à présent sous le nom de Natal. Ce système vise à proposer une nouvelle expérience de jeu, en permettant un contrôle "main-libres", les caméras analysant les mouvements du corps pour en déduire les actions à réaliser dans le jeu. La nouvelle version de la console disposera d'ailleurs d'un port dédié à la connexion de cet accessoire, assez gourmand en énergie (il comporte plusieurs caméra), et qui condamne donc les deux ports USB sur la version classique de la console.

Posté par Matt le 15/06/2010 à 23h50

Aucun commentaire

Source : Tom's Guide

Ce matin, l'Apple Store en ligne d'Apple était fermé, signe de l'arrivée de nouveaux produits au catalogue de la boutique virtuelle de la pomme. Vu la date, il ne faisait aucun doute que la raison de la fermeture était le lancement des pré-commandes de l'iPhone 4. Mais Apple nous a aussi réservé une mise à jour inattendue...

En effet, alors qu'aucune rumeur ne l'annonçait, le Mac Mini a été renouvelé. Une mise à jour d'autant plus surprenante que le Mini avait déjà été rafraichi deux fois en 2009, après plus de deux ans sans mise à jour. De plus, alors que le plus petit des Mac n'avait pas changé de design depuis son lancement, début 2005, il dispose désormais d'un look un peu plus en accord avec le reste de la gamme Apple : fini le capot en plastique blanc, voici venu le temps du châssis Unibody taillé d'une pièce dans un bloc d'aluminium. Avec au passage un important gain de compacité, puisque la machine passe à seulement 3.6cm d'épaisseur, au lieu de 5.1cm, mais avec un léger élargissement (19.7cm au lieu de 6.5cm). Toujours pour plus de compacité, le bloc d'alimentation est désormais interne.

À l'intérieur, on retrouve grosso modo la configuration du Macbook, avec un processeur Core 2 Duo 2.4 GHz (2.66 GHz en option), 2 Go de RAM (extensible à 8 Go via une large trappe située sous la machine), une puce graphique nVidia GeForce 320M (256 Mo de mémoire partagée) et un disque dur de 320 Go (500 Go en option). Les communications se font en Wi-Fi 802.11n, Bluetooth 2.1 + EDR ou Ethernet Gigabit. En face arrière, on retrouve par contre une connectique plus riche que sur le Macbook, avec un port RJ-45, un FireWire 800, quatre USB 2.0, un slot SD, un mini-DisplayPort, une entrée et une sortie audio jack numérique et analogique, et surtout, un port HDMI, ce qui est une grande première sur un ordinateur Apple. Le Mac Mini semble donc s'orienter vers un usage media center... Malheureusement, il faudra toujours se contenter du SuperDrive lecteur/enregistreur de DVD, alors qu'un lecteur Blu-ray aurait été fort appréciable pour un tel usage.

Sur le papier, ce nouveau Mac Mini a donc tout pour plaire, avec son design discret et sa configuration matérielle certes un peu dépassée, mais largement plus puissante que celle des nettops de dimensions équivalentes. Hélas, le prix risque de dissuader plus d'un acheteur, surtout en Europe... En effet, aux États-Unis, Apple a décidé de revoir le prix à la hausse de 100$, en le passant à 699$, mais les aléas des taux de change ont pour conséquence une hausse de 250€ en Europe, avec un ticket d'entrée affichant désormais 799€... Face à des nettops proposés moitié moins chers chez la concurrence, le Mac Mini risque donc d'avoir du mal à trouver son public.

Posté par Matt le 15/06/2010 à 22h16

Aucun commentaire

Alors que la course au GHz est révolue dans le domaine des processeurs depuis qu'Intel a lancé le Core 2 Duo, et travaille depuis sur l'amélioration du ratio performances/consommation, Motorola pourrait bien relancer la course aux GHz dans le domaine des smartphones...

En effet, alors que la génération "600 MHz" commence à doucement être poussée vers la sortie, au profit de la nouvelle génération "1 GHz" (Motorola Droid, Nexus One, HTC EVO 4G et HTC HD2 avec leur Qualcomm Snapdragon, iPhone 4 avec son A4...), Motorola a annoncé qu'il lancera en fin d'année un smartphone moulinant à 2 GHz.

Basé sur la plateforme nVidia Tegra (qui embarque un double cœur ARM Cortex A9), l'appareil disposera d'un gyroscope (nouveauté introduite sur l'iPhone 4), d'un APN au moins 5MP et pourra enregistrer la vidéo en HD. Il supportera le Flash en embarquant le player en version 10.1, ce qui fera plaisir à ceux qui ne pardonnent pas Apple pour l'absence de Flash sur l'iPhone. Côté système, il proposera soit Android 2.2, soit Android 2.3, selon l'état d'avancement du système de Google lorsque Motorola commercialisera l'appareil.

Reste à voir s'il s'agira réellement d'une fréquence de 2 GHz (on peut imaginer que le constructeur nous propose un "2 GHz" marketing, sur la base de deux cœurs à 1 GHz...) et s'il ne faudra pas faire trop de sacrifices sur l'autonomie. La réponse en fin d'année !

Posté par Matt le 14/06/2010 à 23h31

Aucun commentaire

Source : PCInpact

Alors que les serveurs sont souvent équipés de processeurs sur-puissants, issus des gammes Opteron d'AMD et Xeon d'Intel, il serait dans de nombreux cas préférable de disposer d'un plus grand nombre de processeurs moins puissants, plus adaptés au traitement de nombreuses petites tâches parallélisées. Pour ce faire, certains lorgnent du côté des processeurs ARM, tandis que d'autres, comme Seamicro, s'orientent vers l'Atom d'Intel.

Prenant place dans un rack 19" 10U, le serveur SM10000 est un véritable monstre, atteignant une densité de processeurs peu commune. Embarquant 64 cartes mères, chacune porteuse de 8 puces Atom Z530 à 1.6 GHz, il atteint en effet 512 processeurs, soit un peu plus de 50 par unité. Les 64 cartes mères sont interconnectées via un bus à 1.28 Tbits/s, partagé également avec 8 cartes de stockage, supportant chacune jusqu'à 8 disques et 8 cartes réseau.

L'accès au ressources de stockage et aux ressources réseau est entièrement virtualisé via des contrôleurs conçus par Seamicro, tandis que les processeurs des cartes réseau sont capables d'analyser la charge de chaque CPU pour équilibrer la répartition des requêtes, chaque machine virtuelle piochant ainsi dans les 512 processeurs en fonction de ses besoins et de ceux des autres machines virtuelles.

Selon le constructeur, sa solution, particulièrement adaptée aux serveurs web et au cloud computing, permettrait de diviser la consommation par quatre à performances égales.

Posté par Matt le 14/06/2010 à 23h14

Aucun commentaire

Source : Tom's Hardware

Il y a quelques jours nous apprenions que le département de la justice américain enquêtait sur certaines nouvelles clauses de la licence du SDK iPhone, qu'Apple utiliserait pour entraver la concurrence en interdisant aux développeurs l'utilisation de certains langages, dont le Flash. Une seconde enquête aurait été ouverte suite à une nouvelle mise à jour de cette licences, contenant des clauses douteuses au niveau de la publicité intégrée aux applications...

En effet, jusqu'à présent, les développeurs désireux de financer leurs applications par la publicité pouvaient faire à peu près ce qu'ils voulaient. Mais Apple va lancer en juillet sa propre régie publicitaire destinée aux applications iOS (iAd), et de nouvelles clauses sont donc apparues dans le contrat de licence, avec clairement pour intention de favoriser iAd. En effet, désormais les applications ne seront plus autorisées à collecter et transmettre à un tiers (par exemple une régie publicitaire) des informations sur l'utilisateur et sur l'appareil sans l'accord de l'utilisateur, et même avec cet accord, elle ne pourront le faire que pour les régies non affiliées à un autre constructeur de téléphone mobiles ou un développeur d'OS mobile. Ce qui exclue par exemple les régies publicitaires de Google ou de Microsoft, alors que le premier est le leader de la publicité en ligne...

Au premier abord, ces clauses pourraient sembler être dans l'intérêt de l'utilisateur, en protégeant mieux sa bie privée. Mais la plateforme iAd étant intégrée directement au cœur du système iOS, cette régie aura pour sa part bien accès à toutes les informations qu'Apple aura envie de collecter. Ainsi, iAd pourra disposer d'un avantage artificiel sur les régies concurrentes, en disposant d'informations permettant un ciblage bien plus fin des publicités, gage d'une rentabilité accrue.

C'est ce point qui gêne les autorités de régulations, qui jugent probablement à raison qu'il y a là une forme de concurrence déloyale, ce qui n'est probablement pas dans l'intérêt du consommateur, qui est souvent le premier à payer les conséquences d'un manque de concurrence.

Posté par Matt le 10/06/2010 à 23h40

2 commentaires

Source : Macbidouille

Depuis le lancement du premier Eee PC, début 2008, Asus a toujours été fidèle à Intel pour motoriser ses netbooks, d'abord avec des processeurs Celeron, puis avec les Atom, une gamme taillée sur mesure pour les netbooks suite au succès des premiers Eee PC. Avec son Eee PC 1201K, Asus va commettre sa première adultère, en se fournissant du côté d'AMD...

En effet, au lieu des habituels Atom, cette machine embarquera une puce AMD Geode NX1750 à 1.4 GHz, accompagnée d'1 Go de mémoire DDR (non, il ne manque ni un 2, ni un 3...), de 160 à 320 Go de disque dur, d'un écran 12.1" LED 1366x768 surmonté d'une webcam 1.3MP, le tout sous Windows XP Home et alimenté par une batterie 6 cellules.

Malheureusement pour AMD, le choix d'une puce de Sunnyvale n'est pas un signe du retour d'AMD dans le domaines des puces basses consommation, mais sans doute plutôt une volonté d'Asus de proposer une machine à prix cassé (mais non communiqué pour l'instant). En effet, le Geode NX1750 n'est pas vraiment une nouveauté, puisqu'il s'agit en fait simplement d'une déclinaison basse consommation des Athlon K7 socket A qui faisaient la gloire d'AMD au début des années 2000 ! D'où la DDR... Autre signe flagrant de cette orientation low cost, même le Wi-Fi est en option sur cette machine !

Pire, malgré son grand âge, qui aurait pu permettre à AMD d'avoir le temps d'optimiser la consommation, le Geode 1.4 GHz n'est pas un processeur particulièrement sobre, avec 14W de TDP, le double d'un Atom. Et la bonne vieille DDR n'aidera pas non plus, celle-ci étant plus gourmande que les mémoires modernes. Asus n'annonce d'ailleurs que 2h d'autonomie, alors que des Eee PC Atom dotés d'une batterie équivalente se situent généralement entre 5 et 10h...

Posté par Matt le 10/06/2010 à 23h14

Aucun commentaire

Source : Tom's Hardware

Il y a quelques jours, Intel a lancé les Core i7 875K et Core i5 675K, deux processeurs ayant pour particularité d'avoir un coefficient multiplicateur débloqué pour un overclocking facilité, ce que le constructeur réservait jusqu'à présent aux très onéreuses versions "Extreme" de ses processeurs. Ces processeurs étant uniquement vendus sans système de refroidissement, le fondeur vient de lancer un radiateur vendu seul, une première pour Intel.

Baptisé Intel Thermal Solution XTS100H, ce radiateur reprend le design en tour du radiateur des Core i7 980X, mais en version "miniature", puisqu'il se contente de trois caloducs au lieu de quatre, et offre une surface totale de dissipation légèrement inférieure. D'une hauteur de 13cm, il est couplé à un ventilateur de 92mm pouvant fonctionner entre 800 et 2600 RPM, avec un niveau de bruit allant de 17 à 45 dB.

La bestiole est vendue au Japon pour environ 52€, ce qui risque de la rendre bien peu compétitive, la concurrence proposant à ce prix là des solutions très performantes, probablement mieux adaptées aux prétentions des Core i*K.

Posté par Matt le 09/06/2010 à 22h14

Aucun commentaire

Source : PCWorld

À l'occasion du Computex, le constructeur de SSD PhotoFast, peu connu par chez nous mais très présent sur le marché asiatique a créé la sensation, en dévoilant pas moins de sept futurs SSD, tous compatibles SATA 6 Gbits/s, et affichant des performances plutôt alléchantes. Dans le lot, six contrôleurs inédits.

Le premier est le nouveau contrôleur Indilinx dont nous vous parlions la semaine dernière. Il sera finalement baptisé Thunderbolt, et affichera des débits de 400 Mo/s en lecture et 300 Mo/s en écriture, avec des premiers exemplaires fonctionnels à partir du mois prochain.

Le second est le Jetstream, du même constructeur, dont la date de disponibilité n'est pas encore révélée, et qui offrira 100 Mo/s de plus, tant en lecture qu'en écriture. Entre les deux, on trouve la prochaine puce JMicron (1er trimestre 2011), le JMF66x, qui offrira 450 Mo/s en lecture et 350 Mo/s en écriture.

La palme revient à SandForce, avec le Phoenix (4ème trimestre 2010), qui offrira un débit symétrique de 520 Mo/s, proche des limites du SATA 6 Gbits. Deux nouveaux constructeurs vont faire leur apparition : Siglead, avec son Spring (500 Mo/s en lecture et 450 Mo/s en écriture, dès le 3ème trimestre 2010), puis EastWho, avec le EWS900 (500 Mo/s, 250 Mo/s, 2ème trimestre 2011).

Enfin, le septième modèle présenté par Photofast s'appuiera sur le contrôleur Marvell qu'on trouve déjà dans le RealSSD C300 de Micron, qui n'offre "que" 335 Mo/s en lecture et 215 Mo/s en écriture.

Sur le marché des SSD, les années 2010 et 2011 s'annoncent donc aussi agitées que l'année 2009... Espérons que les prix vont enfin passer nettement à la baisse, mais ceci dépendra plus de la baisse des cours de la mémoire flash que d'une guerre des prix entre fabricants de contrôleurs.

Posté par Matt le 08/06/2010 à 23h43

Aucun commentaire

Source : Hardware.fr

Orange UK a présenté en partenariat avec GotWind un nouvel accessoire plutôt original pour les téléphones portables : les Power Wellies. Il s'agit d'un appareil permettant de recharger un téléphone portable et prenant la forme... d'une paire de bottes en caoutchouc !

Pour ce faire, les semelles de ces bottes sont équipées d'un dispositif à effet Seebeck. Cet effet est en quelque sorte l'effet inverse de l'effet Peletier, bien connu des overclockeurs : il permet de générer de l'électricité à partir d'une différence de température. Ici, c'est la différence entre le dessous de la semelle et le pied qui est exploitée.

Les performances laissent toutefois encore à désirer, puisqu'il faudra porter les bottes une douzaine d'heures pour obtenir une heure de charge. Et ne parlons pas de l'esthétique fort discutables de ces bottes...

Posté par Matt le 08/06/2010 à 23h00

1 commentaire

Source : PCWorld

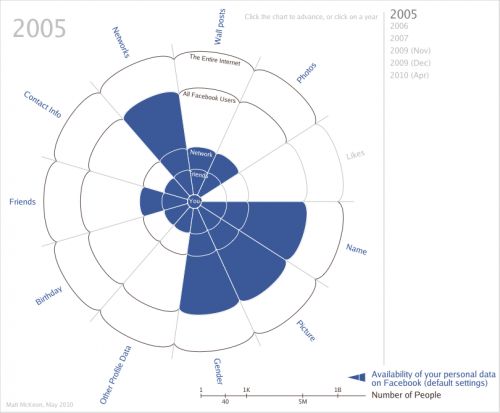

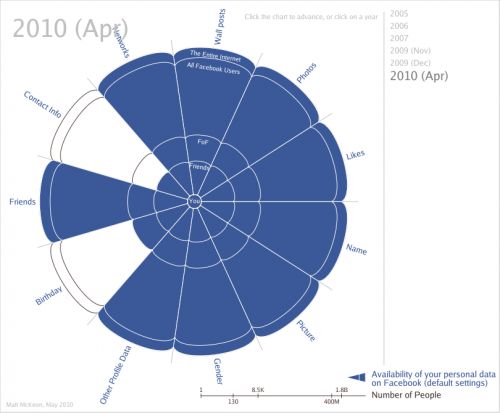

La question de la protection de la vie privée se pose aujourd'hui de plus en plus sur Internet. Parmi les plus pointés du doigts dans ce domaine, on retrouve bien sûr les moteurs de recherche, qui indexent tout ce qui leur passe sous la main, mais aussi Facebook, qui incite ses utilisateurs à étaler leur vie privée sur Internet...

Face aux attaques de plus en plus fréquentes, le réseau social communique de plus en plus souvent sur le sujet, et introduit régulièrement de nouvelles options permettant de contrôler de façon plus fine la diffusion des informations postées par les membres. En apparence donc, on pourrait penser que les choses progressent... En apparence seulement...

En effet, Kurt Opsahl, membre de l'Electronic Frontier Foundation (une ONG qui lutte notamment pour la liberté sur Internet et contre les brevets logiciels), a eu l'idée de relever les évolutions des réglages de confidentialité par défaut de Facebook au fil du temps. Évolution qui a ensuite été mise en image par Matt McKeon, pour que la chose saute mieux au yeux : alors qu'au début, en configuration par défaut, la plupart des informations étaient réservées aux amis et membres du même réseau, tandis qu'aucune information n'était rendue accessible à tout Internet, ce sont aujourd'hui quasiment toutes les données qui sont librement accessible à tout internaute, les deux seules exceptions étant vos coordonnées (réservées aux amis) et votre date de naissance (réservée aux amis et à leurs amis).

Si vous êtes utilisateurs de Facebook et que vous vous inquiétez de la diffusion de vos informations, un petit tour dans les options s'impose pour aller vérifier qui a accès à vos informations. Vous pouvez aussi utiliser le service Reclaim Privacy, qui va scanner vos paramètres et vous aider à renforcer la confidentialité.

Posté par Matt le 08/06/2010 à 00h02

Aucun commentaire

Sources : Matt McKeon via Technofeliz

La WWDC (World Wide Developer Conference) d'Apple s'est ouverte aujourd'hui avec la traditionnelle keynote présentée par Steve Jobs. Comme les rumeurs et l'affiche de l'événement le laissaient supposer, la principale nouvelle de cette keynote est l'officialisation de l'iPhone 4, le prochain téléphone de la pomme.

Sans surprise, le design est identique à celui du prototype qui avait été révélé il y a quelques mois par Gizmodo. Un design qui se démarque assez nettement du précédent, avec une forme plus anguleuse et une épaisseur réduite d'un quart.

Une seconde caméra fait son apparition en façade, pour permettre les conversations vidéo, tandis que la caméra arrière hérite désormais d'un flash LED. Embarquant un processeur Apple A4 et un écran très haute résolution (960x640), l'iPhone 4 sera décliné en noir et en blanc, dans des capacités de 16 et 32 Go.

Il sera commercialisé à partir du 24 juin, avec des pré-commandes à partir du 15 juin. L'iPhone 3G disparait du catalogue, tout comme les iPhone 3GS actuels, qui sont remplacés par un unique modèle 3GS 8 Go, qui constituera la nouvelle entrée de gamme.

L'OS 4.0 sera pour sa part disponible dès le 21 juin pour les iPhone et iPod Touch actuels (à l'exception de l'iPhone V1 et du Touch 1G).

- Présentation de l'iPhone 4,

- Spécifications de l'iPhone 4,

- Nouveautés d'iOS 4 (certaines de ces nouveautés seront réservées aux appareils les plus récents)

Posté par Matt le 07/06/2010 à 23h15

Aucun commentaire

Source : Macbidouille

![]()

Il y a quelques temps, Lucid Logic créait la surprise avec sa puce Hydra, qui permet de faire fonctionner ensembles une carte graphique ATI Radeon et une carte graphique nVidia GeForce. Alors qu'elle n'était proposée pour l'instant que sur quelques cartes mères, Powercolor a eu l'idée originale de l'intégrer directement sur une carte graphique...

Ainsi, le constructeur s'apprête à lancer un Radelon HD 5770 embarquant une puce Hydra, ce qui lui permettra de fonctionner avec une GeForce sur n'importe quelle carte mère. Un bon moyen de donner un petit coup de fouet à une configuration existante sans changer la carte mère et en gardant l'ancienne carte graphique.

Avant d'investir, il faudra toutefois surveiller l'efficacité de la solution. En effet, la puce Hydra ne donne pas toujours des résultats satisfaisants, et les performances sont très sensibles à la qualité des drivers. Drivers qui semblent justement poser quelques difficultés à Powercolor, qui a présenté la carte tout en indiquant qu'elle ne sera pas immédiatement disponible à cause des drivers qui ne sont pas finalisés...

Posté par Matt le 04/06/2010 à 10h38

Aucun commentaire

Source : Tom's Hardware

![]()

Spécialiste de la vente évènementielle sur Internet, le site Vente-Privée propose en ce moment une offre particulièrement alléchante, en partenariat avec Free : un abonnement bradé à -66% !

En effet, jusqu'au vendredi 4 juin à minuit, le site propose à ses membres des abonnements à Free qui seront facturés seulement 10€ par mois pendant la première année, avant de repasser à 29€99. Cette offre fera donc économiser environ 240€ au souscripteurs.

Il s'agit bien entendu d'un abonnement complet, comprenant tous les services de l'abonnement Free classique, et ouvert à toutes les personnes non abonnées à Free et éligibles Free ADSL, aussi bien en zone dégroupée qu'en zone non dégroupée.

Posté par Matt le 03/06/2010 à 22h15

Aucun commentaire

Source : Génération NT

En raison de problèmes financiers, l'équipe en charge de X-Setup Pro a annoncé sur son site que le logiciel ne sera désormais plus maintenu. La version 9.2.100, lancée il y a un peu plus d'un an, sera donc la dernière.

Une triste nouvelle que j'accueille forcément avec un peu de nostalgie. Vous ne le savez peut-être pas, mais sans X-Setup, Infobidouille n'existerait peut-être pas. C'est en effet après avoir découvert ce logiciel et m'être lancé dans sa traduction en français que j'ai lancé mon premier site Internet, il y a bientôt dix ans, pour diffuser la version française. C'est en réalisant ce site que j'ai appris petit à petit les langages qui sont au cœur d'Infobidouille : PHP, HTML, CSS, SQL... Cinq ans plus tard, ce site allait laisser progressivement sa place à Infobidouille, après que j'ai arrêté le travail de traduction, par manque de temps et de motivation.

La dernière version de X-Setup Pro reste disponible au téléchargement sur Major Geeks ou encore Beta News, et, puisque le développement est abandonné, ses auteurs ont décidé de rendre public un numéro de licence valide, permettant d'utiliser le logiciel au delà de ses 30 jours de période d'évaluation : XSA092-11TA9R-8K12YT

Posté par Matt le 03/06/2010 à 21h07

Aucun commentaire

Source : n1fo

Après avoir fait plus d'une fois les titres de l'actualité à cause de son activité principale plutôt sulfureuse, la recherche de fichiers sur le réseau P2P BitTorrent, The Pirate Bay se lance dans une activité un peu plus légale, mais assez surprenante : les rencontres !

Les créateur du site viennent en effet de lancer le site Pirate Date qui, comme son non l'indique, vise à vous aider à trouver l'âme sœur. Pour ce faire, le site s'appuiera tout simplement sur la base de données de Facebook, pour trouver les âmes esseulées parmi les relations de vos relations, et en exploitant le réseau social pour trouver les atomes crochus.

Reste à voir si un jour The Pirate Bay poussera l'idée un peu plus loin, en proposant par exemple de mettre en relation les personnes effectuant le même genre de recherches sur le réseau BitTorrent...

Posté par Matt le 02/06/2010 à 22h58

Aucun commentaire

Source : Tom's Guide

![]()

Star du début de l'année 2009, le contrôleur Indilinx Barefoot accuse déjà le poids de l'âge, en étant aujourd'hui assez nettement surpassé par les contrôleurs de nouvelle génération. Son successeur, le Jetstream, n'étant pas prévu avant un an, Indilinx se devait de rendre son Barefoot un peu plus compétitif...

En effet, après une excellente année 2009 durant laquelle Indilinx a atteint 60% de part de marché, le constructeur a intérêt à ne pas trop se reposer sur ses lauriers s'il veut capitaliser sur ce succès. Ainsi, le Sud-Coréen pourrait lancer avant le Jetstream un Barefoot 2, version amélioré du premier du nom. La principale différence serait le passage de 4 canaux mémoire à 8 (alors que le Jetstream en comptera 16), ce qui devrait se traduire par des débits nettement améliorés dans toutes les situations.

Ce contrôleur, qui pourrait éventuellement exploiter une interface SATA 6 Gbits/s devrait arriver avant Noël.

Posté par Matt le 02/06/2010 à 22h25

Aucun commentaire

Source : Hardware.fr

Après les disques durs hybrides, dont Seagate tente de relancer le principe, qui avait déjà été lancé par Samsung il y a quelques années, sans réel succès, Hitachi se la joue original avec l'HyDrive, un périphérique hybride intégrant lecteur optique et de la mémoire flash.

Mais contrairement au système utilisé sur les disques durs hybrides, la mémoire flash ne sert pas ici de cache, mais constitue bien un support de stockage indépendant, d'une capacité de 32 ou 64 Go et débitant 175 Mo/s. La partie optique est pour sa part un lecteur blu-ray, doublé d'un graveur de DVD. Hitachi n'a pas communiqué sur le contrôleur utilisé pour la partie SSD, mais l'une des vidéo de présentation montre qu'il tient la route, au moins en lecture :

L'intérêt d'un tel système est bien entendu son encombrement réduit par rapport à un SSD classique couplé à un lecteur optique. Il devient ainsi possible de monter dans un portable standard un lecteur optique, un SSD et un disque dur, ou encore de réaliser des portables plus compacts, dotés uniquement d'une baie 5.25" slim.

Si vous êtes intéressé par l'HyDrive, renseignez vous tout de même au préalable sur sa compatibilité avec votre portable : le périphérique utilise un multiplicateur de port SATA pour pouvoir exposer deux unités de stockage sur un même canal SATA, ce qui n'est pas forcément compatible avec tous les contrôleurs SATA.

L'HyDrive devrait être commercialisé au mois d'août prochain, tandis que des modèles de plus grande capacité (jusqu'à 256 Go) sont prévus pour le printemps 2011.

Posté par Matt le 01/06/2010 à 23h37

Aucun commentaire

Source : PCMag via Ptit_boeuf

![]()

Après ses SSD PCI-Express Z-Drive, qui utilisaient des contrôleurs Indilinx Barefoot en RAID0, OCZ s'apprête à lancer les RevoDrive, des SSD PCI-Express qui exploiteront le contrôleur phare du moment, le SF-1200 de SandForce.

Au format PCI-Express 4x, les RevoDrive embarqueront au moins deux contrôleurs SF-1200 et un contrôleur RAID, configuré en mode RAID0, mais le constructeur semble avoir prévu de pouvoir en mettre un plus grand nombre.

Côté prix, OCZ semble être disposé à offrir ces nouveaux SSD à un tarif un peu moins élitiste que les Z-Drive, puisqu'il a annoncé un surcoût de seulement 10 à 20% par rapport à des SSD SATA de même capacité (rappelons tout de même qu'en version SATA, les SSD à base de contrôleurs SandForce sont déjà plus chers que la moyenne).

Malheureusement, si les performances seront sans doute améliorés par le montage RAID, leur dégradation au fil du temps risque d'être plus élevée, puisque le TRIM ne sera pas supporté.