Actualités du mois de juillet 2010

![]()

Encore quasiment inconnu du grand public il y a cinq ans, le taiwanais HTC profite aujourd'hui d'une place de choix parmi les constructeurs de téléphones haut de gamme, en grande partie grâce à la popularité de ses smartphones Android. Mais le constructeur ne compte pas s'arrêter en si bon chemin !

En effet, alors qu'il vient de battre son record trimestriel de vente au second trimestre 2010, avec 5.4 millions d'appareils vendus (alors qu'il n'en a vendu que 5.9 millions sur l'année 2008 complète !), HTC vise désormais les 6.5 millions d'appareils pour le trimestre en cours. C'est sans doute pour pouvoir atteindre de telles volumes que le constructeur a renoncé aux écrans AMOLED sur une partie de sa gamme, au profit de dalles Super LCD, d'approvisionnement plus facile.

Si le taiwanais tient ses objectifs et continue de faire croitre ses ventes à ce rythme, il pourrait même bientôt reprendre à Apple la place de troisième constructeur de smartphones, que la pomme occupe actuellement, juste derrière Nokia et RIM (BlackBerry).

Posté par Matt le 30/07/2010 à 22h16

Aucun commentaire

Source : Génération NT

![]()

Après avoir lancé fin 2008 le Blackberry Storm, son premier téléphone entièrement tactile, pour tenter de surfer sur le succès de l'iPhone, RIM va-t-il tenter de profiter de la popularité de l'iPad pour lancer une tablette tactile ?

C'est en effet la rumeur qui court depuis quelques semaines, et qui vient d'être fortement renforcé par RIM : alors que la rumeur évoquait le nom de BlackPad pour la tablette canadienne, le constructeur a justement enregistré début juillet le nom de domaine blackpad.com, confirmant ainsi indirectement son intérêt pour ce nom. Et avec un tel nom, difficile d'envisager autre chose qu'une tablette tactile.

Selon les rumeurs, celle-ci serait dotée d'un écran de 7" et embarquerait un processeur ARM, des contrôleurs Wi-Fi et Bluetooth... Bref, une configuration désormais classique pour une tablette tactile. Le BlackPad devrait toutefois se distinguer des autres tablettes par son OS, puisqu'il sera très probablement doté d'un OS maison adapté de RIM OS.

Posté par Matt le 30/07/2010 à 10h00

Aucun commentaire

Source : Clubic

Depuis le lancement de l'iPad, les annonces de tablette concurrentes se succèdent, même si on en trouve encore peu sur le marché. Bon nombre d'entre elles fonctionneront avec le système Android, comme l'E-Noa que vient d'annoncer le constructeur allemand Interpad.

Annoncée pour le mois de décembre, cette tablette est basée sur la plateforme nVidia Tegra T20, qui embarque un processeur ARM Cortex A9 double-cœur à 1 GHz. Dotée d'un écran 10" capacitif multi-touch, d'1 Go de RAM et de 16 Go de stockage flash, elle saura décoder les codecs MPEG2, MPEG4, H.264, H.263 et VC-1 en full HD.

L'OS d'origine sera Android 2.1, mais la tablette pourra être mise à jour vers Android 2.2. Côté connectivité, elle surpasse largement sa concurrente pommée : USB 2.0, HDMI, écouteurs, Wi-Fi, Bluetooth... La batterie offrira pour sa part une capacité de 3900 mAh sous 7.4V, ce qui devrait permettre une autonomie de 8 à 12h. Une autonomie atteinte sans trop sacrifier l'encombrement, puisque cette tablette ne fera que 12.5 mm d'épaisseur et 660g (pour 25.3cm de large et 16.4 de haut).

Elle devrait être vendue environ 400€, tandis qu'un modèle un peu plus évolué, intégrant la 3G, une webcam et un GPS devrait être commercialisé pour 100€ de plus.

Posté par Matt le 29/07/2010 à 11h00

Aucun commentaire

Source : Le Journal du Geek

![]()

Il y a quelques mois, nous vous parlions de la probable adoption d'un processeur Atom dans la Live Box, le modem ADLS multi-play d'Orange. La prochaine version de la Freebox pourrait avoir droit au même traitement dans quelques semaines.

En effet, le FAI devrait profiter de sa conférence de presse du 31 août prochain pour annoncer le lancement de la Freebox de 6ème génération. Au lieu de l'actuel processeur MIPS 255 MHz, cette nouvelle version devrait être basée sur une plateforem Atom CE4100, identique à celle prévue par Orange pour sa Live Box et par Google pour les Google TV.

Cette plateforme est en fait un system on a chip (SoC) bâti autour d'un processeur Atom 1.2 GHz, d'une puce graphique GMA500 (basée sur le PowerVR SGX535), de deux décodeurs H.264 1080p, d'un contrôleur audio, d'un contrôleur Gigabit Ethernet, d'un contrôleur SATA, d'un contrôleur SDHC, et, bien entendu, d'un contrôleur USB 2.0.

Cette plateforme devrait offrir des performances très supérieures à celles de la plateforme utilisée actuellement, qui s'essouffle vite dans les jeux vidéos, voir avec certains contenus full HD. La plateforme Atom étant plutôt sobre, on peut également espérer une consommation à la baisse, même si Free ne fait pas parti des opérateurs qui se sont engagés à réduire la consommation de leurs box. Ce ne serait pas du luxe, le boîtier HD de la Freebox 5 étant régulièrement pointé du doigt, car figurant parmi les plus gourmands en veille.

Posté par Matt le 28/07/2010 à 22h38

Aucun commentaire

Source : Tom's Hardware

Comme pour essayer de faire oublier l'"antennagate", Apple vient de lancer de nouveaux modèles de Mac Pro, réclamés depuis fort longtemps par la communauté, mais aussi de nouveaux iMac, et quelques accessoires.

Côté ordinateurs, les changements restent toutefois relativement modestes. Les nouveaux Mac Pro, qui ne seront disponibles que le mois prochains, se distinguent essentiellement par l'adoption de processeurs à 6 cœurs et de nouvelles cartes graphiques, dont le Radeon HD 5870. Des SSD sont désormais proposés en option, le reste de la machine restant inchangé.

Côté iMac, les modèles Core 2 Duo disparaissent aux profits de Core i3 et ce Core i5 double-cœur, tandis que le haut de gamme reste basé sur des Core i5 et Core i7 à quatre cœurs, proposés uniquement sur le modèle 27". L'affichage est confié à des Radeon HD 4670 ou 5670 sur les 21.5" et 5670 ou 5750 sur les 27". Ces derniers pourront également, en option, accueillir un SSD en plus de leur disque dur.

Côté accessoires, Apple s'apprête à lancer un moniteur LED Cinema Display de 27", reprenant la dalle des iMac.

On notera aussi l'arrivée d'un accessoire plutôt original : le Magic Trackpad, qui reprend la technologie multi-touch des trackpad de Macbook Pro, mais dans une version destinée aux machines de bureau.

Enfin, plus anecdotique, Apple a lancé un chargeur de piles AA, destiné principalement aux utilisateurs du clavier sans-fil Apple et du Magic Trackpad, qui utilisent chacun deux piles AA.

Posté par Matt le 27/07/2010 à 21h31

Aucun commentaire

Source : Macbidouille

![]()

Sur ses smartphones haut de gamme, le taïwanais HTC a pris l'habitude d'opter pour des écrans AMOLED, offrant un taux de contraste plus élevé et des angles de vision plus larges que les écrans LCD classiques. Ces dalles AMOLED sont par contre d'approvisionnement difficile...

Ainsi, HTC a annoncé que ses modèles les plus demandés (Desire et Nexus One), normalement dotés d'écrans AMOLED 3.7" vont désormais être dotés de dalles Super LCD de chez Sony, afin que la capacité de production d'HTC ne soit pas limitée par la disponibilité des dalles AMOLED.

Selon le constructeur, les dalles Super LCD offrent d'excellents angles de vision et des couleurs plus naturelles que les dalles AMOLED, donc les consommateurs ne devraient pas y perdre. L'autonomie progresserait même légèrement.

Les modèles dotés de dalles Super LCD devraient commencer à être livré à la fin de l'été. Les appareils dotés d'écrans plus petits, comme par exemple les HTC Legend et HTC Wildfire, équipés en 3.2" ne sont pour l'instant pas concernés, et resteront en AMOLED.

Posté par Matt le 27/07/2010 à 10h30

Aucun commentaire

Source : Generation NT

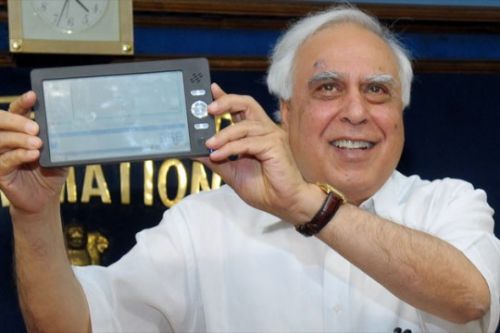

Après l'ordinateur portable pour écoliers à 100$ du projet OLPC, l'Inde s'apprête à commercialiser un appareil qui ciblera les étudiants, à un tarif particulièrement attirant : seulement 35$ !

Pour ce prix, les étudiants indiens auront droit à une tablette tactile, qui a été présentée officiellement pas le ministre indien des Ressources Humaines. Fonctionnant sous Linux et dotée d'un écran 7" (800x480), elle est animée par un processeur Freescale i.MX233, un processeur d'application utilisant une architecteure ARM9 à 454 MHz, combinée à un contrôleur pour écran LCD, une puce audio avec sortie numérique et analogique, un contrôleur pour carte SD, etc... Le stockage s'effectuera sur l'espace interne de 2 Go, tandis que la connectivité sera assurée par une puce Wi-Fi et un port USB.

La configuration n'est donc pas des plus musclées par rapport aux tablettes concurrentes, mais le tarif est par contre particulièrement agressif. On peut d'ailleurs se demander si, pour atteindre un prix aussi faible, la tablette ne serait pas en partie subventionnée par l'état.

Posté par Matt le 26/07/2010 à 22h48

Aucun commentaire

Source : Le Journal du Geek

Depuis quelques temps, les box Internet sons régulièrement critiquées pour leur forte consommation électrique. En effet, la plupart ne disposent pas d'un mode veille sur le boîtier Internet, et certaines n'ont même pas de vraie veille sur leur boitier TV, ce qui engendre une consommation électrique permanente...

Ainsi, il est estimé que les box du parc français consomment en moyenne 10W. Une valeure qui peut sembler faible dans l'absolu, mais multipliée par le nombre de box en activité en France, on atteint une consommation annuelle de 1.6 TWh, soit environ 20% de la production annuelle d'un petit réacteur nucléaire. La Fédération Française des Télécoms, qui réunit les principaux opérateurs, se sont donc engagés à faire évoluer cette consommation moyenne à la baisse.

Pour ce faire, de nouvelles box devraient être proposées en cours d'année, avec un bouton d'arrêt sur le boîtier TV, dont les versions actuelles consomment parfois 10W même lorsqu'elles ne sont pas allumées. Du côté des boîtiers ADSL, les opérateurs vont travailler sur des fonctionnalités de mise en veille lorsque la connexion Internet est peu utilisé. Il n'est par contre pas question d'une extinction totale de ce boîtier, puisque son extinction s'accompagnerait de la coupure de la ligne téléphonique associée à la box.

Avec ces mesures, les opérateurs espèrent n'atteindre que 2.5 TWh de consommation pour l'ensemble du parc en 2020, avec un parc qui devrait atteindre les 50 millions d'appareils, soit une consommation moyenne quasiment divisée par deux, puisqu'elle passerait sous la barre des 6W.

Posté par Matt le 24/07/2010 à 10h13

1 commentaire

Source : Génération NT

Après que Mozilla puis Google ont annoncé une nette augmentation des primes offertes pour la découvertes de failles dans leurs navigateurs, on pouvait s'attendre à des mesures similaires du côté de la concurrence. Ça ne sera pas le cas chez Microsoft.

En effet, pour Jerry Bryant, chargé de superviser la sécurité des produits Microsoft, "une récompense basée sur les failles [n'est pas] la mailleure manière de procéder". En effet, pour lui "les motivations des chercheurs ne sont pas toujours financières", certains recherchant plutôt une reconnaissance par leur milieu, qu'il peuvent obtenir par une citation dans les bulletins de sécurité de l'éditeur.

Il souligne toutefois que Microsoft reste préoccupé par la sécurité, mais privilégie une autre approche : la firme embauche des chercheurs pour travailler à plein temps sur la sécurité de ses produits, et rémunère également des chercheurs pour tester les produits avant leur lancement.

Dommage tout de même de ne pas offrir de prime de résultat à ceux qui découvriraient une faille, d'autant plus que certains spécialistes réputés ont renoncé depuis plusieurs mois à offrir les failles gratuitement. Il est vrai que dans ces conditions, il faut faire preuve d'une sacré motivation pour révéler une faille à l'éditeur, alors qu'il est possible de toucher des dizaines de milliers de dollars en donnant la faille au côté obscure...

Posté par Matt le 23/07/2010 à 23h50

Aucun commentaire

Source : PCInpact

Après Mozilla il y a quelques jours, c'est aujourd'hui au tour de Google d'augmenter le montant maximum de la prime offerte en cas de découverte d'une faille dans son navigateur Google Chrome.

Lancé il y a six mois, le programme de rémunération des découvreurs de faille offrait jusqu'à présent une prime allant de 500 à 1337$, en fonction des caractéristiques de la faille trouvée. La prime minimale reste inchangée, mais le plafond est désormais porté à 3133.7$, un montant similaire à celui que propose désormais Mozilla.

Pour Google, cette augmentation se justifie en fait par le niveau de sécurité élevé offert par son navigateur. En effet, officiellement, le mécanisme de "sandbox de Chrome rend les failles critiques beaucoup plus difficiles à trouve", ce qui justifierait donc une rémunération sensiblement supérieure. Bien entendu, cette annonce survenant quelques jours seulement après celle de Mozilla laisse plutôt entrevoir d'autres motivations, dont on ne va pas se plaindre : ne pas se faire distancer par Firefox sur la plan de la sécurité.

Posté par Matt le 22/07/2010 à 22h38

Aucun commentaire

Source : Clubic

Après avoir réussi à décrocher une place au parlement européen, après avoir remporté 7.1% des voix en Suède, le Parti Pirate va se diversifier dans son pays d'origine en devenant FAI, sous le nom de PirateISP.

Avec des tarifs allant de 243.75 à 525 couronnes suédoises (soit 26 à 55 de nos euros), le FAI va proposer huit offres différentes allant du 10/10 Mbits/s au 1000/1000 Mbits/s (sont bien équipés les suédois...). La plateforme technique sera fournie par ViaEuropa, qui s'était déjà illustré en gérant iPredator, la solution VPN proposée par le sulfureux The Pirate Bay.

Bien entendu, PirateISP met l'accent sur la protection de la vie privée de ses clients, notamment en s'engageant à ne conserveur aucun log. Le Parti Pirate compte également faire jouer son immunité politique pour contourner la loi FRA. Cette loi autorise l'armée suédoise à surveiller toutes les données traversant les frontières du pays via Internet. Le Parti Pirate avait déjà utilisé cette immunité pour proposer de prendre en charge l'hébergement The Pirate Bay, en installant carrément ses serveurs au sein du parlement suédois.

Si l'engagement pour le respect de la vie privée est louable, il ne faut toutefois pas se leurrer, les personnes intéressées par un tel FAI le seront surtout pour d'autres raisons beaucoup moins louables... On peut d'ailleurs regretter qu'un tel anonymat risque aussi de faciliter la tâche de véritables criminels. En cas de succès de PirateISP, espérons donc que les autorités réagiront en proposant des alternatives viables pour les téléchargeurs compulsifs, afin qu'un Internet excessivement anonymisé ne se développe pas en parallèle d'un Internet excessivement contrôlé...

Posté par Matt le 21/07/2010 à 11h20

Aucun commentaire

Source : PCWorld

![]()

Avec leurs énormes écrans tactiles couvrant quasiment toute leur face avant, les smartphones modernes ont souvent un gros point faible : la fragilité de l'écran en question, qui peut voler en éclats en cas de choc ou de chute. Un point faible sur lequel Samsung travaille activement.

En effet, Samung Mobile Display, une division du Coréen spécialisée dans les petits écrans pour téléphones ou baladeurs, travaille actuellement sur des écrans AMOLED basés sur une dalle en plastique souple, ce qui leur confère une excellente résistance aux chocs, puisque même un coup de marteau n'arrive pas à en venir à bout :

Reste à voir si Samsung sera aussi en mesure de rendre la dalle tactile aussi résistante, pour pouvoir faire des smartphones à l'écran indestructible. Il faudra bien entendu aussi que cette nouvelle technique de fabrication atteigne un coût raisonnable, ce qui devrait être le cas dans deux ans, lorsque Samsung lancera ces écrans commercialement.

Posté par Matt le 21/07/2010 à 09h20

Aucun commentaire

Source : Tom's Hardware

On n'a pas trop l'habitude d'entendre parler de Dell dans le milieu du logiciel, mais de temps en temps ça arrive. Et c'est le cas avec Secure Browser, un navigateur récemment mis à disposition par Kace, une filiale de Dell. Sous ce nom se cache en fait une version "sécurisée" de Firefox.

Basé sur la version 3.6 du panda roux, Secure Browser est en fait un Firefox qui s'exécute dans une sandbox, permettant de l'isoler du reste du système. Ainsi, si Firefox venait à être corrompu par un site malveillant exploitant une faille de sécurité, le code malicieux ne pourra pas s'attaquer au reste du système, puisqu'il restera confiné dans la sandbox. Ceci permet de ramener Firefox au niveau de Chrome, qui intègre nativement un système de sandbox. Secure Browser peut être téléchargé gratuitement sur le site de Kace. Malheureusement, cette version ne fonctionne pour l'instant que sur les systèmes Windows 32 bits. Espérons que Kace donnera des idées à Mozilla pour intégrer nativement ce genre de choses à Firefox.

On notera d'ailleurs que Mozilla a décider de s'attaquer un peu plus sérieusement aux problèmes de sécurité, Firefox étant de plus en plus surpassé par Chrome et Opera dans ce domaine. Ainsi, alors que la fondation offrait depuis six ans une prime de 500$ pour tout personne découvrant un nouveau trou de sécurité, elle a décidé de porter ce montant à 3000$, afin de motiver les spécialistes de la sécurité.

Pour toucher la prime, la faille découverte devra toutefois répondre à certaines conditions : être considérée comme critique ou importante, toucher les versions récentes de Firefox, Firefox Mobile ou Thunderbird et être exploitable à distance.

Posté par Matt le 20/07/2010 à 18h21

Aucun commentaire

Sources : Clubic et PCWorld

S'il y a un point sur lequel la puce Fermi qui équipe les GeForce GTX 480 est imbattable, c'est bien sur le plan de la consommation électrique. À tel point que, alors que depuis plusieurs générations, AMD et nVidia proposent tous les deux un haut de gamme bi-GPU, pas grand monde n'envisageait la possibilité de faire une carte bi-GPU à base de GTX 480. Mais chez Asus, ils n'ont pas froid aux yeux...

Ainsi, après sa série limitée Mars, lancée l'année dernière, qui était la seule carte embarquant deux GTX 285, revendiquant alors le titre de carte graphique la plus puissante du monde, le taïwanais travaillerait sur une carte Mars II encore plus ambitieuse, embarquant deux GTX 480 sur un même PCB, qui du coup prend des proportions impressionnantes...

Le système de refroidissement, pas encore vu en photo, devrait être tout aussi impressionnant, vu l'énorme quantité de chaleur à dissiper. L'alimentation de ce monstre se fera via trois connecteurs d'alimentation à 8 pins, ce qui est là encore une première. On peut d'ailleurs se demander si l'usage d'une alimentation externe, comme on en avait déjà vu que les dernières Voodoo de 3dfx n'aurait pas été plus opportune.

Asus n'a pour l'instant communiqué ni date de sortie, ni tarif, mais ce dernier va sans doute atteindre des sommets.

Posté par Matt le 20/07/2010 à 11h22

Aucun commentaire

Source : Tom's Hardware

Après sa conférence de presse de vendredi, Apple n'a clairement pas répondu aux attentes d'explications de nombreux utilisateurs, et le débat est donc loin d'être résolu. Mais en plus, Apple va désormais devoir composer avec la colère de ses concurrents, qui n'ont pas du tout apprécié les propos d'Apple...

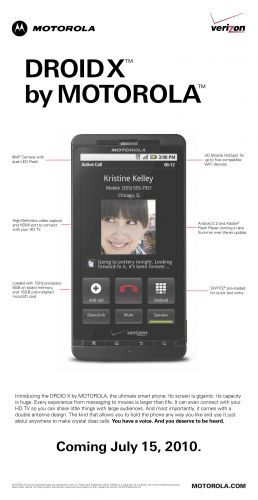

En effet, durant la conférence, Apple n'a pas réellement reconnu le problème, et a préféré prétendre qu'il existait aussi chez les appareils des concurrents. Concurrents qui ne manquent donc pas de réagir, réfutant les propos d'Apple. Ainsi, pour Motorola, "il est tendancieux de dire que tous les téléphones sont touchés de la même façon. D'après nos tests le Droid X fonctionne mieux que l'iPhone 4 quand il est tenu par un utilisateur".

Pour RIM, "la tentative d'Apple d'embarquer RIM dans le pétrin où elle s'est mise toute seule est inacceptable. Les propos d'Apple au sujet des produits RIM semblent être une tentative délibérée de distorsion de la compréhension du public vis à vis de la conception des antennes ... RIM a évité pendant 20 ans d'utiliser des designs tels que celui utilisé par Apple pour l'iPhone 4 ... les clients de RIM n'ont pas besoin de mettre un étui autour de leur BlackBerry pour disposer d'une connexion correcte. Apple a clairement fait des choix de conception et devrait assumer ses responsabilités sur ce sujet, plutôt que de tenter de mouiller RIM et d'autres constructeurs dans une affaire qui ne concerne qu'Apple." (version complète en anglais sur Engadget).

Nokia est pour sa part un peu moins incisif, mais insiste tout de même sur l'importance qu'ils apportent à la qualité de réception : "La conception des antennes est un sujet complexe, qui a été le cœur de métier de Nokia pendant des décennies ... Nokia a investi des milliers d'heures de travail à étudier le comportement humain, et notamment la façon dont les gens tiennent leur téléphone pour passer un appel, écouter de la musique, surfer, etc ... nous mettons la priorité sur les performances de l'antenne plutôt que sur l'apparence physique si ces deux critères entrent en conflit ... en général, les performances de l'antenne peuvent être acceptée lorsque l'appareil est serré dans la main. C'est pourquoi Nokia conçoit ses téléphones en s'assurant des performances acceptables dans toutes les situations réelles, y compris lorsqu'il est tenu dans n'importe quelle main ... par exemple en plaçant une antenne en haut et une en bas et par une sélection rigoureuse des matériaux utilisés." (version complète en anglais sur Engadget).

On notera également que Motorola avait déjà taclé l'iPhone il y a deux semaines dans sa publicité pour le Droid X, qui comporte une allusion aux problèmes de l'iPhone 4 : "il a été conçu avec deux antennes. Ceci permet de tenir le téléphone comme vous le voulez et de l'utiliser quasiment partout pour faire des appels de bonne qualité. Vous avez une voix. Et vous méritez d'être entendu."

Mise à jour le 19/07/2010 à 23h57 : Après Motorola, Nokia et RIM ce week-end, Samsung et HTC ont également réagit aux propos d'Apple, niant le fait que leurs appareils sont touchés autant que l'iPhone 4.

Le taïwanais n'a pour l'instant pas réagit de manière officielle, mais Eric Lin, responsable presse d'HTC, a indiqué au site Pocket-Lint que le taux de plaintes enregistrées par le service client au sujet du Droid Eris (l'un des modèles pointés du doigt par Apple) est de seulement 0.016%, soit 34 fois moins que le chiffre annoncé par Apple pour l'iPhone. Et ces 0.016% incluent toutes les plaintes, pas seulement celles concernant d'éventuels problèmes de réception...

Côté Samsung, ce sont deux démentis officiels qui ont été publiés. Tout d'abord, le porte parole du Coréen a indiqué au Korea Herald que "l'antenne est située en bas de l'Omnia 2 ... Notre conception maintient une certaine distance entre la main et l'antenne. ... Aucun problème de réception n'a été relevé jusqu'à présent." (version complète en anglais sur Samsunghub). C'est en suite le vice-président de la division mobile, Hwan Kim, qui a envoyé un communiqué à l'agence Reuters : "Nous n'avons pas reçu un nombre de plaintes significatif à propos de problèmes de pertes de signal sur l'Omnia II. ... les téléphones mobiles Samsung utilisent une antenne interne, qui optimise la réception quelque soit le type de prise en main." (version complète en anglais sur le site de Reuters)

L'"Antennagate" est loin d'être terminé...

Actu originale : le 18/07/2010 à 19h11

Posté par Matt le 19/07/2010 à 23h57

Aucun commentaire

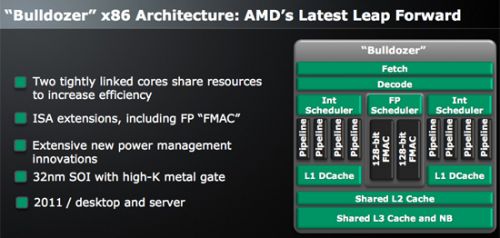

Dans sa course pour rejoindre Intel sur le plan des performances de ses processeurs, AMD vient de produire les premiers exemplaires fonctionnels de sa prochaine génération de processeurs, qui porte pour l'instant le nom de code "Bulldozer".

Il s'agit cette fois de bien plus qu'une révision de l'architecture existante, puisque Bulldozer va introduire un nouveau concept : des cœurs "entrelacés". En effet, plutôt que mettre deux cœurs complet côte à côte sur un même die, AMD a dédoublé une partie des unités de calcul d'un cœur (calculs entiers, scheduler, cache L1...), permettant ainsi d'exécuter deux flux d'instructions en parallèle (sauf lorsque les deux doivent travailler en virgule flottante, cette unité n'étant pas dédoublée).

Il s'agit en quelque sorte d'une solution intermédiaire entre deux vrais cœurs et un seul cœur avec HyperThreading : deux vrais cœurs sont plus efficaces, car tout est dédoublé, mais utilisent beaucoup de silicium, alors que toutes les unités ne seront pas toujours utilisées, tandis que l'HyperThreading économise du silicium en n'ajoutant pas d'unité de calcul supplémentaire, mais optimise l'utilisation des unités existantes. Côté performances, AMD annonce des gains de l'ordre de 80% sur du code multithreadé, ce qui est proche des résultats obtenus avec deux vrais cœurs.

Gravée en 32nm, ces nouveaux processeurs devrait arriver courant 2011, pour entrer en concurrence avec les Sandy Bridge d'Intel.

Posté par Matt le 19/07/2010 à 16h09

Aucun commentaire

Source : PCWorld

Il y a quelques semaines, une affaire d'espionnage faisait la une des journaux américains, après qu'un réseau d'espions russes ait été démantelé aux États-Unis. Onze espions russes avaient été identifiés, dont dix qui ont été expulsés du territoire, pendant que le onzième était en cavale. En début de semaine, un douzième homme a été arrêté.

C'est ainsi que Microsoft s'est retrouvée potentiellement touchée par cette affaire, puisque ce douzième homme est un informaticien de 23 ans qui a travaillé chez Microsoft pendant neuf mois. La firme de Redmond peut donc avoir quelques craintes sur d'éventuelles fuites de secret industriels vers la Russie.

Selon l'entreprise, le Russe ne devrait toutefois pas avoir été en mesure de compromettre son activité, dans la mesure où il n'officiait pas à un poste à responsabilité, son rôle se situant dans le domaine du test de produits Microsoft. Aucune charge n'a d'ailleurs été retenue contre lui, mais il sera par contre expulsé des États-Unis, comme ses dix compatriotes.

Posté par Matt le 18/07/2010 à 12h12

Aucun commentaire

Source : Generation NT

Hier, Apple a tenu une conférence de presse au sujet du très médiatisé problème de réception qui touche l'iPhone 4 lorsqu'il est tenu d'une certaine manière, et qui peut conduire à de très fortes baisses de débit, voir à des coupures de connexions.

Commençons par un petit rappel chronologique. Le 24 juin, Apple a lancé l'iPhone 4, arborant un nouveau design, avec en particulier des antennes en position externe, tout autour de l'appareil, pour libérer de la place à l'intérieur, et réduire ainsi la taille de l'appareil. La jour même, certains acheteurs ont commencé à constater un problème de chute de réception lorsque l'iPhone est tenu de manière à ce que la main entre en contact avec le joint noir qui sépare les deux antennes dans le coin inférieur gauche.

Aux premières plaintes, Apple a répondu en réfutant le problème, et en suggérant aux utilisateurs impactés de tenir leur iPhone directement où d'acheter un Bumper, un étui protégeant le cadre de l'appareil et vendu 30€ par Apple. Des réponses qui n'ont fait qu'envenimer la situation. Finalement, le 2 juillet, Apple a publié sur son site une lettre au sujet de l'iPhone 4. Loin de reconnaitre un défaut de conception, Apple indique dans ce communiqué qu'il y a en fait un problème dans l'algorithme de calcul du nombre de barres, qui serait trop optimiste. Et donc, la chute du nombre de barres ne serait que le reflet d'une très légère baisse de réception... C'est pour corriger cet algorithme qu'Apple a lancé le 15 juillet la mise à jour 4.0.1 d'iOS, qui affiche désormais effectivement moins de barres qu'avant. Une "solution" qui n'a pas convaincu grand monde...

Entre temps, le magazine Consumer Reports, équivalent américain de nos Que Choisir et 60 Millions de Consommateurs, a publié sur son site un article expliquant que, bien qu'ils considèrent l'iPhone 4 comme le meilleur smartphone du marché, ils refusent de le recommander, en raison de ce problème de réception. Un article qui a mis le feu aux poudres, et poussé Apple à donner une conférence de presse sur le sujet. Ce qui nous amène donc à cette fameuse conférence de presse, dont vous pouvez retrouver la retranscription chez Engadget.

En résumé, pour Apple, il n'y a pas plus de problèmes de chute de réception avec l'iPhone qu'avec n'importe quel autre smartphone. Apple appuie ses dires en montrant les résultats d'une prise en main sur différents modèles concurrents. On y voit effectivement le nombre de barres chuter. Mais Apple ne propose par contre aucune mesure de débit sur les modèles concurrents... Alors même que ces mesures de débit sont bien plus fiables que le nombre de barres, dont Apple elle même avait reconnu deux semaines plus tôt qu'il n'était pas forcément correct... Cette baisse est due au fait que le corps humain absorbe une partie des ondes, et donc, que le téléphone en reçoit moins. Pas un mot donc sur un éventuel problème lié au contact de la main avec le joint entre les deux antennes, qui expliquerait le fait que les chutes de débit sont beaucoup plus marquées sur l'iPhone 4.

Pour les clients insatisfaits, Apple offrira un bumper, puisque cet accessoire permet de limiter l'impact de la baisse de débit. C'est là tout le paradoxe de cette conférence de presse : alors que le problème reconnu par Apple, et qui touche effectivement tous les téléphones, est inévitable et impossible à compenser, puisque l'énergie absorbée par le corps ne peut pas être récupérée par un quelconque accessoire, Apple offre une solution qui reconnait implicitement un problème lié au contact de la main avec l'antenne, puisque si le bumper améliore la réception, c'est justement parce qu'il évite ce contact...

Bref, Apple refuse de reconnaitre le problème, mais en est visiblement bien consciente. Une belle leçon de langue de bois, comme peu de marques pourraient se le permettre sans se faire lapider. Mais comme l'a opportunément souligné Jobs pendant la conférence, Apple est la marque qui a les clients les plus fidèles, ce qui doit permettre de leur faire avaler plus aisément des couleuvres...

Posté par Matt le 17/07/2010 à 22h25

Aucun commentaire

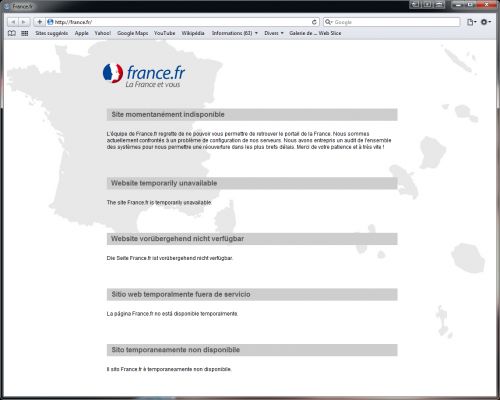

Aussi incroyable que cela puisse paraitre en 2010, la France ne disposait jusqu'à présent pas de site Internet officiel. C'est désormais chose faite avec France.fr, lancé hier à l'occasion de la fête nationale, ou presque...

Destiné tant aux citoyens français, qu'aux étrangers désireux de se renseigner sur l'hexagone, le site connait en effet des débuts forts chaotiques, puisqu'il est tout simplement indisponible à l'heure actuelle, les serveurs ayant apparemment été dimensionnés de façon insuffisante... Après un premier message indiquant un problème de capacité ("Parce que France.fr est victime de son succès, le nombre très important de visiteurs nous contraint à augmenter la capacité de nos serveurs. Quelques perturbations dans la visite du portail dans ses 5 langues peuvent donc survenir, l'équipe de France.fr vous prie de l'en excuser. Tout sera rétabli au plus vite, merci de votre patience !"), on a désormais droit aux problèmes de configuration, plus de 24h après le lancement :

Quand il sera à nouveau disponible, le site devrait s'organiser en 6 rubriques thématiques (Connaître, Visiter, Vivre, Étudier, Travailler et Entreprendre) et proposer plus de 6000 liens vers des sites externes, le tout proposé dans un premier temps en français, anglais, allemand, espagnol et italien, avant une traduction en arabe, chinois et russe l'année prochaine.

On notera également que l'État a choisi de confier le site à l'hébergeur français Vert2all qui, s'il n'est pas le moins cher du marché, revendique d'être le plus vert, avec un datacenter construit dans des matériaux écologiques, refroidi par géothermie et hébergeant des serveurs basse consommation intégralement alimentés par des énergies renouvelables. Cela dit, dans l'état actuel du site, il serait encore plus vert en débranchant le serveur :-)

Posté par Matt le 15/07/2010 à 23h37

Aucun commentaire

Source : PCWorld

Depuis le lancement de Windows Vista, Microsoft propose aux entreprises qui le désirent de remplacer gratuitement leurs Windows Vista et Windows 7 par des Windows XP, afin qu'elle puisse s'équiper de nouveaux PC, tout en continuant à utiliser Windows XP, pour conserver la compatibilité avec leur parc existant. Un droit qui devait expirer le 22 octobre prochain, date anniversaire du lancement de Windows 7.

Mais alors que Microsoft a mis fin il y a quelques jours au support de Windows XP SP2, l'éditeur a annoncé que la période pendant laquelle il sera possible de rétrograder une licence Windows récente vers Windows XP sera prolongée de dix ans, jusqu'en 2020. En effet, 73% des entreprises fonctionnent encore avec Windows XP, et la demande pour cette version est encore grande.

Dans les faits, il y a tout de même peu de chances que beaucoup de clients de Microsoft optent encore pour cette option dans dix ans. Tout d'abord, parce que côté Microsoft, le support ne sera assuré que jusqu'à avril 2014, et peu d'entreprises devraient donc utiliser Windows XP au delà de cette date. Ensuite, parce que les PC qui seront vendus dans 10 ans ne disposeront probablement pas de drivers adaptés à Windows XP, qui sera alors âgé de 19 ans. Quand on sait que Windows NT4 (14 ans) et Windows 2000 (10 ans) sont déjà de moins en moins supportés par le matériel actuel, il y a donc peu de chances qu'XP soit encore supporté par le matériel de 2020, même si sa longévité a été exceptionnelle.

Posté par Matt le 15/07/2010 à 23h01

Aucun commentaire

Source : Tom's Hardware

Maintenant que la HD est partout, elle ne constitue logiquement plus un argument commercial majeur. Alors que les constructeurs de TV se sont tournés vers la 3D pour continuer à vendre leurs produits, YouTube a pour sa part fait le choix du 4K.

4K ? Késako ? Le 4K, c'est tout simplement la HD du future, offrant plus de quatre fois plus de pixels que le "vieux" full HD 1080p. Ainsi, pour une image en 16/9ème, la définition atteint 4096x2304, d'où la dénomination 4K, qui se rapporte au nombre de colonnes de l'image (alors que la "vieille" HD utilisait le nombre de lignes comme référence...

Le service de partage de vidéos de Google supporte donc désormais cette nouvelle résolution, et propose même une playlist dédiée au 4K, permettant d'accéder à toutes les vidéos à ce format, c'est-à-dire... 5 vidéos pour l'instant. Une goutte d'eau dans l'océan YouTube.

Ce chiffre ne devrait par ailleurs pas croître rapidement, puisque le support de cette résolution reste pour l'instant purement marketing, de nombreux obstacles techniques empêchant encore son exploitation. Le premier est bien entendu du côté restitution : quasiment personne n'est aujourd'hui en mesure de profiter de cette résolution. Les prototypes d'écrans compatibles se comptent quasiment sur les doigts d'une main, et les modèles commercialisés sont encore plus rare, et généralement réservés aux professionnels.

Côté transfert également, ça risque de coincer, puisque les flux 4K vont nécessiter une bande passante nettement plus élevée. À moins d'être très fortement compressés, mais on perd alors l'intérêt d'une telle résolution, les artefacts de compression venant tout gâcher. Enfin, côté acquisition, il faudrait que les caméras 4K se démocratisent. Dans les milieux professionnels, ce format s'impose petit à petit, grâce notamment à la très abordable Red One 4K, et les pellicules sont de plus en plus souvent numérisés en 4K, mais du côté du grand public, même le 1080p n'est pas encore la norme, la plupart des appareils d'acquisition se contentant du 720p, voir du VGA ou du QVGA. YouTube étant essentiellement alimenté par des sources amateurs, la 4K attendra donc sans doute encore un paquet d'années avant d'y devenir la norme...

Posté par Matt le 13/07/2010 à 10h50

Aucun commentaire

Source : Clubic

En ces temps de rigueur, on entend beaucoup parler de suppression des niches fiscales. Parmi elle, il y en a une qu'on oublie souvent, mais qui serait dans le collimateur de l'état : le non assujettissement des ordinateurs à la redevance audiovisuelle, même lorsqu'ils sont capables de recevoir la télévision ou la radio.

En effet, à l'heure actuelle, la redevance se limite aux téléviseurs dotés de tuner ou à tout autre appareil doté d'un tuner et raccordé à un écran ou un vidéo-projecteur, à l'exception des PC équipés de cartes tuner (une exception dont on se demande bien pourquoi elle existe...). Dans un récent rapport, deux sénateurs insistent toutefois sur le fait qu'avec la popularité croissante des services de télévision de rattrapage, les programmes de télévision sont aujourd'hui largement accessibles sur tout ordinateur connecté à Internet. Une raison suffisante selon eux pour assujettir les ordinateurs à la redevance (en oubliant au passage le côté "connecté à Internet"...).

Selon les deux sénateurs, cet élargissement de l'assiette de la redevance pourrait rapporter chaque année environ 15 millions d'euros supplémentaire pour le financement de l'audiovisuel public. Une somme dont celle-ci aurait bien besoin, pour compenser une partie du manque à gagner dû à la suppression de la publicité. Les possesseurs de résidences secondaires pourraient également être concernés par un élargissement de l'assiette, les sénateurs suggérant de soumettre à nouveau les résidences secondaires à redevances, alors que ce n'était plus le cas depuis quelques années. Avec à la clé une manne potentielle de l'ordre de 550 millions d'euros.

Enfin, le montant de la redevance devrait être revu à la hausse de 2€ par an. Soit un peu moins de 2% du montant actuel, de 121€ en métropole et 77€ outre-mer. On peut par ailleurs déduire de ce montant que seuls 125 000 foyers environs seront concernés par l'élargissement de l'assiette aux ordinateurs, un chiffre qui s'explique tout simplement par le fait que la majorité des possesseurs d'ordinateurs ont aussi une télévision, donc sont déjà assujettis à la redevance.

MàJ le 13/07/2010 à 00:10 : interrogé sur le sujet, François Baroin, ministre du budget, a indiqué que l'extension de la redevance aux ordinateurs n'était pour l'instant pas à l'ordre du jour, aucune étude n'ayant démontré une consommation significative de programmes télévisés sur ordinateur. Le ministre précise toutefois que cette extension pourrait être étudiée si la situation venait à évoluer.

Actu originale : 05/07/2010 à 22:23

Posté par Matt le 13/07/2010 à 00h10

4 commentaires

Source : Clubic

Depuis l'été 2009, de nombreux utilisateurs de la Time Capsule d'Apple se plaignaient de pannes subites, survenant généralement au bout de 15 à 18 mois. Un an après, Apple reconnait enfin le problème, et prendra désormais en charge les réparations hors garantie.

Le problème avait été rapidement identifié par la communauté : il s'agissait d'un problèmes de qualité des condensateurs de l'alimentation, qui avaient tendance à claquer au bout d'une grosse quinzaine de mois d'utilisation. Nombreux sont ceux qui avaient d'ailleurs réparé leur Time Capsule eux même, en remplaçant les condensateurs défectueux.

Ces pannes seront donc désormais prises en charge par Apple, en échangeant les Time Capsule défectueuses contre des modèles neufs. Les centres de maintenance prendront également en charge le transfert des données de l'ancien disque dur vers le nouveau, et Apple remboursera les clients qui avaient fait réparer leur appareil à leurs frais.

Sont concernées toutes les Time Capsule vendues entre février et juin 2008 et dont le numéro de série est compris entre XX807XXXXXX et XX814XXXXXX. Si vous êtes concerné, vous pouvez vous rendre sur le site d'Apple pour suivre la procédure d'extension de garantie.

Posté par Matt le 12/07/2010 à 22h40

2 commentaires

Source : Macbidouille

Lancée en 1998 pour former l'entrée de gamme des processeurs Intel, la marque Celeron devrait tirer sa redevance l'année prochaine, remplacée par les Pentium. Les actuels Celeron Wolfdale 45nm seront donc les derniers représentants de cette marque.

Après avoir connu ses heures de gloires à ses débuts, grâce notamment au 300A, doué d'exceptionnelles capacités d'overclocking, la marque Celeron n'avait en effet plus beaucoup de raisons d'être depuis quelques années, suite à la disparition de la marque Pentium en haut de gamme, puis sa réintroduction sur l'entrée de gamme, venant empiéter sur les plates bandes du Celeron.

Titillé par le haut par le Pentium, le Celeron était également titillé par la bas par l'Atom, ce qui l'empêchait de descendre en gamme pour continuer d'exister. Intel a donc annoncé que l'architecture Nehalem des actuel Core i7/i5/i3 et Pentium ne sera pas déclinée en Celeron, et cette marque disparaitra donc du catalogue l'année prochaine, lorsque les modèles actuels ne seront plus commercialisés.

Posté par Matt le 09/07/2010 à 23h41

Aucun commentaire

Source : Hardware.fr

Sur le marché des consoles, il n'est pas rare qu'un constructeur vende le matériel de base à pertes, pour pénétrer le marché, en se rattrapant ensuite sur les produits dérivés. C'est la stratégie choisie par Microsoft et Sony, qui n'ont cessé que très récemment de vendre à pertes leurs consoles lancées il y a 3-4 ans. Leurs stratégie divergent par contre au niveau du jeu en réseau...

Ainsi, alors que Sony voit le jeu en réseau comme un moyen d'attirer du monde sur sa plateforme, et laisse donc le Playstation Network accessible gratuitement, Microsoft voit les services en ligne comme une fonctionnalité additionnelle génératrice de profits, au même titre que les accessoires et les jeux. Et il semblerait bien que la stratégie de Microsoft soit payante. En effet, selon Business Week, le service Xbox Live aurait généré au cours des 12 derniers mois un chiffre d'affaire supérieur à 1.2 milliards de dollars, soit, avec une marge brute estimée à 65%, un bénéfice brut de près de 800 millions de dollars.

Cette belle performance devrait permettre à la division divertissement de Microsoft de multiplier son résultat net par six par rapport à l'année précédente, alors que Sony a de son côté encore du mal à rentabiliser sa plateforme Playstation 3. Vu ces résultats, dont près de la moitié provient des abonnements, il ne serait pas surprenant que Sony opte également pour un service payant avec sa prochaine génération de consoles, même si, auprès des clients de la marque, il risque d'être difficile de faire accepter un tel virage.

Posté par Matt le 08/07/2010 à 11h00

Aucun commentaire

Source : PCInpact

Soucieuse de son indépendance technologique par rapport au monde occidentale, la Chine produit depuis quelques années son processeur maison, le Godson, utilisant un jeu d'instruction MIPS64. Celui-ci pourrait bientôt bénéficier d'une révision majeure, aux caractéristiques impressionnantes...

En effet, la Chine prépare actuellement le Godson 3C, qui sera doté de pas moins de 16 cœurs, et pourrait être capable de gérer jusqu'à 32 threads, grâce au SMT. Supportant la mémoire DDR3 et doté d'une unité d'exécution vectorielle 512 bits, il sera gravé en 32nm, ce qui montre à quel point la Chine est en train de rattraper son retard technologique, puisque le Godson actuel utilise encore un bon vieux 65nm, mais que le passage au 32nm met le Godson 3C à la pointe de la technologie, puisque même AMD ne maîtrise pas encore cette finesse de gravure, qu'Intel commence tout juste à utiliser.

En raison de son jeu d'instructions MIPS, ce processeur n'est par contre pas compatibles avec la majorité des logiciels PC, qui nécessitent un processeur exploitant le jeu d'instruction x86. Pour palier à cette limitation, le Godson est capable d'émuler le x86, et le Godson 3C sera même doté d'unités dédiées à accélérer cette émulation. Selon son constructeur, il atteindrait ainsi environ 70% de la vitesse d'un processeur nativement x86. Reste à voir quel processeur x86 a été pris comme référence...

Posté par Matt le 07/07/2010 à 23h05

Aucun commentaire

Source : Tom's Hardware

Si vous avez un jour cherché à acheter une clé 3G en France, vous avez sans doute eu l'occasion de constater l'omniprésence du Chinois Huawei sur ce marché. C'est bien simple : à l'heure actuelle les trois opérateurs français ne proposent à leurs clients que des clés Huawei. Une situation qui n'est pas sans énerver Option, un fabricant belge de modems 3G...

En effet, bien qu'il soit d'origine européenne, Option a énormément de mal à vendre ses produits en Europe. Plus de mal même que pour les vendre dans le reste du monde. Les chinois Huawei et ZTE détiendraient ainsi jusqu'à 80% du marché. Et selon Option, cette domination des chinois sur le marché n'aurait rien de naturel, et serait dû à des pratiques des dumping : ZTE et Huawei auraient proposé leurs produits aux opérateurs européens à des tarifs exceptionnellement faibles, afin de pénétrer le marché et d'éliminer toute concurrence.

Suite à la plainte d'Option, la commission européenne a donc ouvert une enquête, et va désormais se pencher sur les imports de modems chinois. Les autorités chinoises ont de leur côté décidé de se ranger du côté de leurs entreprises nationales, en leur promettant l'assistance dont elles pourraient avoir besoin pour assurer leur défense.

Posté par Matt le 07/07/2010 à 11h00

Aucun commentaire

Source : Génération NT

Il y a quelques semaines, nous apprenions que les autorités américaines de régulation de la concurrence avaient commencé à enquêter sur Apple, en particulier pour les nouvelles clauses de leur SDK, qui visaient clairement à freiner la régie publicitaire AdMob sur iPhone, au profit d'iAd, la plateforme d'Apple. Emboîtant le pas à leurs confrères américains, les régulateurs européens ont également ouvert une enquête.

L'enquête européenne est menée par la néerlandaise Neelie Kroes, commissaire européenne en charge de la société numérique. Celle-ci s'était déjà illustrée en étant à l'origine d'une enquête qui avait mené Microsoft à une condamnation d'1.4 milliards de dollars en raison du manque d'ouverture de leurs logiciels. Elle reproche à Apple de ne pas respecter les règles d'interopérabilité qui s'appliquent aux systèmes numériques en Europe.

En cas de condamnation, Apple pourrait ainsi être forcée à accepter le support de Flash, le développement d'applications iPhone dans un environnement autre qu'Xcode, voir même à permettre la distribution d'applications en dehors du circuit de l'App Store. Une véritable révolution dans le monde de l'iPhone ! D'autres constructeurs de smartphones pourraient également être concernés par des enquêtes similaires, la commissaire ayant affirmé ne pas viser Apple en particulier.

Posté par Matt le 06/07/2010 à 22h36

Aucun commentaire

Sources : Rethink Wireless via Macbidouille

![]()

Dans environ deux ans, Iliad doit lancer son service de téléphonie mobile 3G, Free Mobile. Mais d'ici là, leur réseau ne devrait couvrir qu'une petite fraction de la population, très insuffisante pour lancer une offre viable commercialement. C'est là que l'itinérance avec les autres opérateurs doit intervenir.

En effet, afin d'éviter un lancement trop difficile pour Free Mobile, les trois opérateurs déjà en place auront pour obligation de partager leur réseau avec le nouvel arrivant dans les zones qu'il ne couvre pas, afin qu'il ne soit pas trop défavorisé commercialement. Hélas pour Free, cette obligation ne concerne que l'itinérance 2G (GSM/GPRS/EDGE), et non pas l'itinérance 3G.

Après que le PDG d'SFR se soit exprimé sur le sujet, en expliquant qu'il était hors de question pour lui de partager "son" réseau 3G avec Free, alors qu'il est déjà saturé par ses propres clients, Stéphane Richard, directeur général de France Télécom s'est à son tour prononcé sur le sujet. Et sans surprise, le son de cloche est le même que chez SFR : Orange refuse catégoriquement de partager son réseau avec Iliad, à moins bien sûr que l'ARCEP ne les y oblige.

Mais dans cette éventualité, Orange menace d'ores et déjà de lancer une procédure pour annuler l'attribution de la quatrième licence 3G à Free. En effet, pour Orange, le fait qu'il n'y avait aucune obligation d'itinérance 3G est l'une des raisons pour laquelle, en dehors de Free, tous les candidats à la licence se sont désistés progressivement. Ainsi, ce changement réglementaire justifierait le lancement d'une nouvelle procédure de sélection, qui retarderait l'arrivée du quatrième opérateur sur le marché.

Posté par Matt le 06/07/2010 à 10h50

1 commentaire

Source : Generation NT

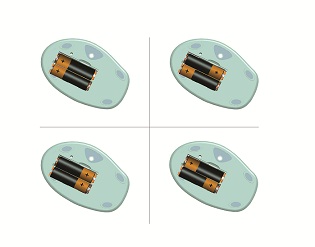

Si Microsoft est bien entendu surtout connu pour ses logiciels, l'éditeur de Redmond a plus d'une corde à son arc, et innove régulièrement dans le domaine du matériel, en particulier avec ses souris. On lui doit notamment les souris à molette, les souris optiques, etc... Et bientôt, les souris à piles "réversibles".

En effet, Microsoft vient de rendre publique sa technologie InstaLoad, qui permettra de monter les piles dans n'importe quel sens. Et tout ça, sans la moindre électronique, grâce à une astuce tout bête : chaque côté du compartiment à piles contient un contact négatif sur les bords, et un contact positif au milieu, légèrement en retrait. Ainsi, la borne négative de la pile ne touchera que le contact négatif, tandis que la borne positive "traversera" le contact négatif sans le toucher.

Les premiers produits Microsoft InstaLoad devraient arriver dans le courant de l'année, tandis que d'autres constructeurs pourraient également bénéficier de cette technologie, que Microsoft a décider de licencier. Duracell devrait notamment proposer un chargeur de piles utilisant ce système.

Posté par Matt le 05/07/2010 à 23h06

Aucun commentaire

Source : Macbidouille

L'Australien Pioneer Computers vient de dévoiler son DreamBook ePad A10. Derrière ce nom pas forcément très original se cache l'une des premières tablettes tactiles sous Windows 7 à être commercialisée.

Assemblé dans un châssis de 26.7x17.3 cm pour une épaisseur comprise entre 0.8 et 1.7 cm, l'ePad est une tablette 10.1" wide (1024x600). Embarquant Windows 7, elle est bien entendu dotée d'un processeur x86, avec au choix un Atom N455 1.66 GHz ou un Atom N475 1.83 GHz. Dans les deux cas, le processeur est accompagné de 1 Go de RAM (extensible à 2 Go), d'un contrôleur réseau Ethernet 10/100 Mbits/s et Wi-Fi n, d'un SSD de 16 ou 32 Go et d'un système audio stéréo.

Côté accessoire l'ePad est doté d'un lecteur micro-SD, d'une webcam 1.3MP, d'un micro, et pourra accueillir différents périphériques via trois ports USB 2.0 (deux ports classiques et un port mini USB). Le tout pèse environ 900 grammes, en incluant la batterie Li-Po qui assure 5 heures d'autonomie.

Elle est vendue 599 dollars australiens, soit environ 416€. À titre de comparaison, la tablette pommée est vendue au pays des kangourous pour un prix allant de 629 à 1049 A$ selon les versions.

Posté par Matt le 02/07/2010 à 10h42

Aucun commentaire

Source : Generation NT

Sony a annoncé avoir découvert un problème au niveau de la régulation de la température sur bon nombre de ses portables Vaio séries F11 et CW2. Le problème peut mener à une surchauffe et une détérioration de l'ordinateur.

Environ 535 000 machines sont concernées, toutes datant d'après janvier 2010, est essentiellement vendues aux États-Unis et au Japon. Le problème étant d'origine et sans risque de conséquences graves pour l'utilisateur, le japonnais n'organise pas de campagne de rappel, contrairement à ce qu'il avait fait il y a quatre ans pour les problèmes de batteries qui surchauffaient, mais il propose sur son site une page dédiée à ce problème, recensant précisément les numéro de série des machines concernées et décrivant la procédure à suivre pour mettre à jour le BIOS des Vaio affectés.

Si vous possédez un Sony Vaio F11 ou CW2, nous vous invitons donc à visiter le site de Sony pour vérifier si vous être concerné par le problème.