Actualités du mois de mai 2011

Ces derniers mois, le marché des disques durs s'est fortement consolidé, avec la fusion des quatres grands constructeurs en deux pôles, Western Digital/Hitachi d'un côté, Seagate/Samsung de l'autre. Une consolidation qui inquiète les autorités européennes...

En effet, la Commission Européenne, dont l'un des rôles est de s'assurer du maintien de la libre concurrence, a annoncé avoir ouvert une enquête sur les deux acquisitions en cours, pour vérifier si ces deux opérations ne risquent pas d'être un frein à la libre concurrence sur le marché des disques durs, ce qui aurait pour conséquence une hausse artificielle des prix.

Dans le cas où ces deux rachats seraient validé, on passerait en effet d'un marché contrôlé par cinq constructeurs, ce qui n'est déjà pas énorme, à un marché contrôlé par à peine trois constructeurs. Et encore, Toshiba est un peu à part, puisque ses produits ne visent que certains marchés.

Après avoir accepté les rachats de Fujitsu par Toshiba et de Maxtor par Seagate, la Commission pourrait donc bien cette fois bloquer le rachat, en fonction des conclusions de l'enquête, qui seront rendues en octobre prochain.

Posté par Matt le 31/05/2011 à 23h41

Aucun commentaire

Source : Clubic

Le taîwanais Asus s'est fait remarquer à domicile en ce premier jour du Computex, avec toute une série de nouveautés dans le domaine de la mobilité, avec quelques produits relativement originaux. Le constructeur semble bien décidé à séduire les utilisateurs nomades, quelques soient leurs besoins !

Commençons par l'entrée de gamme, avec un nouveau netbook, le Eee PC X101. Embarquant un processeur Atom N435 à 1.33 GHz, cet Eee PC 10" (1024x600) est taillé pour la mobilité, avec à peine 1.76cm d'épaisseur et 950g avec sa batterie de 28Wh. Il sera proposé à un prix plancher, avec à peine 200$ pour l'entrée de gamme, qui fonctionnera sous le système MeeGo, tandis que des versions plus haut de gamme auront droit à Windows 7.

Beaucoup plus haut de gamme, l'UX21 est un ultra-portable largement inspiré du Macbook Air dans son design, avec son châssis en alu reprenant les formes des l'ultra-portable d'Apple. Il est par contre dotée d'une configuration un peu plus haut de gamme, avec un processeur Core i7, un SSD SATA 6 Gbit/s, un port USB 3.0, un clavier métallique, etc... Avec seulement 17mm d'épaisseur, il égale aussi son concurrent à la pomme sur ce point.

Les tablettes ne sont pas oubliées non plus. Tout d'abord, Asus à confirmé sa tablette Eee Pad MeMo de 7", déjà vue lors du CES en début d'année, mais à donné un peu plus de détails sur la configuration, en révélant en particulier que l'écran sera doté d'une technologie 3D sans lunettes.

Enfin, le meilleur pour la fin : le PadPhone, sans doute le plus original des produits Asus de ce Computex. Comme son nom l'indique, il s'agit d'une tablette faisant aussi téléphone. Mais pas question bien sûr de porter une grosse tablette à l'oreille pour téléphoner : à l'instar de Motorola avec son Atrix, Asus a conçu un smartphone doté d'une station d'accueil faisant office de tablette. Asus n'a par contre donné aucun détail sur les caractéristiques techniques, ce qui laisse entendre qu'on est encore assez loin de la commercialisation... Il ne manquerait plus qu'une compatibilité avec le dock clavier de l'Eee Pad Transformer pour en faire un des produits les plus polyvalents du marché !

Posté par Matt le 31/05/2011 à 09h00

Aucun commentaire

![]()

Le groupe Iliad a tenu il y a quelques jours son Assemblée Générale. Outre la prolongation du mandat de Maxime Lombardini au poste de directeur général du groupe, cette AG a été l'occasion de faire un point sur l'état d'avancement des deux réseaux d'avenir d'Iliad : le réseau 3G pour Free Mobile et le réseau fibre optique (FTTH).

Du côté de la fibre, si Free ne dispose pour l'instant pas d'un grand nombre d'abonnés, l'opérateur compte bien passer à la vitesse supérieure en 2011, avec un objectif à 100 000 abonnés d'ici à la fin de l'année. Cette croissance s'appuiera sur plus de 200 NRO déployés dans une centaine de villes.

Concernant Free Mobile, le lancement de l'offre commerciale est toujours prévu pour le début de l'année prochaine. Free est confiant sur le fait qu'il atteindra dans les temps le taux de couverture imposé par l'ARCEP (27% de la population), grâce à un réseau qui comportera plus de 5000 antennes relais. L'investissement total dans le réseau 3G avant le lancement de l'offre devrait avoisiner le milliard d'euros, conformément aux plans initiaux du groupe.

Posté par Matt le 30/05/2011 à 13h10

1 commentaire

Source : Freenews

En une grosse douzaine d'années d'existence, Google a connu beaucoup de succès. Dans le domaine de la recherche sur Internet bien sûr, mais aussi dans les navigateurs, les OS mobiles, la messagerie... Mais il y a un secteur ou le géant est toujours à la peine : les réseaux sociaux, largement dominés par Facebook, Twitter et LinkedIn, chacun avec sa propre vision du réseau social.

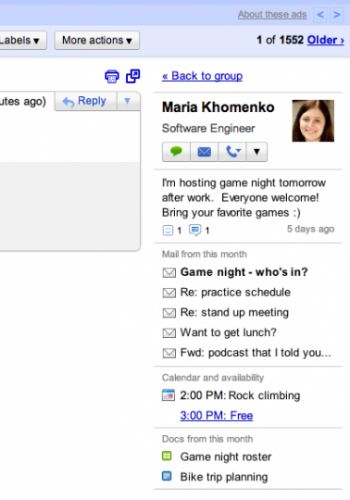

Mais malgré l'échec retentissant de Wave et le peu de succès de Buzz, Google ne semble pas décidé à jetter l'éponge, et prépare une nouvelle façon de se faire sa place dans le milieu des réseaux sociaux, en essayant cette fois de se distinguer un peu plus des acteurs historiques du marché. Cette nouvelle tentative surfera sur la popularité de Gmail, en venant s'intégrer directement dans l'interface du service de messagerie, via le "People Widget".

Ce widget s'affichera sur la droite de l'écran lors de la lecture d'un courrier et il regroupera un ensemble d'informations "sociales" relatives aux contacts impliqués dans la conversation : message de statut, photo, liens pour initier un chat, un appel vocal, envoyer un message, liste des derniers mails échangés, liste des rendez-vous, etc... Ce widget sera disponible dans une quinzaine de jours.

Plutôt que d'inciter au partage d'informations, comme le font Facebook et Twitter, Google opte donc plutôt pour un système facilitant l'accès à l'information, rapprochant ainsi le "social" de son cœur de métier. Reste à voir si cette nouvelle approche aura plus de succès que les tentatives précédentes de Google.

Posté par Matt le 30/05/2011 à 10h47

Aucun commentaire

Source : Le Journal du Geek

![]()

Comme beaucoup de constructeurs de smartphones, HTC a mis en place sur ses modèles les plus récents des systèmes de sécurité vérifiant l'authenticité de l'image système de l'appareil, et refusant de démarrer si la vérification échoue. Une fonctionnalité qui n'était pas du goût de tout le monde...

En effet, si les opérateurs appréciaient le fait de pouvoir modifier l'OS à leur guise, pour pouvoir ajouter leurs fonctionnalités propriétaires et désactiver certaines fonctions qu'ils pouvaient trouver gênantes (comme le partage de connexion par exemple), tout en ayant l'assurance que l'utilisateur ne pourra pas revenir à un système standard, les bidouilleurs eux n'appréciaient pas particulièrement d'être ainsi limités...

Une fois n'est pas coutume, c'est le voix des bidouilleurs qui a été entendue par le constructeur taïwanais, plutôt que celle des opérateurs. En effet, Peter Chou, le CEO d'HTC, a annoncé que les prochains appareils de la marque seront dotés de bootloaders plus ouverts, permettant aux utilisateurs d'installer des ROM personnalisées. Il faut dire que les avis positifs des bidouilleurs sur Internet ont probablement, par leur impact sur les ventes, plus d'importance que de bonnes relations avec les opérateurs.

Posté par Matt le 30/05/2011 à 08h31

Aucun commentaire

Source : Génération NT

Avec la hausse de consommation des datacenters, et donc une augmentation des besoins en refroidissement, on observe de plus en plus souvent les datacenters migrer vers le nord, pour profiter d'un climat plus frais et réduire ainsi les dépenses de climatisation... Mais Google vient de réaliser une grande première, en supprimant complètement le besoin de climatisation sur son dernier datacenter !

Construit en Finlande, sur le site d'une ancienne papeterie, le datacenter profite de la tuyauterie existante pour refroidir ses serveurs avec de l'eau de mer. Pour ce faire, de l'eau est pompée dans le golfe de Finlande, puis injectée dans des échangeurs thermiques où elle absorbe la chaleur produite par les serveurs. L'eau de mer ainsi réchauffée est ensuite envoyée dans un circuit de refroidissement, où elle va être mélangée à de l'eau de mer fraîche, avant d'être rejetée en mer, avec un écart de température négligeable par rapport à sa température de captage, afin de ne pas perturber l'éco-système.

Grâce à ce système, l'ensemble du datacenter fonctionne sans le moindre système de refroidissement "traditionnel" à base de compresseurs. Le géant de la recherche fait ainsi un geste écologique, en diminuant nettement la consommation électrique de son installation, tout en faisant bien sûr de grosses économies sur la facture d'électricité, ce qui constitue sans doute l'une des principales motivations pour le recours à une telle installation.

Posté par Matt le 27/05/2011 à 14h41

8 commentaires

Source : Tom's Hardware

Grâce au travail d'une start-up californienne, BlueStacks, il devrait bientôt être possible de profiter de certaines applications (celles proposées par la boutique d'Amazon) sous Windows, grâce à une version virtualisée du système mobile de Google.

Une solution qui pourrait être intéressante, certaines applications n'existant qu'en version mobile, mais qui souffrira tout de même, au moins dans un premier temps, de quelques limitations. Tout d'abord, seules les applications compilées pour s'exécuter via la machine virtuelle Android fonctionneront. Les applications compilées en code natif ARM sont exclues, mais BlueStackstravaille à un émulateur qui permettra de les exécuter. Il devrait être disponible avant la fin de l'année.

Seconde limitation, les applications disponibles uniquement sur l'Android Market ne seront pas accessibles. En effet, l'Android Market est réservé aux appareils exécutant une version officielle d'Android, et seule l'architecture ARM est supportée. Deux critères que le projet de Bluestacks ne remplis pas, puisqu'il exploite une version modifiée d'Android, sur une architecture x86.

Enfin, il pourrait y avoir quelques soucis d'ergonomie. En effet, les applications Android sont, en toute logique, optimisées pour être exploitées avec un écran tactile, éventuellement multi-touch, alors qu'une manipulation à la souris sous Windows se limite à un point de contact, et avec une maniabilité très différente de celle d'une surface tactile. BlueStackssemble toutefois confiant sur l'élimination de ce défaut à relativement court terme, ses responsables estimant que dans deux ans tous les ordinateurs seront dotés d'écrans tactiles...

BlueStacks devrait lancer sa solution de virtualisation éponyme en fin d'année, avec un pré-lancement en beta au début de l'été et la tablette Viewsonic ViewPad Pro 10" sera livrée avec cette solution pré-installée, pour pouvoir fonctionner avec Windows 7 et Android.

Posté par Matt le 27/05/2011 à 12h19

Aucun commentaire

Source : BusinessMobile

Dans les prochains mois, Intel et AMD vont tous deux lancer leurs nouvelles générations de processeurs. Mais les deux fondeurs pourraient avoir du retard sur leur planning, selon les dernières prévisions.

Côté AMD, alors que les premiers APU Fusion, qui inauguraient la nouvelle architecture, sont disponible depuis plusieurs mois déjà, la déclinaison haut de gamme, connue sous le nom de code Bulldozer, est toujours attendue. Et l'attente pourrait se prolonger. En effet, alors que ces nouvelles puces étaient attendues pour le mois de juillet, les rumeurs font désormais état d'un lancement en août, voir en septembre. D'autres déclinaisons de cette architecture pourraient également prendre du retard, mais la version mobile (Sabine) devrait être épargnée, avec une présentation lors du prochain Computex, comme prévu.

Si ces informations se confirment, le Bulldozer risque d'avoir du mal à se faire sa place; en sortant à peine quelques mois avant l'Ivy Bridge, prévu pour janvier 2012, et alors que ses performances seront probablement plutôt à comparer à celles de Sandy Bridge.

Mais le "salut" pour AMD pourrait venir d'Intel : selon la dernière roadmap publiée par Intel, Ivy Bridge n'arriverait finalement qu'au mois de mars ou avril 2012, laissant ainsi deux à trois mois de plus à AMD. Reste à voir si ce léger retard permettra à AMD de se refaire une santé. Pour cela, il faudra sans doute compter sur le milieu et l'entrée de gamme, puisqu'Intel prépare des nouveaux Sandy Bridge haut de gamme pour la fin de l'année, sur la nouvelle plateforme LGA 2011, et AMD risque d'avoir beaucoup de mal à rivaliser.

Posté par Matt le 27/05/2011 à 11h00

Aucun commentaire

Source : PCInpact

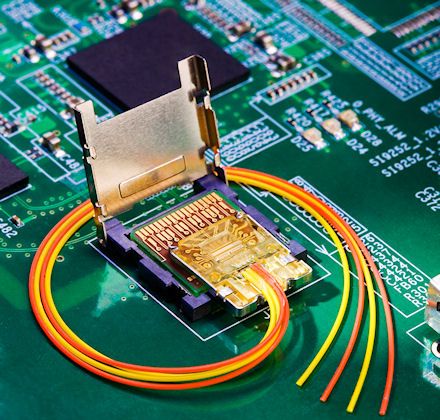

![]()

Le nom "Thunderbolt" semble être la nouvelle mode dans l'informatique... Après le nouveau port de communication d'Intel et un smartphone HTC, ce nom va désormais désigner le nouveau contrôleur SSD OCZ/Indilinx. Un contrôleur attendu depuis longtemps, qui devrait enfin arriver cette année...

Deux ans après avoir connu le succès avec son Barefoot, toujours vaillant aujourd'hui pour l'entrée de gamme, mais largement dépassé sur le haut de gamme, Indilinx, récemment racheté par OCZ, va donc enfin présenter son nouveau contrôleur, avec beaucoup de retard, puisqu'il aurait normalement dû arriver l'année dernière. Notez que ce nom de Thunderbolt est déjà mentionné dans des documents de mi-2010, donc ce nom n'a pas été choisi pour surfer sur la vague lancée par Intel.

Ce nouveau contrôleur sera dévoilé à l'occasion du Computex, qui se tiendra dans quelques jours (du 31 mai au 4 juin) à Taipei. Le constructeur a été très avar sur les caractéristiques, puisque la seule information dévoilée pour l'instant est qu'il sera compatible SATA 6 Gbit/s, ce qui est un minimum pour un contrôleur de nouvelle génération.

OCZ fera par la même occasion la démonstration d'un nouveau SSD PCI-Express, le Z-Drive R4, qui promet 2.7 Go/s et 330 KIOPS en écriture aléatoire de 4 Ko, grâce à l'exploitation du PCI-Express 3.0 et, probablement, de plusieurs contrôleurs Thunderbolt en RAID, ainsi que celle d'un nouveau RevoDrive PCI-Express qui aura la particularité de pouvoir servir de cache pour un disque dur, comme avec un chipset Intel Z68.

Posté par Matt le 27/05/2011 à 08h13

Aucun commentaire

L'absence de malwares sous Mac OS X a souvent été un argument de vente pour Apple. Mais avec la forte augmentation du parc de machine sous OS X, cette plateforme attire de plus en plus les "industriels" du malware. Mac Defender, le dernier malware en date, a d'ailleurs déclenché une vague d'appels à l'assistance d'Apple...

Se présentant sous la forme d'un anti-virus en version d'évaluation, Mac Defender vise à récupérer les coordonnées bancaires des utilisateurs, en leur vendant la version "complète" du logiciel, mais aussi d'intercepter les recherches sur Internet pour les rediriger vers certains sites peu recommandables. Un mode opératoire pas très différent de celui des précédents malwares, mais avec beaucoup plus de succès, si l'on en croit les témoignages de certains opérateurs de l'assistance téléphonique d'Apple.

En effet, selon un responsable de l'AppleCare, le service d'Apple recevrait actuellement quatre à cinq fois plus d'appels qu'en temps normal, et la majorité de ces appels sont au sujet de Mac Defender. À tel point que les téléopérateurs sont surchargés : alors qu'ils pouvaient en général faire une dizaine de minutes de pause entre deux appels, ils enchainent désormais les communications.

Face à cet affluence d'appels, une note interne a même été émise par le direction, pour indiquer aux téléopérateurs que la position officielle d'Apple est de ne pas aider les utilisateurs dans cette situation, puisqu'il ne s'agit pas d'un problème lié à un produit Apple. Pour la direction, ce travail et de la responsabilité des anti-virus, et non de celle d'Apple.

Posté par Matt le 23/05/2011 à 12h20

1 commentaire

Source : PCInpact

Collecter des millions d'adresse mail valides n'est pas toujours une tâche facile pour les spammeurs. Mais parfois, des négligences émanant des fournisseurs d'adresses mail peuvent grandement faciliter ce travail. C'est ce que révèle Tux-Planet dans le cas de Gmail, en exploitant le service Google Profiles...

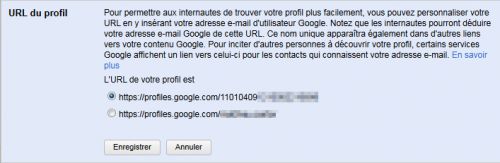

Ce service permet à tous les titulaires d'un compte Google de créer une page de profil, permettant de partager aisément certaines informations. Le profil peut avoir, au choix de l'utilisateur, une URL de la forme https://profiles.google.com/<ID numérique> ou de la forme https://profile.google.com/<adresse Gmail>. Si l'utilisateur opte pour le second choix, la première URL reste valide, et redirige vers la seconde.

C'est cette redirection à partir des ID numériques qui pose problème. En effet, pour faciliter l'indexation des profiles par les moteurs de recherche, Google fournit un fichier Sitemap contenant la liste de toutes les URL de profils, au format numérique, pour éviter d'exposer directement les adresses mail dans ce fichier.

Mais, comme le montre Tux-Planet, il suffit d'écrire un script testant une à une les URL de ce fichier (qui en comporte plus de 35 millions) pour vérifier si elles sont redirigées ou non. Si oui, l'URL de redirection permet de connaitre l'adresse Gmail du propriétaire du profile. Tux-Planet a ainsi obtenu plus de 15 000 adresses en moins d'une heure...

En attendant que Google corrige (ou pas...) ce problème, je vous conseille vivement de configurer votre profil Google pour qu'il utilise l'URL numérique plutôt que l'URL basée sur l'adresse Gmail.

Posté par Matt le 23/05/2011 à 10h20

Aucun commentaire

Source : Tux-Planet

Il y a une semaine, les tarifs des offres mobiles de La Poste pour ses collaborateurs ont été dévoilés. C'est désormais au tour des tarifs des offres grand public d'être disponibles, avec le lancement de ces offres aujourd'hui même.

On retrouve les mêmes offres que dans les forfaits destinés aux collaborateurs de La Poste, mais à des tarifs bien évidemment supérieurs, les postiers bénéficiant d'une réduction de 20% :

- des forfaits bloqués offrant 45min à 1h30 de voix, 60 SMS (illimités dès le forfait 1h) et 200 Mo de data sur les deux forfaits les plus haut de gamme, de 12€ à 26€/mois avec engagement et mobile subventionné, 10€ à 24€/mois sans engagement ni subvention.

- des forfaits classiques, de 30min à 4h sans SMS ni data (les forfaits 2h et 4h disposeront au début des SMS illimités, mais il s'agit d'une offre de lancement), de 13€ à 28€/mois avec engagement, 10€ à 25€ sans engagement. Des options permettront d'ajouter des SMS illimités et de la data illimités (fair use de 500 Mo),

- des forfaits tout compris avec 2 à 10h de voix, SMS illimités, data illimitée (fair use 500 Mo), de 26€ à 49€/mois avec engagement, 21€ à 44€/mois sans engagement,

- des cartes prépayées de 5 à 75€.

Les forfaits bénéficient tous du report des minutes, et celui-ci a le bon goût de ne pas être limité dans le temps, les minutes non consommées pouvant être reportés plusieurs mois de suite, dans la limite de la durée mensuelle du forfait et les forfaits peuvent être pris avec subventionnement d'un mobile et engagement de 12 ou 24 mois ou sans subvention et sans engagement.

La Poste Mobile s'appuiera sur le réseau de SFR et sera filiale à 50% de La Poste et 50% de SFR et pourrait bien venir perturber sensiblement le marché mobile, en profitant de sa notoriété et de ses nombreux points de vente pour attirer les clients plus efficacement que les autres MVNO, d'autant plus que La Poste prend en charge les frais de résiliation pour les abonnés provenant d'un autre opérateur, à hauteur de 100€.

Posté par Matt le 23/05/2011 à 09h01

Aucun commentaire

Source : Univers Freebox

Depuis quelques jours, le PlayStation Network est petit à petit remis en service, après un moins d'interruption suite au piratage des serveurs. Si la sécurité du réseau a été renforcé, Sony a par contre un peu bâclé le système de réinitialisation des mots de passe, déjà désactivé en raison d'une faille de sécurité...

Pour la remise en service du PSN, Sony oblige les utilisateurs à réinitialiser leur mot de passe, via une page dédiée sur son site. Mais le site Nyleveia a rapidement découvert une faille non négligeable dans ce service : une simple URL modifiée à la main permet d'aller modifier le mot de passe de n'importe quel utilisateur dont on connait l'adresse e-mail et la date de naissance.

Le problème, c'est que l'adresse e-mail et la date de naissance font justement partie des informations qui ont probablement été volées le mois dernier lors du hack du PSN, ce qui donne la possibilité aux hackers de réinitialiser eux même de façon automatisée les mots de passe de tous les utilisateurs... En attendant de sécuriser un peu plus le système, Sony a temporairement désactivé la réinitialisation du mot de passe via le site Internet. Il faudra donc effectuer cette réinitialisation directement à partir de la console.

Posté par Matt le 20/05/2011 à 08h30

Aucun commentaire

Source : Numerama

L'e-paper pourrait bien être amené à remplacer petit à petit le papier pour certains usages, ce qui ne fait pas forcément les affaires des fabricants d'imprimantes. Tout naturellement, Epson s'intéresse donc au papier électronique pour préparer son futur, en collaboration avec E-Ink, le leader du secteur. Une collaboration qui semble porter ses fruits...

En effet, en travaillant de concert, les deux entreprises sont parvenues à mettre au point un nouvel e-paper offrant une résolution très supérieure à l'existant, avec 300dpi contre environ 150dpi pour les e-paper utilisés actuellement, ce qui offre une définition de 2400x1650 pixels pour un écran e-paper de 9.7". C'est deux fois plus précis que l'écran e-paper utilisé par la lecteur Kindle d'Amazon, qui plafonne à 1200x824.

Avec une telle précision, le papier électronique devrait grandement se rapprocher du rendu du papier classique, bon nombre d'imprimantes travaillant par défaut en 300dpi, même si elles sont souvent capables de monter beaucoup plus haut. Epson et E-Ink n'ont par contre pas communiqué sur la date de commercialisation et n'ont indiqué pour l'instant aucun futur produit dont le constructeur envisagerait d'adoption de ces nouvelles dalles.

Posté par Matt le 19/05/2011 à 14h20

Aucun commentaire

Source : Le Journal du Geek

![]()

Quelques jours après l'annonce de la FeRAM chez Texas Instruments, c'est au tour de Panasonic d'annoncer une mémoire RAM non volatile, la ReRAM (Resistive Random Access Memory), qui devrait entrer en production de masse dès l'année prochaine.

Destinée en premier lieu à des appareils pouvant se contenter de faibles quantités de RAM, en raisons de puces limitées à 2 Mbits, cette nouvelle RAM est capable selon son constructeur de conserver des données pendant 10 ans sans alimentation, à des températures allant jusqu'à 85°C.

Côté performances, le gain par rapport à la mémoire flash serait d'un facteur dix, tandis que l'endurance ne diminuerait pas avec l'augmentation de la finesse de gravure. Les ReRAM seront également beaucoup moins gourmandes en énergie que les RAM classiques. Panasonic espère que le recours à la ReRAM permettra de réduire de deux tiers la consommation de certains appareils, comme les téléviseurs.

D'autres constructeurs envisagent aussi de commercialiser des ReRAM, basés sur d'autres technologies. HP envisage par exemple une commercialisation en 2013 pour des ReRAM à base de memristors, tandis que Fujitsu et Numonyx sont aussi sur les rang, sur la base de différents matériaux.

Posté par Matt le 19/05/2011 à 11h00

Aucun commentaire

Source : Tom's Hardware

Prévu pour l'année prochaine, Windows 8 se dévoile petit à petit. On savait déjà depuis quelques temps que le prochaine OS de Microsoft pourrait fonctionner avec un processeur ARM, mais on pouvait se poser des questions sur la compatibilité avec les applications x86 existantes...

Renee James, vice-présidente d'Intel a répondu indirectement à cette question, en dévoilant que le prochain Windows sera bien décliné en quatre versions ARM, mais que celles-ci ne permettront pas d'utiliser les anciens programmes.

La version x86 disposera par contre d'un mode "Windows 7", qui permettra d'assurer la compatibilité avec les applications x86 prévues pour les versions actuelles de Windows, aussi bien en 32 bits qu'en 64 bits. Ceci est bien entendu considéré par Intel comme un gros avantage par rapport à la version ARM, et il est vrai que sans cette rétro-compatibilité, la version ARM pourrait avoir du mal à décoller.

Posté par Matt le 19/05/2011 à 08h40

1 commentaire

Source : Génération NT

En 2010, la Cours de Justice de l'Union Européenne a rendu un arrêt (dit arrêt Padawan) indiquant que, pour être en conformité avec le droit européen, les systèmes de redevance pour la copie privée sur les supports d'enregistrement doivent exempter les supports utilisés par des professionnels. Ce qui n'est pas le cas en France...

Ainsi, s'appuyant sur cet arrêt, le rapporteur du Conseil d'État réclame l'annulation des barèmes de la redevance copie-privée depuis fin 2008. Ceci obligerait les commission copie-privée à une refonte totale du mode de calcul et de l'assiette de la redevance, pour s'assurer du respect des règles européennes.

L'impact pourrait également aller au delà des professionnels, puisque les barèmes pour le grand public devront aussi être revus pour prendre en compte ces nouvelles contraintes et il semblerait que la demande du rapporteur aille dans le sens d'une baisse des tarifs en vigueur.

Le Conseil d'État devrait indiquer dans les semaines à venir (il dispose d'un mois) s'il donne suite à la demande du rapporteur et annule les barèmes en vigueur.

Posté par Matt le 19/05/2011 à 01h03

Aucun commentaire

Source : Univers Freebox

![]()

Filiale de Philips spécialisée dans les puces électroniques, NXP Semiconductors vient de présenter GreenChip, une solution originale permettant de piloter l'éclairage de votre domocile à distance, par exemple depuis un smartphone.

Consommant à peine 50 mW et communicant sans-fil et de façon sécurisée (AES 128 bits) avec un contrôleur central connecté au réseau, la puce est suffisamment petite pour pouvoir être installée dans chaque ampoule. NXP indique qu'il sera ainsi possible de commander l'allumage et l'extinction de chaque ampoule, mais aussi piloter finement le niveau de luminosité, pour personnaliser au mieux l'éclairage.

"Green"Chip oblige, NXP avance bien entendu aussi l'argument de l'économie d'énergie, mais on peut tout de même s'interroger sur ce point. Si le système peut effectivement permettre de grosses économies dans certaines situations, par exemple en éteignant à distance une lampe laissée allumée alors qu'on est parti en vacances, les économies au quotidien ne seront probablement pas bien grandes par rapport à des solutions plus classiques (interrupteurs et variateurs...) et comme souvent avec les produits électroniques "verts", les coûts de production ne sont probablement pas pris en compte dans le bilan...

Posté par Matt le 18/05/2011 à 15h10

Aucun commentaire

Source : Génération NT

Une équipe de chercheurs en sécurité de l'université d'Ulm (Allemagne) a dévoilé une faille majeure de sécurité concernant tous les appareils sous Android 2.3.3 ou antérieur, c'est-à-dire l'écrasante majorité des smartphones Android (99.7% selon Google...).

Lorsqu'elle est exploitée, cette faille permet d'accéder à toutes les données personnelles que l'utilisateur a stockées dans son compte Google. Et malheureusement, les chercheurs expliquent que la faille est assez simple à exploiter. Le problème prévient d'un manque de sécurisation de certaines communications avec les serveurs de Google. Lors de l'accès au calendrier, aux contacts ou encore à Picasa, l'appareil se voit attribuer un jeton d'identification, valable 14 jours, qui est transmis en clair.

Ainsi, il suffit de récupérer ce jeton pour pouvoir ensuite se connecter au compte Google via une autre machine et accéder à toutes les informations qui y sont stockées, en lecture et en écriture. Ce jeton peut être particulièrement simple à récupérer lorsque l'appareil Android est connecté à un réseau Wi-Fi public, puisqu'il suffit alors d'analyser le traffic sur ce réseau pour voir passer le jeton.

Par ailleurs, la faille n'est que partiellement corrigée dans Android 2.3.4 et 3.0 : le jeton est désormais chiffré via une connexion HTTP pour les accès aux contacts et au calendrier, mais reste en clair pour l'accès à Picasa (l'application de synchronisation Android n'a pas été développée par Google).

Google a bien entendu indiqué travailler à la correction définitive du problème, mais il faudra ensuite que les constructeurs de smartphones et opérateurs diffusent les mises à jour, ce qui n'est pas toujours très rapide. Il est donc urgent que Google mette en place des procédures de mises à jour indépendantes de ses partenaires, comme évoqué lors de la Google I/O.

Posté par Matt le 18/05/2011 à 12h30

Aucun commentaire

Source : Clubic

![]()

Depuis que le système de la riposte graduée a été mis en place, l'Hadopi s'appuie sur Trident Media Guard pour la surveillance des réseaux P2P et la collecte des IP en infractions. Mais, en raison de grave manquements de sécurité, des informations personnelles stockées sur un serveur de TMG ont été accessibles publiquement. Une affaire qui fait beaucoup de bruit sur Internet.

En effet, si TMG prétend pour sa défense qu'il s'agissait d'un serveur de test et que la plateforme de production n'a pas été corrompue, on peut tout de même se demander si les IP rendues publiques n'avaient pas été collectées sur les réseaux P2P lors d'une campagne de test. Les informations disponibles permettaient par exemple de connaitre les films téléchargés à partir d'une IP donnée, avec les heures de téléchargement. Pour en avoir le cœur net, la CNIL a ouvert une enquête sur le sujet et a dépêché des agents dans les locaux de TMG pour auditer les systèmes.

De son côté, l'Hadopi a indiqué qu'elle allait elle aussi participer à l'inspection de TMG, en collaboration avec la CNIL et que, en attendant, la liaison avec TMG a été temporairement suspendue, mais que la riposte graduée n'est pas interrompue, l'Hadopi disposant d'une "réserve" d'IP déjà collectées mais dont les propriétaires n'ont pas encore notifiées...

Posté par Matt le 18/05/2011 à 11h10

Aucun commentaire

Sources : Univers Freebox et Génération NT

La semaine dernière, Microsoft faisait sensation en annonçant le plus gros rachat de son histoire, celui de Skype. Selon certains, il se pourrait que le géant du logiciel vise désormais encore plus gros, avec la division téléphones mobiles de Nokia !

En effet, alors que le finlandais s'est beaucoup rapproché de Microsoft depuis qu'il est dirigé par un ancien cadre de Redmond, l'analyste Eldar Murtazin, qui a souvent révélé des informations exactes sur Nokia bien avant leur officialisation, parle désormais de la possibilité que Nokia cède sa division mobile à Microsoft. Rien que ça...

Délaissant le marché grand public, Nokia se contenterait alors de son activité d'équipementier réseau, via sa filiale Nokia-Siemens Networks, tandis que Microsoft pourrait modifier en profondeur sa stratégie sur le marché des smartphones, en devenant à la fois constructeur de téléphones et éditeur d'OS mobiles, peut-être même en réservant son OS à ses terminaux, comme le fait Apple.

Pour l'instant, cette information est démentie par Nokia. Mais ce ne serait pas la première fois qu'une information révélée par Eldar Murtazin serait démentie par Nokia avant d'être finalement officialisée... C'était le cas par exemple pour le passage à Windows Phone et l'abandon de la marque Ovi.

Posté par Matt le 18/05/2011 à 08h22

Aucun commentaire

Source : Smartphone France

Après des années et des années d'attente, les fans de Duke vont bientôt pouvoir reprendre les commandes, avec l'arrivée de Duke Nukem Forever, toujours prévue pour le 10 juin prochain, soit dans un peu moins de quatre semaines. Et les pré-commandes ont été ouvertes.

L'éditeur vient en effet de mettre en ligne une nouvelle vidéo, annonçant avec humour que le jeu est bien terminé et passe actuellement les étapes de validation, et devrait donc bien arriver le 10 juin prochain. Les pré-commandes ont été ouvertes, notamment sur la plateforme Steam, qui offre même déjà une réduction de 10%.

Et pour les plus impatients, une démo jouable sera disponible à partir du 3 juin, mais elle sera réservée à ceux qui auront pré-commandé le jeu auprès d'un des revendeurs partenaires. Mais après les multiples rebondissement qui ont émaillé son développement, mieux vaut peut-être attendre la sortie effective du jeu, on ne sait jamais...

Posté par Matt le 17/05/2011 à 21h47

Aucun commentaire

Source : PCInpact

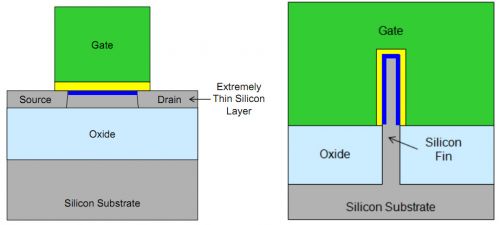

En annonçant il y a quelques jours son intention de passer aux transistors 3D dès la fin de l'année, Intel a surpris beaucoup de monde. Y compris ses concurrents, qui ne sont visiblement pas prêts pour adopter cette évolution aussi rapidement.

Ainsi, TSMC, l'un des plus gros fondeurs du marché, a indiqué qu'il ne serait pas en mesure d'utiliser ces nouveaux transistors avec son processus de gravure 20nm, qu'il prévoit de commercialiser à partir de la fin de l'année prochaine (TSMC travaille actuellement au mieux en 28nm). En effet, si TSMC a déjà réussi à fabriquer des transistors 3D, le fondeur est encore loin d'être capable de les produire en masse, comme le fera Intel pour l'Ivy Bridge.

Et de l'aveu de TSMC, ce n'est pas une question de mois, mais plutôt d'années. Au mieux, le taïwanais envisage pour l'instant la production en masse lorsqu'il lancera son offre de gravure en 14nm, une finesse qui devrait arriver dans trois ou quatre ans.

Posté par Matt le 17/05/2011 à 12h50

Aucun commentaire

Source : Tom's Hardware

En partenariat avec MyID.is Certified, La Poste vient de lancer l'expérimentation de son projet Identic, qui vise à fournir aux particuliers une identité numérique certifiée, leur permettant ensuite de se connecter aux sites partenaires avec un couple identifiant/mot de passe unique.

Expérimenté dans le département de l'Essonne, le service nécessite un enregistrement sur le site dédié. Pour s'enregistrer, il faudra fournir ses nom, prénom et date de naissance, payer 6€ avec une carte de paiement à son nom et indiquer son adresse postale.

Afin de valider l'identité, La Poste effectue deux contrôles. Tout d'abord, une somme aléatoire inférieure à 2€ sera recréditée sur la carte ayant servi au paiement, et l'utilisateur devra saisir le montant exact crédité dans l'interface de gestion de l'identité. Dans un second temps, un code d'activation sera envoyé au titulaire par courrier recommandé, avec une remise en main propre, sans possibilité de procuration. L'identité numérique certifiée sera alors valable pour une durée de six mois.

Reste à voir si le service connaitra un réel succès, alors que beaucoup préfèrent conserver un certain anonymat sur Internet. Pour l'instant, seule le site de petites annonces trefle.com reconnait ces identités numériques, ce qui risque de ne pas beaucoup aider pour le succès.

Posté par Matt le 17/05/2011 à 10h51

Aucun commentaire

Source : Génération NT

Depuis le piratage du réseau PlayStation Network, le service en ligne de Sony était inaccessible, et le nippon travaillait d'arrache pied pour le rétablir. Le réseau donne depuis quelques heures ses premiers signes de vie, mais ne semble pas totalement sorti de l'auberge...

En effet, les premiers témoignages d'utilisateurs semblent indiquer que le réseau n'a fait qu'un bref retour, avant de repasser "en maintenance". Le réseau n'aurait en fait fonctionné que pendant une dizaines de minutes. Sony invite, encore une fois, les utilisateurs à patienter, et justifie ce nouveau contre temps par le grand nombre de demandes de réinitialisation de mots de passe effectuées dès que le service a été remis en route.

Pour compliquer un peu les choses pour Sony, le gouvernement japonais serait particulièrement exigeant sur les nouvelles procédures de sécurité visant à garantir la confidentialité des données à l'avenir. Et tant que ces exigences ne seront pas satisfaites, Sony ne sera pas autorisé à rétablir le PlayStation Network au Japon. D'autres pays asiatiques auraient également imposé leurs conditions, et Sony indique être en discussion avec eux.

Posté par Matt le 17/05/2011 à 08h14

Aucun commentaire

Sources : Übergizmo

![]()

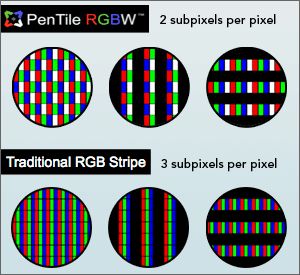

Samsung va prochainement faire la démonstration d'une nouvelle dalle de 10.1", principalement destinée au marché des tablettes, qui affiche une définition particulièrement impressionnante : 2560x1600 (WQXGA). Elle affichera donc autant de pixels qu'un écran classique de 30".

Pour arriver à une telle densité de pixels (300 dpi), Samsung a toutefois un peu triché, comme elle l'a déjà fait avec certaines dalles LCD et AMOLED (le Super AMOLED est par contre épargné) pour smartphones (Motorola Atrix 4G, Nexus One...). En effet, plutôt que de couvrir la dalle de pixels tous identiques et composés de trois sous-pixels (rouge/vert/bleu), la dalle comporte deux types de pixels, chacun composé de deux sous pixels : bleu/blanc ou rouge/vert (pour le Nexus One, il s'agissait de bleu/vert et rouge/vert).

Baptisée PentTile RGBW, cette technologie permet, selon Samsung, d'obtenir une plus grande luminosité à consommation égale (ou une baisse de consommation de 40% à luminosité égale). Mais ceci se fait au détriment de la précision de l'écran, puisque l'écran n'est pas capable de rendre la couleur exacte de chaque pixel, et fait donc des interpolations en jouant sur les couleurs des pixels adjacents, un peu comme si la résolution de l'écran était divisée par deux dans l'une des dimensions.

En pratique, la qualité d'image devrait se situer entre celle des écrans classique à "faible résolution" (environ 150 dpi), tout en restant inférieure à celle des écrans très haute résolution, comme ceux utilisés par Apple sur ses iPhone et iPod Touch (environ 300 dpi, mais avec trois sous-pixels par pixel).

Posté par Matt le 16/05/2011 à 14h57

Aucun commentaire

Source : Tom's Hardware

Lundi prochain, La Poste va diversifier son activité, en devenant opérateur mobile virtuel. Dès aujourd'hui, les employés de La Poste peuvent souscrire aux futures offres, ce qui donne un premier aperçu de ce à quoi on peut s'attendre pour le 23 mai.

Comme chez la plupart des opérateurs et MVNO, la gamme sera divisée en quatre groupes d'offres :

- des forfaits bloqués offrant 45min à 1h30 de voix, 60 SMS (illimités dès le forfait 1h) et 200 Mo de data sur les deux forfaits les plus haut de gamme,

- des forfaits classiques, de 30min à 4h sans SMS ni data (les forfaits 2h et 4h disposeront au début des SMS illimités, mais il s'agit d'une offre de lancement). Des options permettront d'ajouter des SMS illimités et de la data illimités (fair use de 500 Mo),

- des forfaits tout compris avec 2 à 10h de voix, SMS illimités, data illimitée (fair use 500 Mo),

- des cartes prépayées de 5 à 75€.

Les forfaits bénéficient tous du report des minutes, et celui-ci a le bon goût de ne pas être limité dans le temps, les minutes non consommées pouvant être reportés plusieurs mois de suite, dans la limite de la durée mensuelle du forfait et les forfaits peuvent être pris avec subventionnement d'un mobile et engagement de 12 ou 24 mois ou sans subvention et sans engagement. Les tarifs de l'offre postier sont plutôt agressifs, avec un premier prix à 8€ pour le forfait 30min sans mobile à 39€20 pour le forfait 10h/SMS/data avec mobile subventionné. Attention toutefois, il s'agit sans doute de tarifs réduits pour les employés, donc on peut s'attendre à des offres un peu plus chères pour le grand public.

La Poste Mobile s'appuiera sur le réseau de SFR et pourrait bien venir perturber sensiblement le marché mobile, en profitant de sa notoriété et de ses nombreux points de vente pour attirer les clients plus efficacement que les autres MVNO.

Posté par Matt le 16/05/2011 à 12h18

2 commentaires

Source : Freenews

Alors que Chrome OS va très bientôt arriver sur le marché, on en apprend un peu plus sur le modèle économique choisi par Google. Ainsi, en plus des netbooks sous Chrome OS ("Chromebooks"), prévu depuis fort longtemps, la Google I/O a été l'occasion de dévoiler aussi des nettops sous ce nouvel OS ("Chromebox").

Comme pour les Chromebooks, Samsung serait sur les rang pour lancer ce type d'appareil, le Coréen étant à l'origine du boîtier présenté à la Google I/O. Google n'a toutefois dévoilé aucun détail supplémentaire sur l'appareil. Il y a toutefois fort à parier que la configuration soit très similaire à celle des Chromebooks, l'écran et la batterie en moins...

Par ailleurs, Google a indiqué qu'il ne distribuerait pas Chrome OS. Cela signifie donc qu'il sera impossible pour le grand public de se procurer une image du système à installer sur sa propre machine, il faudra obligatoirement passer par une des machines distribuées officiellement avec Chrome OS. Il restera par contre possible d'obtenir une image de Chromium OS, la base open-source du système, mais il manquera alors probablement quelques fonctionnalités.

Posté par Matt le 16/05/2011 à 11h11

2 commentaires

Sources : Le Journal du Geek

Les mots de passe finiront-ils par devenir totalement "has-been" ? On connaissait déjà les solutions alternatives basées sur des cartes à puce ou des lecteurs d'empreintes digitales, et c'est désormais à la reconnaissance d'iris de devenir accessible à tous, grâce à l'EyeLock d'Hoyos.

Connecté par USB et doté d'un capteur photo, l'EyeLock vous permettra de scanner votre iris, et d'utiliser sa signature à la place des mots de passe. Le logiciel livré avec l'appareil vous permettra ainsi de vous identifier sur vos sites préférés grâce à ce système, sans avoir à retenir vos identifiants. Il sera vendu moins de 100$, ce qui reste cher compte tenu de l'usage, mais le rend tout de même accessible au grand public.

Selon le constructeur, un tel système est beaucoup plus fiable qu'une identification par les empreintes digitales, car il utilise plus de cent fois plus de points d'identification pour vérifier la correspondance entre l'iris scanné et l'iris de référence enregistrée par l'utilisateur. Hoyos va jusqu'à affirmer que le système est impossible à pirater/

Posté par Matt le 16/05/2011 à 08h51

2 commentaires

Source : Clubic

En mars dernier, Googla annonçait son intention d'abandonner Gears au profit du HTML5. Une décision qui n'était pas sans conséquence, puisque faute de solution alternative, l'abandon de Gears mettait un terme au mode hors-ligne des services de Google. Google promettait alors une solution équivalente basée sur HTML5, mais sans indiquer de date.

Mais avec l'arrivée prochaine des premières machines sous Chrome OS, le retour de ce mode déconnecté devient indispensable. En effet, en l'absence de mode déconnecté, ces machines n'utilisant que des applications web, elles deviennent inutilisables dès lors que la connexion Internet est coupée. Un gros défaut qui ne faciliterait pas leur ventes...

Google a donc travaillé sur l'implémentation d'un mode déconnecté, en priorité pour Gmail, Agenda et Docs. En test en interne depuis quelques mois déjà, cette solution sera normalement déployée dans le courant de l'été, pour permettre de lire ses mails, travailler sur ses documents bureautique ou encore consulter son agenda même lorsque la connexion est indisponible.

Posté par Matt le 13/05/2011 à 15h00

Aucun commentaire

Source : Clubic

Depuis 2009, Apple a mis en place sur les disques durs de ses iMac un câble permettant d'interroger la sonde de température interne du disque dur et de réguler ainsi la vitesse des ventilateurs, ce qui n'était pas sans poser quelques problèmes pour remplacer le disque. Mais ce n'était qu'un début...

En effet, il était à l'époque assez facile de contourner le problème. Si le câble, spécifique à chaque marque de disque dur, n'était pas connecté, le ventilateur passait automatiquement à sa vitesse maximale, mais il suffisait de court-circuiter ce câble pour que le ventilateur retrouve un régime acceptable pour les oreilles de l'utilisateur. Il restait donc tout a fait possible de remplacer le disque dur par un autre modèle.

Sur les iMac de 2011, dévoilés il y a deux semaines, c'est un autre paire de manches... Tout d'abord, Apple a modifié l'alimentation des disques durs. Le connecteur d'alimentation SATA standard comporte quinze broches, mais seules quatre sont normalement utilisées pour alimenter les disques durs. Apple en utilise désormais sept, les trois broches supplémentaires servant à interroger la sonde de température, à la place du câble supplémentaire qui était utilisé sur les précédents iMac. Mais ça ne s'arrête pas là : en plus d'une connectique non standard, les disques durs des iMac, bien qu'ils utilisent des mécaniques tirés des catalogues officiels de grands constructeurs de disques durs, sont dotés de firmware spécifiques Apple. Dès lors que ce firmware n'est pas reconnu, le ventilateur de l'iMac tournera à pleine vitesse, même si le disque dur porte la même référence constructeur que celui d'origine...

Le fabricant de SSD OWC, qui a révélé le problème sur son site Internet travaille activement à une solution de contournement, pour que les propriétaires d'iMac de dernière génération puissent les doter de leurs SSD sans sacrifier leurs oreilles... Si aucune solution n'est trouvé, ce bridage risque de poser de sérieux problèmes en cas de panne du disque dur hors garantie. En effet, l'utilisateur aura alors le choix entre remplacer le disque dur lui même pour un prix raisonnable, mais se retrouver avec une machine très bruyante, ou faire réparer la machine à grand frais par un technicien Apple...

Posté par Matt le 13/05/2011 à 12h39

1 commentaire

Source : MacGénération

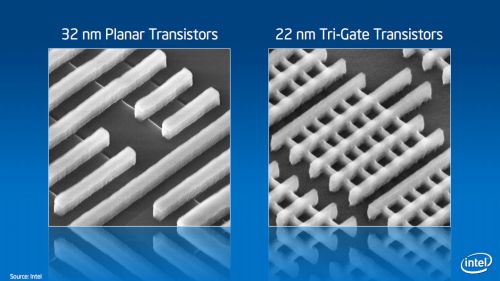

Présentée la semaine dernière par Intel, la technologie Tri-Gate sera utilisée dès 2012 pour ses processeurs Ivy Bridge. Grâce à sa basse consommation, elle pourrait aussi relancer les processeurs Atom, qui devraient en bénéficier à partir de 2013.

En effet, selon CNet, la plateforme Atom Silvermont, qui sera gravée en 22nm et est prévue pour 2013 devrait bien adopter cette nouvelle technologie de gravure. Elle prendra la forme d'un SoC intégrant le CPU, la connectique et la puce graphique. Elle succédera à la plateforme Cedar Trail, gravée en 32nm, qui devrait être lancée dans le courant de l'année.

La baisse de consommation permise par la technologie Tri-Gate devrait permettre à cette plateforme de venir sérieusement concurrencer les produits basés sur l'architecture ARM dans le secteur des smartphones et des tablettes tactiles, tout en permettant des gains d'autonomie sur le secteur des netbooks, où l'Atom est déjà très bien implanté.

Posté par Matt le 13/05/2011 à 10h58

Aucun commentaire

Source : Generation NT

Annoncé il y a bientôt deux ans, Chrome OS va enfin arriver sur le marché dans les semaines à venir, avec un lancement prévu pour le 15 juin aux États-Unis et dans six pays d'Europe de l'Ouest. Comme prévu depuis plusieurs mois, c'est Acer et Samsung qui dégaineront les deux premiers "Chromebooks" équipés de cet OS.

Pour rappel, Chrome OS est un OS entièrement tourné vers le web. Extrêmement léger, pour permettre un démarrage très rapide (Google promet moins de huit secondes pour démarrer), l'OS confie toute son interface graphique au navigateur web Chrome, et toutes les applications seront donc des applications web, distribuées via le Chrome Web Store, lancé il y a quelques mois déjà.

Côté matériel, les deux Chromebooks d'Acer et Samsung seront dotés d'un écran 11.6", d'un processeur Atom double cœur, d'une webcam HD, de deux ports USB et d'un lecteur de cartes mémoire 4 en 1, du Wi-Fi, d'un trackpad cliquable (similaire à ce que propose Apple sur ses Macbook) et d'un clavier Google Chrome (qui se distingue d'un clavier classique par sa touche Verr. Maj. remplacé par une touche recherche, par l'absence de touches entre les touches Ctrl. et Alt. et par la disparition des touches F*, remplacées par des raccourcis pour certaines fonctions de l'OS). Le modèle Acer offrira six heures d'autonomie et une sortie HDMI pour un poids de 1.34 kg et sera vendu 349$ en version Wi-Fi. Côté Samsung, l'autonomie sera supérieure (8h30), mais le HDMI cédera sa place au VGA et le poids atteindra 1.48 kg. La machine sera proposé à 429$ en version Wi-Fi et 499$ en version Wi-Fi + 3G.

Pour les entreprises et les établissements scolaires, Google proposera aussi ces machines en location, respectivement pour 28 et 20$ par mois. Cette location permettra de remplacer le matériel au fil des évolutions, tandis que Google fournira une interface d'administration permettant de contrôler certains paramètres sur l'ensemble du parc.

Posté par Matt le 13/05/2011 à 08h37

5 commentaires

Source : Tom's Guide

![]()

Depuis quelques jours, le buzz de "La Révolution Mobile" montait progressivement, annonçant d'abord un forfait mobile tout illimité à moins de 50€, puis à moins de 35€... Rapidement, les soupçons sur l'origine de cette "révolution" s'étaient tourné vers Numericable, même si la communication aurait pu faire penser à Free (dont les avocats ont d'ailleurs réagit rapidement...). Mais l'annonce officielle est finalement assez loin des promesses...

En effet, si Numericable a bel et bien lancé un forfait tout "illimité" (appels, data et SMS "illimités", mais avec les limitations classiques en nombre de correspondants, durée d'appel, débit...) à seulement 25€ par mois, ce tarif nécessite d'être aussi abonné chez Numericable pour l'accès Internet fixe et de s'engager sur 24 mois (aussi bien pour le mobile que pour l'accès Internet), et ce tarif n'inclus pas de subvention sur l'achat d'un mobile.

Avec un engagement sur 12 mois, le tarif passe à 30€ par mois, tandis que l'abonnement mobile seul sera facturé 50€ par mois avec un engagement de 24 mois s'il n'est pas couplé à un abonnement Internet fixe. Dans ce cas, il faudra de plus s'acquitter de frais d'ouverture de ligne d'un montant de 50€ (soit l'équivalent de 2€ mensuels en plus sur un engagement de 24 mois...) Un tarif assez proche de ceux d'autres MVNO. Côté réseau, c'est sans surprise celui de Bouygues Telecom qui sera mis à disposition, les deux opérateurs étant déjà liés, puisque Bouygues exploite le réseau Numericable pour son offre d'accès Internet fixe.

Posté par Matt le 12/05/2011 à 14h40

Aucun commentaire

Source : Tom's Guide

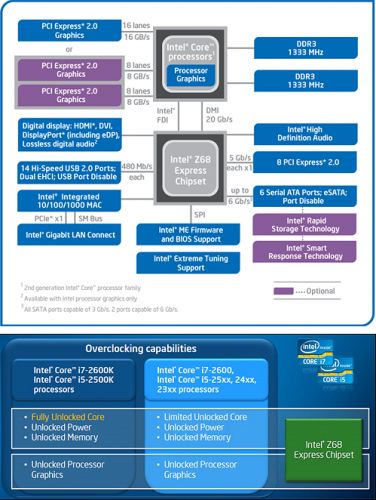

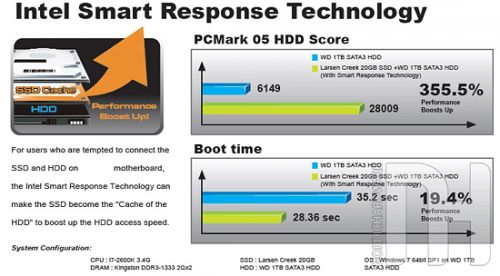

Chipset le plus haut de gamme de la plateforme Sandy Bridge sur socket LGA1155, le Z68 Express a été lancé officiellement aujourd'hui. Il combine les spécificités du H67 (exploitation de l'IGP des Sandy Bridge) et celles du P67 (possibilités d'overclocking avancées), tout en apportant quelques nouveautés.

La plus importante est l'Intel Smart Response Technology, qui va permettre de monter un système de stockage hybride, couplant un petit SSD très performant de quelques Go à un disque dur, pour bénéficier à la fois d'une grande capacité de stockage et de performances élevées. Avec le SSD Intel 311, spécialement prévu pour cet usage et doté de 20 Go de mémoire MLC, Intel annonce des gains pouvant aller jusqu'à 20% sur le temps de démarrage de la machine. Malheureusement, SLC oblige, ce SSD sera très coûteux, puisqu'il est annoncé à 120$... Pour le même prix, on trouve sans problème des SSD de 60 Go en MLC, qui pourraient offrir de meilleurs résultats grâce à leur capacité accrue.

Autre fonctionnalité intéressante, le Z68 supporte la technologie Virtu de Lucid Logix, qui permet de basculer à la volée la gestion de l'affichage entre l'IGP et une carte graphique dédiée en fonction de l'application utilisée. Il devient ainsi possible de profiter de QuickSync pour l'encodage vidéo, tout en ayant de la puissance 3D sous la pédale. L'écran pourra être physiquement connecté soit à l'IGP (IGP utilisé par défaut, carte graphique pour les applications reconnues par Virtu, baisse de performances 3D de 5 à 10% à cause du transfert des images calculées vers l'IGP) soit à la carte graphique (IGP utilisé uniquement dans les applications reconnues par virtu, pas de baisse des performances 3D).

Par rapport au P67, profiter de ces fonctionnalités supplémentaires devrait se traduire par un surcoût de 10 à 30€ sur l'achat de la carte mère, auxquels ils faudra ajouter le prix d'un SSD pour utiliser l'Intel RST. Reste à voir si le surcoût est vraiment justifié par les gains en pratique, ce qui est loin d'être certain...

Posté par Matt le 12/05/2011 à 12h37

Aucun commentaire

Source : Hardware.fr

Ces dernières semaines, on a beaucoup entendu parler du vol de données personnelles et bancaires suite au piratage du PlayStation Network. C'est désormais au tour de Facebook de faire les frais d'une faille de sécurité...

En effet, selon Symantec, une faille de sécurité permettrait à n'importe quelle application Facebook de récupérer toutes les données privées de tous les utilisateurs qui ont installé une des 100 000 applications touchées par la faille de sécurité. Pire, la faille permet même de prendre le contrôle sur le mur de l'utilisateur, en y postant des messages en son nom.

Si Facebook a bien reconnu et corrigé le problème, le réseau social tente toutefois d'en minimiser l'impact, en indiquant qu'il n'y a aucune preuve que des données ont été exploitées ainsi (en l'absence de preuve, Sony avait préféré indiquer qu'il y avait un risque que des données aient été volées...), et que les développeurs d'applications et annonceurs sur le réseau Facebook sont tenus par contrat à ne pas obtenir et exploiter des données personnelles obtenues par un moyen ne respectant pas les règles d'utilisation de Facebook... Une bien maigre protection donc...

Bien que la faille soit corrigée, Symantec recommande tout de même aux utilisateurs de changer leur mot de passe, afin d'invalider les clés d'accès aux données personnelles que certaines applications auraient pu obtenir de façon illégitime.

Posté par Matt le 12/05/2011 à 11h00

1 commentaire

Source : 01Net

Avec la multiplication des radars automatiques d'un côté et l'explosion du nombre de GPS et de smartphones de l'autre, est apparu un marché très lucratif : celui des avertisseurs de radar basés sur la localisation GPS. En effet, si les détecteurs de radars ont toujours été interdits, ce n'est pas le cas de ces avertisseurs, basés sur la connaissance de la position des radars, et non pas sur leur détection dynamique. Ou plutôt, ce n'était pas le cas...

En effet, alors que les premiers chiffres de la délinquance routière pour 2011 ne sont pas satisfaisants, le gouvernement a adopté hier de nouvelles mesures visant à réduire ces chiffres. Outre le retrait de 8 points pour un taux d'alcoolémie supérieur à 0.8 g/ℓ, le gouvernement a décidé de mettre un terme aux avertisseurs de radars.

Désormais, tous les dispositifs visant à prévenir de la présence d'un radar seront interdits, quelque soit la technique de "détection" utilisée, et quelque soit l'appareil sur lequel ils fonctionnent. Si les spécialistes du GPS, comme TomTom ou Navigon ne devraient pas être trop affectés par cette mesure, puisqu'ils auront juste à désactiver cette fonction dans leurs produits, les sociétés spécialisés dans les avertisseurs risquent par contre de très mal accueillir la nouvelle, qui signifie la fin de leur activité en France. Plusieurs d'entre elles ont d'ailleurs annoncé une conférence de presse commune. La carte des radars fixe, qui était visible sur le site du Ministère de l'Intérieur a par ailleurs été supprimée, et les panneaux signalant les radars automatiques devraient connaitre le même sort.

Reste à voir en pratique comment la présence de tels avertisseurs sera vérifiée. En effet, s'il est facile lors d'un contrôle de vérifier que le véhicule ne contient pas un boîtier avertisseur dédié, il sera bien plus compliqué de vérifier les GPS, et, encore plus, les smartphones... Et avant leur disparition, on constate d'ailleurs une forte hausse des ventes des applications d'avertissement radar sur l'App Store...

Puisqu'on parle de smartphone, notez aussi que l'usage du téléphone au volant sera désormais puni bien plus sévèrement : de 22€ d'amende et 1 point retiré, on passe à 135€ et 3 points. Il faut dire que selon les statistiques, l'usage du téléphone portable au volant serait responsable d'un accident sur dix sur les routes française. Ceci concerne toutefois uniquement l'utilisation du téléphone à la main. Les sanctions pour l'utilisation d'un téléphone avec kit mains-libres, un temps évoqué, n'ont finalement pas été retenues.

Posté par Matt le 12/05/2011 à 09h06

Aucun commentaire

![]()

Free a publié ce soir deux nouveaux firmwares pour ses boîtiers Freebox Server (1.0.5.1) et Freebox Player (1.0.4.1). Il s'agit de mises à jour mineures, corrigeant quelques uns des bugs signalés sur le bugtracker de Freeplayer.org.

Freebox Server

Corrections

- Disque dur externe non reconnu depuis la 1.0.5.

Améliorations

- Support des fichiers compressés en NTFS.

Freebox Player

Corrections

- Type de fichier non reconnu dans l’explorateur pour les sous-titres.

- Sous-titres non pris en charge lorsqu’ils ne sont pas encodés en UTF-8.

- Sous-titres non pris en charge a la racine du menu « Mes Vidéos ».

- Boutons vert et rouge non fonctionnels dans le lecteur Blu-ray.

- Support des TV avec EDIDs invalides dans le lecteur Blu-ray.

- Disque dur externe non reconnu depuis la 1.0.4.

Améliorations

- Support des fichiers compressés en NTFS.

- Support des tags HTML pour les sous-titres.

Posté par Matt le 11/05/2011 à 23h58

Aucun commentaire

Sources : L'actualité de la Freebox

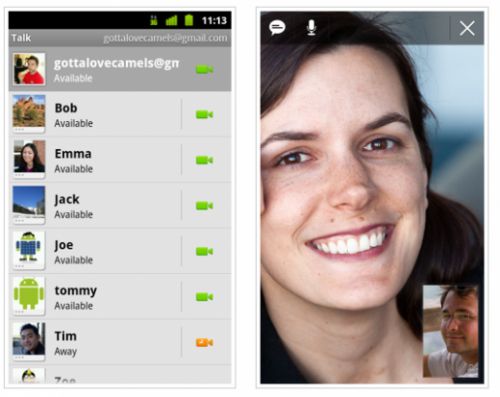

Si Google Music a été présenté durant la keynote d'ouverture de la Google I/O, c'est loin d'être le seul sujet à avoir été traité, et, une fois de plus, c'est Android qui a eu les honneurs, avec de nombreuses annonces, et pas des moindres !

Commençons par les chiffres annoncés par Google : la barre des 100 millions d'appareils activés a été franchie, grâce à 36 constructeurs et 215 opérateurs mobiles. Le rythme d'activation est actuellement de 400 000 appareils par jour. Côté applications, 450 000 développeurs ont été recensés, pour un total d'environ 200 000 applications sur l'Android Market. 4.5 milliards de téléchargements ont déjà été effectués, donc 1 milliard pendant ces deux derniers mois. Apple n'a qu'à bien se tenir !

Côté nouveauté, on notera le lancement d'Android 3.1, qui garde le nom d'Honeycomb. Cette première mise à jour du système pour tablettes est disponible immédiatement pour les propriétaires de la Motorola Xoom en version Verizon. Elle apporte quelques évolutions de l'interface graphique et un support plus larges des périphériques USB, avec notamment la gestion des manettes Xbox 360 USB. Cette version sera également utilisé pour les boîtiers Google TV.

L'autre grosse annonce est celle d'Ice Cream Sandwich, une future version d'Android qui vise à réunifier les deux branches actuelles du système, avec une version unique pour les smartphones, les tablettes, les netbooks, etc... Ceci devrait simplifier la vie des développeurs, qui auront moins de version à gérer, d'autant plus que Google planche aussi sur un plan, déjà approuvé par plusieurs grands constructeurs, pour obliger les fabricants de matériel à fournir les nouvelles versions d'Android aux appareils existants pendant une durée d'au moins 18 mois, ce qui devrait favoriser la diffusion des nouvelles versions, et surtout, éviter que des anciennes versions trainent trop longtemps dans le parc installé...

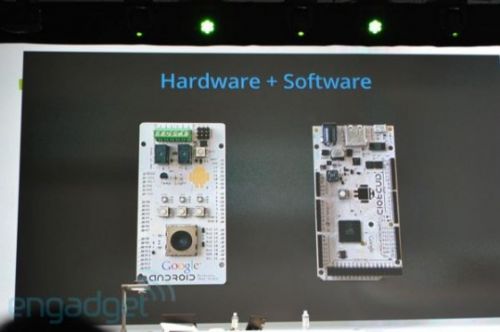

Enfin, Google semble bien décidé à étendre l'écosystème Android au delà de l'OS et des applications, avec le lancement d'une nouvelle API, l'Android Open Accessory Development Kit qui, comme son nom l'indique, va permettre de réaliser des accessoires pour Android, mais aussi des drivers pour de nombreux produits existants, l'API gérant les périphériques USB et, prochainement, les périphériques Bluetooth. Google fournira également une plateforme de test matérielle pour le développement de ces accessoires.

Posté par Matt le 11/05/2011 à 14h47

Aucun commentaire

Source : Le Journal du Geek

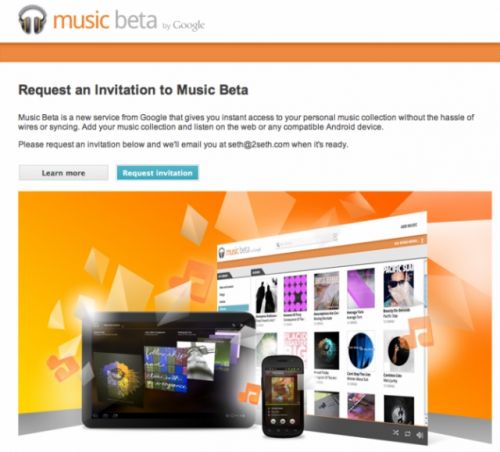

Les rumeurs ne se sont pas trompées, Google avait bien dans ses cartons un service de musique en ligne. Et comme les dernières rumeurs l'annonçaient, ce service sera dans un premier temps un simple espace de stockage en ligne avec possibilité de lire la musique en streaming, faute d'accord avec les majors pour vendre de la musique.

Ouvert uniquement aux États-Unis pour l'instant, et sous forme de beta privée sur invitation, comme Gmail en son temps, Google Music permettra aux utilisateurs de stocker jusqu'à 20 000 titres musicaux, puis à les écouter en streaming depuis un navigateur web ou le lecteur de musique de n'importe quel appareil Android.

Le service serait pour l'instant gratuit, mais on ne sait ni si cette gratuité sera conservée après la phase de beta, ni à partir de quand le service sera disponible en dehors des États-Unis.

Posté par Matt le 11/05/2011 à 12h11

Aucun commentaire

Source : Macbidouille

![]()

Suite à l'affaire des données de localisation stockées par les appareils iOS et Android, la Cnil a cru bon de rappeler quelles sont les règles concernant en vigueur en France concernant ce genre de données. L'occasion aussi pour le consommateur de connaitre ses droits. Un rappel qui concerne à la fois les base de données de hot-spots Wi-Fi et les données de localisation des appareils mobiles.

Concernant les hot-spots Wi-Fi :

- la Cnil considère qu'un SSID peut être considéré comme une donnée à caractère personnel, et les bases de données de SSID doivent donc être déclarées à la Cnil si elle a été constituée à partir de données collectées automatiquement par des appareils mobiles ou des véhicules,

- il n'est pas nécessaire d'informer les propriétaires des hot-spots,

- les propriétaires de hot-spots doivent pouvoir s'opposer à la collecte des informations sur leur hot-spot,

- les données de localisation associées à un hot-spot ne devraient pas être conservées plus de cinq ans.

Concernant les localisation des appareils mobiles :

- les éventuels identifiants uniques associés à un appareil lors de requêtes à une base cartographique doivent être aléatoires et conservés au maximum 24 heures. Si une raison valable nécessite de les conserver plus longtemps, l'utilisateur doit donné son accord. L'identifiant ne doit pas être associé à un identifiant de l'utilisateur ou de l'appareil,

- les utilisateurs doivent être clairement informés de tous les traitements effectués sur les données collectées et sur leurs droits relatifs à ces données,

- les utilisateurs doivent pouvoir effacer les données les concernant, quelque soit leur lieu de stockage.

Posté par Matt le 11/05/2011 à 10h30

Aucun commentaire

Source : Universfreebox

![]()

Depuis quelques temps, des rumeurs indiquaient que Skype était à vendre. Parmi les acheteurs évoqués, Google, Facebook, Apple, Microsoft... C'est finalement Microsoft qui a annoncé hier avoir conclu l'affaire, pour la coquette somme de 8.5 milliards de dollars, payés cash !

Redmond met ainsi la main sur l'un des outils de communication les plus utilisés du monde, ce qui pourrait contribuer à le relancer sur ce marché, où ses outils, comme MSN, sont plutôt en perte de vitesse. Skype devrait devenir la pièce centrale des outils de communication de Microsoft, puisque c'est carrément une nouvelle division du géant qui a été crée pour accueillir le nouvel arrivant, avec à sa tête Tony Bates, l'actuel PDG de Skype.

Microsoft a profité de la conférence de presse pour dévoiler quelques chiffres sur la plateforme Skype, qui montrent bien son importance capital dans le secteur de la communication sur Internet :

- 170 millions d'utilisateurs actifs (+40% sur un an),

- 600 000 nouveaux utilisateurs par jour,

- 207 milliards de minutes de conversation en 2010 dont plus de 40% en vidéo,

- 30 millions d'utilisateurs connectés en simultané,

- 860 millions de dollars de chiffre d'affaire (+20% sur un an) et 264 millions de dollars de bénéfice (+40%).

Ce rachat va aussi permettre l'arrivée de Skype sur tous les produits Microsoft, et en particulier la Xbox 360 et Windows Phone 7, qui n'avaient pour l'instant pas droit à ce service. Espérons par contre que les clients Skype ne vont pas disparaitre d'autres plateformes plus "gênantes" pour Microsoft, comme Linux ou iOS. Le rachat devant encore être validé par les autorités de contrôle de la concurrence, il y a des chances que Microsoft prenne des engagements sur ce point, afin de s'assurer que l'opération ne sera pas bloquée.

Posté par Matt le 11/05/2011 à 08h52

Aucun commentaire

Source : Numerama

Alors que les dernières études montrent que la part de marché d'nVidia sur les puces graphiques PC est en chute libre, la firme au caméléon semble considérer de plus en plus que son avenir repose sur les plateformes mobiles à base de processeurs ARM.

En effet, la stratégie du spécialiste du GPU se recentre de plus en plus sur ces plateformes. Après le succès de la plateforme Tegra 2, qui est, et de loin, la plus utilisée dans les tablettes sous Android 3.0 et l'annonce de futurs processeurs ARM 64 bits hautes performances et de la plateforme mobile Tegra 3, le constructeur souhaite visiblement proposer une offre encore plus complète, en s'offrant Icera, qui produit des puces 3G et 4G et dispose d'un large portefeuille de brevets.

Avec cette acquisition, qui a coûté 367 millions de dollars à nVidia, le caméléon devrait être en mesure de produire des puces baseband, entrant ainsi sur un marché de près de 20 milliards de dollars, mais probablement aussi de lancer de nouvelles versions de Tegra intégrant le baseband. De quoi venir concurrencer directement le SoC Snapdragon de Qualcomm, qui intègre lui aussi le baseband.

Grâce à ce rachat, nVidia espère doubler son chiffre d'affaire sur les plateformes pour smartphones et tablettes.

Posté par Matt le 10/05/2011 à 14h08

Aucun commentaire

Source : Clubic

Parmi les nombreuses sources d'énergie alternative qui se développent, en voici une fort originale : l'utilisation du bruit pour produire de l'électricité. C'est ce que promettent certains chercheur, en mettant à profit les nanotechnologies.

Pour arriver à ce résultat, les chercheurs ont mis au point un dispositif consistant en une fine lamelle de zinc placée entre deux électrodes. Lorsqu'un son atteint la lamelle, les efforts mécaniques induisent un courant électrique. Mieux, le son est en partie absorbée (principe de base de la physique, si de l'énergie sonore est convertie en électricité, l'énergie sonore restante diminue forcément), ce qui permet d'envisager par exemple la construction de murs anti-bruit producteur d'électricité à installer le long des autoroutes.

Mais avant d'envisager une industrialisation du procédé, il faudra d'abord parvenir à améliorer son rendement, pour qu'il soit rentable. En effet, les appareils actuels ne produisent qu'une tension de 50 millivolts à partir d'un son de 100 dB. Les chercheurs espèrent toutefois améliorer ce rendement en utilisant d'autres matériaux.

Posté par Matt le 10/05/2011 à 12h49

1 commentaire

Source : Clubic

Depuis quelques années, le GPGPU, qui consiste à faire effectuer des calculs non graphiques par les GPU, s'est petit à petit répandu dans les domaines où une forte puissance de calcul est nécessaire, comme l'encodage vidéo ou le calcul scientifique. Avec le projet KGPU, le GPGPU pourrait trouver sa place au cœur même du système...

En effet, le noyau est parfois amené à effectuer des opérations complexes, comme par exemple du chiffrement AES pour assurer la sécurité des données. C'est sur ce genre de routines que le projet KGPU travaille, pour intégrer le GPGPU dans le noyau Linux. Sur les procédures de chiffrement du système de fichier, le gain de performances atteindrait d'ores et déjà un facteur de 3 à 4 sur une machines à base de Core i7 930 2.8 GHz et de GeForce GTX 480.

Le projet est bien entendu open source, mais par contre, les développeurs ont pour l'instant fait le choix de l'interface de programmation GPGPU propriétaire CUDA, ce qui le limite aux GPU nVIdia.

Posté par Matt le 10/05/2011 à 10h21

Aucun commentaire

Source : Tom's Hardware

Très attendue, la mémoire de type Ferroelectric Random Access Memory (FRAM ou FeRAM) vient enfin de se concrétiser, grâce à Texas Instruments, qui a annoncé la commercialisation des premiers modules de cette mémoire du futur.

Exploitant le magnétisme de cristaux à base de fer au lieu de charges électriques utilisées par les autres types de RAM et les mémoires flash, les FRAM sont très prometteuses : très peu sensibles aux perturbations, elles offrent des taux d'erreur exceptionnellement bas, tout en étant non volatiles et bien plus performantes que les autres mémoires non volatiles, y compris la mémoire flash, qui équipe la plupart des SSD d'aujourd'hui. Le facteur de performance par rapport aux mémoires flash serait de 100, ce qui permet d'utiliser ces mémoires pour le stockage de masse, mais aussi comme RAM.

Elles sont également bien moins gourmandes en énergie que les mémoires flash, avec à peine 100µA/MHz (contre trois fois plus pour la flash) et intègrent une réserve d'énergie permettant de terminer les opérations d'écriture lorsque l'alimentation est coupée, évitant ainsi des pertes de données. Enfin, ces mémoires sont aussi particulièrement endurantes. Alors que les mémoires flash supportent de moins en moins de cycles d'effacement au fil de l'augmentation de la finesse de gravure (les dernières générations ne supportent plus que 3000 cycles en MLC), ces FRAM supportent selon TI pas moins de 10^14 cycles... De quoi voir venir !

Ces mémoires ne sont pas encore produites en masse, mais Texas Instruments fournit dès à présent aux constructeurs intéressés des modules de test permettant d'évaluer l'intégration des FRAM dans divers produits électroniques.

Posté par Matt le 10/05/2011 à 08h41

Aucun commentaire

Source : BHMag

Une petite nouveauté a été déployée ce soir sur Infobidouille : il vous est désormais possible de recevoir une notification par e-mail lorsqu'un nouveau commentaire est publié sur le site.

Pour activer ce service, il vous suffit de vous inscrire ou d'aller modifier votre profil.

Posté par Matt le 10/05/2011 à 00h12

Aucun commentaire

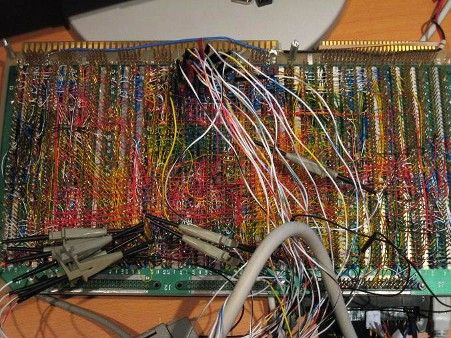

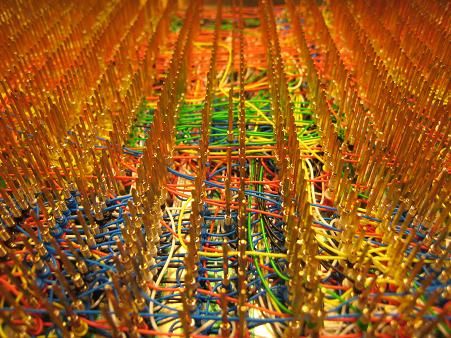

Si certains cherchent la performances à tout prix avec leur ordinateur, en y installant des composants haut de gamme et en affinant l'overclocking, d'autres s'intéressent plus au fonctionnement bas niveau de la machine. Et pour ça, rien de tel que d'en construire une soi même !

C'est ainsi que Steve Chamberlin a construit le Big Mess O'Wires, un ordinateur assemblé à la main, avec pas moins de 1250 câbles wrapés à la main pour raccorder les composants entre eux. Avec son processeurs 8 bits à 2 MHz, ses 512 Ko de RAM et ces 512 Ko de ROM, cet ordinateur n'est bien entendu pas une foudre de guerre, mais la prouesse mérite le respect.

Les entrées/sorties n'ont pas été négligées, puisque l'appareil dispose d'un port clavier PS/2, d'un port USB, d'un afficheur LCD intégré, d'une sortie VGA (512x480 en monochrome ou 128x240 en 256 couleurs) et d'une sortie audio. L'OS est multi-tâche préemptif, comme les OS actuels, et dispose d'un interpréteur BASIC. Steve Chamberlin a même écrit un jeu d'échecs fonctionnant sur sa machine.

Voilà qui devrait rappeler quelques souvenirs aux pros de la wrapette !

Posté par Matt le 09/05/2011 à 14h28

2 commentaires

Source : Mac 4 Ever

![]()

En rachetant Sun, Oracle avait fait tomber dans son escarcelle bon nombre de projets phares de la communauté open-source. Depuis, l'américain est très critiqué par la communauté, qui lui reproche d'avoir une vision trop commerciale... Oracle a ainsi fini par rendre OpenOffice à la communauté, et il en est désormais de même pour le projet Hudson...

Celui-ci avait connu un destin assez similaire à celui d'OpenOffice. Des désaccords entre Oracle et les acteurs historiques du projet (dont son fondateur, Kohsuke Kawaguchi) avaient d'abord mené à un fork du projet, sous le nom de Jenkins, alors qu'Oracle était bien décidé à continuer de développer le projet de son côté. Avant de finalement jeter l'éponge, comme il l'a fait pour OpenOffice.

En effet, le serveur d'intégration Hudson a finalement été offert à la Fondation Eclipse. Une décision saluée par la communauté, d'abord parce que les règles de licences de la Fondation Eclipse sont beaucoup plus ouvertes, en permettant notamment aux contributeurs de rester propriétaires de leur code, ensuite parce que la gestion du projet Hudson par la Fondation Eclipse est techniquement plutôt logique, les outils de la fondation étant souvent utilisés conjointement à Hudson, vu la popularité de ce dernier dans le monde Java.

Il serait temps de rappeler à Oracle que MySQL a lui aussi été forké par son fondateur (MariaDB), et qu'un geste envers la communauté serait donc le bienvenue :-)

Posté par Matt le 09/05/2011 à 12h10

6 commentaires

Source : Clubic

![]()

Dans son rapport concernant la fixation des nouveaux tarifs de terminaisons d'appel, l'ARCEP a laissé apparaitre un petit détail intéressant sur la stratégie de déploiement 3G de Free, confirmant certaines rumeurs : Free s'intéresse aux femtocell.

En effet, le document de l'ARCEP précise que "Free Mobile indique à propos du déploiement des femtocellules que 'ce mode de déploiement, même s'il est à ce jour marginal, pourrait fort bien se développer rapidement dans les années à venir. Cette fonctionnalité étant déjà modélisée, Free Mobile considère qu'il est judicieux de la conserver".

Ceci relance donc les rumeurs sur l'existence future d'un module femtocell pour la Freebox 6. En effet, dès la présentation de la boîte, Xavier Niel avait indiqué qu'il y avait encore des fonctionnalités cachées, qui seront dévoilées petit à petit. Si le démontage de la Freebox 6 n'a pas révélé la présence du matériel nécessaire à une telle fonction, il reste toujours cette mystérieuse baie d'extension, dont personne n'a encore trouvé quelle est l'utilité.

Posté par Matt le 09/05/2011 à 10h49

Aucun commentaire

Source : Numerama

Après avoir dévoilé il y a quelques jours le Projet Café, la prochaine console de salon de Nintendo, qui devrait arriver l'année prochaine, Big N a annoncé une importante baisse de prix sur la Wii, pour tenter de relancer des ventes en forte baisse...

En effet, à partir du 15 mai prochain, la Wii sera proposée à 150$ au lieu de 200$, soit une baisse de 25%. Le président de Nintendo Amérique indique par ailleurs que la Wii continuera à être commercialisée après le lancement de la console de nouvelle génération, qui devrait être positionnée sur un segment beaucoup plus haut de gamme. Une baisse de prix aura également lieu en Europe à partir du 20 mai, avec un nouveau tarif qui devrait se situer aux alentours de 150€.

Par ailleurs, Nintendo va proposer un nouveau bundle pour la console. Jusqu'à présent, celle-ci était vendue uniquement avec Wii Sports, puis Wii Sports Plus. Le nouveau bundle visera la clientèle plus "traditionnelle" de Nintendo, puisque le jeu livré avec la console sera le fameux Mario Kart, accompagné de son volant.

Enfin, confirmant le positionnement entrée de gamme de la Wii, Nintendo va lancer une gamme de jeux "Select", qui comprendra des rééditions à petit prix des titres phares de la console. Les premiers titres seront Wii Sports, Wario Ware : Smooth Moves, Mario Strikers Charged Football et Animal Crossing : Let's go to the City. Ces jeux devraient être vendus environ 20€.

Posté par Matt le 09/05/2011 à 08h30

Aucun commentaire

Source : Gameblog.fr

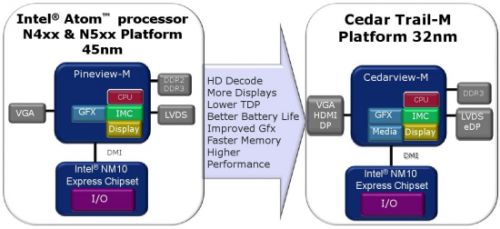

Intel avait promis hier à la presse qu'il allait faire une annonce technologique majeure... Chose promise chose due : le fondeur a indiqué que son process de gravure 22nm, qui entrera en service en fin d'année avec les Ivy Bridge, allait adopter des transistors 3D.

Étudiés dans les labos depuis plusieurs années, ces transistors, qu'Intel a baptisé Tri-Gate, ont la particularité d'avoir une porte qui n'est plus posée à plat sur le substrat, mais qui entoure une protubérance du substrat. Cette solution permet d'augmenter sensiblement la surface de contact pour une même finesse de gravure, et ainsi de réduire les courants de fuite au repos (donc de réduire la consommation en idle), ou de réduire la tension de seuil du transistor, ce qui permet une réduction de consommation en charge.

La réactivité des transistors est également améliorée. Selon Intel, cette technologie permettra d'augmenter la vitesse de 18% à 37% selon la tension de fonctionnement, tandis que pour une même vitesse, il sera possible de réduire la tension de 0.2V par rapport à un transistor classique. Les gains seront donc nettement plus élevés que lors du passage de 45 à 32nm, où la vitesse n'avait progressé que de 14 à 22%.

Même si les premiers processeurs qui bénéficieront de cette nouvelle technologie seront les Ivy Bridge, qui remplaceront les actuels Sandy Bridge dans les PC, il y a fort à parier qu'Intel propose assez rapidement des SoC pour smartphones et tablettes exploitant les transistors Tri-Gate. En effet, sur ces marchés, Intel est malmené face aux processeurs ARM à cause de la consommation excessive de ses puces, et une technologie permettant une forte baisse de consommation est donc clairement la bienvenue.

Posté par Matt le 05/05/2011 à 13h41

2 commentaires

Source : Hardware.fr