Actualités du mois d'avril 2011

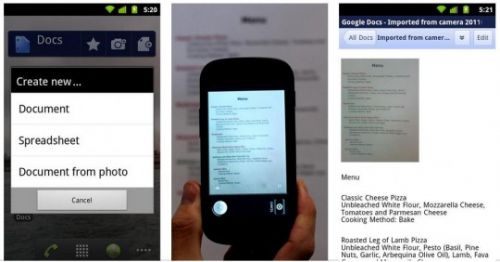

Avec l'arrivée des tablettes sous Android, et en particulier de l'Eee Pad Transformer d'Asus, avec son clavier physique optionnel, Android devient un système qui pourrait être amené à servir occasionnellement pour des petites tâches bureautiques. Le système avait donc besoin d'une suite bureautique, et c'est désormais chose faite.

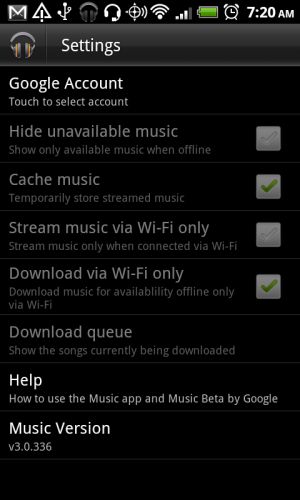

Google a en effet publié sur l'Android Market une application Google Docs pour Android. Elle permet d'accéder aux principales fonctionnalités de la suite bureautique en ligne de Google, mais avec une interface mieux adaptée aux terminaux mobiles, y compris les smartphones. Elle apporte également quelques fonctionnalités exclusives, dont une particulièrement intéressante : un système de reconnaissance de caractère qui permettra de générer une version éditable d'un document pris en photo avec l'appareil photo du smartphone ou de la tablette.

Pour l'instant, l'application reste toutefois un peu trop liée au service en ligne de Google, puisque l'application ne propose pas de mode hors ligne, qui permettrait d'éditer des documents en toutes situations, même en l'absence de connexion Internet. Espérons que Google lèvera cette limitation, en attendant qu'une suite bureautique plus complète, comme LibreOffice, arrive sur la plateforme.

Posté par Matt le 29/04/2011 à 14h21

Aucun commentaire

Source : Le Journal du Geek

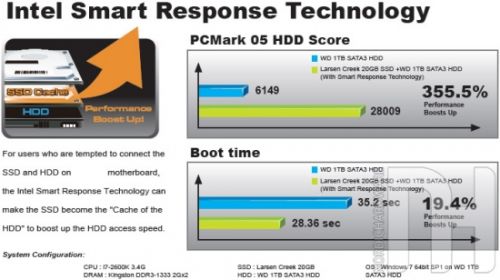

Dans son futur chipset Z68, pour processeurs Sandy Bridge, Intel va introduire une fonction baptisée Smart Response Technology, destinée à améliorer les performances des machines grâce à un SSD. On en sait désormais un peu plus sur cette fonction, pour laquelle Intel prévoirait même de sortir un nouveau modèle de SSD.

Comme on pouvait s'y attendre, le principe de cette fonction est de coupler un disque dur et un SSD en un seul volume logique, de la taille du disque dur, qui exploitera le SSD comme un énorme cache. Ainsi, sur les fichiers fréquemment accédés, les performances seront celles d'un SSD, tandis qu'on disposera de la capacité d'un disque dur. Cette solution permettra donc de se contenter d'un SSD de très petite capacité, qui n'aurait normalement même pas suffit à installer le système.

Dans cette optique, Intel aurait d'ailleurs prévu un nouveau modèle de SSD, l'Intel SSD 311 "Larsen Creek". D'une capacité de seulement 20 Go, il permettra d'exploiter pleinement le Z68 pour un prix réduit, puisqu'une telle capacité devrait permettre un prix inférieur à 50€.

Posté par Matt le 29/04/2011 à 13h00

Aucun commentaire

Source : TTHardware

Annoncé en juin dernier, en même temps que l'iPhone 4 noir, l'iPhone 4 blanc a depuis joué l'arlésienne, en étant sans cesse reporté. Il avait même fini par disparaitre du site d'Apple, laissant penser à son abandon définitif... ou pas.

En effet, alors que les amateurs de la pomme attendent déjà l'iPhone 5, Apple a finalement trouvé la recette de la peinture blanche, et l'iPhone 4 blanc est désormais disponible à la vente, au même tarif que la version noire. Cette sortie tardive tendrait d'ailleurs à confirmer que l'iPhone 5 arrivera plus tard que d'habitude, et que la sortie de l'iPhone 4 blanc arrive donc juste au bon moment pour relancer un peu les ventes et faire durer cette génération...

Alors que différentes rumeurs avaient évoqué les causes de ce retard, d'abord pour des raisons de problèmes de densité de la couleur (impossibilité de produire une peinture suffisamment dense pour ne pas être transparente, sans pour autant être trop épaisse), puis pour des problèmes de flash (la face arrière blanche aurait une influence sur la qualité des photos prise au flash, en diffusant la lumière différemment), la justification officielle, donnée par Phil Schiller, vice-président en charge du marketing, est qu'Apple aurait eu du mal à mettre au point une formule à la couleur suffisamment durable, en particulier lors de l'exposition aux rayons UV.

Posté par Matt le 29/04/2011 à 10h41

Aucun commentaire

Source : Mac 4 Ever

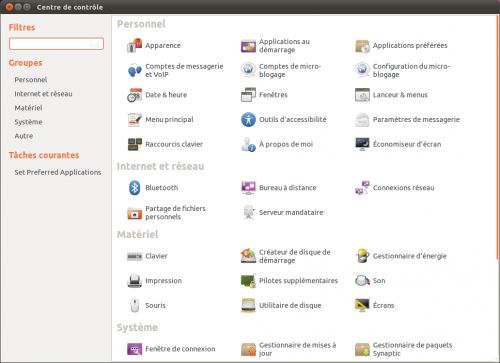

Comme prévu, Canonical a publié hier la version finale de son système Ubuntu 11.04 Natty Narwhal, juste à temps pour qu'elle ne soit pas numérotée 11.05. Cette nouvelle version, qui fusionne Ubuntu Netbook Edition et Ubuntu Desktop risque de changer un peu les habitudes des utilisateurs. Adieu Suricate Anti-conformiste (Maverick Meerkat), place au Narval Astucieux !

Changement le plus visible, la distribution adopte une nouvelle interface graphique, l'interface Unity, qui avait été introduite sur la version Netbook d'Ubuntu. Cette interface se caractérise par une barre latérale (Unity Launcher) reprenant les applications en cours, mais aussi des raccourcis vers les applications favorites, à la manière du dock de Mac OS X et de la nouvelle barre des tâches de Windows 7. La barre supérieure, qui conserve la zone de notification en haut à gauche, ne sert plus de lanceur pour les applications, mais de barre de menu unifiée (là encore, à la façon d'OS X, mais ce n'est ici pas encore exploité par toutes les applications, certaines gardent leurs menus dans leur fenêtre), et fusionne avec la barre de titre lorsqu'une fenêtre est utilisée en plein écran.

Le lancement des applications ne passe plus par des menus hiérarchisés, mais par l'"App Menu". S'il conserve une organisation par catégorie, l'"App Menu" privilégie plutôt l'accès aux applications par la saisie des premières lettres de leur nom. Il sert aussi à suggérer des applications à l'utilisateur, lors du parcours des catégorie : l'"App Menu" affiche pour chaque catégorie les applications installées, mais aussi des suggestions d'applications à installer.

Le paramétrage de l'ordinateur a lui aussi droit à son lifting. Anciennement présentés sous forme de menus accessibles via la barre supérieure, les réglages sont désormais intégrés dans une application, le "Centre de contrôle".

Suivant la tendance du moment, Ubuntu 11.04 s'est également doté de son App Store, la "Logithèque Ubuntu", qui recense plusieurs dizaines de milliers d'applications, gratuites ou payante et permet de les installer aisément. Il est également possible de noter les applications et de déposer des commentaires, ce qui n'est pas possible avec les dépôts logiciels classiques, reposant sur APT.

Pour le reste, comme d'habitude avec une nouvelle version d'Ubuntu, les principaux logiciels passent à des versions plus récentes que dans Ubuntu 10.10. Par exemple, Firefox passe en version 4 et OpenOffice est remplacé par LibreOffice

Posté par Matt le 29/04/2011 à 08h38

Aucun commentaire

Source : Site du Zéro

![]()

À l'approche de la campagne pour les présidentielles, et alors que plusieurs responsables de l'opposition ont déjà exprimé leur volonté de toucher à l'Hadopi en cas d'accession au pouvoir en 2012, même Nicolas Sarkozy retourne un peu sa veste en admettant que des erreurs ont été commises...

Il y a quelques jours déjà, le président avait indiqué que, si le Conseil National du Numérique (CNN) avait existé à l'époque, la loi n'aurait sans doute pas pris la forme qu'elle a actuellement. Hier, lors de la mise en place officielle du CNN, Nicolas Sarkozy s'est dit prêt à mettre en chantier une loi Hadopi 3, qui pourrait être l'une des premières missions du CNN. Le président a même reconnu avoir sa part de responsabilité dans les erreurs commises par les deux premières loi Hadopi. Rappelons qu'à l'époque des débats, il était particulièrement déterminé à imposer son projet, et à "aller jusqu'au bout", comme il le disait à l'époque.

Le CNN est composé de vingt professionnels du secteur de l'Internet, dont le médiatique directeur général de Free, Xavier Niel, mais aussi des représentants de SFR, Bouygues Telecom, Orange, Deezer et Dailymotion (donc en fait 3 représentants d'Orange, Deezer et Dailymotion appartenant à l'opérateur historique...). Il n'a pas de pouvoir direct, mais sera consulté sur les questions liées à Internet, et en particulier sur les épineux dossiers de la neutralité, du respect de la vie privée et du piratage. Il est toutefois déjà critiqué à cause de sa composition, qui fait la part belle aux industriels du secteurs, en ignorant toute représentation des utilisateurs...

Posté par Matt le 28/04/2011 à 14h52

Aucun commentaire

Source : Tom's Guide

Quelques jours après le début du "locationgate", Apple a publié sur son site une page expliquant ce que fait et ce que ne fait pas Apple avec les informations de localisation de l'utilisateur, et en particulier sur le contenu du fameux fichier "consolidated.db", accessible sur tout ordinateur synchronisé avec un iPhone.

Tout d'abord, Apple indique qu'elle ne trace pas la localisation des iPhone et n'a aucune intention de le faire. Le fichier incriminé ne stockerait en fait pas la position de l'iPhone lui même, mais uniquement celle des antennes GSM et Wi-Fi à proximité de lui. Ces positions peuvent ensuite être utilisées par l'iPhone pour calculer sa position approximative plus rapidement que s'il fallait télécharger les informations à chaque fois. L'iPhone envoie également certaines informations à Apple, pour compléter la base de données des hot-spots Wi-Fi et pour préparer le lancement d'une application de navigation prenant en compte l'historique du trafic, mais ces données sont envoyées de façon anonyme et uniquement à Apple. Apple indique par ailleurs que le fait que l'iPhone continue à remplir ce fichier même lorsque le service de localisation est désactivé est un bug.

Enfin Apple promet une mise à jour du système iOS pour modifier la gestion de ce fichier :

- réduction du nombre de positions conservées,

- désactivation de la sauvegarde de ce fichier lors de synchronisation avec iTunes,

- suppression du fichier lorsque le service de localisation est désactivé.

Dans la prochaine version majeur du système, le fichier stocké sur l'iPhone sera chiffré.

Posté par Matt le 28/04/2011 à 12h41

Aucun commentaire

Source : Le Journal du Mac

Présentée en début d'année, la gamme de tablette Eee Pad d'Asus devrait déjà être disponibles en France si les dates promises à l'époque avaient été respectées... Depuis, une trop forte demande et une pénurie de composants ont quelques peu perturbé les plans d'Asus, qui en a donné une nouvelle version lors d'une conférence devant les journalistes français.

Très populaire outre-Manche, l'Eee Pad Transformer, qui devait arriver en France mi-avril arrivera finalement le 6 juin, et il y a fort à parier que ceux qui n'auront pas pré-commandé ne seront pas servis par le premier arrivage. Aux USA, où elle vient d'être lancée, elle est déjà en rupture chez tous les revendeurs. Il faut dire que non seulement, Asus n'avait pas prévu une telle demande, mais en plus, sa capacité de production, qui devait être de 200 000 unités par mois, a été limité à 100 000 exemplaires au mois d'avril à cause d'une pénurie de composants. Le rythme de production devrait reprendre la normale dès le mois de mai.

L'Eee Pad Slider, très proche de la Tranformer, mais avec un clavier coulissant intégré au lieu d'un clavier amovible, qui devait sortir avant la Transformer, est finalement repoussée au quatrième trimestre. Asus en profitera pour revoir la configuration matérielle : le Tegra 2 cédera sa place à un Tegra 3 ou un Atom Z670.

Enfin, l'Eee Pad MeMo, une tablette au format 7", arrivera également au quatrième trimestre, alors qu'elle était initialement prévue pour mai.

Posté par Matt le 28/04/2011 à 10h17

Aucun commentaire

Source : PCInpact

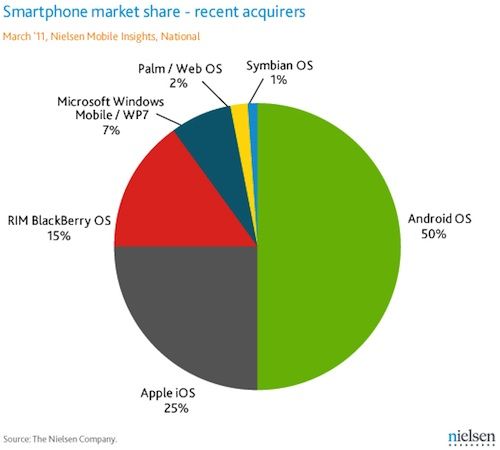

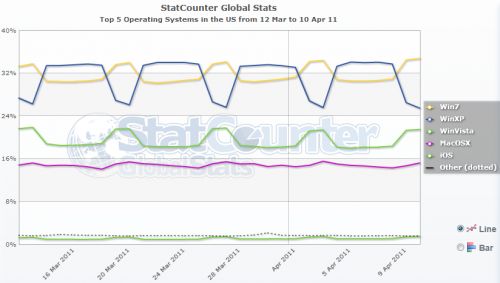

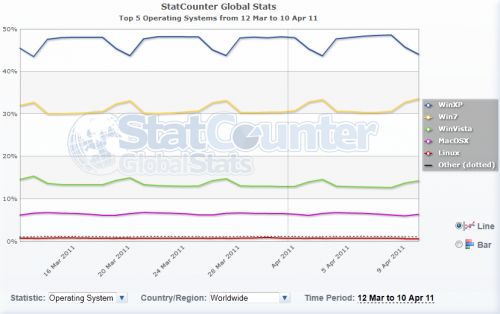

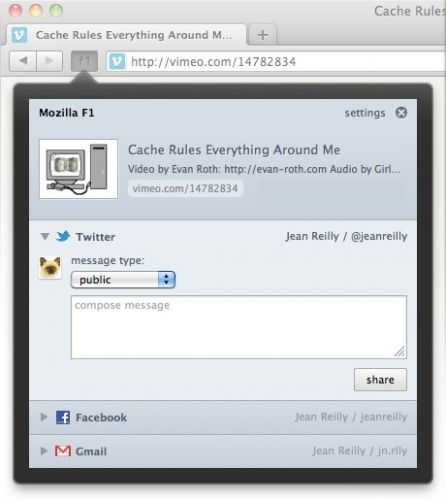

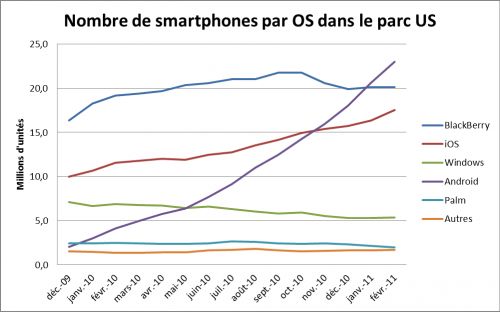

Ces derniers mois, Android a dépassé bon nombre d'indicateurs symboliques de son succès : passage en tête des ventes aux USA, passage en tête du parc installé aux USA, passage en tête des ventes au niveau mondial... Selon le cabinet Nielsen, il aurait atteint deux nouveaux paliers symboliques aux États-Unis le mois derniers.

Tout d'abord, le système mobile de Google équipe désormais un smartphone sur deux vendus aux USA. Sa part de marché est le double de celle de l'iPhone (25%), et plus du triple de celle des Blackberry (15%), tandis que Windows Phone 7 ne décolle toujours pas, avec 7% (cumulé avec Windows Mobile), suivi de WebOS (2%) et de Symbian, qui n'a jamais réussi à percer outre-Atlantique (1%).

Autre symbole, Android est pour la première fois passé en tête des intentions d'achat. En effet, parmi les gens prévoyant l'achat d'un nouveau smartphone dans les douze mois à venir, 31% pensent opter pour Android, contre 30% pour l'iPhone. Dans les faits, l'historique de cet indicateur, comparé aux ventes effectives montre que les ventes réelles de l'iPhone sont inférieures aux intentions d'achat, alors que celles d'Android sont supérieures.

Posté par Matt le 27/04/2011 à 14h40

Aucun commentaire

Source : Mac 4 Ever

![]()

Alors que beaucoup attendent la fibre, un abonné de Free a eu l'idée de créer une carte Google Maps permettant de suivre l'avancement du déploiement du réseau de Free, en recensant les Nœuds de Raccordement Optique de l'opérateur.

Basée sur des témoignages, et non pas sur des données officielles de Free, cette carte n'est pas d'une parfaite précision, mais permet tout de même de se faire une idée de l'avancée des travaux. Et malheureusement, ce n'est justement pas encore très avancé... En effet, pour l'instant, seuls 137 NRO ont été confirmés pour l'instant, à Paris, Lille, Rennes, Nantes, Valenciennes, Lyon, Nice, Marseille, Montpellier et Toulouse, et seuls une minorité d'entre eux accueillent déjà des abonnés (un à Valenciennes, un à Lyon, quatre à Montpellier, une petite quarantaine en région parisienne, rien dans les autres villes).

La carte recense également une quarantaine de NRO qui n'ont pas encore été confirmés, mais qui étendraient la couverture aux villes de Strasbourg, Besançon et Grenoble.

Il reste donc encore beaucoup de travail à Free pour déployer une réseau fibre optique digne de ce nom, d'autant plus que la présence d'un NRO n'est pas forcément synonyme d'une bonne couverture jusqu'aux abonnés. À titre de comparaison, le réseau ADSL de Free se compose de plus de 3400 NRA, et Free en ouvre en moyenne une soixantaine par mois...

Posté par Matt le 27/04/2011 à 12h21

1 commentaire

Source : Univers Freebox

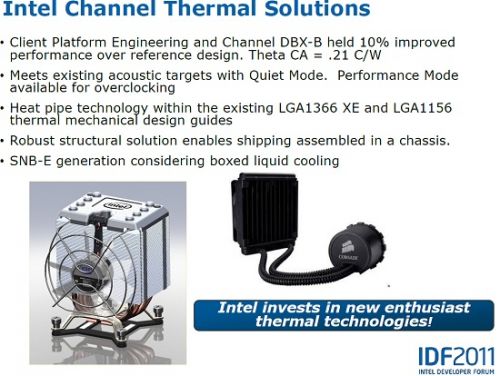

Selon un document interne d'Intel, le fondeur envisagerait le distribuer certains de ses processeurs haut de gamme avec un système de refroidissement liquide, au lieu des habituels systèmes de refroidissement à air.

Ceci concernerait les futurs processeur Sandy Bridge-E, les puces haut de gamme d'Intel destinées aux "power-users", qui prendront place sur le socket LGA2011. La plupart des acheteurs de ces processeurs "Extreme" capables d'assembler eux même leurs machines, et à qui un système de refroidissement à eau ne devrait pas faire peur, même s'il est un peu plus complexe à installer qu'un radiateur : il faut installer le bloc échangeur sur le processeur, comme un radiateur, mais il y a en plus à fixer le radiateur et son ventilateur au boîtier, généralement au niveau de l'aération arrière.

Le système proposerait deux modes de fonctionnement, un mode silencieux suffisant pour un usage normal du processeur, et un mode performance destiné à ceux qui souhaitent overclocker le processeur.

Reste à voir si une telle solution intéressera vraiment la cible des processeurs "Extreme". En effet, les utilisateurs avertis aiment généralement choisir chaque pièce de leur machine, et utilisent donc rarement les systèmes de refroidissements fournis par les constructeurs. Intel avait d'ailleurs choisi pour cette raison de vendre séparément les processeurs Core i7 haut de gamme et leurs radiateurs.

Posté par Matt le 27/04/2011 à 10h55

Aucun commentaire

Source : Tom's Hardware

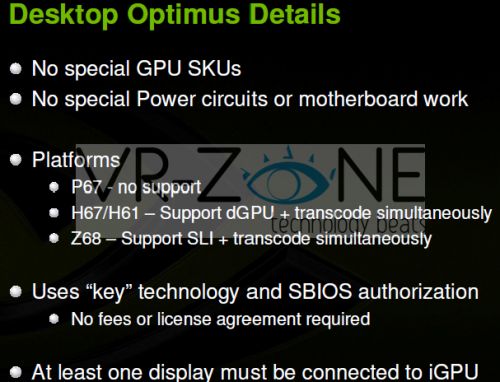

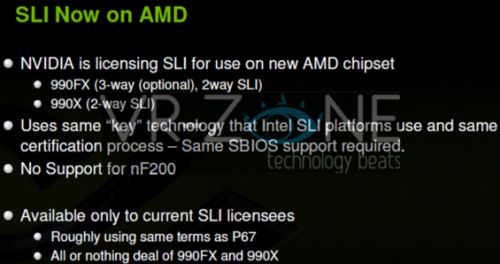

Lancée il y a un peu plus d'un an, la technologie Optimus d'nVidia est destinée aux ordinateurs portables dotés d'une puce graphique intégrée et d'une puce graphique dédiée, et permet la bascule automatique des traitements d'une puce à l'autre en fonction des besoins, pour économiser la batterie sans sacrifier les performances. Cette technologie va arriver dans les machines de bureau, sous le nom de Synergy.

Compatible avec les processeurs Intel Sandy Bridge et les chipsets Intel série 6 (sauf bien sûr le P67, qui ne supporte pas la puce graphique intégrée aux Sandy Bridge), Synergy fonctionne sans modification matérielle (une mise à jour du BIOS est toutefois requise), et permettra de basculer entre la puce graphique Intel intégrée et une carte graphique nVidia, voir plusieurs cartes en SLI sur le chipset Z68.

L'écran sera connecté à la carte mère, et c'est l'IGP Intel qui gérera donc l'affichage, en récupérant les images calculées par la carte graphique nVidia. Bonne nouvelle, cette solution sera gratuite et compatible avec toutes les puces nVidia actuelles.

Avec la généralisation des IGP dans les processeurs Intel et AMD et le développement de solutions de bascule aussi bien chez nVidia que chez AMD, voir chez des sociétés tierces, on s'oriente donc de plus en plus vers un retour au modèle de fonctionnement des deux premières générations de cartes 3dfx : une puce graphique basique pour gérer l'affichage hors 3D, et une carte accélératrice dédiée à la 3D... Souvent considéré comme un défaut des 3dfx à l'époque, ces systèmes se transforment aujourd'hui en avantages, en permettant de réduire la consommation des machines lorsqu'elles sont faiblement utilisées.

Posté par Matt le 27/04/2011 à 08h40

Aucun commentaire

Source : PCWorld

Alors que le projet Google Music semble bloqué par les réticences des majors, il se murmure que Google serait finalement en négociation avec Spotify, qui a déjà la bénédiction des majors. Un nouveau moyen de pression sur les majors ?

Interrogé sur ces rumeurs, Google a refusé de répondre, tandis que Spotify indique qu'il n'est pour l'instant pas question d'ouverture d'un service Google basé sur Spotify. Il se pourrait donc que ces rumeurs ne soient en fait qu'un moyen de pousser les majors à revoir leur position, en les laissant croire que Google pourrait trouver une solution pour lancer son service sans leur accord direct.

Il se pourrait également que les négociations entre Google et Spotify ne concernent effectivement pas une intégration de Spotify dans un nouveau service Google, mais carrément un rachat de Spotify par Google. Ceci permettrait au géant de la recherche d'entrer de plein pied dans un marché où il a pris beaucoup de retard sur ses concurrents, qu'il s'agisse de streaming de musique (Deezer, Spotify), de vente de musique dématérialisée (Apple, Amazon), ou encore de stockage de musique en ligne (Amazon).

Posté par Matt le 26/04/2011 à 15h11

Aucun commentaire

Source : Le Journal du Geek

Depuis quelques temps déjà, les rumeurs annonçaient le lancement prochain d'une nouvelle console de salon chez Nintendo, pour remplacer la Wii, techniquement totalement dépassée par ses concurrentes et dont les ventes commencent à sérieusement s'essouffler. C'est désormais officiel, avec un communiqué de presse de Nintendo confirmant la rumeur.

Le communiqué ne dit toutefois pas grand chose sur la bête, si ce n'est qu'elle sera présentée officiellement lors du prochain E4, qui aura lieu à Los Angeles du 7 au 9 juin prochains. C'est à cette occasion donc que l'on en saura un peu plus sur les caractéristiques de la console, qui répond pour l'instant au nom de code "Café".

Selon les derniers rumeurs, son nom commercial pourrait être "Stream". Elle embarquerait une variante de processeur IBM PowerPC à trois cœurs (comme la Xbox 360) et une puce graphique AMD de la série R700 (Radeon 4000), là où la Xbox 360 embarque une une version intermédiaire entre le R500 et le R600. Plus volumineuse que la Wii, elle ferait par son design un clin d'œil à la Super Nintendo.

Côté manette, Nintendo pourrait de nouveau "révolutionner" les choses, avec, en plus de la classique Wiimote, une nouvelle manette intégrant un écran tactile de 6 pouces sur lesquels les jeux pourraient afficher des informations. Elle pourrait même être utiliser comme console portable, à condition de ne pas trop s'éloigner de la base, qui enverrais l'image sur la manette.

Un prototype fonctionnel devrait pouvoir être testé lors de l'E3, mais il faudra par contre attendre au mieux avril 2012 pour la commercialisation.

Posté par Matt le 26/04/2011 à 10h20

Aucun commentaire

Source : JeuxVidéo.fr

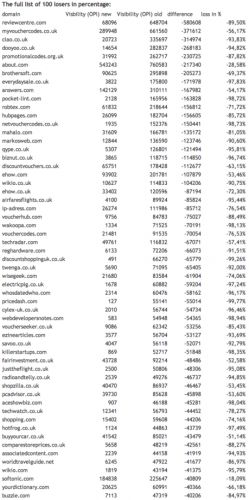

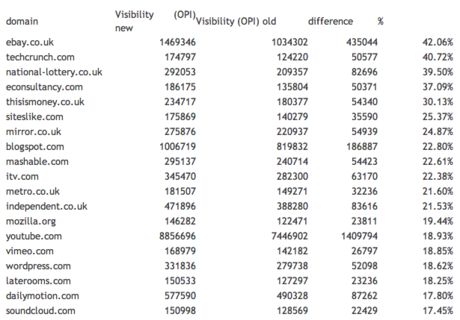

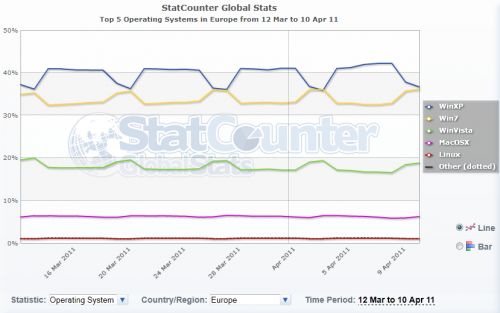

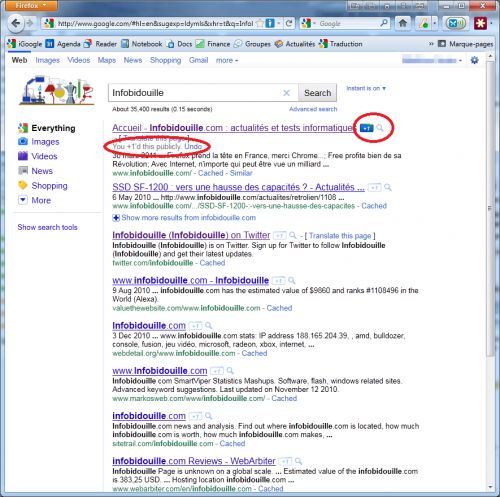

Il y a quelques semaines, Google avait annoncé avoir mis au point une nouvelle version de ses algorithmes de recherche, baptisée Panda, dont le but était d'améliorer la pertinence des résultats de recherche, en privilégiant les sites dotés d'un vrai contenu, plutôt que les fermes de contenus sans valeur ajoutée, qui polluent largement les résultats de recherche. Le premier bilan semble confirmer l'efficacité de ces nouveaux algorithmes !

Différentes études publiées par des sociétés spécialisées dans le monitoring du trafic Internet montrent en effet d'importantes baisses de trafic sur certains sites, la plupart correspondant bien aux types de sites que Google ciblait avec sa mise à jour. Bon nombre de sites ont ainsi vu leur trafic dégringoler de plus de 80%, avec des cas extrêmes ou la chute dépasse les 99%.

À l'inverse, certains sites offrant une véritable valeur ajouté ont désormais les faveurs de Google, et voient donc leur trafic augmenter fortement. C'est le cas par exemple de TechCrunch, qui progresse de plus de 40%, ou encore de Mozilla qui gagne près de 20%. On notera au passage que YouTube et BlogSpot, deux plateformes d'hébergement appartenant à Google progressent, respectivement de 22.8% et 18.9%. C'est plus que leurs concurrents Vimeo, Wordpress et Dailymotion, qui profitent respectivement de 18.9%, 18.6% et 17.8% d'augmentation. Google pourrait également être critiqué sur le fait que les comparateurs de prix ont été fortement pénalisés avec Panda, ce qui pourrait favoriser Google Shopping...

Par ailleurs, des informations ont filtré sur les données prises en compte par ces nouveaux algorithmes pour détecter les fermes de contenu :

- le nombre de publicités par page : plus il est grand, plus le site risque d'être blacklisté,

- la présence de texte caché,

- l'affichage d'un contenu différent aux robots Google par rapport à un visiteur classique.

Par ailleurs, une seule page suspecte suffit à blacklister le site entier, et, une fois un site blacklisté, il sera visité moins souvent par le robot Google, ce qui augmentera le temps nécessaire à la propagation des mises à jour.

Utilisé pour l'instant uniquement aux États-Unis et en Angleterre, Panda devrait arriver sur la version française de Google d'ici à quelques semaines.

Posté par Matt le 25/04/2011 à 13h00

Aucun commentaire

Source : PCInpact

Nabaztag, le lapin hi-tech aussi inutile qu'indispensable a désormais un petit frère, baptisé Katotz, que Mindscape vient de commercialiser, après plusieurs retards. Cette nouvelle version du gadget pour geek apporte bon nombre de nouvelles fonctionnalités.

Sous un même aspect extérieur, avec son corps conique et ses deux grandes oreilles mobiles, Karotz se distingue visuellement par l'apparition d'un "nombril", qui est en fait une webcam, permettant d'utiliser le Karotz pour faire de la vidéosurveillance. Il est également livré avec deux mini-lapins, baptisés FlatNanoz, contenant une puce RFID, qui peut être lue par le Karotz. Il devient ainsi possible de déclencher certaines fonctions en approchant simplement un FlatNanoz. Le fabricant donne comme exemple la possibilité de vérifier qu'un enfant est bien rentré à la maison, en recevant par mail une photo prise avec le webcam lorsque le FlatNanoz de l'enfant passe à proximité.

Grâce à son moteur de synthèse vocale, le Karotz pourra vous lire vos flux RSS, vous annoncer la météo et, bientôt, lire les status Facebook et les tweets de vos amis. Une application devrait également permettre de lires des histoires et de chanter pour des enfants, tandis que le constructeur promet la possibilité de téléphoner gratuitement de Karotz à Karotz.

Avec cette nouvelle version plus communicante et s'intégrant avec les smartphones (il peut même être contrôlé à distance avec un iPhone), Mindscape espère vendre 120 000 lapins cette année, qui viendront compléter les 150 000 Nabaztag déjà en activité.

Il faudra tout de même compter 200€ pour adopter la bestiole...

Posté par Matt le 25/04/2011 à 10h22

Aucun commentaire

Source : 01Net

Depuis quelques jours, une affaire fait beaucoup de bruit sur Internet : une petite application permet depuis n'importe quel ordinateur synchronisé avec un iPhone d'afficher une carte parfois très précise des déplacements de l'utilisateur de l'iPhone. Avec un historique portant parfois sur plusieurs années...

L'existence de ce fichier dans l'iPhone avait déjà été découverte et révélée cet été, mais à l'époque, il ne semblait accessible que sur l'iPhone, et n'était pas lisible sans jailbreak. Le fait qu'il soit accessible depuis n'importe quel ordinateur synchronisé avec l'iPhone pose de gros problèmes en termes de respect de la vie privée : possibilité de tracer un conjoint, risque que le fichier soit accédé à distance par un pirate, etc...

De nombreuses voix se sont donc élevées contre l'existence de ce fichiers, avec à la clé plusieurs demandes d'explication à Apple, émanant de sources très officielles (la CNIL en France, des sénateurs aux État-Unis...). Pour l'instant, l'explication serait que ce fichier sert de cache pour le service de localisation, et permettrait d'accélérer la localisation par triangulation GSM. Mais il est impossible de désactiver la mise à jour de ce fichier, même si le service de localisation est désactivé ! Le contrat de licence d'iOS prévoit également que ces données peuvent être envoyées à Apple, de manière anonyme.

Mais l'affaire ne s'arrête pas là. En effet, vu ces indiscrétions de l'iPhone, certains ont eu l'idée de vérifier ce qu'il en est sous son principal concurrent : Android. Et il n'a pas fallu bien longtemps pour découvrir que l'OS de Google trace lui aussi l'utilisateur. Le fichier stocké par les smartphones Android est toutefois beaucoup moins complet : il se limite aux 50 dernières antennes relais auxquelles l'appareil s'est connecté, ainsi que les SSDI des 200 derniers réseaux Wi-Fi qui ont été à porté de l'appareil. Il est également un peu moins problématique en termes de vie privée, car il n'est pas accessible sans rooter le téléphone et utiliser le mode debug, et n'est pas transféré sur l'ordinateur. On peut toutefois craindre que des applications malveillantes parviennent un jour à l'exploiter.

Si vous avez des déplacements à cacher, méfiez vous de votre smartphone !

Posté par Matt le 25/04/2011 à 09h01

Aucun commentaire

Alors que chaque jour apparaissent de nouvelles menaces sur la sécurité des services en ligne ou le respect de la vie privée, l'Electronic Frontier Foundation, qui œuvre à la défenses des droits des internautes, se lance dans une campagne de sensibilisation du public à l'usage du protocole HTTPS.

En effet, si bon nombre de sites renommés supportent le HTTPS, peu l'activent par défaut, et le chiffrement n'est donc appliqué qu'aux utilisateurs l'ayant spécifiquement demandé en saisissant l'URL du site. Or, pour l'EFF, le protocole HTTPS est le strict minimum requis pour garantir un minimum de sécurité lors de l'échanges de données avec un site Internet.

Via sa campagne de sensibilisation, l'EFF recommande ainsi aux utilisateurs d'Internet d'utiliser les navigateur Firefox couplé à l'extension HTTPS Everywhere, développée par l'EFF et des membres du projet Tor (un réseau d'anonymisation). Cette extension permet de passer automatiquement en HTTPS sur un grand nombre de site supportant ce protocole mais fonctionnant par défaut en mode non chiffré.

L'EFF a également publié plusieurs documents à destination des administrateurs, pour les inciter à opter pour le HTTPS et les aider à le mettre en œuvre. Enfin, un wiki permettra aux internautes de constituer une base de données des options de sécurité proposées par divers sites. On y repère ainsi quelques bons élèves, comme PayPal, qui impose le HTTPS et respecte la plupart des bonnes pratiques, mais aussi des mauvais élèves, comme le moteur de recherche Ask.com, qui n'offre aucune fonction de sécurité.

Posté par Matt le 22/04/2011 à 14h30

Aucun commentaire

Source : Clubic

![]()

Lorsque la loi Hadopi a été voté, elle prévoyait l'existence de "moyens de sécurisation" labellisés par l'Hadopi, qui permettrait à l'internaute les utilisant de prouver qu'il a mis tout en œuvre pour sécuriser sa connexion. Éventuellement doté d'une fonction de journalisation, traçant l'activité, ce moyen de sécurisation pourrait aller se loger directement dans la box Internet...

En effet, l'Hadopi a récemment publié la première versions des spécifications fonctionnelles de ces moyens de sécurisation. Si elles sont très permissives pour les entreprises, qui sont simplement invitées à indiquer explicitement dans leur charte informatique que la contrefaçon est interdite, ces spécifications sont par contre plutôt strictes pour les moyens de sécurisation à destination du grand public.

Ainsi, alors que les "radars" de l'Hadopi se contentent pour l'instant de surveiller les réseaux P2P, l'Hadopi prévoit que les moyens de sécurisation filtrent ces réseaux P2P, mais aussi le streaming, le téléchargement direct, le cloud et même la messagerie instantanée ! Un mécanisme de liste blanche et de liste noir permettra d'affiner le filtrage en fonction des ports, des logiciels utilisés, des types de fichiers, des sites... En option, ces spécifications prévoient aussi un volet journalisation, qui tracerait dans un fichiers toutes les activités de l'utilisateur ayant provoqué un blocage par les filtres du moyen de sécurisation. De quoi faire rêver les dirigeants de certains pays...

Concernant la forme du moyen de sécurisation, l'Hadopi est plutôt ouverte. Elle accepte en effet qu'il s'agisse d'un logiciel, éventuellement libre, mais aussi de tout dispositif matériel permettant d'arriver à ce résultat. À ce titre, les spécifications précisent que le moyen de sécurisation pourrait être installé directement dans le boîtier de connexion fournit par le FAI. Mais si c'est le cas, c'est tout de même à l'abonné que reviendra la décision d'activer ou non ce moyen de sécurisation.

Enfin, malgré toutes ces contraintes et tous les risques encourus par les utilisateurs de ces moyens de sécurisation en termes de liberté d'expression et de respect de la vie privée, l'Hadopi reconnait que ces moyens de sécurisation ne pourront pas être infaillible et que, même en les installant, il restera donc possible que la connexion Internet de l'utilisateur soit détournée... De quoi s'interroger sur le réel intérêt de ces moyens de sécurisation, s'ils ne sont pas capable de garantir la fonction de base pour laquelle ils sont censés servir...

Posté par Matt le 22/04/2011 à 12h28

1 commentaire

Source : Génération NT

![]()

En déportant le disque dur de la Freebox Révolution dans le boîtier ADSL, Free espérait pouvoir échapper à la taxe copie privée. Mais les critères d'exemption ont été modifiés pour que la Freebox Révolution ne soit plus exemptée... Free a alors argumenté, sans convaincre, sur le fait que la Freebox est simplement prêtée et non pas vendue à l'abonné...

Toujours pas officiellement exempté, Free opte finalement pour une autre stratégie : accepter le principe de la taxe, mais pas son montant. Le compte rendu d'une récente réunion de la commission copie privée indique en effet que Free n'est pas opposé à cette taxe, mais que le montant réclamé pour les 250 Go de la Freebox Révolution (35€) et trop élevé par rapport au prix de vente du service.

Free sera donc invité à venir négocier avec les membres de la commission le 28 avril prochain. Si tout va bien pour Free, cette réunion donnera lieu à un nouveau barème réclamant une somme moins élevée pour ce type d'appareil. Au sein de la commission, Free devrait normalement bénéficier de l'appui du SECIMAVI, qui représente les constructeurs. En effet, celui ci a déjà évoqué dans une réunion le fait qu'un disque dur de grande capacité coûte aujourd'hui moins cher à produire qu'un petit modèle, ce qui pousse les constructeurs à intégrer des disques de plus en plus gros. Et une taxe proportionnelle à la capacité annule donc toutes les économies ainsi réalisées...

Posté par Matt le 22/04/2011 à 10h10

Aucun commentaire

Source : PCInpact

Si Google a décidé de ne pas diffuser le code source d'Android 3.0 Honeycomb pour l'instant, le code source est tout de même disponible pour certains partenaires, dont Intel, qui travaille sur le portage du système sur architecture x86.

C'est ce qu'à confirmé Paul Otellini, CEO du fondeur, lors de la conférence de presse de présentation des résultats financiers du premier trimestre. Ce portage devrait permettre l'arrivée sur le marché de tablettes x86 sous Android avant la fin de l'année, en utilisant la plateforme Oak Trail.

L'année prochaine, ce devrait être le tour des smartphones Android x86, avec l'arrivée de la plateforme Medfield, qu'Intel devrait commencer à livrer en fin d'année. MeeGo devrait également être de la partie, aussi bien sur tablettes que sur smartphones.

Posté par Matt le 22/04/2011 à 08h51

Aucun commentaire

Source : Génération NT

Notre confrère vient de réactualiser ses statistiques de taux de panne des composants informatiques, tirées des chiffres du SAV de LDLC sur des produits âgés de 6 mois à 1 an (vendus entre octobre 2009 et avril 2010). Les statistiques sont calculées par marques (avec un minimum de 500 ventes), mais aussi par produits plus les plus vendus (minimum 100 exemplaires).

Du côté des cartes mères, bonne nouvelle : tous les taux de retour sont en baisse, le plus mauvais de ce bilan (MSI) étant au niveau du meilleur du bilan précédent (Gigabyte), avec 2.3% de retours. Gigabyte reste en tête, avec 1.6% (-0.7pt), suivi de Asus (1.9%, -0.6pt) et ASRock (2.0%, -0.7pt). MSI est celui qui a le moins progressé, ne gagnant que 0.1pt, ce qui lui vaut de passer de la seconde à la dernière place.

Côté alimentations, Seasonic redresse fortement la barre, passant de 3.3% de retours à 1.3%, ce qui lui permet d'accrocher la 3ème place, derrière CoolerMaster (1.0%, -0.1pt) et Antec. Ce dernier conserve sa première place, malgré une forte hausse du taux de retour (1.0%, +0.4%). Derrière le podium, le classement reste très serré, avec Corsair, Akasa, Enermax et Fortron entre 1.4% et 2.0%, tandis que Thermaltake ferme la marche avec 2.3%.

Pour la fiabilité des barrettes de RAM, l'ordre reste inchangé : Kingston, Crucial, Corsair, G.skill et OCZ. Les deux premiers sont à moins de 1%, les deux suivants à moins de 2%, et OCZ, très mauvais élève, dépasse les 7%. Rappelons que l'américain a décidé de se retirer ce ce marché pour se concentrer sur les SSD...

Sur le marché des cartes graphiques, Asus pers sa première place au profit de PNY, mais reste 2ème. Les deux constructeurs ont pourtant vu leur taux de retour augmenter. Sapphire progresse légèrement, Club 3D progresse nettement. Derrière, Gainward est en légère régression, tandis que Gigabyte, MSI et XFX voient leur taux de retour augmenter fortement.

Les données semblent aujourd'hui un peu plus en sécurité. En effet, à part Western Digital, en très légère régression (1.5%, +0.1pt) mais toujours premiers, les taux de retour baissent chez tous les constructeurs. C'est Samsung qui progresse le plus (1.8%, -0.7pt), ce qui lui permet de passer de prendre la seconde place, juste devant Seagate qui vient de le racheter.

Enfin, du côté des SSD, Intel continue d'écraser ses concurrents, avec un taux de retour divisé par deux, à seulement 0.3%. Kingston prend la seconde place, en divisant également son taux de retour par deux, mais reste quatre fois moins fiable qu'Intel. Crucial complète le podium, en progressant un peu, tandis que Corsair et OCZ ferment la marche, avec des taux en nette hausse.

Posté par Matt le 21/04/2011 à 14h41

Aucun commentaire

Source : Hardware.fr

Après Intel, Apple a publié hier soir ses résultats de son second trimestre fiscal 2011 (correspondant à quelques jours près au 1er trimestre civile). Et comme chez Intel, les records sont au rendez-vous...

Ainsi, si le chiffre d'affaire est, logiquement, en légère baisse par rapport au trimestre précédent, à 24.67 milliards de dollars contre 26.74, il est en hausse de 83% par rapport à l'année dernière (13.5 milliards). La marge brute reste stable à 41.4% (contre 41.7% il y a un an), mais la marge nette progresse, ce qui permet quasiment de doubler le bénéfice net : il passe de 3.07 milliards à 5.99 milliards sur un an (+95%). Mieux, malgré la baisse de CA par rapport au trimestre précédent, le bénéfice net est quasiment le même, ne diminuant que de 10 millions de dollars.

Côté produits, les ventes sont en hausse sur tous les produits phares de la pomme. Les Mac progressent de 28% sur un an, pour atteindre 3.76 millions d'unités (dans le détail, les Mac de bureau baissent de 1.15 à 1.01 millions, tandis que les portables passent de 1.8 à 2.75 millions). Avec 18.65 millions d'unités, les iPhone ont plus que doublés leurs ventes (+113%), tandis que l'iPad atteint 4.69 millions d'exemplaires sur le trimestre. Seul produit en baisse, à cause de la concurrence de l'iPhone, l'iPod s'est encore écoulé à 9.02 millions d'exemplaires (-17%).

Si ces résultats montrent encore une fois qu'Apple gagne beaucoup d'argent avec ses produits, et pourrait donc les rendre beaucoup plus accessibles, ils devraient faire plaisir aux actionnaires de la pomme. En hausse de 1.35% à la cloture du NASDAQ, quelques minutes avant l'annonce, l'action Apple a pris plus de 4% sur l'after-market après l'annonce...

Pour l'anecdote, le chiffre d'affaire de ce trimestre est légèrement supérieur à celui de l'année 2007 entière (24.58 milliards), la dernière année "pré-iPhone". Le bénéfice est par contre supérieur de 36%...

Posté par Matt le 21/04/2011 à 13h01

6 commentaires

Source : MacGénération

Intel vient d'annoncer ses résultats financiers du premier trimestre 2011 et, encore une fois, le géant des semi-conducteurs atteint des chiffres record, avec un CA en progression de 25% (12.8 milliards de dollars) et un bénéfice net en hausse de 29% (3.2 milliards de dollars).

Cette progression, Intel la doit principalement au marché des composants pour serveurs (+32%) et celui des processeurs pour PC, en hausse de 17% malgré l'arrivée des tablettes, dont beaucoup d'analystes annonçaient qu'elles allaient cannibaliser les ventes de PC. Intel prévoit aussi une forte croissance sur le marché des micro-serveurs, pour lesquels il va bientôt lancer une gamme dédiée de processeurs Atom.

L'Atom qui, justement, donne pour sa part un bilan plus mitigé. La croissance est bien là, mais elle est faible (seulement 4%), et, avec 370 millions de dollars de chiffre d'affaire, l'Atom ne représente même pas 3% du chiffre d'affaire d'Intel. Intel compte sur sa plateforme Oak Trail pour doper ces chiffres, ainsi que sur le développement du marché des set-top-box à base d'Atom. Free est d'ailleurs le plus gros client d'Intel dans ce domaine, et il devrait bientôt être rejoint par Orange et Bouyges Télécom, mais aussi par ces opérateurs étrangers.

Ce trimestre record ne devrait par contre pas le rester bien longtemps, Intel tablant sur une croissance de 20% pour le reste de l'année, ce qui devrait rapidement amener à de nouveaux records.

Posté par Matt le 21/04/2011 à 10h10

Aucun commentaire

Source : Silicon.fr

Il y a un peu plus d'un an, Apple a attaqué HTC en justice pour violation d'une vingtaine de brevets. Nokia avait rapidement rejoint HTC sur le banc des accusés. Mais cette procédure pourrait bien être un coup d'épée dans l'eau pour Apple, suite au premier rapport de l'ITC sur le sujet.

En effet, alors qu'Apple réclamait l'interdiction de l'importation des smartphones HTC et Nokia sur le territoire américain, l'ITC, l'agence fédérale américaine en charge de conseiller la justice sur les affaires commerciales, a publié un rapport préliminaire sur cette affaire, dans lequel l'un des avocat de l'ITC recommande au juge de rejeter la demande d'Apple.

Bien entendu, le tribunal n'a aucune obligation de se ranger à l'avis de l'avocat de l'ITC, dont le rôle est de protéger l'intérêt des consommateurs, et non ceux de l'une des deux parties du procès. Il y a toutefois de fortes chances que le juge, qui rendra son verdict le 5 août prochain, privilégie lui aussi l'intérêt du consommateur, en laissant la concurrence entre les constructeurs de smartphone s'exercer librement.

Posté par Matt le 21/04/2011 à 09h00

Aucun commentaire

Source : Tom's Hardware

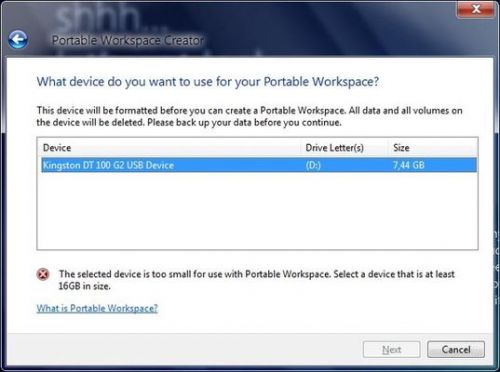

Depuis des années que l'USB existe, Windows n'est toujours pas capable de s'installer et de démarrer nativement depuis un périphérique de stockage USB, qu'il s'agisse d'une clé ou un disque dur. Ceci pourrait enfin changer avec Windows 8, mais uniquement pour l'édition Enterprise...

En effet, cette version proposera une fonction baptisées "Portable Workspace", qui permet de créer une installation bootable de Windows sur un périphérique USB. Il s'agirait même d'un peu mieux qu'une simple installation sur périphérique USB, puisque cette installation pourra ensuite être utilisée sur n'importe quelle machine, et pas seulement sur celle où l'installation a été réalisée.

Cette solution a probablement été mise au point pour faciliter le dépannage des ordinateurs en entreprise, ce qui expliquerait le fait qu'elle ne soit proposée que dans l'édition Enterprise, mais il est dommage qu'elle ne soit pas proposée pour le grand public, qui aurait aussi pu y trouver une utilité, pour se créer un système de secours sur clé USB.

Posté par Matt le 20/04/2011 à 14h40

6 commentaires

Source : Tom's Hardware

![]()

Notre confrère Hardware.fr vient de publier un nouveau comparatif de SSD, reprenant les principales références de ce début d'année 2011, ainsi que quelques modèles représentatifs de 2010. Mauvaise nouvelle, ce comparatif laisse entrevoir une hausse de la consommation des SSD...

En effet, si les SSD de début 2011 sont impressionnant par leurs débits, tirant largement parti de l'adoption du SATA 6 Gbit/s, cette hausse de performances s'est accompagnée d'une hausse de consommation, aussi bien au repos qu'en activité. Ainsi, alors que dans le comparatif des modèles 2009/2010, la consommation moyenne au repos s'établissait à 0.55W (0.2W pour le plus sobre, 1.2W pour le plus gourmand), elle atteint 0.86W (0.74W sans le Vertex 3 240 Go, dont la consommation élevée est mise sur le compte d'un firmware de pré-série) avec les modèles 2011 (0.6W minimum, 1.65W maximum).

Et ce n'est pas mieux en utilisation. Les modèles 2009/2010 consommaient en moyenne 2.32W en activité (1.5W minimum, 4.7W maximum) et plusieurs modèles descendaient sous les 2W. Parmi les modèles 2011, aucun ne parvient à descendre sous la limite des 2W, et la moyenne s'établit à 3.2W.

Si cette hausse de consommation est en partie liée à la hausse des capacités, il semblerait toutefois que les contrôleurs soient responsables d'une partie de cette hausse. Espérons que les constructeurs auront rapidement l'idée de se concentrer sur la consommation de leurs produits, plutôt que de se battre uniquement sur les performances, sans quoi les SSD pourraient perdre une part de leur intérêt dans les ordinateurs portables, avec des consommations qui deviennent supérieures à celles des disques durs 2.5".

Posté par Matt le 20/04/2011 à 13h00

Aucun commentaire

Source : TT-Hardware

![]()

Le marché des disques durs sera-t-il bientôt limité à deux constructeurs ? C'est en tout cas le chemin qu'il prend, avec le rachat par Seagate de la division disques durs de Samsung. Il ne reste donc plus que trois constructeurs : Western Digital (Hitachi), Toshiba (Fujitsu) et Seagate (Samsung, Maxtor, Quantum).

Avec ce rachat, Seagate porte sa part de marché à environ 40%, dont plus du quart provenant de Samsung. Le coût de l'opération est de près de 1.4 milliards de dollars, dont environ la moitié versée à Samsung sous forme d'actions Seagate. Ainsi, Samsung devient un important actionnaire de Seagate, avec 9.6% du capital. Le Coréen siégera d'ailleurs désormais au conseil d'administration de l'Américain et participera à l'élaboration de certains produits à venir. Les deux entreprises vont également partager leurs brevets.

Seagate a également négocié une position de client privilégié sur la mémoire flash NAND, utilisée dans les SSD. En effet, Seagate a obtenu la garantie que Samsung répondra prioritairement à ses commandes, évitant ainsi tout risque en cas de pénurie.

Posté par Matt le 20/04/2011 à 10h20

Aucun commentaire

Source : Clubic

Fort d'une importante croissance de ses ventes ces derniers mois, grâce à l'explosion du marché des tablettes, le français Archos souhaite se développer en investissant massivement dans son avenir. Et pour ça, Archos à besoin d'argent !

Ainsi, le français a lancé une procédure d'augmentation de son capital, en émettant 4 millions d'actions nouvelles. Ceci correspond à une augmentation d'environ 20% du capital de la société. En vendant ces nouveaux titres pour 6€50 (l'action Archos se négocie aujourd'hui un peu plus de 7€), Archos espère ainsi récupérer 30 millions d'euros d'argent frais.

Cette somme sera utilisé tout d'abord pour diminuer l'endettement de l'entreprise, en remboursant un emprunt de 5 millions d'euros contracté en 2008, mais aussi à financer le développement de la société et de sa filiale Arnova, créée il y a peu pour conquérir le marché de l'entrée de gamme.

Posté par Matt le 20/04/2011 à 09h12

Aucun commentaire

Source : PCWorld

Annoncé en janvier lors du CES, l'Eee Pad Slider d'Asus devait être une tablette Android 3.0 à clavier coulissant basée sur une plateforme nVidia Tegra 2, comme l'Eee Pad Transformer qui commence petit à petit à être disponible dans différents pays. Mais la Slider pourrait finalement adopter la plateforme Intel Oak Trail...

En effet, dans le kit presse proposé par Intel pour cette plateforme, le fondeur présente l'Eee Pad Slider comme étant une tablette exploitant la plateforme Oak Trail... Le kit presse évoquait également une autre tablette chez Asus, dans un format un peu plus classique. La présence de ces tablettes Asus dans le kit presse d'Intel est visiblement une erreur, le kit ayant rapidement été mis à jour par Intel pour supprimer toute référence à ces deux produits. Reste à voir si l'erreur était simplement une mise en ligne anticipée par rapport aux annonces d'Asus, où carrément une annonce erronée sur l'utilisation de la plateforme Oak Trail dans ces produits.

Pour rappel, la plateforme Oak Trail a été lancé il y a peu par Intel et vise principalement à imposer l'architecture x86 dans le monde des tablettes, avec le processeur Atom Z670 qui l'équipe. Si Asus sortait effectivement une Slider à base d'Atom, il sera donc intéressant de comparer ses performances et son autonomie à celles de la Transformer, pour voir qui de Oak Trail ou de Tegra 2 s'en tire le mieux en exploitant la même couche logicielle...

Mise à jour le 19/04/2011 à 22h20 : Asus a finalement confirmé travailler sur une tablette exploitant la plateforme Oak Trail. Mais Intel a tout de même fait une erreur dans son kit presse, la tablette Oak Trail d'Asus n'était pas l'Eee Pad Slider, mais un nouveau modèle non encore présenté par le taiwanais, tandis que la Slider conservera bien le Tegra 2 initialement prévu.

Actu originale : 19/04/2011 à 12h30

Posté par Matt le 19/04/2011 à 22h20

Aucun commentaire

Sources : Tom's Hardware

Annoncé par les rumeurs depuis plus d'un an et visiblement déjà bien avancé dans son développement, le service Google Music pourrait bien ne jamais voir le jour, ou en tout cas pas sous la forme que Google envisageait...

En cause, les industriels de la musique, avec lesquels Google n'aurait pas réussi à s'entendre sur les modalités tarifaires de son service. Selon certaines sources, Google envisageait, en plus de la vente de musique, de proposer un service de stockage en ligne, comme le fait Amazon avec Cloud Player, où l'utilisateur pourrait stocker ses propres fichiers musicaux pour y accéder de n'importe où en streaming. Alors que Google comptait offrir gratuitement une première tranche d'espace, les majors souhaiteraient que Google facture cet espace à l'utilisateur dès le premier octet...

Ces réticences des majors pourraient même pousser Google à changer totalement le principe de son service, en en faisant un simple service de stockage de données en ligne, sans orientation particulière pour la musique.

Posté par Matt le 19/04/2011 à 14h50

Aucun commentaire

Source : Le Journal du Geek

Très controversée lors de son élaboration, la loi Hadopi pourrait bien être au cœur des débats lors de prochaines présidentielles, qui se tiendront en avril et en mai 2012. Ainsi, après que le Parti Socialiste ait évoqué son abrogation dans son projet de programme, c'est au tour de Dominique de Villepin, candidat République Solidaire et ancien Premier Ministre d'évoquer une adaptation de l'Hadopi...

Ainsi, pour DdV, "la culture doit être un bien public accessible à tous les citoyens grâce à un service public de la culture". En clair, l'ancien Premier Ministre souhaite mettre en place un système de licence globale. Pas question toutefois pour lui de supprimer l'Hadopi, qui serait conservée pour éviter certains abus.

L'idée de DdV serait en fait d'autoriser le téléchargement gratuit des œuvres sur les réseaux P2P et sur des sites à caractère non lucratif (dépourvus de publicités), mais uniquement après un certain délai d'exploitation commerciale. Pour les films par exemple, le candidat évoque une libre diffusion sur les réseaux P2P à partir de 4 mois après la sortie en salle. Ce délai correspond actuellement au minimum légal séparant la sortie en salle de la sortie den DVD et VOD.

L'Hadopi serait donc là uniquement pour réprimer les échanges d'œuvres récentes et pour traquer les sites de téléchargement à caractère lucratif, tandis que le système de licence globale collecterait des fonds reversés aux ayant-droits pour compenser le manque à gagner. DdV ne semble par contre pas avoir évoqué comment la répartition des sommes prélevées serait calculé. Ce point pourrait pourtant être crucial pour faire accepter un tel système par les ayant-droits.

Du côté du PS, le projet est un peu plus clair à ce sujet, puisque, sans évoquer le mode de répartition, il précise le mode de prélèvement (sur les factures Internet), mais aussi et surtout, le caractère non systématique de cette licence : les ayant-droits auraient le choix entre accepter le système de licence globale, et donc autoriser le libre échange de leurs œuvres en échange d'une part de la rémunération, ou interdire ce libre échange, mais renoncer à toute rémunération autre que les ventes.

Il sera intéressant de voir les positions des autres candidats sur le sujet, qui sera probablement très difficile à éviter pendant la campagne, et pourrait même être un point particulièrement important pour attirer des électeurs. Mais encore une fois, il ne faudra pas oublier que les promesses de campagne n'engagent généralement que ceux qui y croient...

Posté par Matt le 19/04/2011 à 10h31

Aucun commentaire

Source : PCInpact

![]()

Suite au rachat de Sun par Oracle, des divergences d'opinion entre Oracle et la communauté sur l'avenir de la suite bureautique OpenOffice avaient fini par donner naissance à LibreOffice, un dérivé d'OpenOffice entièrement contrôlé par la communauté, tandis qu'Oracle gardait le contrôle d'OpenOffice, en proposant une version commerciale de la suite.

Finalement, quelques mois après cette séparation, Oracle a annoncé sa décision d'abandonner la version commerciale d'OpenOffice, tant décriée par la communauté. Conséquence de cet abandon, Oracle va replacer le projet OpenOffice sous le contrôle de la communauté. Reste à voir si cette nouvelle communauté OpenOffice saura attirer les développeurs... En effet, le gros des troupes à quitté le projet originel pour rejoindre LibreOffice, et il est loin d'être certain qu'ils refassent le chemin inverse.

Cette décision pourrait aussi attirer sur Oracle les foudres des autorités de régulation de la concurrence. En effet, pour que celles-ci approuvent l'opération, Oracle avait pris des engagements sur l'avenir d'OpenOffice et de MySQL. Or, il est désormais certains que ces engagements sur OpenOffice ne seront pas tenus, tandis que ceux sur MySQL semblent pour l'instant mal partis pour être tenus...

Posté par Matt le 19/04/2011 à 08h02

3 commentaires

Source : Silicon.fr

![]()

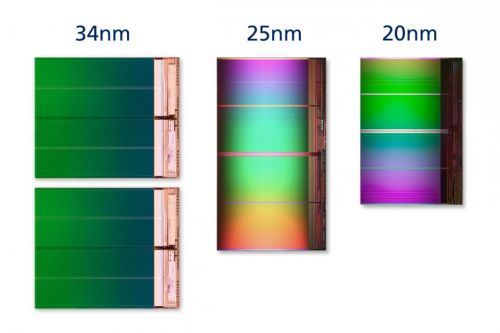

Moins d'un an après la commercialisation de sa mémoire flash gravée en 25nm, IMFT (une joint-venture entre Intel et Micron) vient d'annoncer préparer une nouvelle génération de mémoire flash NAND, gravée en 20nm.

D'une capacité de 8 Go, la première puce adoptant cette finesse de gravure n'occupe plus que 118mm² sur un wafer de silicium, contre 167mm² pour son équivalent en 25nm. Le gain en surface est donc de près de 30%, ce qui devrait se traduire par une baisse de prix du même ordre.

Par ailleurs, le fondeur a annoncé que cette nouvelle finesse de gravure devrait permettre d'atteindre les mêmes durée de vie qu'en 25nm, soit entre 3000 et 5000 cycles écriture-effacement pour les mémoires MLC à 2 bits par cellule. Enfin, ces nouvelles puces étant très proches des puces 25nm, leur adoption ne devrait nécessiter que des modifications mineures des produits les utilisant. Elles pourraient donc se répandre rapidement dans les produits à base de mémoire flash.

La fabrication débutera dans l'usine de Lehi (Utah). Intel et Micron adapteront ensuite les usines de Manassas (Virginie) et de Singapour à cette nouvelle finesse, au fil de la hausse de la demande.

Posté par Matt le 18/04/2011 à 14h51

Aucun commentaire

Source : PCWorld

Introduit il y a une quinzaine d'années, le format actuel de la Carte Nationale d'Identité ne donne plus satisfaction en terme de sécurité, ce qui donne lieu à de nombreuses fraudes et usurpations d'identité. Le gouvernement travail donc à un nouveau format, plus sécurisé.

Celui-ci devrait faire la part belle à l'électronique. Le gouvernement projette en effet d'incorporer dans la future carte d'identité une puce qui stockera différentes informations sur l'identité du titulaire de la carte : nom, prénom et date de naissance bien sûr, mais aussi photo numérisée et informations biométriques, comme les empreintes digitales, la taille, la couleurs des yeux et des cheveux, etc.... Si cette puce est correctement sécurisée, il sera donc très difficile de falsifier les cartes à ce format.

Plus intéressant pour les internautes, la carte pourrait, en option, contenir une signature numérique. Celle-ci permettrait par exemple de s'identifier de façon sécurisée sur un site Internet pour effectuer des achats, consulter ses comptes, ou encore échanger des courriers sécurisé. Ceci nécessiterait bien entendu de disposer d'un lecteur de cartes à puces sur l'ordinateur, mais ce genre d'appareil est d'ores et déjà disponible à très bas prix (la société de transport en communs de Grenoble en propose par exemple à ses usagers pour à peine 3€).

Posté par Matt le 18/04/2011 à 12h50

Aucun commentaire

Source : 01Net

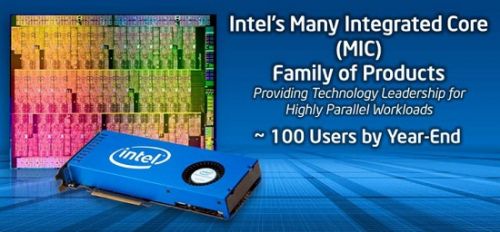

Depuis quelques années, les cartes graphiques nVidia et AMD se retrouvent de plus en plus souvent dans des calculateurs, en exploitant le principe du GP-GPU, qui consiste à utiliser la puissance des GPU pour effectuer des calculs non graphiques. Intel répond enfin à ce concept, avec son "Many Integrated Core", présenté lors du dernier IDF.

Many Integrated Core (MIC) est probablement une résurgence du projet Larrabee, abandonné depuis quelques temps déjà. Ce dernier consistait à mettre au point un GPU basé sur un grand nombre de petits cœurs x86. Et c'est exactement ce que propose MIC : une carte de calcul prenant place sur un port PCI-Express et contenant pas moins de 50 cœurs x86, gravés en 22nm.

Selon Intel, cette solution aura l'avantage d'être plus simple à utiliser que les solutions GP-GPU car, utilisant un jeu d'instruction x86, elle pourra être exploitée avec les outils de développement habituels. Bien que la puissance brute soit inférieure, cette solution a également l'avantage d'une grande indépendance entre les cœurs, alors que sur un GPU, les unités de calcul sont regroupés en "cluster", toutes les unités d'un même cluster devant traiter la même opération (mais sur des données différentes).

D'ici la fin de l'année, une centaine d'exemplaires de pré-série seront fournis par Intel a certains de ses partenaires. La date de sortie définitive n'a par contre pas été communiquée, et Intel n'a pas non plus évoqué de plans pour transformer MIC en carte graphique.

Posté par Matt le 18/04/2011 à 11h11

Aucun commentaire

Source : Clubic

![]()

Pour obtenir sa précieuse licence 3G, Free Mobile s'était engagé à fournir une couverture de 25% pour le lancement de l'offre en 2012, puis d'étendre cette couverture à 90% avant 2018. L'opérateur souhaite toutefois aller plus loin, et dépasser les taux de couverture actuels de ses concurrents.

En effet, Maxime Lombardini, directeur général d'Iliad, a indiqué que Free Mobile ambitionne une couverture de 99% en 2018. Selon les dernières mesures publiées par l'ARCEP en début d'année, les taux de couverture actuels d'Orange, SFR et Bouygues Télécom sont respectivement de 91%, 88% et 75%.

Pour arriver à ce résultat, Free Mobile envisage le déploiement d'au moins 9000 antennes-relais. Ces déploiement pourraient notamment se faire sur les sites actuellement exploités par Orange, ou encore ceux utilisés par Télédiffusion de France pour la diffusion de la TNT.

Avec un tel taux de couverture, Free Mobile aurait un bel argument pour vendre son offre. Reste à voir si l'opérateur sera capable d'atteindre ce niveau... Rappelons également qu'en téléphonie mobile les taux de couverture se mesurent en pourcentage de la population, et non en pourcentage du territoire, donc un taux de 99% peut tout de même laisser de larges zones blanches dans les campagnes.

Posté par Matt le 18/04/2011 à 08h47

2 commentaires

Source : Tom's Guide

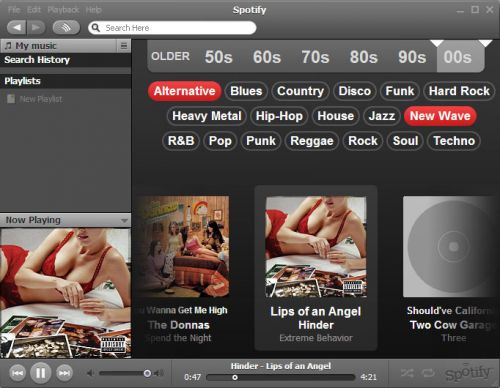

Malgré sa popularité, le service Spotify, qui permet d'accéder gratuitement à un large catalogue de musique en streaming, semble souffrir d'un modèle économique insuffisant à satisfaire ses besoins. En conséquence, l'accès gratuit au service est de plus en plus limité...

À ses débuts, le service proposait l'écoute en streaming illimité pour tous les inscrits, mais les utilisateur d'un compte gratuit devaient accepter quelques publicité en contrepartie, parfois sous formes d'images dans l'interface de Spotify, parfois sous forme de spot audio diffusé entre deux titres. Mais depuis un an environ, les utilisateurs d'un compte gratuit ont été limités à 20h d'écoute par mois.

Aujourd'hui, Spotify envisage de réduire encore plus cette limite, pour tenter d'équilibrer son financement. La limite passerait ainsi à seulement 10h par mois, tandis qu'une nouvelle règle limiterait à cinq par mois le nombre d'écoutes autorisées pour un même titre. Ces nouvelles restrictions devraient inciter certains utilisateurs à opter pour l'abonnement Unlimited à 5€ par mois, qui supprime ces limitations et les publicités, voir pour l'abonnement Premium à 10€, qui permet en plus d'accéder au service depuis un mobile, de bénéficier d'une meilleure qualité et d'un accès hors connexion.

C'est toutefois un pari risqué pour Spotify, qui pourrait perdre quelques clients avec ces nouvelles restrictions, qui pourraient rendre le service moins attractif que certains de ses concurrents.

Posté par Matt le 15/04/2011 à 16h00

Aucun commentaire

Source : Übergizmo

![]()

Même si le rythme de mise à jour à diminué, Free continue de travailler sur les firmwares de la Freebox Révolution, et a publié hier une nouvelle mise à jour du firmware du boîtier Free Player, qui passe à la version 1.0.3.3.

Freebox Player

Nouvelles fonctionnalités

- Ajout des portails Disney, ABC, INA et MyZen.tv dans la Vidéo à la demande.

Corrections

- Plantage lors de la lecture des bandes-annonces de certains DVD (FP #3580),

- Impossible de jouer un CD audio après la lecture d’un DVD (FP #6020),

- Impossible de provisionner le compte sur Duo Sexy,

- Freebox Player bloqué au démarrage lorsqu’un disque dur eSATA est branché.

Posté par Matt le 15/04/2011 à 12h50

Aucun commentaire

Source : L'actualité de la Freebox

Bien que les contrôleurs USB 3 soient disponibles depuis un bon bout de temps, les deux principaux fabricants de chipsets, Intel et AMD, n'ont toujours pas intégré cette norme à leurs produits. C'est finalement AMD qui sera le premier des deux à sortir des chipsets USB 3.0, dès cette année, alors qu'il faudra attendre 2012 chez Intel.

Les premiers chipsets AMD supportant l'USB 3.0 seront les chipsets A75 et A70M, qui devraient normalement accompagner le lancement de la plateforme Llano, prévue pour les semaines ou les mois à venir.

Chez Intel, les premiers chipsets intégrant l'USB 3.0 devraient être les chipsets accompagnant les processeurs Ivy Bridge, prévus pour le premier trimestre 2012.

Posté par Matt le 15/04/2011 à 10h50

Aucun commentaire

Source : Macbidouille

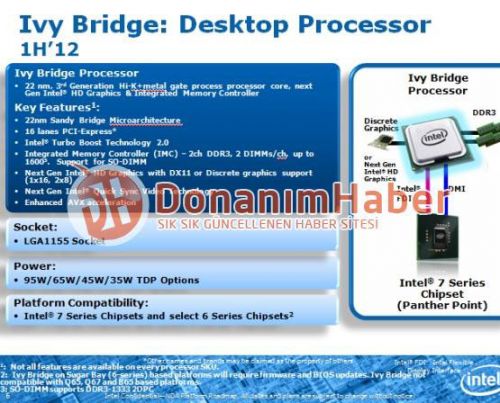

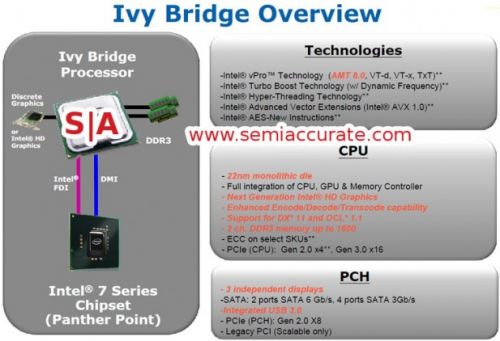

Il y a un peu plus de deux mois, on apprenait que les futurs processeurs Ivy Bridge d'Intel allaient prendre place sur le socket 1155, actuellement utilisé par les Sandy Bridge, ce qui laissait entrevoir une compatibilité avec les cartes mères actuelles. De nouvelles sources confirment cette compatibilité.

En effet, le site turc DonanimHaber a mis la main sur un document interne d'Intel, qui donne plus de précisions sur le futur processeur. Le document confirme le passage à une gravure 22nm, le support de la DDR3 1600, l'amélioration du jeu d'instructions AVX et le passage à une nouvelle génération de puce vidéo Intel HD Graphics compatible avec DirectX 11.

Mais surtout, ce nouveau document indique explicitement la compatibilité avec les chipsets utilisés actuellement avec les processeurs Sandy Bridge (chipsets série 6). Cette compatibilité ne sera toutefois que partielle, en se limitant aux chipsets grand public Z68, P67, H67 et H61, tandis que les versions professionnelles Q67, Q65 et B65 seront laissées de côté.

Dans ce document, Intel précise tout de même aussi que la compatibilité ne sera assurée que sous réserve de disponibilité d'une mise à jour du BIOS/EFI. La compatibilité dépendra donc en partie de la bonne volonté des constructeurs de cartes mères.

Posté par Matt le 15/04/2011 à 08h30

Aucun commentaire

Source : Hardware.fr

Wallpaper Rotator vient d'être mise à jour. L'application a été en grande partie réécrite en utilisant le framework Qt, et propose quelques nouvelles fonctionnalités. Les sources sont désormais disponibles sous licence CeCILL-B. Pour l'occasion, Wallpaper Rotator passe en version 2.

Historique des changements :

- possibilité de définir un intervalle de temps personnalisé entre deux rafraichissements,

- ajout d'une boîte de dialogue permettant de choisir les emplacements où chercher les fonds d'écran,

- possibilité de choisir plusieurs emplacements source en simultané,

- utilisation du framwork Qt,

- passage sous licence CeCILL-B 1.0.

Posté par Matt le 14/04/2011 à 22h29

Aucun commentaire

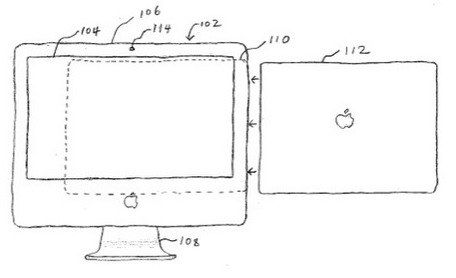

Il y a quelques mois, un développeur avait réalisé une application permettant de synchroniser un iPhone avec iTunes via Wi-Fi. Rejetée de l'App Store par Apple au motif qu'elle posait des problèmes de sécurité, l'application est depuis disponible pour les iPhone jailbreakés. La synchronisation via Wi-Fi pourrait toutefois arriver officiellement, en commençant par la prochaine génération d'iPod.

En effet, selon Cult of Mac, Apple serait sur le point de finaliser sa propre solution de synchronisation via Wi-Fi, et elle pourrait donc être proposée sur la prochaine génération d'iPod, qui devrait arriver au mois de septembre, période habituelle du renouvellement de la gamme. pour ce faire, il faudra bien entendu ajouter une puce Wi-Fi aux iPod Shuffle, Nano et Classic, qui en sont absolument dépourvu.

Toujours selon Cult of Mac, ces nouveaux iPod pourraient par la même occasion changer de design, avec l'adoption d'une coque en fibre de carbone, qui laisserait mieux passer les ondes que les coques métalliques actuellement utilisées par la pomme. Une rumeur appuyée par le fait qu'Apple a récemment embauché un spécialiste des matériaux composites, qui avait travaillé au préalable sur des cadres de vélo en carbone.

Si une telle fonctionnalité était proposée pour les iPod, il y a fort à parier qu'elle arrive aussi quelques semaines ou quelques mois plus tard pour les différents appareils sous iOS, d'autant plus qu'ils ont l'avantage d'être déjà tous dotés d'une connectivité Wi-Fi. Une simple mise à jour logicielle serait donc suffisante.

Posté par Matt le 14/04/2011 à 14h30

2 commentaires

Source : Macbidouille

Peu de temps après avoir lancé sa plateforme Atom Oak Trail, visant principalement le monde des tablettes tactiles, Intel confirme son intérêt pour ce secteur de marché, en s'associant avec le chinois Tencent pour un centre de recherche et développement dédié aux tablettes.

Doté dans un premier temps d'une équipe d'une soixantaine d'ingénieurs issus des deux partenaires, le centre de recherche, installé en Chine, s'occupera aussi bien des aspects matériels et système, sous la houlette d'Intel, que de la partie logicielle, de l'interface utilisateurs et des services associés, sous la direction de Tencent. Ce centre de recherche devrait notamment travailler sur la plateforme MeeGo, pour laquelle l'implication de Nokia pourrait aller décroissant suite au partenariat avec Microsoft.

À terme, l'effectif du centre de recherche pourrait dépasser 200 personnes, tout en étendant le champ d'application de ses travaux. Toujours en Chine, Intel travaillerait aussi main dans la main avec l’équipementier ZTE, spécialisé dans les technologies pour réseau cellulaire. Ce partenariat pourrait mener à la commercialisation du premier smartphone à base d'Atom Oak Trail.

Posté par Matt le 14/04/2011 à 12h56

Aucun commentaire

Source : Génération NT

Il y a quelques temps, un projet de loi sur la neutralité du net avait été bloqué au motif qu'un rapport sur le sujet était en préparation par deux députés, Laure de la Raudière (UMP) et Corinne Erhel (PS). Ce rapport ayant été présenté, les débats sur le sujet vont pouvoir être ré-ouverts.

Bonne nouvelle, ce rapport semble plutôt en faveur d'une neutralité garantie par la loi, avec des propositions allant dans le sens de la liberté d'expression de la protection de l'innovation et du financement du réseau. Par exemple, alors que la récente loi LOPSSI permet de blocage de sites sans intervention d'un juge, les deux députés préconisent plutôt le recours systématique à un juge pour valider ou non une demande de blocage. Elles invitent aussi à ne demander aux opérateurs de bloquer les communications qu'en dernier recours, pour éviter de restreindre la liberté d'expression, mais aussi pour éviter une escalade dans les mesures techniques de contournement des filtrages.

Le rapport évoque aussi le problème de la qualité de service. En effet, face à l'explosion de la consommation de bande passante, certains opérateurs, en particulier les opérateurs mobiles, ont commencé à mettre en place des règles de priorité, voir des blocages, pour favoriser certains services au détriments des autres. Dans de tels cas, le rapport propose d'interdire aux opérateurs d'utiliser le terme "Internet" pour décrire leur offre, ce terme devant être réservé aux offres fournissant un accès "neutre", où tous les services sont à égalité. C'est l'ARCEP qui serait chargé de surveiller ces pratiques.

Une version préliminaire de ce rapport est disponible en ligne. La version définitive devrait mener à l'élaboration de nouvelles lois, mais aussi à la modification de certaines lois existantes.

Posté par Matt le 14/04/2011 à 10h40

Aucun commentaire

Source : Clubic

Quelques semaines après la sortie d'Internet Explorer 9, Microsoft a profité de la conférence MIX 2011 pour présenter et publier la première "platform preview" de Internet Explorer 10. Mais la démonstration ne s'est en fait pas limité au nouveau Internet Explorer...

En effet, si cette démonstration a été effectuée sur une machine sous Windows 7, il ne s'agissait pas du Windows 7 de monsieur tout le monde : la plateforme de démonstration était animée par un SoC nVidia Tegra 2. Microsoft avait promis que Windows 8 supporterait l'architecture ARM, et visiblement le portage a donc déjà commencé avec Windows 7. D'après les personnes présentes lors de la démonstration, le système semblait fonctionner convenablement, et bénéficier d'une bonne réactivité.

Côté Internet Explorer, cette première "platform preview" apporte un meilleur support des technologies web les plus récentes, et notamment les gradients CSS3. Internet Explorer 10 devrait arriver en version finale fin 2012, et, d'ici là, Microsoft promet une nouvelle "platform preview" toutes les 8 à 12 semaines, pour rendre compte de l'avancée. La prochaine version devrait par exemple supporter les transformations 3D CSS3.

Posté par Matt le 14/04/2011 à 08h21

Aucun commentaire

Source : Tom's Hardware

Gros consommateur d'électricité avec ses nombreux datacenters, Google a depuis longtemps compris qu'investir dans les économies d'énergie et les énergies renouvelables pouvait faire réduire ses frais de fonctionnement. De nombreux locaux de Google sont donc couverts de panneaux solaires ou dotés d'éolienne. Mais ce n'est rien à côté du dernier projet de la firme...

En effet, Google a investi 168 millions de dollars dans un projet majeur, la centrale Ivanpah Solar Electric Generating System. Construite dans le désert de Mojave, en Californie, cette centrale sera parmi les plus puissantes centrales solaires du monde, avec une puissance de 392MW. Les rejets de CO2 économisés par cette centrale sur les 25 ans minimum de son exploitation sont selon Google l'équivalent du retrait de 90 000 voitures du parc automobile américain. En construction depuis octobre 2010, la centrale devrait entrer en production en 2013.

Pour arriver à une telle puissance, la centrale va s'appuyer sur une technologie solaire thermique, dont la fabrication est nettement moins polluante que celle du photovoltaique, tout en offrant des rendements et une durée de vie supérieurs. L'installation va se baser sur un réseau de 173 000 miroirs motorisés pour suivre le déplacement du Soleil (héliostats), qui vont concentrer les rayons solaires au somment d'une tour de 140m de hauteur. Là, un fluide sera porté à haute température (540°C) pour générer de la vapeur sous pression, qui entrainera une turbine.

Bien moins connue que le photovoltaïque, cette technologie est toutefois largement éprouvée, avec plusieurs centrales expérimentales ou industrielles dans le monde depuis plus de dix ans, y compris en France, où a été construite l'une des premières centrales solaire de ce type, la centrale expérimentale Thémis dans les Pyrénées, qui fêtera bientôt ses 30 ans.

Avec cet investissement, Google apporte donc sa contribution au développement d'une des technologie de production d'électricité les plus prometteuses pour l'avenir, le solaire thermique étant l'une des solutions les plus propres, au cœur de nombreux projets à venir : les projets en cours totalisent une puissance de près de 3GW, dont la moitié aux États-Unis, et, sur le plus long terme, le projet Désertec-Eumena prévoit de fournir la moitié de l'électricité nécessaire pour l'Europe et quasiment toute celle consommée par les pays d'Afrique du Nord via un gigantesque réseau de centrales solaires thermiques installées en Afrique du Nord et dans la péninsule arabique, complété par des centrales éoliennes, hydrauliques, géothermiques, photovoltaïques et biologiques disséminées en Afrique du Nord en Europe et au Moyen-Orient.

Posté par Matt le 13/04/2011 à 15h00

1 commentaire

Source : Clubic

Amazon a présenté aux États-Unis une nouvelle version de son lecteur de livres numériques, le Kindle. Reprenant exactement le même matériel que le modèle actuellement vendu 139$, ce nouveau modèle sera disponible pour 114$. Une baisse de tarifs en contrepartie de laquelle l'interface de l'appareil sera agrémentée de publicités...

Amazon promet heureusement que ces publicités ne viendront pas troubler la lecture des possesseurs de l'appareil. Ces publicités, qui prendront la forme d'offres spéciales (réductions sur des livres numériques ou sur des albums en MP3 par exemple) seront insérées dans une zone dédiée en bas de l'écran d'accueil, ainsi que sur l'écran de veille de l'appareil.

Si ces publicités ne sont pas trop intrusives, elles constitueront donc un bon moyen d'économiser 25$ sur l'achat de l'appareil (soit tout de même 18% de réduction), ce qui devrait faire du bien au Kindle, qui souffre de la concurrence des tablettes tactiles, certes moins confortables et moins autonomes, mais beaucoup plus polyvalentes.

Posté par Matt le 13/04/2011 à 12h40

Aucun commentaire

Source : 01Net

Après l'annonce de son accord avec Microsoft pour la production de smartphones sous Windows 7, Nokia avait précisé que Symbian ne serait pas abandonné à court terme. Le finlandais vient de le prouver avec le lancement de deux nouveaux smartphones, accompagnés d'une nouvelle version de Symbian.

Baptisé E6, le premier est smartphone destiné au marché professionnel, reprenant un design façon BlackBerry, avec un écran en mode paysage et un clavier complet sur la partie inférieure de la façade. Avec son processeur à 680 MHz, ses 8 Go de stockage et son écran de 2.5", il risque toutefois de souffrir de la comparaison avec les smartphones d'autres marques, même s'il se distingue avec son APN de 8MP. Il pourrait par contre profiter de son tarif contenu (430€ TTC), de son port USB hôte et de son excellente autonomie (annoncée à 5 jours en utilisation normale) pour se faire sa place sur le marché.

Nettement plus orienté grand public, le X7 embarque la même base matérielle que le E6, mais troque l'écran paysage et le clavier contre un écran portrait AMOLED 640x360 couvrant la façade de l'appareil. Il sera vendu 450€ TTC. Comme le E6, il risque de souffrir du manque de puissance de son processeur, mais Nokia se défend en indiquant qu'une puce à 680 MHz suffit pour un appareil sous Symbian, le système étant peu gourmand et capable de tirer parti de l'accélération matérielle. Cette fréquence réduite est aussi un plus pour l'autonomie.

Côté système, des nouveaux Nokia embarqueront la toute nouvelle version de Symbian, baptisée Anna. Dotée d'une ergonomie améliorée, d'un navigateur web plus rapide et de la nouvelle version d'Ovi Cartes gérant les transports en commun, cette nouvelle version du système vise également les professionnels, avec la prise en charge du chiffrement matériel et de nouvelles fonctions collaboratives au niveau de la messagerie.

Cette version de Symbian ne sera pas réservée aux nouveaux appareils. Les actuels N8, E7, C7 et C6-01 auront droit à une mise à jour dans les mois à venir.

Posté par Matt le 13/04/2011 à 11h00

Aucun commentaire

Source : Business Mobile

Lancée par Apple et Intel il y a six semaines, cette interface est très intéressante sur le papier, mais souffre pour l'instant de l'absence de périphériques l'exploitant, même si LaCie et Promise ont déjà annoncé des solutions de stockage à cette norme. Avec le NAB 2011, la situation commence toutefois à évoluer...

Constructeur d'accessoires pour Mac, principalement dans le domaine du stockage et des cartes d'extensions, Sonnet a ainsi dévoilé une nouvelle gamme de produits, qui sera présentée en détail au NAB 2011.

La gamme commence avec du très classique, trois périphériques de stockage externe. Le premier embarque deux SSD en RAID0, le second offre quatre baies pour disque dur 3.5" SATA et le troisième en propose huit. Sonnet commercialisera également deux adaptateurs, l'un offrant une connectique Gigabit Ethernet, le second offrant un port Firewire 800.

Mais les deux produits les plus originaux et les plus intéressants sont probablement deux boîtiers permettant de connecter une carte PCI-Express via Thunderbolt. Le premier est destiné à des cartes de petite taille (pas plus longue que le port PCI-E 16x) et ne consommant pas plus de 75W, tandis que le second pourra accepter des cartes deux fois plus longues et consommant jusqu'à 150W. Dans les deux cas, le connecteur interne est un connecteur au format 16x, mais câblé seulement en 4x. Ces boîtiers permettront par exemple d'ajouter une carte graphique à un ordinateur portable.

Le NAB 2011 a également être l'occasion de présenter des périphériques Thunderbolt pour d'autres constructeurs spécialisés dans les solutions audio/vidéo. Par exemple, Matrox y a montré un adaptateur Thunderbolt pour ses boîtiers MXO2 (qui se connectent actuellement via une interface PCI-Express externe dans un format propriétaire), tandis que Blackmagic Design a présenté l'UltraStudio 3D, un boîtier d'acquisition vidéo haut de gamme.

Posté par Matt le 13/04/2011 à 08h21

Aucun commentaire

Source : Tom's Hardware

![]()

C'est en tout cas ce que promet le Parti Socialiste dans son projet pour la présidentielle 2012, à condition bien sûr que le candidat choisi à l'issu des primaires conserve cette idée dans son programme, et qu'il soit élu le 6 mai 2012...

En effet, le projet du PS indique que "l'adaptation du droit d'auteur à la révolution numérique passe plus que jamais par l'émergence d'un nouveau modèle économique réellement rémunérateur et redistributif pour les ayant-droits et non par des lois pénales que nous abrogerons". Rapidement, des journalistes ont supposé que les "lois pénales" mentionnées étaient le volet répressif de l'Hadopi et les dispositifs de filtrage autorisés par la loi LOPPSI.