Actualités du mois de novembre 2011 (Matériel)

Outre la version Windows de son Kinect, Microsoft travaillerait actuellement à la version 2 de l'appareil, qui sera destiné à la prochaine génération de Xbox, attendue pour 2012 ou 2013. Un nouveau Kinect qui serait beaucoup plus performant que l'actuel...

En effet, si le concept de Kinect est intéressant, il souffre encore parfois d'un manque de réactivité, mais aussi d'une capacité de reconnaissance limitée, qui ne permet pas d'exploiter tout le potentiel du concept. Mais selon des fuites provenant de l'équipe de développement, Kinect 2 améliorerait grandement les choses. Le nouvel appareil serait par exemple en mesure de reconnaitre les émotions des joueurs grâce à l'analyse de leurs expressions faciales et du ton de leur voix. Il serait même capable de lire sur les lèvres.

Pour rappel, le Kinect est un périphérique pour Xbox 360 qui, grâce à un jeu de caméras, détecte les mouvements et la position du joueur pour les retranscrire en actions dans les jeux. Avec un système plus efficace, il sera donc possible de rendre les jeux encore plus immersifs. On pourrait par exemple envisager des jeux de tirs où le viseur passerait en mode sniper lorsque le joueur ferme un œil, ou encore des jeux de rôle où les émotions du joueur seraient retranscrites en temps réel sur son avatar.

Posté par Matt le 30/11/2011 à 13h10

Aucun commentaire

Source : Übergizmo

Quelques mois après son abandon par Mindscape, une nouvelle vie devrait prochainement commencer pour le petit lapin communicant, grâce au française Aldebaran Robotics, qui vient d'annoncer avoir repris le bébé.

Déjà connu pour son robot NAO, qui avait notamment permis de débloquer une grosse subvention d'Intel, Aldebaran Robotics promet la mise en place de nouveaux serveurs pour héberger les services existants, en se basant sur le code libéré par Mindscape, mais annonce aussi le développement de nouveaux services pour les modèles les plus récents, et notamment des services de reconnaissance et de synthèse vocale. À quand Siri sur Nabaztag ?

Aldebaran n'a par contre pas encore indiqué de date précise pour le lancement de ces nouveaux serveurs, et, malheureusement pour les fans du Nabaztag, n'a pour l'instant pas évoqué l'arrivée de nouveaux produits dans la gamme. Mais le simple fait de fournir à nouveau les services indispensables au fonctionnement de la bête devrait déjà ravir les propriétaires, dont le lapin était pour l'instant devenu un onéreux presse-papier.

Espérons pour Aldebaran Robotics que la société ne connaitra pas le même sort que les deux précédents éleveurs de lapins, Violet et Mindscape.

Posté par Matt le 29/11/2011 à 13h10

Aucun commentaire

Source : PCWorld

Outre le problème de la capacité et du temps de charge, qui freine les possibilités, les batteries actuelles souffrent généralement d'une durée de vie assez limitée, qui dépasse rarement les 1000 cycles de charge/décharge. Mais les chercheurs de Stanford seraient sur le point de trouver une solution.

Une équipe de chercheurs de la prestigieuse Université de Stanford (Californie) a en effet réussi à multiplier par 100 le nombre de cycles que peut tolérer une batterie, passant de 400 à 40 000 cycles. Pour ce faire, ils ont simplement remplacé les électrodes classiques par des électrodes en hexacyanoferrate de cuivre. Les électrodes ainsi réalisées s'usent bien moins au fil des charges/décharges, d'où le gain sur la durée de vie de la batterie.

Selon les chercheurs, cette nouvelle technologie aurait de plus l'avantage d'être très peu onéreuse à la fabrication, engendrant donc un surcoût minime à la production. Par contre, le procédé n'est malheureusement pas encore parfaitement au point, et il faudra donc encore patienter avant d'arriver à une solution industrialisable. Il faudra aussi que les constructeurs soient intéressés par cette technologie, qui pourrait fortement freiner les ventes de batteries...

Posté par Matt le 29/11/2011 à 10h41

5 commentaires

Source : Génération NT

Si la Chine reste un pays au niveau de vie plus faible que dans les pays occidentaux, ce niveau de vie croit rapidement, et la population importante de la Chine fait que le nombre de Chinois bénéficiant d'un niveau de vie "occidental" est déjà plus que significatif. Une situation de plus en plus visible dans les ventes de produits hi-tech.

Ainsi, alors que le dernier rapport trimestriel d'Apple montrait déjà qu'une part importante de la croissance des ventes provenait de la Chine, une étude de Strategy Analytics montre que depuis le troisième trimestre 2011, la Chine est devenu le premier marché mondial pour la vente de smartphones, avec 23.9M d'unités vendues (en hausse de 57.5% sur un an) soit 600 000 de plus qu'aux États-Unis, qui deviennent le second marché, avec une baisse des ventes de 7% sur un an.

Ce boom du smartphone profite pour l'instant surtout à Nokia et Samsung, qui, avec 6.8M (+28.5%) et 4.2M (+17.6%) d'unités occupent les deux premières places, mais les fabricants Chinois pourraient les rattraper rapidement vu leurs taux de croissance : ZTE à quasiment doublé ses ventes (+95%) tandis que celles d'Huawei ont augmenté de 80%.

Posté par Matt le 24/11/2011 à 14h51

Aucun commentaire

Source : PCInpact

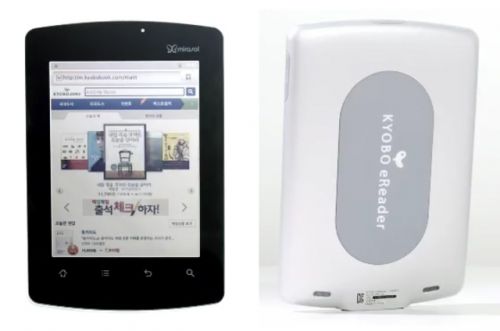

Depuis l'arrivée des tablettes, les lecteurs d'e-books ont perdu beaucoup de leur attrait. Face aux écrans LCD aux couleurs chatoyantes proposées par les tablettes, les écrans e-ink en niveau de gris très peu contrastés sont effectivement bien fades, empêchant d'utiliser ces appareils pour la lecture de BD, de magazines ou de sites web. Mais l'heure de la revanche à sonnée avec l'arrivée des écrans Mirasol.

Présentée par Qualcomm il y a plus d'un an, la technologie Mirasol repose sur un principe proche de celui mis en œuvre dans les écrans e-ink : des éléments de couleurs "mécaniques" dont la capacité à renvoyer ou non la lumière peut être modifiée par le circuit électronique de l'écran. Dans l'e-ink, il s'agit de billes avec une face blanche et une face noire, dans Mirasol il s'agit d'éléments de couleurs qui renvoient plus ou moins la lumière en fonction de leur distance par rapport à la surface de la dalle, distance contrôlée par des MEMS.

Dans les deux cas, on obtient un écran fonctionnant sans rétroéclairage et ne consommant de l'énergie que lors du changement d'état des pixels et parfaitement lisibles en pleine lumière, mais en perdant par contre en contraste et en réactivité par rapport aux écrans LCD ou OLED, ce qui les limite aux contenus peu animés. C'est donc idéal pour la lecture, l'absence de rétroéclairage limitant également la fatigue visuelle.

Très attendus dans les lecteurs d'e-books, les écrans Mirasol commencent enfin à arriver. C'est le Coréen Kyobo qui dégaine le premier produit basé sure cette technologie, le Kyobo eReader, qui est d'ores et déjà disponible dans son pays natal pour environ 230€, avec quelques mois d'avance sur le planning de Qualcomm pour l'application commerciale de sa technologie.

Doté d'un écran de 5.7" d'une définition de 1024x768, l'écran est selon Kyobo suffisamment réactif pour permettre de lire des vidéos. L'appareil est d'ailleurs équipé en conséquence, puisqu'il embarque un processeur double-cœur Qualcomm SnapDragon S2 à 1.2 GHz et fonctionne sous une version modifiée d'Android 2.3/Gingerbread. Grâce à son écran Mirasol, il atteint plusieurs semaines d'autonomie.

Voilà qui augure pour 2012 une belle bataille entre les tablettes traditionnelles, plus polyvalentes mais moins autonomes, et les lecteurs d'e-books, qui vont multiplier leurs usages grâce aux écrans couleurs.

Posté par Matt le 24/11/2011 à 12h31

Aucun commentaire

Source : PCWorld

Alors que les connexions Ethernet 10 Gbit/s commencent lancement à se démocratiser, le japonais Rohm promet déjà une technologie offrant un débit trois fois supérieur et sans-fil grâce à l'utilisation d'ondes à très haute fréquence, de l'ordre du térahertz.

Mis au point en collaboration avec l'Université d'Osaka, le premier prototype de puce exploitant cette technologie permet déjà des débit d'1.5 Gbit/s avec une puce plus petite qu'une pièce de 10 yens (soit environ 10 centimes d'euros, donc une petite pièce...) et une antenne d'à peine 2 cm de long pour 1 cm de large. Il y a encore du chemin à faire pour arriver à 30 Gbit/s, mais le débit de 1.5 Gbit/s est déjà très supérieur à la plupart des solutions sans-fil existantes.

Mieux, le coût de production de cette puce ne serait que de quelques centaines de yens (si vous suivez bien, vous devez en déduire que ça ne fait donc que quelques euros), alors que les meilleures puces sans-fil THz actuelles coûtent plusieurs millions de yens (plusieurs dizaines de milliers d'euros), occupent 20cm² (environ une demi carte de crédit) et plafonnent à seulement 100 Mbit/s.

Rendez-vous dans trois à quatre ans pour voir ces puces entrer en production et découvrir quel est leur réel potentiel. Il faudra particulièrement surveiller la porté de leur signal, les ondes de haute fréquence n'étant pas réputées pour leur capacité à traverser les obstacles.

Posté par Matt le 24/11/2011 à 08h12

Aucun commentaire

Source : Übergizmo

Depuis sa sortie il y a deux ans, Windows 7 supportent l'instruction TRIM sur les SSD, qui permet d'augmenter leur durée de vie et de réduire les pertes de performances liées à la fragmentation interne de la mémoire Flash. Cette instruction va enfin être supportée par les pilotes RAID0 Intel.

Avec les pilotes Rapid Storage Technology 11.5, il deviendra donc enfin possible de monter un RAID0 de SSD sur un chipset Intel sans perdre l'usage de la commande TRIM. Une perte qui avec le temps faisait perdre l'intérêt du RAID0, le gain de performances apporté par la parallélisation pouvant être annulé par la baisse de performances provoquée par la fragmentation.

Posté par Matt le 22/11/2011 à 14h11

Aucun commentaire

Source : TTHardware

Dans la course à la finesse pour les tablettes et les ordinateurs ultra-portables, la question du stockage oblige souvent à un dilemme : privilégier la finesse, en optant exclusivement pour de la mémoire flash, ou privilégier la capacité, en optant pour un disque dur ? Une équipe de chercheurs travaille a une solution intermédiaire qui pourrait s'avérer intéressante.

En effet, alors que les disques durs 2.5" standard font actuellement 9.5mm d'épaisseur et que quelques rares modèles se contentent de 7mm, les chercheurs du Data Storage Institute (entité de la Singapore Agency for Science) ont réussi à mettre au point un disque dur 2.5" de moins de 5mm d'épaisseur. La plus grande difficulté a été la réalisation d'un moteur axial d'à peine 4mm d'épaisseur.

Ce gain en finesse devrait se faire sans sacrifier les performances, le moteur réalisé étant capable de monter jusqu'à 7200 tours par minute. La capacité sera par contre limitée, le châssis ne pouvant accueillir qu'un seul plateau. De quoi proposer tout de même des capacités dépassant les 500 Go, ce qui serait un gros progrès par rapport aux quelques dizaines de Go de mémoire flash embarquée dans les tablettes.

Les chercheurs travaillent également à intégrer un peu de mémoire flash à leur produit, pour en faire un disque hybride, et ainsi ne pas trop sacrifier l'autonomie des tablettes et ultra-portables auxquels il sera intégré.

Posté par Matt le 22/11/2011 à 08h30

Aucun commentaire

Source : Macbidouille

Après l'explosion des prix des disques durs en octobre suite aux inondations en Thaïlande, les tarifs se sont plus ou moins stabilisés entre 2 et 3 fois les prix d'avant la catastrophe. Les prix devraient commencer à bosser dans les semaines à venir.

En effet, alors que les usines relancent petit à petit leur production, les principaux grossistes commencent à retrouver un approvisionnement normal, et donc à revoir leurs tarifs à la baisse. Selon certains estimations, le retour à la normale des prix, qui était initialement attendu pour mi-2012 pourrait finalement avoir lui dès février, voir janvier.

Seagate, bien qu'il soit l'un des constructeur les moins affectés, à une vision beaucoup plus pessimiste. En effet, selon le CEO, le marché du disque dur ne devrait pas être revenu à la normale avant la fin de l'année prochaine. Il indique qu'aucune usine de Seagate et que très peu d'employés ont été affectés, mais qu'une bonne partie des 130 fournisseurs dont la production dépend sont encore sous 1m d'eau.

Selon DigiTimes, sur l'ensemble du quatrième trimestre, la baisse de production serait de 67 millions d'unités chez Western Digital (-36M), Seagate (-9M), Hitachi (-11M) et Toshiba (-10M) par rapport au troisième trimestre, durant lequel ces quatre constructeurs avaient livré 162 millions de disques durs, alors que la demande serait en hausse de 18 millions d'unités.

Posté par Matt le 21/11/2011 à 08h53

Aucun commentaire

Sources : PCWorld et Tom's Hardware

En avril dernier, Intel présentait Many Integrated Core, un projet dédié au calcul hautes performances construit sur les cendres du projet abandonné de carte graphique x86 Larrabee. Avec Knights Corner, ce projet devient une réalité commerciale.

Comme Intel l'avait annoncé en avril, la puce contient pas moins de 50 cœurs x86 22nm, basés sur l'architecture P55C du Pentium, mais probablement largement optimisé pour doper sa puissance de calcul, puisqu'Intel annonce une puissance brute de 1 Tflops en double précision pour l'ensemble de la puce, soit 20 Gflops par cœur. Un score qui s'approche de celui d'une puce Sandy Bridge, qui atteint 32 Gflops par cœur sur les instructions AVX.

Ajouté aux cartes mères en tant que co-processeur, cette puce pourrait donner d'excellent résultats dans le milieu du HPC. Elle offre en effet des performances au niveau de celles d'une solution GPGPU, mais l'utilisation du jeu d'instruction x86 pourrait la rendre plus simple à programmer, donc à exploiter pleinement.

Posté par Matt le 18/11/2011 à 12h36

Aucun commentaire

Source : Macbidouille

En un peu plus de 13 ans d'existence, Google a connu beaucoup de succès et s'est taillé une place de choix sur de nombreux marchés. Mais cela n'empêche pas le géant de la recherche de connaitre quelques échecs. Il semblerait que ça soit le cas du concept Chromebook...

Lancés il y a six mois, les Chromebook sont des ordinateurs portables low-cost, très proches des netbooks, dotés du système d'exploitation Chrome OS de Google, qui a la particularité de s'articuler autour du navigateur web, pour n'utiliser que des web app. Un concept qui pouvait être intéressant sur le papier, en éliminant toute problématique de maintenance logicielle, mais qui souffre tout de même de deux défauts : pour profiter pleinement d'un Chromebook, il faut une connexion Internet sans-fil permanente, souvent couteuse, et le prix de vente des machines est plutôt élevé compte tenu de leurs caractéristiques.

Résultat des courses, six mois après le lancement, les chiffres de ventes chez les deux constructeurs (Acer et Samsung) sont bas, et même ridiculement bas... Acer indique ainsi n'avoir écoulé que 5 000 exemplaires de son Cromia 761, tandis que Samsung préfère n'indiquer aucun chiffre sur ses propres ventes...

S'il veut relancer son concept, Google va donc devoir revoir sa copie. L'américain tenterait notamment de commencer par populariser Chrome OS auprès des utilisateurs, en incitant les constructeurs de PC à livrer des machines dotées de Chrome OS en double boot. Peut-être qu'une convergence avec Android serait également la bienvenue, mais elle ne semble pas être à l'ordre du jour pour l'instant.

Posté par Matt le 18/11/2011 à 08h31

Aucun commentaire

Source : Génération NT

Depuis des années, l'autonomie des produits mobiles est un problème récurrent, d'autant plus que le temps de recharge est parfois long, voir très long. Les chercheurs de la Northwestern University (Chicago) pourraient avoir trouvé une solution résolvant les deux problèmes.

En effet, en remplaçant les habituelles anodes de graphite des batteries Lithium-Ion par des anodes constituées de feuilles de graphènes perforées de trous d'une dizaine de nanomètres et recouvertes de silicium, les chercheurs ont réussi à augmenter très fortement la surface d'échange à l'anode, permettant donc d'augmenter le débit d'électrons. Les chercheurs vont désormais travailler sur un traitement similaire à appliquer à la cathode, et envisagent d'arriver à un produit industrialisable dans trois à cinq ans.

Le procédé permettrait également d'augmenter la capacité des batteries à encombrement égal, mais au prix par contre d'une baisse plus rapide de la capacité au fil des charges : au bout de seulement 150 charges, la moitié du gain de capacité par rapport à une batterie Lithium-Ion classique serait déjà perdue.

S'ils y parviennent, cette technologie promet des batteries pouvant se recharger dix fois plus vite et offrant une capacité dix fois supérieur. De quoi donner en quinze minutes une semaine d'autonomie à un smartphone... à condition bien sûr de disposer d'un chargeur de puissance suffisante, les 2.5W de l'USB étant bien insuffisants pour ça...

Posté par Matt le 17/11/2011 à 10h21

Aucun commentaire

Source : Macbidouille

Après avoir créé la surprise en début d'année en annonçant un partenariat stratégique avec Microsoft et l'abandon des OS mobiles maison, Nokia vient de lancer son premier smartphone fruit de ce partenariat, le Lumia 800 sous Windows Phone 7.5.

L'OS étant en rupture avec les produits habituels de Nokia, le finlandais a choisi un design lui aussi en rupture, en reprenant le châssis coloré à tranche arrondi du N9, qui fait un peu penser à un iPod Mini de première génération, surmonté d'un écran tactile 3.7" AMOLED dépassant de la façade. On aime ou on n'aime pas, mais on n'y reste pas indifférent.

À l'intérieur, on trouve un processeur mono-cœur à 1.4 GHz (Microsoft ne supporte toujours pas les puces multi-cœurs...), 512 Mo de RAM, 16 Go de stockage, un APN 8MP/720p avec optique autofocus Karl Zeis et double flash LED, le Wi-Fi, le Bluetooth, une puce GPS, un tuner FM et les capteurs habituels des smartphones modernes (accéléromètre, proximité, boussole...).

Il reste maintenant à voir si la stratégie de la rupture était la bonne pour Nokia, qui a de moins en moins droit à l'erreur sur un marché qu'il l'a totalement dépassé.

Posté par Matt le 16/11/2011 à 12h20

Aucun commentaire

Source : TechCrunch

![]()

Déjà présent sur le marché des tablettes avec deux produits sous Android, la Flyer (7") et la Jetstream (10"), HTC aurait en projet une nouvelle tablette pour début 2012, qui fera un bon en avant côté performances grâce à l'adoption du SoC nVidia Tegra 3, tout en changeant de système d'exploitation, en adoptant Windows 8. Encore au stade de la rumeur, elle pourrait être officialisée en février 2012 lors du Mobile World Congress.

Posté par Matt le 16/11/2011 à 08h57

Aucun commentaire

Source : PCWorld

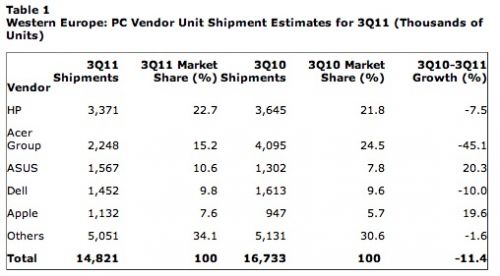

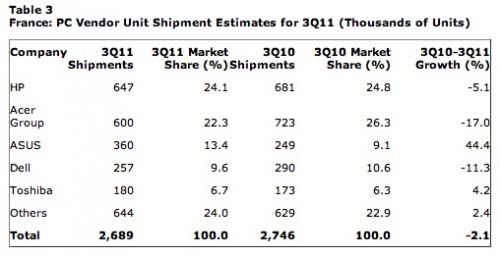

En raison de la crise économique et de la concurrence des tablettes et, dans une moindre mesure, des smartphones, les ventes d'ordinateur en Europe sont en berne, avec au troisième trimestre 2011 une baisse de 11% par rapport à 2010 selon Gartner. Deux constructeurs tirent toutefois très bien leur épingle du jeu : Asus et Apple.

Avec 1 567 000 d'unités vendues ce trimestre en Europe, Asus voit en effet ses ventes progresser de 20.3% sur un an, et sa part de marché dépasser les 10% (10.6%, en hausse de 2.8 points), ce qui lui permet de prétendre à la troisième marche du podium, derrière les indélogeables HP (redevenu premier) et Acer (tombé à la seconde place). Apple a pour sa part écoulé 1 132 000 de Mac en Europe, ce qui lui permet d'atteindre 7.6% du marché (+1.9 points), contre "seulement" 947 000 unités il y a un an, soit une hausse des ventes de 19.6%. La principale victime de la baisse des ventes est Acer, qui a perdu près de la moitié de sa clientèle (-45.1%, 2 248 000 d'unités), passant ainsi de 24.5% du marché à 10.6%.

Sur le marché français, qui n'a globalement baissé que de 2.1%, la progression d'Asus est encore plus impressionnante : de 249 000 unités (9.1%), le constructeur asiatique est passé à 360 000 unités (13.4%), soit une hausse de 44.4%, devenant, en France aussi, le troisième plus gros constructeur. Acer est aussi le plus gros perdant ce trimestre, mais avec une chute moins marquée (-17%), qui ne lui permet tout de même pas de conserver sa première place, cédée à HP. Gartner se limitant aux top 5, l'évolution des ventes d'Apple en France n'est pas connue, la cinquième place étant occupée chez nous par Toshiba, avec 6.7% du marché (contre 6.3% il y a un an). On peut donc simplement en déduire que la part d'Apple en France est inférieure à 6.7%, et donc inférieure à la part en Europe (7.6%).

Posté par Matt le 15/11/2011 à 14h20

Aucun commentaire

Source : Macbidouille

![]()

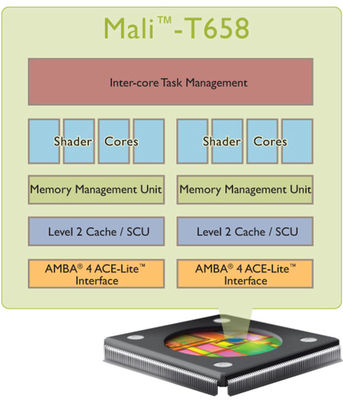

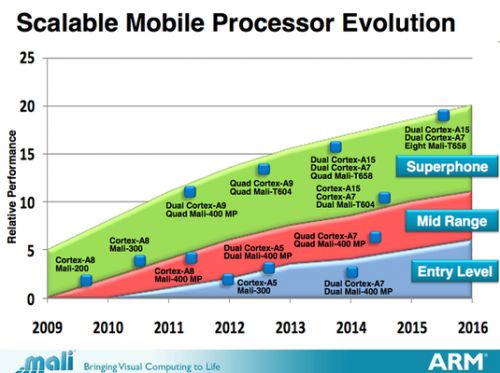

ARM a dévoilé son nouveau processeur graphique mobile haut de gamme, le Mali T658, qui promet des performances de très haut niveau. De quoi aider peut-être ARM à améliorer sa part de marché sur ce secteur, où l'anglais est encore un peu à la peine face à Imagination et ses puces PowerVR.

Dix fois plus performant que le Mali 400, actuel haut de gamme de la marque, et quatre fois plus puissant que le Mali T604, qui devrait constituer le haut de gamme ARM l'année prochaine, cette nouvelle puce embarquera un à huit cœurs, chacun doté de quatre processeurs de flux, d'un contrôleur mémoire et d'un cache L2 de 32 à 256 Ko. Destiné avant tout au graphisme via les API OpenGL ES 1.1, 2.0, OpenVG 1.1 et Direct X 11, le Mali T658 supportera aussi les API de GPGPU OpenCL 1.1, Google Renderscript et DirectX Compute.

Il ne faudra par contre pas être trop pressé de voir cette puce dans un smartphone. Selon la roadmap actuelle d'ARM, le Mali T658 n'arrivera dans les smartphones haut de gamme que fin 2013 en version quadri-cœur, et il faudra attendre mi-2015 pour goûter aux performances de la version à huit cœurs.

Posté par Matt le 14/11/2011 à 09h22

Aucun commentaire

Source : Tom's Hardware

Lancée fin septembre par Amazon, la tablette Kindle Fire était considérée par beaucoup comme le plus sérieux concurrent de l'iPad. Une opinion que les ventes semblent confirmer pour l'instant, Amazon ayant à nouveau revu ses objectifs à la hausse.

Après avoir vendu 100 000 exemplaires de sa tablette lors de son premier jour de commercialisation, Amazon avait une première fois augmenté ses objectifs pour la fin de l'année, passant de 3.5 millions d'unités à 4 millions. Ce succès des premiers jours n'était visiblement pas passager, puisqu'un peu plus d'un mois après le lancement, Amazon vient d'augmenter une seconde fois son objectif, qui atteint désormais 5 millions d'unités.

Un succès sans doute bien aidé par le modèle économique choisi par Amazon : la tablette est vendue à très bas prix, peut-être même à pertes selon certaines sources, Amazon comptant ensuite sur la vente de contenus (applications, musiques, films, livres...) pour faire sa marge. Ainsi, la Kindle Fire se retrouve à seulement 199$ aux États-Unis, soit à peine 40% du premier prix de l'iPad 2.

Posté par Matt le 11/11/2011 à 14h21

Aucun commentaire

Source : Numérama

![]()

Pour la télécommande de sa Freebox Révolution, Free a fait le choix peu commun d'une transmission radio plutôt qu'infrarouge. Souvent plus pratique, car s'affranchissant de presque tous les obstacles, ce choix rend par contre la Freebox incompatible avec les télécommandes universelles infrarouge. Suite à de nombreuses demandes, Free va prochainement proposer une solution.

Elle prendra la forme d'un simple dongle USB infrarouge en vente sur la boutique d'accessoires de Free. Free a précisé qu'il s'agit du récepteur IR-605Q d'AIM, qu'on peut trouver relativement facilement dans le commerce. La version actuelle du firmware le supporte d'ailleurs déjà ce dongle, ce qui permettra aux plus pressés de s'équiper immédiatement, sans attendre que Free lance la commercialisation.

Posté par Matt le 10/11/2011 à 11h37

Aucun commentaire

Source : Génération NT

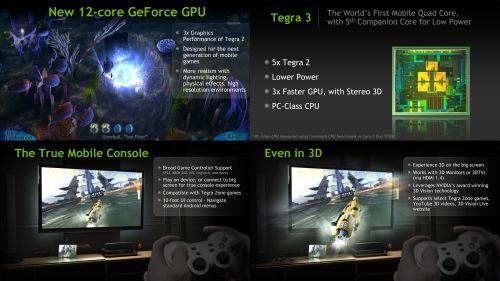

Annoncé depuis un bon bout de temps, le nouveau SoC Tegra 3 (Kal-El) d'nVidia est enfin lancé officiellement. nVidia en a profité pour dévoiler les derniers détails sur sa nouvelle plateforme mobile.

Comme nVidia l'avait déjà évoqué, Tegra 3 adopte une architecture multi-cœur hétérogène, avec quatre cœurs optimisés pour la performance et un cœurs optimisé pour la faible consommation. Lorsque la puissance nécessaire est faible (lecture vidéo, musique, veille), seul ce cinquième cœur sera activé, à une fréquence pouvant varier entre 0 et 500 MHz. En cas de besoins plus importants, c'est un, deux ou quatre cœurs hautes performances qui seront activés. Ces cœurs moduleront leur fréquence de fonctionnement entre 0 et 1.3 GHz, et même 1.4 GHz quand un seul est activé.

Grâce à cette architecture atypique, nVidia promet une consommation 15 à 60% inférieure à celle de son ancien SoC Tegra 2 et des performances jusqu'à quatre fois plus élevées que celles des SoC haut de gamme concurrents en Javascript. Les performances des contrôleurs de stockage seraient également fortement en hausse, avec le support de normes deux à six fois plus rapides que celles implémentées dans le Tegra 2 : S-ATA 3 Gbit/s, SD 3.0, eMMC 4.41...

La partie graphique ne devrait pas être en reste. Alors que le Tegra 2 avait un peu déçu sur ce point, le Tegra 3 embarque une GeForce à douze cœurs, annoncé comme trois fois plus performante que celle du Tegra 2, tout en consommant moins. La partie graphique est capable de gérer une sortie HDMI 1.4 pour jouer sur grand écran, y compris en 3D, sur les écrans supportant la technologie 3D Vision d'nVidia. Côté vidéo, le 1080p High Profile, grand absent du Tegra 2, est enfin supporté, jusqu'à un débit de 40 Mbit/s (la plupart des films Blu-Ray ne dépassant pas les 30 Mbit/s en moyenne).

Le premier produit intégrant Tegra 3 sera la nouvelle tablette Eee Pad Transformer Prime d'Asus, annoncée en même temps que le Tegra 3, qui sera disponible d'ici quelques semaines à partir de 600€.

Posté par Matt le 10/11/2011 à 09h22

Aucun commentaire

Source : PCInpact

Il y a un an et demi, la Chine avait fait sensation en annonçant le supercalculateur le plus puissant du monde (du moins en performances théoriques, en pratique les monstres japonnais et américains le dépassaient. Mais alors que ce calculateur n'était que de conception chinoise sur la base de composants essentiellement étrangers, la Chine vient d'annoncer un nouveau calculateur 100% chinois.

Baptisé Sunway BlueLight MPP, il utilise le processeur chinois ShenWei SW1600, une puce 16 cœurs à 1 GHz dotée d'un jeu d'instruction RISC. Il embarque 8704 de ces processeurs dans 9 armoires refroidies à l'eau. Ces processeurs sont épaulés par 150 To de RAM DDR3 et 2 Po d'espace de stockage. Le tout consomme un peu plus d'1MW, pour une puissance de calcul théorique dépassant 1 PFLOP en pointe, et atteignant 795 TFLOPS en soutenu sous LINPACK. Ces performances lui vaudraient une 13ème place dans la liste Top 500 de juin 2011.

Avec ce calculateur, la Chine devient le troisième pays à s'équiper d'un calculateur entièrement basé sur des technologies "locales". Jusqu'à présent, seuls les États-Unis et le Japon remplissaient ces critères.

Ce calculateur est installé au National Supercompute Center de Jinan, à environ 400km au sud de Pékin. Il sera utilisé pour de l'analyse financière, de la recherche médicale, la prévision météo, la simulation industrielle...