![]()

Ces dernières années, la stratégie d'Acer était claire : rogner sur la qualité et sur les marges pour faire de gros volumes (et donc des économies d'échelle) et tenter de devenir le premier constructeur mondial d'ordinateurs. Un objectif qui devrait être atteint cette année sur les portables et l'année prochaines sur les machines de bureau. Mais le taiwanais s'apprêterait à changer de stratégie...

En effet, si la stratégie a été efficace sur les volumes, elle ne l'est pas sur les marges, trop faibles au goût des investisseurs. La situation a mené au départ du PDG du groupe, l'italien Gianfranco Lanci. Le groupe semble désormais vouloir suivre les conseils de son fondateur, Stan Shih, qui suggérait il y a quelques jours qu'Acer devrait suivre l'exemple d'Apple.

Ainsi, JT Wang, le nouveau PDG par interim a-t-il annoncé que la stratégie d'Acer a été chamboulée par l'arrivée des tablettes, obligeant le groupe à s'adapter. Acer va donc désormais viser un peu moins les volumes, mais plutôt proposer des produits plus haut de gamme, sur lesquels le constructeur pourra faire plus de marges, tout en se donnant les moyens d'investir dans les secteurs porteurs actuels, les smartphones et les tablettes. Le taiwanais vise ainsi 10% du marché des tablettes en 2011, mais reste moins ambitieux sur les smartphones, dont il se contenterait de 2%.

Posté par Matt le 06/04/2011 à 08h30

Aucun commentaire

Source : PCInpact

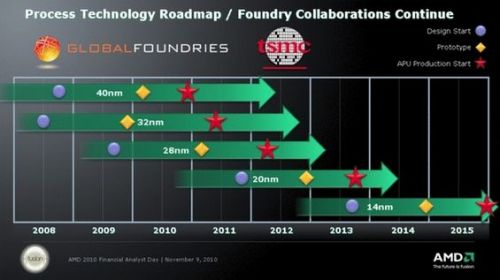

Depuis qu'AMD s'est séparé de ses usines en les confiant à GlobalFoundries, une société créée pour l'occasion, cette dernière reste le principal fournisseur d'AMD pour la fabrication de ses processeurs. Mais AMD devient un client de plus en plus exigeant...

En effet, AMD ne serait pas du tout satisfait des faibles rendements offerts par GlobalFoundries sur la gravure en 32nm, d'autant plus que ces problèmes l'ont forcé à retarder le lancement de sa nouvelle gamme de processeurs à GPU intégré Llano, au profit de la gamme Ontario, gravée en 40nm chez un autre fondeur (TSMC).

Pour l'année 2011, AMD a donc décidé de renégocier son contrat avec le fondeur, pour lui mettre un peu plus la pression. Traditionnellement, les clients des fondeurs achètent les wafers à un tarif prédéterminé, quelque soit le nombre de puces fonctionnelles sur le wafer. AMD accepte de rester sur ce modèle pour les wafers 45nm, mais va par contre payer les wafers 32nm en fonction du taux de puces défectueuses. GlobalFoundries a donc intérêt à faire progresser son processus de gravure 32nm, les rebuts étant désormais à sa charge.

Ce différend est également l'occasion de constater l'avance prise par Intel sur son concurrent dans ce domaine... En effet, alors qu'AMD se bat pour obtenir un taux acceptable de puces fonctionnelles en 32nm et sortir son premier processeur de cette finesse, Intel distribue des Core i en 32nm depuis plus d'un an, et s'apprête déjà à passer au 22nm pour la fin de l'année... AMD pour ça part n'envisage pas mieux que du 28nm pour début 2012, et vise la commercialisation de ses premières puces 20nm fin 2013...

Posté par Matt le 05/04/2011 à 12h11

Aucun commentaire

Source : Tom's Hardware

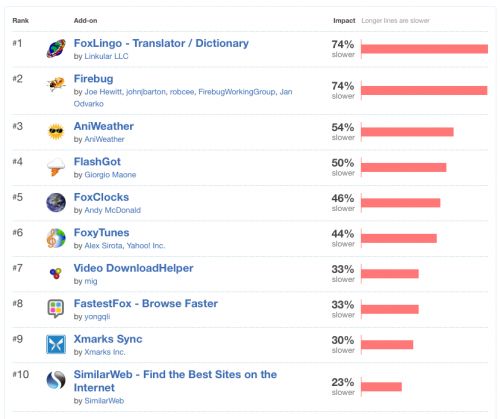

L'un des reproches les plus souvent faits au navigateur Firefox concerne son temps de démarrage. Sur ce point, le panda fait en effet pâle figure face à Chrome ou Internet Explorer. Si une partie du problème est bien à imputer au navigateur, une partie provient également des nombreuses extensions qu'installent certains utilisateurs...

Pour redorer le blason de son bébé, la fondation Mozilla s'est donc lancée dans une chasse aux extensions qui ralentissent le plus le démarrage du navigateur. Pour ce faire, la fondation a tout simplement repris les 100 extensions les plus téléchargées, et mesuré leur impact sur le temps de démarrage du navigateur. À la clé, une classement des extensions les plus lourdes à charger.

En tête de ce classement peu glorieux, les extensions FoxLingo (assistance à la traduction) et Firebug (outils pour développeurs) augmentent le temps de chargement du navigateur de 74%. Le podium est complété par AniWeather (météo), avec une augmentation de 54%. La dernière extension du top 10, SimilarWeb (recherche de sites en liens avec le site courant) ralenti le chargement de 23%, ce qui montre tout de même que les ralentissements observés avec les extensions du podium sont exceptionnels. On notera également la présence dans ce top 10 de l'extension FastestFox, censée accélérer l'utilisation de Firefox, mais qui ralenti son démarrage de 33%...

Afin d'inciter les développeurs d'extensions à corriger le tire en optimisant le temps de chargement de leurs produits, Mozilla précise que ce classement sera mis à jour en temps réel, permettant ainsi de rendre compte rapidement des progrès effectués.

Posté par Matt le 05/04/2011 à 11h31

Aucun commentaire

Source : Tom's Guide

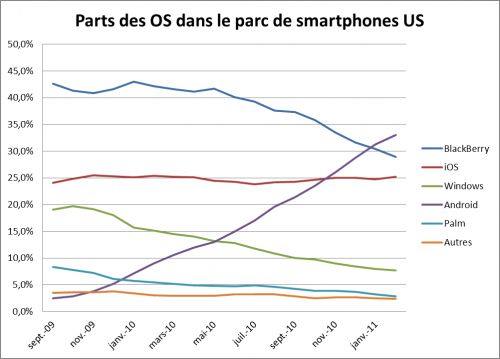

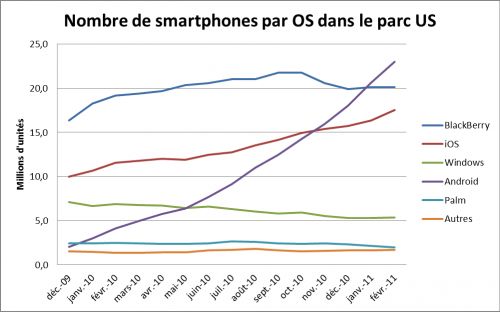

Rien ne semble pouvoir arrêter la croissance d'Android aux États-Unis ! Passé devant l'iPhone depuis cet automne et devant les BlackBerry depuis le début de l'année, Android continue de gagner des parts de marché aux États-Unis.

Même si sa croissance s'est très légèrement ralentie par rapport au mois de janvier, l'OS mobile de Google a en effet atteint quasiment le tiers du parc de smartphones américains au mois de février 2011, selon la dernière étude de ComScore. Comme d'habitude, la principale victime de cette croissance est le BlackBerry, suivi par les systèmes Microsoft et par Palm, tandis que l'iPhone stagne, ne gagnant que 0.2pt de part de marché.

En nombre d'unités, iOS et Android sont les deux seules systèmes à encore connaitre une croissance significative du nombre d'unités en circulation. Ainsi, en février, le nombre de smartphones Android a augmenté de 2.3 millions, pour s'établir à 23 millions (+11%), tandis que l'iPhone a progressé de 1.1 millions d'unités, atteignant un total de 17.5 millions (+6.7%) d'appareils. Le BlackBerry stagne à 20.1 millions, Windows Mobile passe de 5.3 à 5.4 millions (+1.9%) et Palm passe de 2.1 à 1.9 millions (-9.5%).

D'après ces chiffres, on peut estimer que la part de marché d'Android sur les ventes de smartphones doit désormais s'établir entre 50 et 65%.

Posté par Matt le 05/04/2011 à 11h00

Aucun commentaire

Source : Mac4Ever

![]()

Invité de l'émission Capital sur M6 dimanche dernier, Xavier Niel a évoqué la "guerre des prix" entre les opérateurs télécoms. L'occasion pour lui de donner également quelques informations, et non des moindres sur les tarifs de la future offre mobile...

En effet, Xavier Niel promet que Free Mobile proposera un forfait "tout illimité" à un tarifs significativement inférieur à 50€. Le dirigeant d'Iliad révèle en effet que le coût d'un tel forfait pour Free Mobile serait de seulement 25€ par mois en moyenne, et donc que le vendre à 50€ serait encore un tarif trop élevé à son goût. Il n'a par contre pas donné plus de détail sur le reste des offres que proposera l'opérateur. Cette information apporte toutefois un peu de crédit aux prévisions de l'ADUF sur les tarifs de Free Mobile.

Par ailleurs, l'ARCEP a communiqué la date à laquelle elle vérifiera le taux de couverture offert par Free Mobile : ce sera la 12 janvier 2012. Free Mobile devra donc d'ici là parvenir à couvrir 27% de la population française, sans quoi l'opérateur ne pourra pas lancer son offre et perdrait son accord d'itinérance avec Orange.

Posté par Matt le 05/04/2011 à 08h31

2 commentaires

Sources : Univers Freebox et Freenews

Jusqu'à présente, la plateforme Android était une plateforme très ouverte, que n'importe quel constructeur pouvait adopter pour n'importe quel appareil, quasiment sans condition. De plus, les constructeurs avaient la possibilité de modifier plus ou moins le système. Il semblerait que Google veuille mettre un terme à tout ça...

En effet, alors que Google avait annoncé il y a quelques jours que les sources d'Android 3.0 ne seraient pas disponibles immédiatement, pour éviter que n'importe qui puisse sortir un appareil sous cette version du système, ceci ne serait pas la seule mesure de Google. En effet, pour faciliter le développement d'applications et le déploiement des mises à jour du système, Google voudrait une plus grande uniformité du parc d'appareils Android.

Et cette uniformisation ne passera pas que par une limitation des modifications logicielles, puisque Google serait également en négociation avec ARM pour la définition d'une architecture matérielle standardisée pour les appareils Android. Ainsi, Google pourrait s'affranchir des constructeurs et diffuser directement les mises à jour du système.

Ce ne serait pas forcément une mauvaise chose, tant certains constructeurs trainent la patte pour fournir des mises à jour compatibles avec leur matériel, mais on peut par contre craindre qu'une telle solution soit un frein à l'évolution des appareils Android, en l'absence d'une vraie concurrence sur le matériel.

Posté par Matt le 04/04/2011 à 14h30

Aucun commentaire

Source : Tom's Hardware

Dans un récente discours, Francis Gurry, directeur de l'Organisation Mondiale de la Propriété Intellectuelle, a appelé les gouvernants et les ayants-droits à réformer le droit d'auteur pour l'adapter aux nouvelles technologies.

En effet, selon lui les bouleversements apportés par le numérique sont irréversibles, et le système de droits d'auteurs n'a d'autres choix que de s'adapter ou de disparaître. Il rappelle également que le but du droit d'auteur est de favoriser le dynamisme culturel, et non de protéger des intérêts commerciaux... Il va même jusqu'à évoquer quelque chose ressemblant beaucoup à une licence globale, en proposant la mise en place d'une infrastructure mondiale qui permettrait d'obtenir légalement des œuvres aussi facilement que via les réseaux pirates.

Pour Francis Gurry, une telle solution aurait l'avantage de mieux correspondre aux attentes du public, et permettrait de le responsabiliser face aux problématiques de droits d'auteurs. Il va même jusqu'à citer les aspirations du Parti Pirate comme exemple de ce qu'attend le public, tout en précisant quand même qu'il s'agit d'une position extrême : limiter la durée d'exploitation commerciale d'une œuvre à cinq ans, et permettre gratuitement une utilisation non commerciale dès sa sortie.

Si cette position de l'OMPI est un pas important vers la mise en place de nouvelles règles adaptées aux nouvelles technologies, elle risque malheureusement d'être suivie de peu d'effet, l'accord ACTA (Anti-Counterfeiting Trade Agreement), un traité international sur la lutte contre la contrefaçon, prévoyant d'ores et déjà le remplacement de l'OMPI par une nouvelle entité

Posté par Matt le 04/04/2011 à 12h50

2 commentaires

Source : Numerama

Comme prévu, le lancement jeudi dernier du Sony Ericsson Xperia Play, aussi connu sous le surnom de PlayStation Phone, a été accompagné de l'arrivée sur l'Android Market de plusieurs titres issus du catalogue de la PlayStation 1.

Au nombre de cinq pour l'instant (Syphone FIlter, Destruction Derby, MediEvil, Jumping Fish et Cool Boarders 2), ils sont vendus 6$38 (4€50) et sont proposés en anglais, espagnol et allemand. Ils seront utilisables sur la plupart des appareils Android, et non pas seulement sur le Xperia Play, et d'autres titres devraient rapidement compléter le catalogue.

Hasard du calendrier, ou réponse à une demande de Sony, Google a retiré de l'Android Market l'émulateur PlayStation PSX4Droid, au motif qu'il violerait leur politique de contenu. Cela fait pourtant huit mois que l'émulateur était proposé dans la boutique d'Android. D'autres émulateurs sont par contre toujours proposés, ce qui fait penser certains que PSX4Droid aurait été retiré suite à une demande de Sony, propriétaire du nom PSX.

Posté par Matt le 04/04/2011 à 11h11

Aucun commentaire

Sources : Tom's Guide et Le Journal du Geek

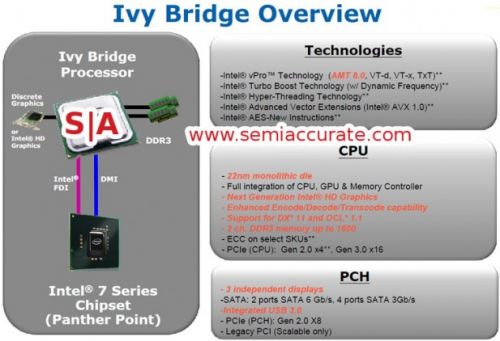

Prévu pour succéder à la plateforme Sandy Bridge en fin d'année , la plateforme Ivy Bridge sera essentiellement un die-shrink en 22nm du Sandy Bridge (32nm). Mais il apportera aussi quelques nouveautés, notamment au niveau du PCI-Express.

Ainsi, le contrôleur PCI-Express intégré au processeur va proposer 20 lignes PCI-Express, contre 16 actuellement, et les 16 premières lignes, généralement utilisées par la carte graphique, seront à la norme PCI-Express 3.0, qui offrira une bande passante doublée par rapport à l'actuelle norme PCI-Express 2.0.

La partie graphique intégrée sera également améliorée, avec le support de DirectX 11 et d'OpenCL 1.1 et pourra gérer trois écrans indépendants, tandis que le southbridge accompagnant le processeur supportera enfin l'USB 3.0.

Posté par Matt le 04/04/2011 à 08h22

Aucun commentaire

Source : Macbidouille

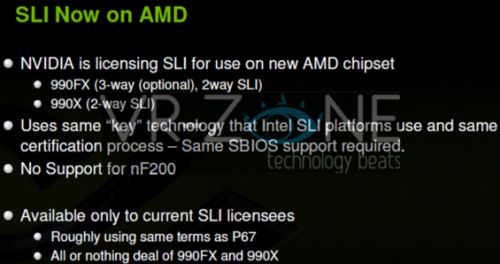

Lorsqu'nVidia avait relancé le SLI en 2005, c'était pour la firme au caméléon un bon moyen de rendre ses chipsets plus attractifs : le SLI n'était supporté que sur les chipsets nForce. Plus tard, nVidia l'a autorisé sur certains chipsets Intel via une puce additionnelle, puis sans cette puce... Et désormais, ce sont des chipsets AMD qui vont y avoir droit !

En effet, maintenant qu'nVidia n'est plus du tout présent sur le marché des chipsets haut de gamme, il a tout intérêt à ce que sa technologie SLI fonctionne sur un maximum de chipsets, dans la mesure ou le CrossFire d'AMD est ouvert depuis longtemps à quasiment tous les chipsets. Ce sont donc deux chipsets AMD qui vont avoir droit aux SLI : le 990X et le 990FX. Ces deux chipsets ne sont pas encore disponibles, mais équiperont la nouvelle plateforme AMD, qui ne devrait plus trop tarder.

Ces deux chipsets pourront supporter le SLI sans ajout de puce additionnelle, comme les derniers chipsets Intel. Le 990X aura droit au SLI à deux cartes, tandis que le 990FX, plus haut de gamme, pourra en exploiter jusqu'à trois.