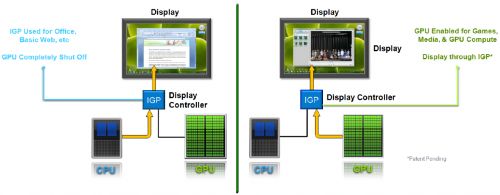

nVidia annoncé officiellement en début de semaine sa technologie Optimus, qu'on avait déjà aperçu sans qu'elle est de nom sur le portable UL80JT d'Asus. Rien à voir avec le fameux clavier Optimus Maximus, puisqu'il s'agit là d'une technologie ciblant les cartes graphiques, et plus particulièrement, celles des ordinateurs portables.

Le principe d'Optimus est de permettre d'exploiter dans une même machine une vraie carte graphique dédiée, couplée à un IGP, comme celui qui équipe désormais une partie des processeurs mobiles d'Intel. Grâce à un driver adapté, Optimus permet de basculer dynamiquement la gestion de l'affichage entre le carte graphique et l'IGP, et ce, en toute transparence : l'affichage final est toujours géré par l'IGP, mais les instructions 3D sont envoyées au GPU, qui va ensuite directement écrire le résultat dans la zone mémoire utilisée par l'IGP pour que ce dernier puisse afficher l'image.

Lorsque le GPU n'est pas utilisé, celui-ci peut être complètement éteint. Optimus permet ainsi de bénéficier d'une autonomie élevée, comme sur une machine dotée uniquement d'un IGP, tout en en gardant sous la pédale pour les applications 3D, qui sont souvent le point faible des ordinateurs portables les plus autonomes. Les résultats sembles probants, puisque le portable UL80JT d'Asus atteint 12 heures d'autonomie.

Posté par Matt le 11/02/2010 à 12h46

Aucun commentaire

Source : Hardware.fr

Depuis le lancement des Core i7, Intel propose sur bon nombre de ses processeurs la technologie "Turbo Boost", qui consiste à faire fonctionner les cœurs actifs à une fréquence supérieures à leur fréquence lorsque certains cœurs sont inactifs. AMD pourrait également opter pour cette astuce dans ses modèles à six cœurs.

En effet, si les modèles à quatre cœurs fonctionnent déjà à des fréquences proches de leurs limites, les modèles à six cœurs sont prévus pour être commercialisés à des fréquences sensiblement inférieures, donc devraient bénéficier d'une bonne marge de manœuvre lorsque seulement quatre cœurs ou moins seront utilisés. Ceci pourrait notamment permettre d'éviter que les Phenom II X4 soient dans certaines situations plus performants que les Phenom II X6 (Thuban).

Cette information n'a pas encore été confirmée par AMD, mais notre confrère la tiendrait d'une source proche du fondeur, et l'introduction d'une telle technologie dans les processeurs AMD n'aurait rien de surprenant, puisque les processeur AMD sont en partie mis à mal par le Turbo Boost et que l'ajout de cette fonctions aux processeurs AMD ne présenterait aucun réelle difficulté technique.

Posté par Matt le 08/02/2010 à 22h30

Aucun commentaire

Source : Hardware.fr

![]()

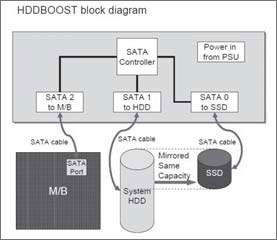

Silverstone, spécialisés dans les boîtiers et accessoires pour boîtier, vient de lancer un nouvel accessoire assez original, à destination des possesseurs de SSD : le HDDBoost.

S'installant dans une baie 3.5", le HDDBoost offre une baie 2.5" pour accueillir un SSD, un port SATA pour raccorder un disque dur et un port SATA pour le raccordement à la carte mère. Son contrôleur intégré va exposer l'ensemble disque dur + SSD comme une seule unité de stockage. Ainsi, sur les premiers Go de l'unité logique ainsi constituée, les lecture s'effectuent sur le SSD, tandis que les écritures s'effectuent sur le disque dur, afin de limiter l'usure du SSD, tout en profitant de ses performances en lecture. La synchronisation des deux s'effectue à chaque démarrage, par une recopie des premiers Go du disque dur vers le SSD.

Si le concept est intéressant, on peut toutefois se poser plusieurs questions sur son fonctionnement, et en particulier sur la façon dont il va se comporter lorsqu'on effectue une lecture après une écriture (la nouvelle lecture va-t-elle bien se faire à partir du disque dur, pour récupérer la version fraichement écrite ?). Par ailleurs, le choix de stocker sur le SSD une portion du disque choisie de façon totalement statique n'est pas forcément très judicieuse. Il aurait sans doute été bien plus efficace (mais aussi bien plus complexe) de choisir les données à stocker sur le SSD en fonction de la fréquence des accès.

L'appareil est heureusement proposé à un tarif relativement raisonnable (moins de 40€), ce qui aidera à faire passer la pilule en cas de résultat inférieur aux attentes...

Posté par Matt le 05/02/2010 à 08h53

Aucun commentaire

Source : Hardware.fr

nVidia a révélé hier les premiers noms commerciaux qui seront utilisées pour sa nouvelle génération de GPU, basés sur la très attendue architecture Fermi (GF100), qui a déjà fait couler beaucoup d'encre en raison de l'inconnu sur ses performances et de sa consommation électrique qui s'annonce assez extrême...

Alors qu'on aurait pu s'attendre à ce que ces cartes occupent le haut de gamme de la série GeForce 300, aujourd'hui constituée uniquement d'une solution d'entrée de gamme et de puces mobiles, nVidia a opté pour la création d'une série 400, sans doute pour bien distinguer la nouvelle architecture des anciennes. Ainsi, les premières cartes Fermi grand public seront baptisées GeForce GTX 480 et GeForce GTX 470. Le modèle haut de gamme devrait embarquer 512 processeurs de flux et 1.5 Go de mémoire interfacés sur un bus 384 bits.

Reste donc à voir ce qu'nVidia fera du trou béant laissé dans la gamme GeForce 300. De nouveaux renommages en perspective ?

Posté par Matt le 03/02/2010 à 08h51

Aucun commentaire

Source : PCWorld

Quand il s'agit de vendre un produit à des gamers, il est habituel de sortir des caractéristiques techniques qui n'engagent pas à grand chose, et pour lesquelles il peut sembler bien difficile de trouver un intérêt pratique. Microsoft ne déroge pas à la règle avec son tout nouveau clavier Sidewinder X4...

Sous sa robe noire rétro-éclairée de rouge, ce clavier dispose en effet de toutes les caractéristiques nécessaires à un bon clavier pour gamer, avec ses touches programmables, le support de macro-commandes, un driver capable de gérer plusieurs profiles, et d'une électronique interne capable de gérer l'utilisation simultanée de... 26 touches ! Soit environ le quart du nombre de touches composant un clavier standard. Voilà qui devrait ravir les gamers à cinq mains !

Ce clavier sera disponible le mois prochain, pour un peu moins de 60€.

Posté par Matt le 02/02/2010 à 22h18

Aucun commentaire

Source : Hardware.fr

Après son contrôleur SF-1000, resté relativement anonyme, le Californien SandForce avait annoncé il y a quelques mois les contrôleurs SF-1200 et SF-1500, aux performances particulièrement alléchantes. Les premiers SSD basés sur ces nouveaux contrôleurs ne devraient plus tarder à arriver en France.

En effet, le Vertex 2 LE d'OCZ commence à être référencé en pré-commande dans différentes boutiques en ligne européennes, dont notre partenaire Materiel.net. Décliné pour l'instant en deux capacités, 100 Go et 200 Go, le Vertex 2 LE embarque de la mémoire flash MLC et un contrôleur SF-1200. Son prix est sensiblement supérieur à celui de ses concurrents (à partir de 340€ en Europe pour la version 100 Go), mais les performances sont également nettement au dessus, en particulier sur les accès aléatoires. Selon certaines boutiques, la disponibilité devrait être effective dès la fin de la semaine.

Du côté du Japon, c'est le Photofast G-Monster 2 SFV1 qui ouvre le bal des SSD à base de contrôleur SandForce. Celui-ci est d'ores et déjà disponible dans certaines boutiques d'Akihabara, la "rue Montgallet" de Tokyo. Il est par contre proposé à un tarif particulièrement élevé, puisque les revendeurs n'en demandent pas moins de 75 000¥ (600€) pour un modèle de 100 Go. Ce tarif s'explique par l'utilisation du contrôleur SF-1500, plutôt destiné au marché de l'entreprise et offrant des performances plus élevées sur les accès aléatoires.

Posté par Matt le 02/02/2010 à 10h11

Aucun commentaire

Source : PCWorld

![]()

Après avoir été le premier à graver de la mémoire flash à moins de 40nm, avec ses MLC 34nm produites depuis la mi-2008, IMFT vient d'annoncer le lancement dans les prochains mois les premières puces flash gravées à moins de 30nm.

Disponibles dès le second trimestre 2010, les puces annoncées seront gravées en 25nm et proposeront une capacité de 8 Go en MLC à 2 bits par cellule. Le fondeur grille ainsi une nouvelle fois la politesse aux autres acteurs du marché de la mémoire flash, qui envisagent plutôt le passage sous les 30nm pour la fin de l'année. Cette nouvelle finesse de gravure permet d'augmenter la densité de près de 90%, ce qui devrait se traduire à terme par une quasi division par deux des prix, une fois ce nouveau process correctement maitrisé.

Pour rappel, IMFT est une joint-venture entre Intel et Micron (Intel Micron Flash Technologies). On peut donc s'attendre à ce que les SSD X25-M soient parmi les tout premiers à bénéficier de ces nouvelles puces mémoire, ce qui permettrait de trouver le futur modèle 160 Go à un tarif proche de l'actuel modèle 80 Go. Plusieurs rumeurs évoquent un lancement de ces nouvelles durant l'été prochain.

Posté par Matt le 01/02/2010 à 22h33

Aucun commentaire

Source : Macbidouille

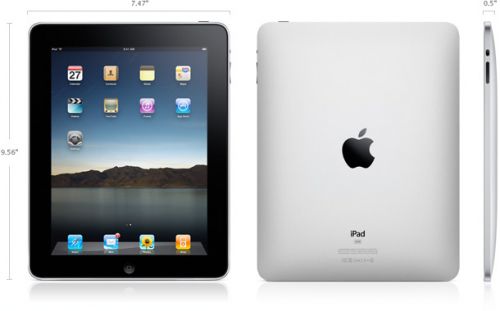

Annoncée par de nombreuses rumeurs depuis des mois et très attendue par la communauté Apple, la tablette tactile du constructeur à la pomme a été présentée en baptisée officiellement aujourd'hui : il faudra désormais l'appeler iPad.

Ressemblant à un gros iPod Touch, l'iPad est finalement sans grande surprise, conformer à la plupart des rumeurs, mais pas forcément les plus optimistes... Commençons par le matériel. L'iPad se présente sous la forme d'une fine tablette de 1.34cm d'épaisseur pour 24.3cm de long et 19cm de large. Le gros de la surface supérieure est occupé par un écran 9.7" d'une résolution de 1024x768. Il est bien entendu tactile multitouch. Par contre, point d'OLED ici, puisqu'il s'agit d'un écran IPS à rétroéclairage LED.

À l'intérieur, on trouve une puce SoC conçue par Apple (probablement via sa filiale P.A. Semi) et cadencée à 1 GHz, 16 à 64 Go d'espace de stockage flash, une puce Wi-Fi 802.11a/b/g/n, une puce Bluetooth 2.1+EDR, un magnétomètre (boussole), des accéléromètres et une imposante batterie de 25 Wh assurant 10h d'autonomie en surf via Wi-Fi. En option, l'iPad peut également être équipée d'une connectivité cellulaire (GSM/EDGE quadri-bande et UMTS/HSDPA tri-bande) et d'une puce A-GPS. Curieusement, cette version cellulaire ne pourra se connecter qu'à un réseau de données, pas à un réseau voix. La connectique et les boutons sont pour leur parts identiques à ceux de l'iPhone.

La partie logicielle risque également d'en décevoir plus d'un. En effet, nombreux sont ceux qui espéraient (sans trop y croire...) une tablette fonctionnant sous Snow Leopard, qui irait concurrencer les tablettes PC sous Windows 7, mais la tablette présentée par Apple tournera finalement comme prévu sous un système dérivé de celui de l'iPhone, avec toutes les restrictions que ça implique : accès très limité au système de fichiers, applications obligatoirement distribuées via l'App Store, pas de multitâches... Apple a par contre comme à son habitude porté beaucoup de soin à l'ergonomie des applications, en tirant bien partie de la plus grande taille de l'écran. Les applications iPhone existantes pourront fonctionner sur l'iPad, tandis que les nouvelles applications pourront être développées dans des versions spécifiques à l'iPad, grâce au nouveau SDK publié aujourd'hui. Apple donne d'ailleurs l'exemple avec une version de la suite iWork spécialement adaptée à l'iPad, qui sera vendue à raison de 10$ par logiciel (Pages, Numbers et Keynote).

Enfin, Apple pour accompagner l'iPad, Apple se lance dans la vente en ligne de livres numériques, via l'iBook Store et proposera également différents accessoires : un dock classique, un dock intégrant un clavier de taille standard, des lecteurs de cartes mémoire, etc...

Terminons avec le côté douloureux de la tablette : les tarifs ! Le modèle d'entrée de gamme (16 Go sans réseau cellulaire) sera proposé à 499$, le modèle 32 Go à 599$ et le modèle 64 Go à 699$. Il faudra encore rajouter 130$ pour bénéficier de la connectivité cellulaire, quelque soit la capacité, soit un prix total de 829$ pour le modèle le plus haut de gamme. L'appareil devrait être disponible dans moins de deux mois aux USA, et au début de l'été dans le reste du monde.

Posté par Matt le 27/01/2010 à 23h17

7 commentaires

Régulièrement, AT Internet Institute (anciennement Xiti Monitor) publie des études statistiques sur les internautes européens : OS et navigateurs utilisés, parts de marché des moteurs de recherche, comportement de surf... Le dernier rapport publié concerne les navigateurs Internet, et marque une nouvelle étape : Internet Explorer est passé sous la barre des 60% du marché européen !

En effet, les différentes versions du navigateur de Microsoft ne cumulent plus que 58.6% des utilisateurs en décembre 2009, contre 64.6% en mars 2009, soit une baisse de 9.3%. Derrière, les quatre principaux navigateurs concurrents ont tous vu leur part de marché progressé, mais certains en ont profité bien plus que d'autres. Ainsi, Chrome progresse de 192%, atteignant désormais 4.1% du marché, tandis qu'Opera ne progresse que d'un modeste 4.5%, en passant à 2.3% du marché. Firefox et Safari progressent pour leur part respectivement de 5.8% (29.4%) et 55% (5.1%). Il y a désormais en Europe plus d'un utilisateur de Firefox pour deux utilisateurs d'Internet Explorer.

À ce rythme, Internet Explorer devrait passer sous la barre des 50% en Europe d'ici à 18 à 24 mois et pourrait perdre sa première place dans un délai à peine plus long, tandis que Chrome devrait être très bientôt la troisième force du marché des navigateurs, en ravissant la place de Safari.

Il faut également noter que ces chiffres publiés par AT Internet Institute correspondent au mois de décembre 2009, donc en prennent pas en compte l'impact qu'ont pu avoir les différentes recommandations gouvernementales suite à la faille découverte dans Internet Explorer à la mi-janvier.

Pour informations, sur Infobidouille en décembre 2009, c'est Firefox qui est largement en tête des visites, avec une part de 45.2% (contre 46.7% en mars), devant Internet Explorer (32.7% en décembre, 34.6% en mars), Safari (12.5% en décembre, 11.1% en mars), Chrome (5.9% en décembre, 2.6% en mars) et Opera (2.2% en décembre, 1.7% en mars).

Posté par Matt le 26/01/2010 à 23h43

1 commentaire

Source : PCInpact

Si la comparaison des processeurs à leur fréquence commerciale est la plus intéressante pour le consommateur, afin de savoir ce qu'il aura pour son argent, il existe une autre comparaison intéressante pour les amateurs de matériel : la comparaison à fréquence égale, permettant de mettre en évidence l'efficacité des différentes architectures. C'est la comparaison à laquelle s'est attelée notre confrère Tom's Hardware...

Pour ce faire, notre confrère a comparé quatre processeurs cadencés à 2.8 GHz : un bon vieux Core 2 Quad (Q9550s), un AMD Phenom II X4 (965), un Intel Core i5 (750) et un Intel Core i7 (920). Sans surprise, c'est le Core i7 qui s'en sort le mieux, avec une légère avance sur le Core i5. Un bon cran derrière, on retrouve le Core 2 Quad, suivit par le Phenom II X4. Notez tout de même que ce dernier est celui qui dispose de la fréquence commerciale la plus élevée (3.4 GHz), même si celle-ci reste insuffisante pour recoller avec les puces haut de gamme d'Intel.

Les choses se compliquent encore un peu pour AMD lorsqu'on se penche sur la consommation, le Phenom se classant seulement 3ème, juste devant le Core i7, tant que la consommation au repos que sur la consommation en pleine charge. Il termine par contre dernier sur la consommation moyenne pendant un ensemble de test, mais aussi sur la consommation totale durant cet ensemble de test, avec un écart encore plus marqué que sur la consommation moyenne (du fait que le test dure plus longtemps, en plus de consommer plus). Ainsi, sur une passe de PCMark Vantage, le Phenom II X4 consomme 70% d'énergie en plus par rapport au Core i5, tout en étant sensiblement plus lent !

Si AMD a fait de gros progrès avec ses Phenom II X4, en arrivant à un niveau de performance proche de celui des Core 2 Quad, il montre également que le fondeur a encore de gros progrès à faire en termes de consommation pour reprendre le leadership à Intel.