C'est indéniables, les systèmes Microsoft ont fait d'énormes progrès en termes de sécurité ces dernières années. Mais il reste toujours un problème important : le recours à des comptes utilisateurs disposant de droits administrateur. En effet, même avec l'UAC, ces comptes sont bien plus exposés que des comptes utilisateur classiques.

Si ce comportement est relativement logique, et concerne quasiment tous les systèmes existants, y compris Linux et Mac OS X, il affecte particulièrement Windows, qui proposent toujours un compte disposant des droits administrateur comme compte par défaut, alors que ses concurrents proposent (voir imposent...) depuis longtemps un compte utilisateur un peu plus restreint.

En analysant les vulnérabilités concernant les produits Microsoft en 2009 (environ 200 vulnérabilités), BeyondTrust, un éditeur de solutions de sécurité, a pu établir un bilan chiffré de l'impact des droits administrateurs sur la sécurité. Ainsi, dans 9 cas sur 10, les failles critiques touchant Windows 7 deviennent quasiment inoffensives si l'utilisateur ne dispose pas des droits administrateur. Sous Microsoft Office et Internet Explorer 8, on atteint même les 100% de failles atténuées par l'absence de droits administrateur. Globalement, sur l'ensemble des produits Microsoft, ce sont pas moins de 81% des failles critiques qui sont atténuées chez les utilisateurs limités, et 64% de l'ensemble des failles.

Malheureusement, l'héritage du passé étant ce qu'il est, de nombreux logiciels nécessitent encore des droits administrateur pour s'exécuter correctement. Mais conscient de ces problématiques de sécurité, Microsoft travaille avec les éditeurs pour rendre le recours à ces droits de moins en moins indispensable, ce qui devrait permettre de s'en passer d'ici quelques années. En attendant, il serait bon que Microsoft travaille sur un moyen un peu plus simple d'élever les privilèges en cas de besoin, à la façon de ce qui est fait sous Mac OS X ou Linux, ce qui permettrait de faciliter grandement la transition vers des comptes non administrateur.

Posté par Matt le 01/04/2010 à 10h57

Aucun commentaire

Source : Generation NT

Alors que l'HADOPI peine à se mettre en place, les internautes français n'auraient pas encore changé leurs habitudes de téléchargement. Au contraire même, certains auraient intensifié leur consommation de contenus illicites, par défiance envers la Haute Autorité... Mais la riposte s'organise, et elle risque de faire très mal !

En effet, une nouvelle entité serait à l'étude, pour éradiquer définitivement le problème du téléchargement illicite. Baptisée Autorité pour la Validation et la Régulation d'un Internet Légal, cette nouvelle autorité change radicalement de stratégie. En effet, plutôt que de s'attaquer aux fournisseurs de contenus, elle va instaurer des contrôles au niveau des tuyaux en partant d'un constat tout bête à la portée de n'importe quel adepte de la stratégie du moindre effort : pour rendre les offres légales plus attractives, il suffit de rendre les offres illicites moins attractives... Et pour ça, il existe un moyen tout simple : jouer sur les débits !

Sous le contrôle de cette nouvelle autorité, les FAI auront l'obligation de brider les débits de leurs abonnés en fonction de l'IP avec laquelle les échanges de données sont effectuées. Cette autorité publiera chaque mois trois listes d'IP correspondant à trois "zones" Internet, chacune bridée à une certaine vitesse :

- la zone 30 : elle comportera les IP identifiées comme hébergeant des sites susceptibles d'être visités par des mineurs. Afin de freiner la pédophilie, le débit sur ces sites sera limité à 30 Ko/s,

- les sites dont le contenu est contrôlé par les autorités locales ou par l'état (sites de communes, sites des ministères, presse...) : la vitesse y sera limité à 90 Ko/s,

- les sites de téléchargement légal : il s'agira des sites identifiés comme fournissant du contenu multimédia dans le respect des droits d'auteurs, soit sous forme gratuite, soit sous forme payante, facturée au Mo. Afin de favoriser les offres payantes, celles-ci ne seront limitées qu'à 130 Ko/s, contre 110 Ko/s pour les offres gratuites.

Un groupe d'artistes expatriés en Suisse et représenté par notre Johnny national négocierait également la mise en place d'un palier intermédiaire entre les sites de téléchargement gratuits et les sites payants, en proposant une offre particulièrement compétitive : le téléchargement à 120 Ko/s moyennant un forfait annuel facturé moins de 30€ !

Par défaut, les IP n'appartenant à aucune de ces zones seront limités à 50 Ko/s. Ainsi, télécharger illégalement un MP3 sera 2.6 fois plus long que de le télécharger sur un site payant, ce qui devrait convaincre certains utilisateurs de rentrer dans le droit chemin.

La nouvelle autorité va également profiter d'une autre leçon tiré d'HADOPI : afin d'éviter la grogne des opérateurs en raison des coûts élevés qu'impliqueraient la mise en place de telles limitations sur l'ensemble du réseau, ces limitations de débit ne s'appliqueront pas par bridage, mais sur la base de la bonne volonté de l'utilisateur. Les opérateurs pourront donc toujours vendre des offres allant bien au delà des vitesses autorisées, les utilisateurs pourront toujours atteindre ses vitesses... mais il pourront à tout moment être contrôlés via des systèmes automatisés !

En cas de dépassement avéré du débit autorisé, l'utilisateur sera puni d'une amende et de 1 à 6 mails d'avertissement, en fonction de la gravité de l'infraction (le titulaire de l'abonnement pourra toutefois contester les avertissements en indiquant l'identité de la personne qui utilisait sa connexion au moment de l'infraction). Au 12ème mail d'avertissement, il sera demandé au titulaire de ne plus se servir de sa connexion, et il s'exposera à de lourdes poursuites s'il ne respecte pas cette sanction, pouvant aller jusqu'à la saisie de son modem. Une dérogation pourra être obtenue sous condition, pour les personnes ayant impérativement besoin de leur accès Internet pour leur travail.

Reste à voir si ces nouvelles mesures seront plus efficaces que les précédentes... Il se pourrait que non, puisque le site Die Piratebahn aurait déjà annoncé avoir trouvé une faille dans le système de contrôle, et affirme être en mesure de proposer du téléchargement gratuit avec un débit illimité vers toutes les IP allemandes. Si Die Piratebahn tient ses promesse, cette nouvelle mesure risque donc une fois de plus de pénaliser les utilisateurs honnêtes en dégradant leur confort d'utilisation, tout en laissant passer les pirates entre les mailles du filets...

Posté par Matt le 01/04/2010 à 08h20

3 commentaires

![]()

Maintenant que les autorités européennes ont validé le rachat de Sun par Oracle, à la suite des autorités américaines, le rachat du constructeur de serveurs par l'éditeur de SGBD est entériné, et les premières mesures induites par ce rachat semblent prendre forme...

Difficile en effet de ne pas mettre sur le compte d'Oracle un changement majeur qui vient d'intervenir au niveau de Solaris 10, le système d'exploitation Unix que Sun propose à ses clients : l'utilisation du système au delà d'une période d'essai de 90 jours nécessitera désormais la souscription à un contre de service, alors que le système était jusqu'à présent utilisable indéfiniment et gratuitement sans un tel contrat.

OpenSolaris, la version libre de Solaris, reste pour sa part entièrement gratuite, mais Oracle n'a pris aucun engagement sur les évolutions futures de ce système, et à même au contraire déjà affirmé que les nouveautés futures de Solaris ne seraient pas forcément portées dans OpenSolaris...

Espérons que MySQL ne prenne pas la même voie une fois qu'Oracle ne sera plus soumis aux engagements formulés en fin d'année dernière. À noter que dans cette éventualité, la résistance s'organise déjà : le créateur de MySQL a lancé un nouveau projet open-source, MariaDB, qui restera basé sur MySQL tant que ce sera possible, et pourra continuer ensuite à vivre de son côté si Oracle décidait de fermer MySQL.

Posté par Matt le 31/03/2010 à 22h42

2 commentaires

Source : Tom's Hardware

La 3D est aujourd'hui devenue la nouvelle mode pour attirer le public dans les salles obscures, mais aussi pour pousser au renouvellement du matériel vidéo domestique. Nos confrères de chez Tom's Hardware proposent à leur lecteur un guide original pour passer à la 3D sans investir dans du matériel dernier cri.

Leur solution utilise un système de projection basé sur la polarisation de la lumière, assez similaire à celui utilisé dans la plupart des cinéma. L'avantage de ce système est qu'il ne nécessite pas un équipement de projection spécifique (contrairement aux systèmes à lunettes occultantes, qui nécessitent un projecteur capable d'afficher à haute fréquence et de se synchroniser avec les lunettes) : le guide de Tom's Hardware vous permettra de réaliser un système de projection 3D à partir de deux projecteurs classiques.

Il suffit en effet de monter sur chacun des projecteur un filtre polarisant et de projeter vers un écran spécifique, qui conserve la polarisation, et le tour est joué.

Malheureusement, il ne faut pas s'attendre pour l'instant à une véritable solution low cost, puisque malgré le côté "bidouillé à la maison" de cette solution, il faudra tout de même compter environ 400$ de filtres polarisant et 150$ d'écran, en plus du coût des deux projecteurs et d'un PC de salon, indispensable pour piloter les deux appareils.

Posté par Matt le 31/03/2010 à 11h11

Aucun commentaire

Les habitués des CD-R et des DVD-R le savent sans doute : ces supports de stockage ne sont pas des modèles de fiabilité dans le temps, ceux-ci ayant une certaine tendance à devenir illisible plus ou moins rapidement... Une étude de l'Académie des Sciences confirme ce manque de fiabilité, et le quantifie pour la première fois.

Ainsi, selon cette étude, 8% des CD inscriptibles seraient illisibles au bout de seulement 4 ans. Pire, les supports de certaines marques ne tiennent parfois même pas un an, alors que les meilleurs frisent une durée de vie de 20 ans ! Du fait de leur densité plus élevée, les supports plus modernes, tels que le DVD-R et le BD-R seraient encore moins à l'aise dans le temps. Sachant qu'environ 10 milliards de galettes sont vendues par an, le volume de données en danger de disparition a de quoi donner le vertige...

Alors, vers quoi se tourner ? Les disques durs ? Échec ! L'étude de l'Académie des Sciences dresse également un portrait plutôt sombre de ces derniers. En effet, la majorité des disques durs rendraient l'âme au bout de seulement cinq années d'utilisation. Et comme pour les supports optiques, les supports les plus denses sont les moins durables, accentuant encore la gravité de la situation, puisque les volumes de données perdus sont d'autant plus grands...

Les mémoires flash ? Pas mieux ! On le sait depuis longtemps, les mémoires flash stockent les données sous forme de charges électriques, chargent qui ont tendance à disparaitre avec le temps à cause des courants de fuite.

Le stockage en ligne ? S'il apparait très séduisant, en détachant l'utilisateur de toutes les indispensables tâches de maintenance, le stockage en ligne ne serait en fait pas non plus viable, en raison de l'énorme volume de données à stocker, qui nécessiterait d'investir des sommes phénoménales dans les serveurs.

La solution est donc finalement surtout de rester très attentif à l'état de ses données, en les copiant régulièrement sur de nouveaux supports, et surtout, en gardant toujours plusieurs exemplaires des données les plus importantes.

Les auteurs de l'étude espèrent également que leurs conclusions pousseront certains industriels à se lancer dans la recherche de nouvelles solutions de stockage plus durables, pour assurer la sauvegarde à long terme des données numériques.

Posté par Matt le 30/03/2010 à 22h59

7 commentaires

Sources : PCWorld et ZDNet via Ptit_boeuf

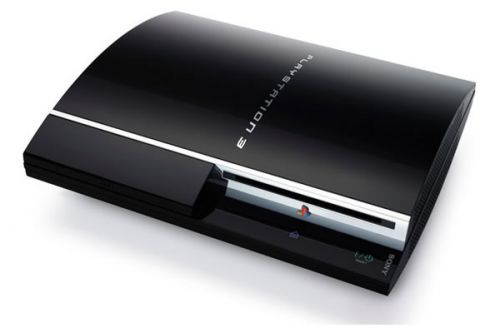

Des trois principaux constructeurs de consoles, Sony a longtemps été le plus ouvert, en autorisant l'installation de systèmes d'exploitation alternatifs, principalement sur base Linux, sur les PlayStation 2 et les PlayStation 3, ce qui permettait de les utiliser comme de vrais ordinateurs. Mais après l'abandon de cette possibilité sur les derniers modèles (PS3 Slim), Sony vient d'annoncer une bien mauvaise nouvelle pour les adeptes de Linux sur PS3...

En effet, le nippon va diffuser à partir de jeudi le firmware 3.21 de sa console, firmware qui supprimera la possibilité d'installer un OS alternatif sur tous les modèles de PlayStation 3, et qui effacera d'office les installations existantes. Ce choix aurait été fait pour des raisons de sécurité, une faille matérielle dans le gestionnaire de mémoire risquant d'autoriser au système Linux un accès un peu trop libre à la mémoire de la console... Difficile de ne pas faire un lien entre cette annonce et une autre, émanant de GeoHot il y a quelques semaines, qui annonçait avoir réussi à prendre la main sur l'hyperviseur de la console et avoir ainsi obtenu un accès complet à la mémoire. Plus que la sécurité des utilisateurs de la console, ce serait donc en fait la protection du mécanisme anti-copie qui motiverait Sony...

Bien entendu, comme chaque mise à jour de la console, cette mise à jour ne sera pas obligatoire. Toutefois, Sony prévient d'ores et déjà que certaines fonctionnalités ne pourront plus fonctionner sans la mise à jour, et leur absence risque de faire perdre beaucoup de son intérêt à la console :

- plus d'accès aux PlayStation Network, et donc à tous les services qui y son liés (chat, jeu en ligne, téléchargement de démos et de mises à jour de jeux, etc...),

- les jeux à venir ne pourront pas fonctionner.

Le refus de la mise à jour sera donc surtout réservée à ceux qui ont acheté une PlayStation 3 sans la moindre intention d'utiliser les fonctionnalités prévues par Sony, comme par exemple certains laboratoires de recherche qui ont exploité la grande puissance de calcul de la PS3 pour monter des clusters à moindre coût.

Posté par Matt le 30/03/2010 à 10h18

Aucun commentaire

Source : PCInpact

Présente quasiment depuis toujours dans les téléphones mobiles, la carte SIM permet d'identifier la ligne associée au téléphone sur le réseau de son opérateur de rattachement. Mais elle sert aussi, par le biais de son identifiant opérateur, à restreindre l'usage d'un terminal donné sur un réseau donné, en configurant simplement le téléphone pour qu'il n'accepte que les cartes dotées du bon identifiant opérateur.

Un verrouillage qui n'est aujourd'hui clairement pas dans l'intérêt de l'utilisateur. En effet, s'il pouvait se justifier dans le cas d'un mobile subventionné par l'opérateur mais non assorti d'un forfait avec engagement de durée, ce type d'offre n'existe quasiment plus, les grosses subventions étant aujourd'hui toujours associées à des engagements d'un à trois ans, tandis que les offres sans engagement sont cantonnées à des mobiles peu ou pas du tout subventionnés.

Partant de ce constat et de la gêne induite par ce système de verrouillage, en particulier pour les utilisateurs se déplaçant régulièrement à l'étranger, et qui auraient donc tout intérêt à se doter d'une carte SIM prépayée de leur pays de destination pour éviter les coûts exorbitants du roaming, le ministère japonnais de la communication serait en train d'étudier la possibilité d'interdire ce verrouillage.

Une bonne nouvelle pour les utilisateurs japonnais, qui seront sans doute ravis de constater que leur gouvernement est encore capable de privilégier l'utilisateur plutôt que les opérateurs. Si ce projet abouti, espérons qu'il donnera des idées en France et en Europe...

Posté par Matt le 29/03/2010 à 22h59

Aucun commentaire

Source : Clubic

Depuis quelques jours, c'est le printemps, et avec lui, l'arrivée de la saison des barbecue. nVidia a donc pensé aux joueurs amateurs de viande grillée, en lançant ce week-en ses nouvelles cartes graphiques haut de gamme aux spécifications hors du commun, les GeForce GTX 480 et 470.

Comme nous vous l'annoncions il y a quelques jours, les GeForce GTX 480 et 470 sont toutes deux basées sur la nouvelle puce GF100 (Fermi) et ses 3 milliards de transistors, cadencée respectivement à 700 MHz et 607 MHz. Elle est dotée de 480 cœurs à 1401 MHz dans la GTX 480, contre 448 cœurs à 1215 MHz dans la GTX 470, le tout épaulé respectivement par 1.5 Go de GDDR5 à 924 MHz sur bus 384 bts et 1.25 Go de GDDR5 à 837 MHz sur bus 320 bits.

Les premiers tests montrent que la GeForce GTX 480 permet à nVidia de sauver l'honneur, en proposant à nouveau le GPU le plus puissant du marché, grâce à une avance moyenne de l'ordre de 5 à 20% par rapport au GPU haut de gamme actuel d'ATI, le Radeon HD 5870. Mais le canadien garde tout de même la palme de la carte la plus performante du marché avec sa Radeon HD 5970, dotée de deux GPU, qui surpasse assez largement la GTX 480, tout en offrant un rapport performances/prix beaucoup plus avantageux, grâce à un tarif conseillé de 599$, contre 499$ pour la GTX 480.

Le rapport avec le barbecue ? En plus d'offrir un rapport performances/prix très moyen, ces nouvelles GeForce se permettent également d'être des gouffres énergétiques, en réclamant près de 300W en pointe (malgré un TDP annoncé à "seulement" 250W par nVidia...). Résultat des courses, malgré une bruyante turbine de refroidissement, la carte atteint des températures très élevées. Et comme elle est surmontée d'une plaque métallique striée, elle devrait être idéale pour les grillades, pour peu que vous disposiez d'un boîtier "tête en bas".

Enfin, on notera que ces cartes seront disponibles au compte goutte, avec des quantités extrêmement réduites (on parle d'à peine 200 unités pour la France), ce qui ne devrait pas aider à voir les prix baisser rapidement. Il faudra donc probablement attendre une nouvelle révision de la puce GF100 pour qu'nVidia puisse offrir des cartes plus sobres et plus abordables, mais aussi des déclinaisons d'entrée et de milieu de gamme, marchés bien plus demandeurs que le haut de gamme. En attendant, on peut d'ores et déjà considérer que, après avoir largement perdu la bataille sur la première génération de cartes DirectX 10, AMD a gagné la première bataille du DirectX 11, avec sa gamme Radeon HD 5000, qui domine désormais de l'entrée au haut de gamme, en passant par le milieu de gamme.

Posté par Matt le 29/03/2010 à 21h48

Aucun commentaire

Après les iPod, les iPhone et bientôt les iPad, la prochaine étape du développement d'Apple dans le secteur du divertissement numérique sera-t-il une "iTV", sorte de super TV dopée au jus de pomme ? C'est en tout cas l'opinion de Piper Jaffray, qui pense qu'un tel produit pourrait arriver d'ici deux à quatre ans.

En effet, pour ce cabinet d'analystes habitué à étudier Apple, le marché de la TV multi-fonctions connectée à Internet pourrait être la prochaine étape pour la pomme, en surfant sur la popularité de ses périphériques multimédia. Selon les analystes, une telle solution pourrait combiner en un seul appareil les fonctions actuellement confiées à une demi-douzaine de produits connectés ensembles. Une intégration qui apporterait beaucoup en simplicité, tout en permettant éventuellement des économies sur le prix d'achat.

Ainsi, Apple pourrait proposer une TV 40" pour un peu moins de 1999$. Celle-ci intégrerait un disque dur pour réaliser des enregistrements stocker des fichiers achetés sur l'iTunes Store, mais aussi un véritable petit ordinateur permettant d'exécuter des applications en provenance de l'App Store, et en particulier des jeux. Apple pourrait également proposer un abonnement iTunes TV, d'un montant estimé de 50 à 90$ par mois, qui donnerait accès à des chaînes payantes, aux service de catch-up TV et à la VOD. En plus de la simplicité d'un tout en un, une telle solution serait plus économique, puisque Piper Jaffray estime qu'un ensemble de service et de fonctionnalités équivalent coûterai 2065$ à l'achat (via 6 appareils distincts), assortis de différents abonnements, pour un total mensuel de 97$.

Gardons tout de même à l'esprit qu'il s'agit pour l'instant uniquement de fantasmes d'analyses, et on est donc encore loin d'un produit annoncé officiellement par Apple.

Posté par Matt le 25/03/2010 à 10h41

Aucun commentaire

Source : MacWorld

Après avoir envahi à peu près tous les moyens de transport motorisés, de l'avion à la voiture en passant par le train, l'informatique est en train de faire son entrée dans les moyens de transport non motorisées, via les VTT...

En effet, le constructeur américain Cannondale vient d'annoncer une suspension informatisée pour son nouveau VTT, le Simon. Dotée d'un capteur optique et d'accéléromètres, cette suspension analyse en permanence l'état du chemin et la vitesse du VTT et en déduit le réglage idéal de la valve électro-hydraulique située dans l'amortisseur, ce qui permet de moduler la réponse de celui-ci, en le rendant par exemple plus rigide sur route et plus souple sur terrain très accidenté.

Et pour cette première, Cannondale n'a pas fait le choses à moitié, puisque le dispositif est déjà d'une précision redoutable : l'ouverture de la valve peut s'ajuster au micron près, et la latence du dispositif n'est que de 7ms ! Il aura donc fallu à peine plus de 20 ans entre la première suspension semi-active sur une voiture de série (Mitsubishi Galant de 1987) et l'arrivée d'un tel système sur un VTT. À quand l'ABS et l'ESP ?