Actualités du mois d'avril 2009

Notre partenaire Materiel.net vient d'obtenir le statut de "revendeur agréé" Apple. La plupart des produits Apple seront donc désormais disponible sur leur mini-site dédié à Apple et lancé pour l'occasion.

Pour fêter ça, Materiel.net lance également une offre promotionnelle, qui sera valable jusqu'au 31 mai prochain. Grâce à cette offre, pour tout achat d'un Mac portable ou de bureau, vous pourrez bénéficier de 25% de réduction sur l'extension de garantie Apple Care de 3 ans pour et de 10% sur l'édition standard d'Office 2008, soit 405€ pour la suite bureautique et 127 à 218€ pour l'Apple Car, en fonction de la machine.

Si vous envisagez l'achat d'un Mac, c'est donc le moment de le faire ! J'en profite également pour rappeler que pour toute commande passée sur Materiel.net dans un délai de 24h après avoir cliqué sur un lien depuis Infobidouille, nous touchons une commission qui permet de contribuer au financement du site sans le moindre surcoût pour l'acheteur. Merci d'avance à tous ceux qui choisiront Materiel.net !

Posté par Matt le 29/04/2009 à 23h41

Aucun commentaire

Source : Macbidouille

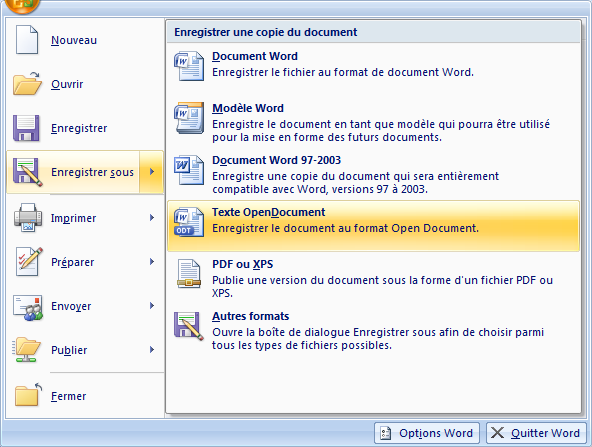

Microsoft l'avait promis il y a quelques temps : la suite bureautique Office devait être mise à jour pour supporter les formats Open Document. En effet, la norme OpenXML de Microsoft n'étant pas implémentée totalement dans la suite Office, elle ne gérait aucun format normalisé ISO, et il était apparemment plus simple pour Microsoft d'implémenter l'Open Document plutôt que son propre format (sic !).

Chose promise, chose due : le Service Pack 2 pour la suite Office 2007 publié aujourd'hui par l'éditeur de Redmond apporte bel et bien le support des formats Open Document dans Word (ODT), Excel (ODS) et Powerpoint (ODP). Ces nouveaux formats sont même relativement mis en avant, puisqu'ils ils sont accessibles directement depuis le menu "Enregistrer sous", sans avoir à passer par la boîte de dialogue "Autres formats". C'est donc une bonne nouvelle pour tous les partisans des suites bureautiques alternatives, la compatibilité avec Office étant grandement améliorée par le support natif de l'Open Document par Microsoft.

Autre signe d'ouverture de la part de Microsoft, le Service Pack 2 d'Office intègre désormais l'exportation au format PDF (qui était jusqu'à présent disponible via un complément facultatif), tout en améliorant le rendu de ces exports. Il est vrai que dans le domaine des formats de documents destinés à la publication, le XPS promu par Microsoft depuis quelques années n'a jamais réussi à se faire une place, tandis que, avec la volonté croissante des administrations et entreprises à utiliser des formats normalisés, le PDF est en position de force (normalisé ISO) pour devenir le format idéal pour la publication de documents.

Le Service Pack 2 pour Office 2007 est disponible dès à présent via Microsoft Update.

Posté par Matt le 29/04/2009 à 00h36

Aucun commentaire

Source : PC Inpact

Lorsqu'une nouvelle version de Windows pointe le bout de son nez, il n'est pas rare que certains programmes existants ne soient plus compatibles avec la nouvelle version de l'OS, soit en raison du non respect de certaines règles de développement, soit parce qu'ils utilisent des fonctions qui ne sont plus proposées dans le nouvel OS ou qui ne se comportent plus de la même façon...

Pour remédier à ce problème, Microsoft avait introduit depuis Windows XP (et Windows 2000 via un Service Pack) un mode compatibilité, qui devait permettre de simuler l'exécution de l'application dans une version antérieure de Windows. Mais le résultat était très mitigée, car ce mode ne permettait de contourner que quelques problèmes, essentiellement avec les applications qui vérifiaient le numéro de version de Windows.

Avec Windows, Microsoft a donc décidé d'aller plus loin. Beaucoup plus loin même ! En effet, Windows 7 contiendra Windows XP... Oui oui, vous avez bien lu. Pour assurer la compatibilité avec les applications les plus récalcitrantes, Microsoft a fait le choix radical d'inclure dans Windows 7 une machine virtuelle (basée sur Virtual PC) exécutant une image préconfigurée de Windows XP (image à télécharger). Par rapport à Virtual PC, un nouveau mode de fonctionnement a été ajouté, pour permettre aux fenêtres des applications tournant dans la machine virtuelle de s'afficher directement dans l'environnement graphique de la machine hôte (à l'instar du mode "seamless" proposé par VirtualBox).

Si cette solution est plus contraignante que le mode compatibilité (puisqu'il faudra installer les logiciels concernés dans la machine virtuelle), elle devrait avoir l'avantage d'offrir une compatibilité bien plus large. Elle risque toutefois de ne pas fonctionner avec les applications 3D et celles faisant un accès relativement bas niveau au matériel, deux domaines qui ne sont vraiment pas les points forts de Virtual PC. Pour en profiter, il faudra par contre posséder un processeur doté d'instructions dédiées à la virtualisation (Intel VT ou AMD Pacifia) et s'acquitter d'une licence "haut de gamme" de Windows 7, puisque les version familiales n'auront pas droit à cette fonction.

Cette nouveauté devrait faire son apparition dans la Release Candidate de Windows 7, attendue pour le 5 mai prochain.

Posté par Matt le 27/04/2009 à 13h29

2 commentaires

Source : NDFR.net

Depuis la saison 2002, représenté mi 2003 dans le F1 Challenge 99-02 d'Electronic Arts, la Formule 1 avait déserté les écrans de nos PC. Non pas par manque d'intérêt des éditeurs ou par manque de public, mais parce que Sony s'était offert une licence exclusive pour l'exploitation de la Formule 1 dans les jeux vidéos, licence que le nippon n'a bien entendu exploité que sur PlayStation, avec la série des Formula 1. Mais ceci ne sera bientôt plus qu'un mauvais souvenirs pour les pilotes virtuels !

En effet, c'est désormais Codemasters qui possède une licence exclusive pour la Formule 1. L'éditeur a annoncé qu'il sortira dans un premier temps des versions Wii et PSP, tandis que la Xbox 360, la PS3 et le PC suivront l'année prochaine. Codemasters est un éditeur expérimenté dans le domaine de la course automobile (avec notamment à son actif six Colin McRae, deux TOCA Touring Cars, trois TOCA Race Driver et Race Driver GRID), donc on peut s'attendre à un jeu de bonne qualité, mais il reste toutefois une inconnue : prendra-t-il la voie de la simulation orientée arcade, comme F1 Challenge 99-02, ou plutôt la voie de la simulation pure et dure, comme F1 Racing Championship ? Malheureusement pour les amateurs des simulations, il y a de bonnes chances que l'arcade l'emporte, vu la tendance des principales franchises de Codemasters ces dernières années...

Pour rappel, F1 Challenge 99-02 était à l'époque un jeu plutôt orienté arcade, qui avait la particularité de regrouper les quatre saisons de F1 pour lequels EA disposait d'une licence. Il était le premier jeu à utiliser le moteur ISI, qui a ensuite été utilisé par l'une des références de la simulation de course sur PC, le fameux GTR premier du nom.

F1 Racing Championship, lancé par Ubi Soft en 2001, reste pour sa part l'une des référence absolue du genre. Il nous faisait vivre la saison 1999, avec un réalisme inégalé dans un jeu sous licence officielle (les mods F1 non officiels pour rFactor le dépassent tout de même sur de nombreux points). Malgré ses huit ans d'âge et ses graphismes qui ont beaucoup vieilli, il m'arrive d'ailleurs encore de le dépoussiérer pour quelques tours de circuit.

Pour Sony, le transfert de la licence vers Codemasters représentera donc encore une exclusivité de moins pour la PlayStation 3. Avec les rumeurs de portage de Gran Turismo sur PC, il ne restera plus grand chose pour convaincre les pilotes en herbe de se tourner vers la console de Sony...

Mise à jour le 25/04/2009 à 12h21 :

La FIA a publié sur son site quelques captures d'écran du jeu F1 2009, en version Wii et PSP. Finalement les graphismes de F1 Racing Championship n'ont pas vieillis tant que ça :-)

On peut d'ores et déjà constater que sur la version PSP, la température et/ou l'usure des pneus est gérée. Une donnée qui était présente dans TOCA Race Driver 3, mais avait disparu de Race Driver GRID. On peut donc espérer un jeu au comportement plus proche de la simulation que les derniers titres de Codemasters.

Actu originale : 24/04/2009 à 1h38.

Posté par Matt le 25/04/2009 à 12h21

Aucun commentaire

Source : F1-Live

Lorsque l'iPhone est arrivé, certains avaient émis l'idée qu'Apple pourrait proposer des MacBook utilisant un écran tactile d'iPhone comme trackpad, pour disposer d'un écran secondaire, voir un "dock" évolué, comprenant un clavier et un écran, et dans lequel l'iPhone viendrait s'enficher pour constituer le trackpad et le coeur de l'a machine. Si Apple n'a pas concrétisé ces concepts, Sharp vient par contre d'adapter la première idée sur son prochain modèle de netbook, le Mebius NJ70A.

Ceux-ci se distinguent en effet de la concurrence par un écran LCD tactile qui tient lieu de trackpad. Cet écran peut être utilisé comme un simple trackpad, mais aussi comme une mini-tablette graphique, avec affichage direct sur le pad de ce qui est dessiné (avec le stylet fourni), voir pour afficher des petites applications dédiées, dont une application de création de cartes de vœux et un clavier musical virtuel.

Si la solution semble intéressante, on peut toutefois s'interroger sur l'impact de ce trackpad évolué sur l'autonomie de la machine, la consommation d'un écran LCD, même de petite taille n'étant pas négligeable par rapport à la consommation d'un netbook. Il faut donc espérer que la partie graphique de ce trackpad puisse être totalement désactivée lorsqu'on n'en a pas besoin.

Par ailleurs, Sharp ne précise pas si, à l'instar des écrans secondaires proposés sur certains portables Asus, ce trackpad peut être utilisé comme unique écran pour un système d'exploitation simplifié, qui permettrait par exemple de lire de la musique ou de consulter rapidement ses mails sans avoir à démarrer le système complet.

Du côté des caractéristiques techniques, le Mebius NJ70A embarque un processeur Atom N270, un chispet Intel 945GSE, un disque dur de 160 Go, une webcam... bref, un netbook tout ce qu'il y a de plus classique. Le trackpad est pour sa part un écran de 4" (donc légèrement plus grand que celui d'un iPhone) d'une résolution de 848x480 et avec un rétro-éclairage par LED. La partie tactile est bien entendu multi-touch, pour permettre l'utilisation de certaines fonctions avancées.

Posté par Matt le 25/04/2009 à 11h06

Aucun commentaire

Source : Akihabara News

Nous avons droit à pas mal de nouveautés du côté de Google cette semaine. Le moteur de recherche a en effet lancé trois nouveaux produits (à l'essai) : un nouveau moteur de recherche dans l'actualité, la recherche d'images par similarité et l'API O3D.

Baptisé Google News Timeline, le nouveau moteur de recherche dans les actualités innove par sa mise en page : plutôt que d'être présentés sous forme de liste hiérarchisée, les actualités y sont présentées de façon chronologique, ce qui permet de suivre l'enchainement des actualités sur un sujet donné.

Il est possible de créer des filtres, pouvant porter sur la catégorie, sur des mots-clés, etc... L'affichage se fait à différents niveau de "zoom" (jour, mois, année, décennie...), chaque niveau présentant les actualités les plus importantes de la période. En plus des actualités, les événements recensés par Wikipedia sont également pris en compte, ce qui permet de retracer une large période de l'histoire, en remontant plusieurs siècles en arrière.

La recherche d'images par similarité (Google Similar Images) est pour sa part une évolution de Google Image. À partir d'une recherche sur un mot clé (liberté par exemple), il devient possible de sélectionner un des résultats et de demander une recherche d'images similaires (par exemple, La liberté guidant le peuple d'Eugène Delacroix ou la Statue de la liberté). Après avoir effectué différents essais, il semble que la recherche d'images similaires se base à la fois sur des mots clés commun (ceux-ci n'était pas forcément ceux ayant mené à l'image source) et sur des analyse basique de l'image (couleurs, formes grossières).

Enfin, la troisième nouveauté intéressera plutôt les fournisseurs de contenus : Google vient de rendre publique l'API O3D qui, via un plug-in installé sur le navigateur, permettra de créer des animations 3D directement depuis une page web. Ceci pourrait par exemple donner plus de richesse visuelle aux nombreux jeux en ligne se jouant uniquement au travers d'un site web. Une belle vidéo valant mieux qu'un long discours, voici la vidéo de présentation de cette API :

O3D Beach Demo

Bientôt Infobidouille en 3D ? Ou pas...

Posté par Matt le 22/04/2009 à 23h20

Aucun commentaire

Il y a deux semaines, nous apprenions que Sun avait refusé l'offre officieuse de rachat d'IBM, pour diverses raisons, dont un manque de garanties dans le cas où les autorités de régulation de la concurrence remettraient en cause le rachat. Nouveau rebondissement aujourd'hui dans cette histoire : Sun n'est plus à vendre !

Et pour cause : le fabricant de serveur, mais aussi éditeur de certains logiciels renommés (MySQL, VirtualBox...) et créateur du langage Java a été vendu. Non pas à IBM ou à un autre grand fabricant de serveurs, comme on aurait pu s'y attendre, mais à Oracle, l'éditeur du logiciel de gestion de bases de données du même nom. Cette vente se fera au prix de 7.4 milliards de dollars, soit un peu plus que les 7 milliards proposés dans la dernière offre d'IBM.

Alors qu'Oracle ne produisait jusqu'à présent que du logiciel, l'entreprise pose donc un pied dans le domaine du matériel via ce rachat. On ne sait pas encore quels seront les débouchés réels de ce rachat, mais on peut tout de même parier sur des possibilités pour Oracle de vendre des solutions clés en main, construites autour d'un serveur Sun sur lequel les applications Oracle seraient préinstallées et préconfigurées.

Oracle met également la main sur le gestionnaire de bases de données MySQL. Si ce dernier ne pouvait pas rivaliser avec Oracle sur les gros systèmes, sa gratuité et sa légèreté en font un des leaders dans le domaines des petites bases de données. En le faisant tomber dans son giron, Oracle pourra donc proposer une gamme plus large de solutions de base de données, pouvant aussi bien répondre aux besoins de petites PME qu'aux besoins des plus grands comptes.

Posté par Matt le 20/04/2009 à 22h35

Aucun commentaire

Source : PCWorld

Bon nombre d'amateurs de belles mécaniques en ont rêvé, Sony et Polyphony Digital vont peut-être le faire : d'ici quelques temps, il sera peut-être enfin possible de jouer à Gran Turismo sur PC !

À mi-chemin entre les simulations pures et dures que sont GTR2, rFactor ou Live For Speed et les simulations "arcadifiées" comme par exemple la série des TOCA Race Driver, la famille Gran Turismo est pour beaucoup une des référence de la course automobile virtuelle, en grande partie grâce à la richesse offerte par les Gran Turismo, tant dans le choix des véhicules que dans le nombre de circuits où les possibilités de modification des voitures.

Selon John Koller, directeur du marketing de Sony USA, Polyphony Digital, le studio de développement à l'origine de la série, serait en train d'étudier la possibilité d'une version PC de Gran Turismo 5 (alors que la version PlayStation 3 n'est toujours pas terminée...), destinée dans un premier temps au marché chinois. Si cette version se concrétisait, ce serait une petite révolution, la série faisant partie des plus anciennes (et des dernières) licences exclusives dont dispose Sony sur la PlayStation.

L'information reste en tout cas particulièrement surprenant, car Gran Turismo représentait pour beaucoup une bonne raison, voir la seule raison d'acheter une PlayStation, et offrir une version PC pourrait donc nuire aux ventes de la console, alors mêmes qu'elles sont inférieures aux attentes de Sony... Après ça, il ne manquerait plus qu'un portage sur PC de la famille Formula One (qui bénéficie d'une licence FIA exclusive depuis plusieurs années) pour faire mon bonheur, et me faire économiser l'achat d'une PS3 :-)

Posté par Matt le 16/04/2009 à 10h32

6 commentaires

Source : Puissance PC

Depuis quelques années, les écrans larges sont devenus la norme, et les écrans au format 4/3 ou 5/4 ont quasiment disparu du marché. Malheureusement, la plupart des applications ne se sont pas adaptées à ce format, en continuant à placer les barres d'outils horizontalement. Dans une future version, Firefox pourrait bien lancer la mode des applications "larges".

En effet, la future version 3.6, actuellement connue sous le nom de code Namoroka, devrait proposer de positionner les onglets dans une barre verticale sur le côté de la fenêtre. Cette nouvelle disposition permettrait donc de profiter de la surface offerte en largeur par les écrans actuels, tout en laissant une plus grande hauteur disponible pour l'affichage du contenu des sites. Les onglets verticaux auront également l'avantage de permettre l'affichage d'un plus grand nombre d'onglets à l'écran, sans pour autant trop rogner sur la largeur du titre affiché. Enfin, cette nouvelle barre d'onglets pourrait être hiérarchisée, pour rendre l'organisation des onglets plus logique.

Cette nouvelle version de Firefox devrait être disponible en 2010. En attendant, ceux qui seraient pressés de tester cette nouvelle disposition pourront se rabattre sur l'extension Tree Style Tabs ou sur le navigateur Opera.

Posté par Matt le 15/04/2009 à 23h01

Aucun commentaire

Source : Generation NT

Au milieu des souris embarquant des capteurs de plus en plus sophistiqués et un nombre croissant de boutons, la Microsoft Arc Mouse se distingue par un capteur laser tout ce qu’il y a de plus classique et seulement trois boutons. Elle doit toute son originalité à son design : elle se présente sous la forme d’un arc de cercle qui peut être replié pour réduire l’encombrement de la souris.

Posté par Matt le 14/04/2009 à 21h24

Aucun commentaire

L'avènement d'Internet a profondément changé le marché de la téléphonie, en permettant désormais de téléphoner partout dans le monde sans gros surcoût, grâce à la VoIP, qui véhicule des appels téléphoniques dans les "tuyaux" d'Internet.

Mais il existe encore un secteur d'Internet pour lequel la VoIP est quasi inexistante : l'Internet mobile via les réseaux cellulaires. En effet, si les connexions Internet illimitées via les réseaux 3G gagnent aujourd'hui en popularité grâce aux dernières générations de smartphones et aux modems 3G qui accompagnent certains netbooks, les opérateurs mobiles tiennent à continuer d'assurer (et de facturer...) les communications vocales. La plupart des opérateurs ont donc tout simplement interdit l'utilisation de la VoIP à leurs abonnés.

Considérée comme un frein au développement de services innovants, ces interdictions ne sont toutefois pas du goût de l'Union Européenne, qui aimerait casser ces clauses des contrats des opérateurs mobiles. Viviane Reding, responsable des législations sur les Télécoms au niveau européen a ainsi demandé aux pays de l'Union de prendre des mesures légales contre les opérateurs mobiles qui continueraient d'interdire ce type de services.

Voilà donc une bonne nouvelle pour les propriétaires de smartphones, et en particulier pour ceux qui sont également titulaires d'un abonnement Internet Free, le FAI fournissant à tous ses abonnés un compte téléphonique SIP, permettant de téléphoner de n'importe où et vers n'importe quelle destination en bénéficiant des mêmes conditions tarifaires qu'avec le téléphone fixe branché à la Freebox. L'autre grand gagnant pourrait être Skype, dont le service Skype Out pourrait devenir particulièrement attractif, combiné à un abonnement mobile incluant un faible quota d'appels vocaux et les connexions data en illimité (chez Orange, un tel abonnement coûterait actuellement 16€).

Posté par Matt le 13/04/2009 à 22h26

2 commentaires

Source : TGDaily

À la surprise générale, l'assemblée nationale a rejeté hier le projet de loi Création et Internet, avec 21 voix contre et 15 voix pour (soit à peine 36 votants sur les 577 députés que compte l'assemblée...) ! La majorité, trop sûre de sa victoire, n'avait pas crû nécessaire de mobiliser ses forces pour le vote...

Ce nouvel épisode du feuilleton HADOPI fait suite à un vote "pour" très contesté le jeudi 2 avril (16 votants...), suivi d'un passage en commission mixte paritaire (le texte voté par le sénat et celui voté par l'assemblée étant différents) après lequel le texte définitif avait été accepté par le sénat hier matin.

Si ce nouveau vote ne tue pas totalement le projet de loi, il va fortement le ralentir, et surtout, montrer une nouvelle fois que ce texte est loin de faire l'unanimité !

Posté par Matt le 10/04/2009 à 18h59

Aucun commentaire

![]()

Après les téléphones, les appareils photos, les baladeurs, les imprimantes, etc... c'est désormais au tour des écrans de devenir "intelligents", comme en attestent les nouveaux écrans LG de la gamme W53 Smart.

Proposés dans des diagonales de 18.5 à 27", ces écrans 16/9ème full HD (à partir de 21.5") offrent en effet diverses fonctions intelligentes qui pourront rendre de fier services à leurs propriétaires. On passera outre la fonction permettant de compter le temps passé devant l'écran pour aller directement à la fonction qui intéressera les amateurs de vidéo : cette gamme d'écran embarque une électronique capable de détecter les bandes noires et de couper les rétroéclairage de ces parties de l'image. Ainsi, ces bandes seront réellement noires, et non plus grises comme sur la plupart des écrans LCD, tandis que cette fonction permettra également d'économiser un peu d'énergie. Plus classique, un capteur de luminosité permet d'adapter les réglages de l'écran aux conditions ambiantes, avec là aussi une économie d'énergie à la clé, en évitant de mettre le rétroéclairage au maximum quand ce n'est pas nécessaire.

Notez au passage que LG n'est pas le seul à proposer des écrans intelligents. En effet, certains téléviseurs Sony Bravia intégrent également des fonctions d'économie d'énergie "intelligentes" : des capteurs de présences permettent de détecter les spectateurs dans un rayon de 7m autour du téléviseur. Si le téléviseur ne détecte aucun spectateur dans ce rayon, l'image est coupée au bout de 5 minutes et le son au bout de 10 minutes. Dommage que LG n'ait pas également intégré une telle fonction, pour pousser jusqu'au bout l'idée de l'écran "intelligent".

Posté par Matt le 09/04/2009 à 11h10

Aucun commentaire

Source : Matbe

Depuis des années, quasiment tous les ordinateurs sont vendus à un prix incluant ce que certains qualifient de "taxe Windows", c'est-à-dire le prix de la licence Windows systématiquement inclus dans le prix de vente, avec très peu de possibilités de passer outre. En France, cet état de fait devrait changer en 2009 !

En effet, vendre une licence Windows avec chaque ordinateur est considéré en France comme une vente liée, vente qui n'est autorisée que si les différents éléments composants l'ensemble sont également proposés séparément. Or, s'il est facile de se procurer une licence Windows sans acheter un ordinateur, réussir à acheter un ordinateur de grande marque sans la licence Windows qui va avec relève souvent du parcours du combattant.

Mais selon un courrier adressé par la Direction Régionale de la Concurrence, de la Consommation et de la Répression des Fraudes de la région Poitou-Charentes à un consommateur lésé, l'année 2009 pourrait marquer un tournant pour les consommateurs français : les grandes surfaces devraient dès cette année communiquer de façon plus clair auprès de leurs clients sur les possibilités de remboursement des logiciels pré-installés, y compris le système d'exploitation (sur la base du tout ou rien), mais aussi expliciter les procédures à suivre pour demander le remboursement.

Il ne manquera donc plus que l'affichage systématique du prix détaillé et la possibilité de choisir avant l'achat plutôt que de payer puis de demander le remboursement, et la "taxe Windows" ne sera plus qu'un lointain souvenir pour les adeptes des systèmes alternatifs.

Posté par Matt le 08/04/2009 à 17h50

Aucun commentaire

Source : PCInpact

Après les stations de travail il y a quelques semaines, c'est désormais au tour des serveurs Apple de basculer des processeurs Xeon 54xx "Harpertown" (Penryn) aux Xeon 55xx "Gainstown" (Nehalem), dans la plus grande discrétion, avec tout juste une fermeture de l'Apple Store pendant quelques heures.

Comme d'habitude, ces serveurs se présentent sous la forme d'une rack 19" 1U (1.75" d'épaisseur) au design très soigné (même si ce n'est pas vraiment la priorité des acheteurs de serveurs...). A l'intérieur, on trouvera un ou deux processeurs Nehalem quad-core, 6 slots mémoire DDR3 par processeur, une alimentation de 750W à haut rendement (89%), une carte graphique nVidia GeForce GT120 256 Mo, deux interfaces réseau Gigabit Ethernet, deux slots PCI-Express 16x (dont un limité à des cartes courtes), deux ports Firewire 800, trois ports USB 2.0 (dont un en façade) et un port série RS-232.

Côté stockage, ces nouveaux Xserve pourront accueillir jusqu'à trois disques durs SATA ou SAS de 3.5" dans des baies accessibles en façade, et enventuellement montés en RAID via une carte RAID optionnelle. Nouveauté intéressante par rapport à l'ancienne gamme, le Xserve offre désormais également une baie 2.5" destinée à accueillir un SSD. Enfin, on retrouve l'habituel Superdrive, qui permettra notamment d'utiliser le DVD d'installation du système.

Le tarif d'entrée est de 2899€ avec un processeur à 2.26 GHz, 3 Go de mémoire et un disque dur SATA 7200 RPM de 160 Go, contre 3469€ pour la même configuration mais avec un second processeur. En option, la fréquence des processeurs pourra être poussée à 2.93 GHz, la RAM à 12 Go (mono-processeur) ou 24 Go (bi-processeur), le stockage à 3 To via 3 disques SATA 7200 RPM de 1 To. Apple propose également un SSD de 128 Go, une carte RAID, différentes cartes d'extension (Gigabit, Fibre Channel...), une seconde alimentation, et même l'adjonction d'un second rach au format 3U pouvant accueillir 16 disques durs SAS supplémentaires. Le prix dépasse alors les 30 000€ (soit approximativement deux reins et demi).

Côté support, Apple voit également les choses en grand, avec une offre de support logiciel et matériel pouvant être facturée jusqu'à 60 000€ suivant le niveau de support désiré, ou encore une option bien plus raisonnable, permettant de se faire livrer le serveur avec une carte mère, une alimentation et un module de refroidissement (le Xserve en comporte deux) de rechange pour 950€.

Posté par Matt le 08/04/2009 à 10h19

Aucun commentaire

Source : Macbidouille

Lorsque l'EEE PC a été introduit sur le marché et à connu un succès impressionnant, beaucoup voyaient le netbook comme une porte ouverte vers Linux pour le grand public, avec à la clé la fin de la suprématie de Microsoft sur les systèmes d'exploitation... Hélas pour eux, les choses ont bien changé depuis...

En effet, alors que Linux était le seul OS proposé sur les premiers netbooks, Microsoft a réagit face à la menace que représentait Linux, en ressortant des cartons un bon vieux Windows XP vendu à prix cassé (30$) pour conquérir le marché des netbooks. Et ils ont réussi : Windows XP atteindrait aujourd'hui selon NPD 96% de parts de marché sur le secteur des netbooks, soit plus que sur les ordinateurs de bureau et les ordinateurs portables classiques. Pour Microsoft, cette position s'explique par le fait que les utilisateurs habitués à Windows sur leur machine principale préfèrent opter également pour Windows sur leur netbook, tandis que les constructeurs auraient une préférence pour Windows en raison du support d'une plus large gamme de matériel.

On notera tout de même que, si Windows fait effectivement mieux sur netbooks que sur les machines classiques, c'est également le cas de Linux (4% sur les netbooks contre environ 2% sur le reste des machines grand public), les deux OS étant aidés sur ce marché par l'absence d'un outsider de poids : Mac OS X, qui atteint une part mondiale supérieure à 5%, avec des pointes à plus de 20% sur certains marchés !

Posté par Matt le 07/04/2009 à 17h00

Aucun commentaire

Source : Cowcotland

Il y a quelques jours, nous vous parlions des rumeurs de rachat de Sun par IBM. Alors qu'aucune information officielle n'a encore été communiquée sur ce rachat, il semblerait qu'il y ait de l'eau dans le gaz entre IBM et Sun...

En effet, selon le Wall Street Journal, les négociations entre IBM et Sun se seraient soldées par un échec, le conseil d'administration de Sun aurait en effet rejeté l'offre d'IBM, ayant jugé que Big Blue offrait trop peu de garanties. IBM aurait en effet prévu plusieurs clauses lui permettant de se rétracter de son offre, clauses qui ne seraient pas au goût de Sun.

Il se murmure également que Sun aurait trouvé l'offre d'IBM trop faible, bien que ce dernier offrait une plus value de plus de 50% par rapport à la capitalisation boursière actuelle de Sun.

Dans l'attente d'une nouvelle proposition d'IBM, Sun aurait aussi décidé de négocier avec d'autres repreneurs potentiels.

Posté par Matt le 07/04/2009 à 10h19

Aucun commentaire

Source : ZDNet

Avec sa gamme Core 2, Intel avait fait un gros pas en avant au niveau du rapport performances/W, grâce à une architecture particulièrement optimisée. Mais le géant de Santa Clara compte bien ne pas en rester là et nous annonce de nouveaux progrès, en s'attaquant cette fois à la technologie de gravure.

Le fondeur a en effet annoncé avoir développé une nouvelle technique de gravure s'appuyant sur un autre type de semi-conducteurs et qui permettrait de graver des transistors consommant dix fois moins d'énergie pour une même fréquence ! Intel n'a pour l'instant pas indiqué de date de disponibilité pour les premières puces utilisant cette technologie, mais il ne faut probablement pas trop s'enthousiasmer : entre les laboratoires de la R&D et les chaînes de production, il n'est pas rare de voir s'écouler cinq à dix années.

En tout cas, cette technologie s'annonce très prometteuse : à l'heure où la finesse de gravure des processeurs s'approche de plus en plus des limites de la physique, cette technologie pourrait permettre de multiplier le nombre de transistors sans que la consommation n'atteigne des valeurs trop élevées.

Posté par Matt le 06/04/2009 à 22h47

Aucun commentaire

Source : PresencePC

Hier soir, le très controversé projet de loi Création et Internet (dite loi HADOPI) a été adopté par l'assemblé nationale. Il est donc temps de récapituler les grandes lignes de ce texte et leurs conséquences.

La principale raison d'être de ce texte est la mise en place de l'HADOPI (Haute Autorité pour la Diffusion des Œuvres et la Protection des Droits sur Internet), qui aura en charge la surveillance d'Internet dans le cadre de la lutte contre le piratage et la "condamnation" des pirates.

Cette condamnation se fera par le biais de la "réponse graduée" : une fois une adresse IP répérée pour piratage, le propriétaire de cette adresse au moment des faits sera identifié et recevra un premier avertissement par e-mail. En cas de récidive dans un délai de six mois, un second et dernier avertissement sera envoyé, par courrier recommandé. En cas de nouvelle récidive, l'internaute s'exposera à une coupure de sa connexion Internet, pour une durée de un mois s'il reconnait les faits et accepte la sanction sans la contester et d'au minimum deux mois dans le cas contraire. Cette mesure ne sera toutefois pas effective avant 2011, les FAI ayant réclamé un délai pour se préparer techniquement à pouvoir couper la connexion Internet sans couper le téléphone et la télévision.

Au delà du fait que le coupure de la connexion Internet peut être un frein à l'éducation et au développement des nouvelles technologies en France, cette loi soulève de sérieuses questions sur le respect de la vie privée. Tout d'abord, en cas de contestation, un internaute accusé par l'HADOPI aura la charge de démontrer sa bonne foi (exit donc la présomption d'innocence), ce qui ne sera probablement possible que si l'internaute avait accepté de doté son ordinateur d'un mouchard de l'HADOPI. Comment l'HADOPI compte-elle garantir que le mouchard en question ne sera utilisé que dans le cadre de la lutte contre le piratage, et qu'en ouvrant une porte vers Internet, il ne risque pas de rendre la machine de l'internaute plus vulnérable aux attaques de virus et de vers ? La CNIL risque en tout cas d'avoir bien du mal à s'assurer de la bonne utilisation de ce mouchard, puisque l'amendement proposant qu'un représentant de la CNIL siège de façon permanente au sein de l'HADOPI a été rejeté...

Second problème, encore plus inquiétant : tous ceux qui fournissaient une connexion Internet gratuite ou non, via des hotspots Wi-Fi (comme on en trouve dans les restaurants McDonalds, les gares, les hôtels...) seront légalement responsables des agissements des utilisateurs de ces hotspots, et pourraient donc se faire couper la connexion en cas de piratage. Pour remédier à ce problème, la loi propose de filtrer ces accès en établissant une liste blanche de sites autorisés. Cette liste serait établie par une autorité constituée entre autres de représentants de la CNIL, du CSA et de l'HADOPI. Jusqu'à présent, seule la Chine a mis en place ce genre de mesure... Un label HADOPI serait également attribué aux sites de téléchargement légaux.

Enfin, la loi HADOPI exige que les moteurs de recherche privilégient dans leur résultats les sites distribuant légalement de la musique. Une mesure contre laquelle s'est déjà insurgé Google, qui estime qu'elle est totalement incompatible avec ses principes de base de fonctionnement, tant d'un point de vue technique que d'un point de vue éthique.

On notera également que la façon dont la loi a été votée soulève des interrogations sur son caractère démocratique, tout ayant été fait pour faire passer la loi le plus vite possible, et avec un minimum de débats :

- dans un premier temps, la déclaration d'urgence, qui permet de n'effectuer qu'une seule lecture du texte devant le sénat et l'assemblée nationale,

- ensuite, le vote de l'assemblée nationale a été précipité : alors qu'il aurait dû avoir lieu la semaine prochaine, après la séance de questions au gouvernement, le vote a été avancé à hier soir, à une heure où la plupart des députés avaient déjà quitté l'hémicycle : au moment du vote, il ne restait plus que 16 des 577 députés, et il a donc suffit d'une dizaine de voix pour que le texte soit validé, l'adoption se faisant à la majorité relative et non pas à la majorité absolue... Selon certains, ce vote aurait été avancé par crainte d'un taux d'abstention trop élevé chez les députés UMP, qui aurait fait pencher la balance en faveur des opposants au projet...

Le texte voté par l'assemblé étant différent de celui voté par le sénat, il devra toutefois encore être validé par une commission paritaire de 7 députés et 7 sénateurs, puis éventuellement par le conseil constitutionnel, avant d'être promulguée par le président. En attendant, la résistance s'organise, et bon nombre de sites proposent d'ores et déjà des mesures de contournement, rendant cette loi obsolète...

Posté par Matt le 03/04/2009 à 23h22

Aucun commentaire

![]()

Au petit jeu du "kikitoutdur" qui oppose en ce moment certains constructeurs de SSD, SuperTalent vient de remporter une manche, en présentant le RAIDDrive. À l'instar du G-Monster de PhotoFast ou du Z-Drive d'OCZ, le RAIDDrive de SuperTalent est un support de stockage se présentant sous la forme d'une carte PCI-Express 8x.

Mais là où ses concurrents se sont contentés de monter au sein de la carte un RAID 0 de quatre SSD de 256 Go, SuperTalent a vu les choses en grand, en embarquant huit SSD en RAID 0, pour une capacité totale de 2 To. Mais le plus impressionnant se trouve du côté des débits : SuperTalent annonce pas moins de 1.2 Go/s en lecture et 1.3 Go/s en écriture ! C'est deux fois plus que ses concurrents.

Prochaine étape, 4 To et plus de 2 Go/s sur un port PCI-E 16x ?

Posté par Matt le 02/04/2009 à 22h51

Aucun commentaire

Source : Matbe

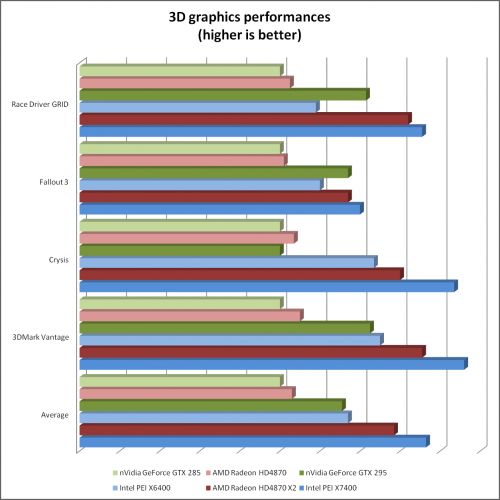

Alors que l'Intel PEI dont nous vous parlions hier est bien entendu un poisson d'avril, nVidia et ATI ont lancé cette semaine deux vraies nouveaux modèles de cartes graphiques, garanties sans arrêtes et sans odeur de poisson ! Comme à leur habitude ces derniers mois, ils ne s'agit toutefois que de produits réchauffés...

Du côté des verts, nous avons droit à la GeForce GTX 275 qui, comme son nom l'indique, se positionne entre la GTX 260 et la GTX 285. Elle embarque une puce GT200b, gravée en 55nm et embarquant 240 processeurs de flux, 80 unités de texturing, comme la GTX 285 (la GTX 260 est dotée pour sa part de 216 processeurs de flux et 72 unités de texturing), mais en se contentant de 28 ROPs et d'un bus mémoire 448 bits, comme la GTX 260, contre 32 ROPs et 512 bits sur la GTX 285. Elle est cadencée à 633 MHz pour le GPU, 1404 MHz pour les processeurs de flux et 1134 MHz pour ses 896 Mo de GDDR3, soit des fréquences légèrement inférieures à celles de la GTX 285 (648/1476/1242).

Chez les rouges, c'est une nouvelle carte haut de gamme qui s'offre à nous, avec la Radeon HD 4890. Elle embarque une version très légèrement améliorée de la puce qui équipait la 4870. Le nombre d'unités de calcul (800 processeurs de flux, 16 ROPs), la largeur du bus mémoire (256 bits en GDDR5) et la finesse de gravure (55nm) restent inchangés, mais les fréquences sont revues à la hausse (850 MHz pour le GPU et 975 MHz pour la mémoire au lieu de 750 et 900), tandis que la puce est dotée d'un nouveau mode d'économie d'énergie, qui permet d'économiser une vingtaine de watts au repos. En charge, elle consomme par contre plus que la 4870, ce qui n'est pas vraiment une surprise compte tenu des caractéristiques.

En pratique, c'est la GTX 275 qui semble la plus rapide, mais c'est aussi la plus cher des deux, puisque la 4890 devrait être disponible à partir de 220€, contre 240€ pour la GTX 275.

Posté par Matt le 02/04/2009 à 10h00

Aucun commentaire

Les plus anciens s'en souviennent peut-être : aux débuts de l'AGP, Intel s'était lancé sur le marché des cartes graphiques, avec un certain succès, les performances de son i740 de l'époque n'ayant rien à envier à ses concurrentes. Le fondeur avait ensuite délaissé ce marché au profit des puces graphiques intégrées, avant de manifester un nouvel intérêt pour les cartes graphiques lorsqu'AMD a racheté ATI...

Depuis, de nombreuses rumeurs ont évoqué le retour d'Intel sur le marché de la carte graphique, en particulier avec le projet Larrabee, un projet à relativement long terme, qui vise à mettre au point une carte graphique basée sur une multitude de coeur x86, dont Intel a déjà fait une démonstration il y a quelques temps. Mais que faire en attendant la disponibilité de Larrabee ? Rien ? Non ! Le fondeur a en effet décidé d'occuper le marché avec une puce graphique plus conventionnelle, l'Intel PEI.

Conçue dans le plus grand secret, cette puce a été présentée aujourd'hui par Intel, pour une commercialisation immédiate. Elle embarque 256 shaders processors cadencés à 2.0 GHz (contre 240 à 1.5 GHz pour la GeForce GTX 285 d'nVidia et 800 à 750 MHz sur la Radeon 4870 d'ATI), ce qui lui confère donc une puissance brute supérieur de 40% à la plus puissance des puces nVidia. Le rendu sera pour sa part confié à 48 unités de texturing et 16 ROPs à 2 GHz (80/32 à 650 MHz sur GTX 285 et 40/16 à 750 MHz sur Radeon 4870 X2), le tout assisté par 1 à 2 Go de RAM GDDR5 à 1.6 GHz sur un bus 512 bits, soit une bande passante mémoire record de 190 Go/s (environ 150 Go/s sur GTX 285 et 110 Go/s sur Radeon 4870).

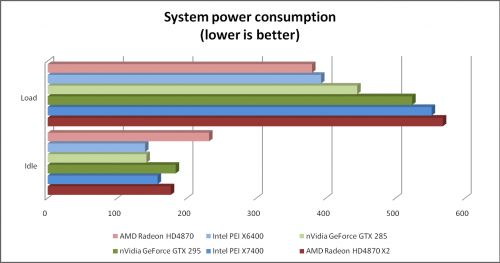

Dans un premier temps, Intel distribuera directement cette puce, intégrée à deux modèles des cartes : la PEI X6400 embarquant une puce PEI à 2 GHz et 1 Go de RAM et la PEI X7400, dotée de deux puces PEI à 2 GHz et de 2 Go de mémoire. Toutefois, contrairement aux solutions bi-GPU concurrentes, la PEI X7400 se comportera exactement comme s'il s'agissait d'une unique puce dotée de deux fois plus d'unités de calcul et d'un bus mémoire deux fois plus large. Les premiers benchmarks de ces cartes sont disponibles et montrent qu'elles se défendent très bien face aux concurrentes, qu'elles parviennent à globalement surpasser, tant en mono-GPU qu'en bi-GPU, tout en ayant une consommation relativement modérée, en particulier en idle.

Dans un second temps, Intel ouvrira la puce aux constructeurs de cartes désirant l'intégrer à leurs produits. Une version haut de gamme fonctionnant à plus haute fréquence serait également prévue, tandis que des versions dotées de moins d'unités de calcul devraient arriver sous peu pour l'entrée de gamme. Un nouveau GMA basé sur l'architecture PEI devrait également être de la partie.

MàJ le 02/04/2009 à 0:00 : comme vous l'avez probablement compris, il s'agit là d'un poisson d'avril. La photo du die est celui du GT200 d'nVidia, tandis que la carte est une Radeon HD 4850X2 de chez Sapphire retouchée.