Actualités du mois de décembre 2009

Après s'être lancé il y a un peu plus de deux ans sur le marché des systèmes d'exploitation pour téléphones portables, avec Android, Google pourrait prochainement passer à la vitesse supérieure avec le lancement d'un Google Phone, premier téléphone vendu sous la marque Google.

Depuis quelques temps, de plus en plus d'informations circulent à propos de ce téléphone, actuellement connu sous le nom de code Nexus One, et qui sera fabriqué par HTC, partenaire historique de Google sur ce marché. On en sait désormais un peu plus sur les caractéristiques techniques de l'appareil, qui fonctionnera sous Android 2.1 :

- processeur Qualcomm QSD8250 à 1 GHz,

- 512 Mo de RAM,

- 512 Mo de mémoire interne, extensible à 32 Go via un slot micro SD (une carte de 4 Go devrait être fournie),

- écran 3.7" AMOLED Wide VGA (800*480),

- appareil photo 5MP avec auto-focus et flash LED,

- connectivité sans-fil Wi-Fi 802.11n et Bluetooth 2.1 + EDR,

- réseau cellulaire 3G (HSDPA et HSUPA), EDGE et GSM,

- positionnement par A-GPS, triangulation GSM ou Wi-Fi, boussole numérique et accéléromètres,

- connectique : port dock, port micro USB, entrée/sortie jack 3.5mm pour casque/micro, slot micro SD,

- deux micros intégrés pour l'annulation de bruit de fond,

- batterie amovible haute capacité (1400 mAh).

Comme sur de nombreux appareils sous Android, le Nexus One est doté de plus de boutons que son concurrent à la pomme, avec, en plus du bouton d'allumage et du bouton de volume, quatre boutons de fonction rétro-éclairés en dessous de l'écran et une trackball, elle aussi rétro-éclairée en trois couleurs différentes. Le clavier virtuel tactile offrira également un retour haptique par vibration.

Tout celà sera "emballé" dans un boîtier aux dimensions légèrement plus réduites que celles de l'iPhone malgré la grosse batterie (119*59.8*11.5mm) et ne pèse que 130g. En plus d'être distribué par Google, il pourrait également être commercialisé directement par HTC. Selon certaines rumeurs, la distribution par Google pourrait se faire dans un premier temps avec un système d'invitations, comme Google l'a déjà fait par le passé pour certains de ses services.

Posté par Matt le 26/12/2009 à 08h52

Aucun commentaire

Source : iPhon.fr

Si vous nous suivez régulièrement NDFR, vous avez pu constater que Microsoft est très présent sur le marché des claviers et des souris. Mais il y a un autre marché où l'éditeur de Windows est en concurrence frontale avec Logitech : les webcams. Nous avons donc testé la dernière webcam de Microsoft, la LifeCam Cinema.

Posté par Matt le 23/12/2009 à 20h23

Aucun commentaire

Comme nous vous l'annoncions hier, Intel vient de présenter officiellement sa plateforme Atom Pineview, qui se caractérise par l'intégration du northbridge dans le CPU, comme Intel l'avait déjà fait sur sa gamme de processeurs hautes performances, avec les Core i7 et i5. Une disparition qui laissait en craindre une autre : celle de la plateforme ION d'nVidia.

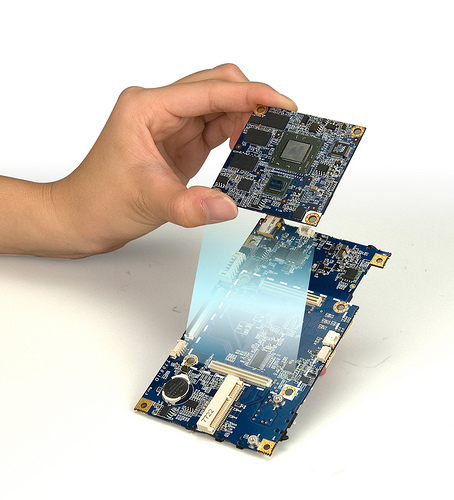

Celle-ci devrait toutefois finalement arriver dans une version 2, spécialement dédiée à ces nouveaux Atom, en se présentant sous une forme radicalement différente. Exit le chipset tout intégré, réunissant northbridge, southbridge et GPU dans une seule puce : l'ION 2 devrait en fait se présenter sous la forme d'une carte mini PCI-Express (Mini Card).

Avec une telle interface, ne débitant que 250 Mo/s sur la plateforme Pineview (l'équivalent d'un bon vieil AGP 1x d'il y a douze ans), il ne faudra toutefois pas s'attendre à des miracles. Ainsi, les rumeurs font état d'une puce qui ne servirait qu'à compléter le GMA 3150 pour la décompression de la vidéo HD, tandis que la puce Intel garderait la main sur l'affichage et la 3D... Un ION 2 qui ne serait donc que l'ombre de son illustre prédécesseur :-(

Posté par Matt le 22/12/2009 à 11h00

Aucun commentaire

Source : Tom's Hardware

Intel a présenté aujourd'hui sa nouvelle gamme de processeur Atom, jusqu'ici connue sous le nom de code Pineview. Les accros à la puissance seront déçus d'apprendre que les gains dans ce domaine sont minimalistes, le fondeur s'étant concentré quasi exclusivement sur la réduction du coût et de la consommation.

En effet, la série N (N450 simple cœur pour netbooks) voit sa taille diminuer de 60% et sa consommation de 20%, tandis que la série D (D510 double cœur et D410 simple cœur pour nettops) bénéficie d'une réduction de taille de 70% et d'une baisse de consommation de 50%.

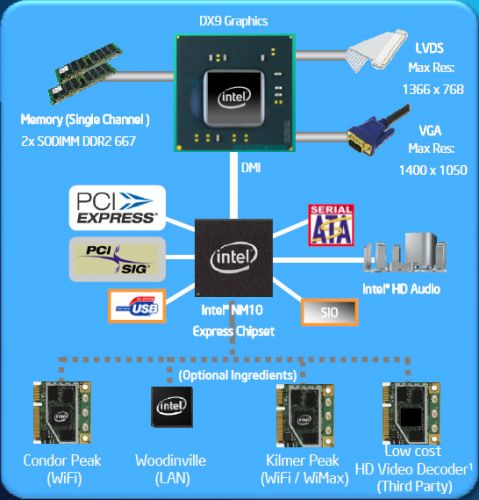

Pour parvenir à ce résultat, le fondeur a travaillé sur une intégration plus poussée : on retrouve désormais au sein d'une seule puce le ou les coeurs Atom, 512 à 1024 Ko de cache, mais aussi, et c'est là la nouveauté, une solution graphique DirectX 9.0 GMA 3150 et un contrôleur mémoire DDR2-667 (série N) ou DDR2-800 (série D). Il devient ainsi possible de se passer du northbridge, et donc d'économiser une puce sur la machine, la southbridge étant connecté directement au processeur via un lien DMI. Niveau consommation, les N450, D510 et D410 sont respectivement annoncés avec des TDP de 5.5, 13 et 10W, pour une fréquence de 1.66 GHz dans les trois cas.

Ces nouveaux Atom seront vendus avec le southbridge NM10, qui gère deux ports SATA, 8 ports USB 2.0, un port réseau 10/100 Mbits/s et l'audio via un codec Intel HD Audio. Quatre lignes PCI-Express seront également de la partie pour gérer différents composants optionnels : la puce Wi-Fi Condor Peak, la puce réseau Gigabit Woodinville, la puce combinée Wi-Fi / Wi-Max Kilmer Peak, ou n'importe quelle puce tierce s'interfaçant sur PCI-Express.

Malheureusement, cette nouvelle version de l'Atom ne s'accompagne pas que de bonnes nouvelles. Tout d'abord, elle risque de marquer l'arrêt de mort de la très appréciée plateforme nVidia ION, qui faisait office de northbridge et de southbridge en une seule puce sur les Atom actuels. Ensuite, Intel s'est assuré que l'Atom ne viendrait plus canibaliser les ventes de sa plateforme Core 2 Duo CULV, grâce à différents bridages. Tout d'abord, la partie graphique ne sera pas capable de gérer les grands écrans. Bien que dérivée du GMA 3100, tout a fait capable de gérer les hautes résolution, le GMA 3150 est limité à 1400x1050 via sa sortie VGA et 1366x768 via sa sortie numérique. Ensuite, au niveau de la mémoire, la série N est limitée à 2 Go, tandis que la série D est limitée à 4 Go.

Le gain d'autonomie devrait toutefois vite faire oublier ces limitations auprès des utilisateurs de netbooks. En effet, il semblerait que les Atom Pineview tiennent bien leurs promesses sur ce plan. Notre confrère TechReport a ainsi mesuré près de 9h30 de surf sur le web et plus de 8h de lecture vidéo sur un Asus EEE PC 1005PE doté d'une batterie 6 cellules et de la nouvelle plateforme Atom, contre moitié moins pour un EEE PC 1000H embarquant l'ancienne plateforme. Ce premier test confirme également les gains très limités en termes de performances. On attend avec impatience les résultats qu'atteindra MSI sur ses Wind à très longue autonomie !

Posté par Matt le 21/12/2009 à 18h19

2 commentaires

Sources : PCWorld et Gizmodo via Ptit_boeuf

![]()

C'était l'un des dossiers chauds de l'année 2009 : l'attribution par l'ARCEP d'une quatrième licence 3G sur le territoire français, permettant l'arrivée d'un quatrième opérateur mobile. Seul opérateur ayant déposé un dossier, après les désistements des autres candidats, Free Mobile a sans surprise obtenu l'aval de l'ARCEP.

Comme son nom l'indique, ce nouvel opérateur est une filiale d'Iliad, la maison mère de l'opérateur Internet Free. L'opérateur désire réaliser sur le marché de la téléphonie mobile ce qu'il a fait sur le marché de l'ADSL il y a quelques années : débarquer et faire exploser le marché avec des offres très compétitives. Dans son dossier de candidature, Free Mobile s'est en effet engagé à proposer un forfait 3h pour moins de 20€, soit le prix actuel d'un forfait 1h chez les trois opérateurs en place. L'opérateur précise également que toutes ses offres donneront accès à la data, y compris les cartes pré-payées, mais bien entendu pas forcément de façon illimitée et que la voix sur IP ne sera pas interdite sur son réseau, ce qui devrait ravir les abonnés Free ADSL. Des forfaits purement data seront également proposés, pour les modems 3G.

Autre changement important par rapport aux opérateurs en place, Free Mobile ne subventionnera pas l'achat de terminaux. À la place, l'opérateur proposera l'étalement du prix d'achat sur les factures du forfait. Par exemple, l'acheteur d'un terminal à 240€ avec un forfait à 20€ pourra choisir d'étaler les 240€ sur 24 mois, en payant 30€ par mois, puis 20€ au delà. Ce système a été particulièrement apprécié par l'ARCEP pour sa simplicité et sa transparence, comparé aux offres existantes, où le tarif ne bouge pas d'un iota une fois la subvention du téléphone amortie...

Côté technique, Free Mobile déploiera directement un réseau 3G doté des toutes dernières évolutions technologiques, permettant un débit maximal de 28.8 Mbits/s, contre 3.6 à 7.2 Mbits/s sur les réseaux 3G actuellement en place (sans compter les éventuels bridages, comme c'est le cas notamment chez Orange...). L'opérateur s'est engagé à couvrir 25% de la population d'ici à deux ans et 90% d'ici à huit ans. Le réseau Wi-Fi Freephonie servira à étendre un peu cette couverture, tandis que la couverture 2G se fera via l'un des opérateur existant grâce à un contrat MVNO.

L'offre commerciale devrait être lancée fin 2011 ou début 2012, accompagnée de l'ouverture d'un réseau de boutiques Free Mobile. Le dossier de candidature n'évoque par contre aucune offre "quadruple play" ADSL + mobile, ni le partage de ces boutiques avec Free ADSL, mais il serait surprenant que l'opérateur ne profite pas de l'occasion pour promouvoir un peu ses offres ADSL.

Posté par Matt le 20/12/2009 à 23h43

Aucun commentaire

Source : Macbidouille

Il y a environ deux mois, Apple lançait sa nouvelle gamme d'iMac, dont le modèle haut de gamme embarquait une toute nouvelle dalle LCD 16/9ème à la résolution inédite : le 2560x1440. Elle devrait bientôt être également proposé par Dell.

La bonne nouvelle, c'est que le constructeur texan intégrera cette dalle d'origine LG dans un simple moniteur, ce qui permettra donc d'en disposer avec la machine de son choix. Pour rappel, la dalle LG LM270WQ1 est une dalle de type IPS, offrant donc d'excellents angles de visions, et dotée d'un rétro-éclairage par LED, permettant de réduire la consommation, qui était le point faible des dalles IPS.

L'écran Dell portera la référence UltraSharp U2711. Il devrait être doté d'un pied pivotant et réglable en hauteur, et la dalle pourra être alimentée en images via DVI dual-link, HDMI, DisplayPort et VGA (cette dernière connectique risque toutefois d'être à la peine avec une telle résolution...).

Dell n'a pour l'instant communiqué ni sur la date de disponibilité, ni sur le prix. Sur ce dernier point, vu les tarifs habituels du constructeur, on peut s'attendre à un positionnement proche des 1000€, mais avec régulièrement de fortes réductions promotionnelles.

Posté par Matt le 17/12/2009 à 11h00

2 commentaires

Source : Tom's Hardware

![]()

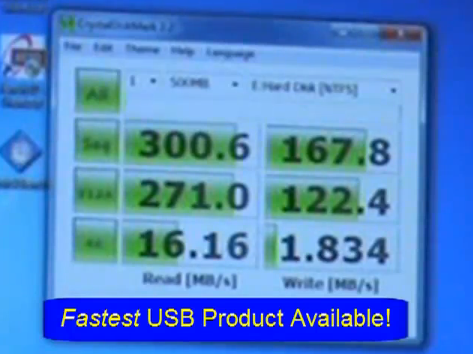

Spécialiste des solutions de stockage à base de mémoire flash, Super Talent vient de lancer la clé USB la plus rapide du marché, et de loin, puisqu'en termes de débit, même les meilleurs SSD SATA sont dépassés !

Utilisant une liaison USB 3.0, la clé RAIDDrive peut en effet atteindre un débit record de 320 Mo/s grâce à deux contrôleurs montés en RAID0. Pour arriver à ce résultat, il faudra toutefois un port USB 3.0 et un driver spécifique supportant l'UAS (USB Attached SCSI), non fourni par SuperTalent. Sans ce driver, il faudra se contenter de 200 Mo/s en USB 3.0, contre à peine 35 Mo/s en USB 2.0.

Cette clé sera disponible à partir de la semaine prochaine, en version 64 Go, pour environ 400$. Un modèle 32 Go à 300$ et un modèle 128 Go à 650$ seront lancés par la suite.

Mise à jour le 16/12/2009 à 23h40 : Les premiers tests de cette clés sont apparus sur Internet. Le moins que l'on puisse dire est qu'elle tient ses promesses, avec un peu plus de 300 Mo/s en lecture séquentielle et près de 170 Mo/s en écriture séquentielle, ce qui la place au dessus des meilleurs SSD disponibles actuellement. En aléatoire, elle est moins à la fête, mais assure tout de même 16 Mo/s en lecture est près de 2 Mo/s en écriture, ce qui la place au niveau des SSD d'entrée de gamme, et largement au dessus des disques durs.

Actu originale : 08/02/2009 à 21h10

Posté par Matt le 16/12/2009 à 23h40

Aucun commentaire

Sources : DailyTech via Ptit_boeuf et PCWorld

![]()

Comme nous l'évoquions il y a quelques mois, l'Union Européenne s'inquiétait pour l'avenir de MySQL dans le cadre du rachat de Sun par Oracle. Après les propos rassurants du PDG d'Oracle durant l'Oracle Open World, l'éditeur vient de passer à la vitesse supérieur pour convaincre l'Union Européenne de ses bonnes intentions, en prenant différents engagements sur l'avenir de MySQL.

Ils sont pour l'instant au nombre de dix :

- maintient et amélioration de l'API permettant d'ajouter des moteurs de stockage à MySQL,

- Oracle n'exigera pas la publication sous licence GPL des moteurs de stockage développés pour MySQL et n'exigera pas l'acquisition d'une licence commerciale pour les développeurs de ces moteurs,

- prolongation des accords OEM jusqu'à décembre 2014,

- Oracle travaillera sur l'amélioration de MySQL et publiera ces améliorations sous licence GPL,

- Oracle n'obligera pas les acquéreurs d'une licence commerciale à souscrire également un contrat de support,

- pendant les trois prochaines années, le budget R&D alloué annuellement à MySQL sera supérieur à celui alloué par Sun pendant la dernière année fiscale précédant le rachat (24 millions de $),

- moins de six mois après la conclusion du rachat, Oracle mettra en place une commission composée d'utilisateurs de MySQL, qui fournira des retours d'expérience et guidera les développements à venir,

- de même, une commission des éditeurs de moteurs de stockage sera mise en place,

- le manuel de référence de MySQL sera maintenu et restera distribué gratuitement,

- les contrats de support pourront toujours être renouvelé sur une base annuelle ou pluri-annuelle, au choix de l'utilisateur.

Ces engagements seront valables dans le monde entier et seront effectifs pour une durée minimale d'un an à compter de la finalisation du rachat de Sun.

Voilà donc qui devrait plaider en faveur d'Oracle auprès de la Commission Européenne, tout en rassurant les utilisateurs de MySQL.

Posté par Matt le 15/12/2009 à 22h40

Aucun commentaire

Source : PCWorld

Notre guide d'achat vient d'être mis à jour.

Les configuration ont relativement peu changé, la baisse de prix des composants suffisant tout juste à compenser la hausse de prix de la RAM.

Posté par Matt le 14/12/2009 à 10h45

1 commentaire

Lancée en 2004, l'initiative 80 Plus visait à pousser les fabricants d'alimentations à faire des efforts sur le rendement de leurs produits, grâce à un label attribué aux alimentations dépassant les 80% de rendement pour une charge allant de 20% à 100% de leur puissance nominale. Un nouveau label vient de voir le jour, le 80 Plus Platinum, qui vise désormais plus de 90% de rendement.

En effet, même s'il s'appelle toujours 80 Plus, probablement en raison de la popularité de ce label, la nouvelle certification requiert un rendement de 90% à 20% de charge, 94% à 50% de charge et 91% à 100% de charge. Les alimentations obtenant ce label seront donc plus de deux fois moins gourmandes que les alimentations respectant le 80 Plus de base au plus juste.

Pour rappel, le label 80 Plus fait partie de la norme Energy Star 4.0 et avait déjà été complété par trois labels plus stricts : - 80 Plus Bronze qui exigeait 82% de rendement à 20% et 100% de charge et 85% à 50%, - 80 Plus Silver qui exigeait 85% de rendement à 20% et 100% de charge et 88% à 50%, - 80 Plus Gold qui exigeait 87% de rendement à 20% et 100% de charge et 90% à 50%.

Le nouveau label Platinum ne concerne toutefois pour l'instant que les alimentations redondantes pour serveur, pour lesquelles l'initiative 80 Plus est plus exigeante (le label de base n'existe pas, le Bronze est à 81/85/81, le Silver à 85/89/85 et le Gold à 88/92/88). Si ce label était aussi décliné pour les alimentations classiques, on peut donc s'attendre à un niveau d'exigence légèrement inférieur.

Posté par Matt le 14/12/2009 à 08h51

Aucun commentaire

Source : Tom's Hardware

Il y a quelques jours, lorsque Google a lancé son service Google DNS, de nombreuses voix se sont élevées sur Internet pour pointer du doigt cette nouvelle possibilité d'intrusion dans notre vie privée que s'offre Google. Dans une récente interview sur CNBC, Eric Schmidt, PDG de Google, a répondu à ces critiques, mais pas forcément de la meilleure façon qui soit...

À ceux qui s'inquiètent des informations personnelles que pourrait collecter Google, Eric Schmidt n'a en effet pas trouvé mieux à répondre que : "if you have something that you don't want anyone to know, maybe you shouldn't be doing it in the first place". Ce qui se traduirait en français par : "si vous faites des choses dont vous ne voulez que personne soit au courant, vous devriez plutôt ne pas les faire". Pas bien rassurant donc...

Ainsi, au lieu de faire taire les critiques, Eric Schmidt a plutôt permis à la vague anti-Google de rallier de nouveaux membre. Et pas des moindres, puisque Asa Dotzler, le responsable de la communauté qui développe Firefox, s'est exprimé sur le sujet. Un billet bref et incisif, où Asa Dotzler recommande purement et simplement de passer par Bing pour les recherches !

Quand on sait que près de 90% des revenus de la fondation Mozilla proviennent de Google, on peut s'imaginer qu'il faut que l'inquiétude soit vraiment grande pour qu'un responsable de la fondation prenne une telle position.

Espérons que Google finira par tenir compte de toutes ces craintes et prenne un jour position de façon plus franche en faveur du respect de la vie privée.

Posté par Matt le 13/12/2009 à 20h07

2 commentaires

Source : NDFR.net

C'est un sujet qui fait souvent débat sur les forums Internet : la consommation des box des différents opérateurs... Pour en avoir le cœur net, notre confrère Les Numériques a sorti le wattmètre. Et les résultats confirment qu'à l'heure du sommet de Copenhague, nos opérateurs Internet sont responsable de la consommation inutile d'un bon paquet de kWh...

En effet, si les box des trois opérateurs testés (Free, Neuf/SFR et Numéricable) ont toutes les trois une consommation relativement raisonnable (de 6W pour Numéricable à 11W pour Free, mais avec une liaison CPL pour ce dernier, qui gonfle un peu le résultat), on ne peut pas en dire autant des boîtiers TV associés aux box, dont la consommation en veille est anormalement élevée. Le plus mauvais élève est ici Numéricable, dont le boîtier TV consomme près de 20W en veille, contre un peu moins de 15W pour le boîtier Free et 8W pour celui de Neuf/SFR, le bon élève sur ce point.

À l'heure où la plupart des appareils électroniques descendent à moins de 1W en veille, de tels niveau de consommation ne devraient plus exister ! Notre confrère a bien entendu aussi mesuré la consommation de ces boîtiers lorsqu'ils sont utilisés, et elle n'est alors supérieure que de 4 à 5W par rapport au mode veille. Cette faible différence prouve bien que le mode veille des boîtiers TV "oublie" d'éteindre le gros des composants.

Voilà donc un domaine dans lequel nos opérateurs Internet ont encore énormément de progrès à faire... En attendant, nous ne pouvons que vous recommander de débrancher votre boîtier TV lorsque vous ne l'utilisez pas. En plus de faire un petit geste pour la planète, vous économiserez ainsi une dizaine d'euros par an sur votre facture d'éléctricité.

Posté par Matt le 10/12/2009 à 22h40

4 commentaires

Source : Les Numériques

![]()

Deux logiciels majeurs sont passé cette semaine en version 3.0 : VMWare Player et Thunderbird. Le premier est une solution de virtualisation gratuite, le second est un client mail développé par la fondation Mozilla, également à l'origine du navigateur web Firefox.

Du côté de VMWare Player, les principales nouveautés concernent Windows 7, avec la prise en charge de ce système dans les machines virtuelles, aussi bien en 32 qu'en 64 bits, le support complet de l'interface graphique Aero dans les machines virtuelles, ou encore la possibilité d'utiliser avec VMWare Player l'image système du mode XP proposé dans les versions haut de gamme de Windows 7. Les linuxiens ne sont pas oubliés non plus, avec une carte son virtuel désormais dotée d'un driver ALSA. Si VMWare Player reste tout de même un cran en dessous de Virtual Box du point de vue des fonctionnalités, cette nouvelle version se rapproche grandement de VMWare Workstation, et pourrait donc reprendre l'avantage sur Virtual Box, grâce à une interface plus adaptée au grand public et à des performances supérieures.

Thunderbird 3 était pour sa part une évolution attendue depuis longtemps par les utilisateurs de la solution de messagerie de Mozilla. Celle-ci accuse en effet beaucoup de retard, après que la fondation Mozilla ait concentré ses efforts sur Firefox 3.0 et Firefox 3.5. Au programme des nouveautés, une interface graphique redessinée, adoptant désormais un système d'onglets, un moteur d'indexation et de recherche puissant, un meilleur support des comptes IMAP et des comptes Gmail, un nouvel assistant de configuration, un nouveau gestionnaire d'extensions, de nouveaux champs dans le gestionnaire de contacts (avec notamment enfin un champ date de naissance...), une interface plus personnalisable... Bref, à télécharger absolument si vous êtes déjà un utilisateur de Thunderbird 2 ou si vous envisagez d'abandonner votre solution de messagerie actuelle !

Posté par Matt le 09/12/2009 à 22h58

3 commentaires

Sources : PCInpact et 1for-matik

Annoncée il y a quelques temps, la puce graphique Intel Larrabee était initialement censée être commercialisée en cette fin d'année. Déjà reportée une première fois, la version 1 de cette puce a finalement été annulée par Intel, ce qui retardera donc encore un peu l'arrivée des solutions graphiques de Santa Clara...

Pour rappel, la puce Larrabee est une nouvelle puce graphique innovante, basée sur une multitude de cœurs x86 basiques, et sur laquelle les primitives graphiques s'exécutent de façon entièrement logicielle, grâce à un programme fourni par le driver, au lieu d'être câblées dans le silicium comme sur des puces graphiques spécialisées. L'intérêt d'un tel système étant d'obtenir une puce graphique plus évolutive (possibilité par exemple de prendre en charge de nouvelles instructions DirectX via une simple mise à jour du driver), mais aussi plus facile à programmer en particulier pour le GPGPU, car directement utilisable avec du code x86, bien maitrisé par les développeurs.

Cet abandon ne marque toutefois pas la fin définitive de Larrabee. La puce actuelle, si elle ne sera pas commercialisée sous forme de carte graphique, servira en effet de base à une plateforme de développement qu'Intel pourrait commercialiser l'année prochaine. Reste à voir si cette puce pourra ensuite évoluer vers un produit graphique commercialisable, ou si Intel décidera de la réserver définitivement au marché du calcul scientifique.

Posté par Matt le 07/12/2009 à 22h14

Aucun commentaire

Source : Hardware.fr

Et hop, encore un nouveau produit Google ! Après les mails, les agendas ou encore les systèmes d'exploitation Android et Chrome OS, le géant de la recherche revient vers son cœur de métier : faciliter la vie des surfers. Et pour se faire, Google s'attaque au cœur même du réseau Internet : le service DNS.

Vous ne vous en rendez peut-être même pas compte, mais vous utilisez le service DNS tous les jours. En effet, quasiment à chaque fois que vous tapez une adresse ou cliquez sur un lien dans votre navigateur, une requête est effectuée vers un serveur DNS pour retrouver l'adresse IP correspondant au nom de domaine de l'adresse que vous demandez. Les DNS sont donc en fait les annuaires d'Internet, faisant la correspondance entre les noms compréhensibles par les humains et les adresses IP compréhensibles par les protocoles de routage réseau.

Avec son service Public DNS, Google a pour objectif de fournir à tous un service DNS plus performant et plus sécurisé, pour rendre le surf plus rapide tout en réduisant les risques d'attaques de pirates. Les DNS peuvent en effet être un gros talon d'Achile pour la sécurité : si un serveur DNS est piraté pour renvoyer vers des IP de serveurs pirates au lieu de celles des serveurs légitimes, le visiteur d'un site peut être redirigé vers un site pirate sans qu'il ne s'en rende compte, même s'il est équipé de systèmes de protection contre le phising.

Pour arriver à ce résultat, Google a développé de nouveaux algorithmes de gestion du cache DNS, mais aussi des algorithmes d'anticipation des requêtes, permettant de réduire fortement le taux de défauts de cache, tandis que la casse des requêtes est modifiée aléatoirement pour limiter les risques de piratages. Google promet également de ne pas jouer au petit jeu des DNS menteurs, une pratique de plus en plus courante chez les prestataires DNS, qui permet de monétiser les erreurs de saisie des utilisateurs en les renvoyant vers une page spécifique contenant de la publicité.

Toutefois, après quelques essais, je vous recommanderais de rester sur les DNS de votre FAI, surtout en dehors des États-Unis. En effet, ces DNS répondent généralement bien plus vite grâce à leur proximité géographique (avec les DNS de Free, j'obtiens 14ms, contre 23 pour ceux de Google) et sont normalement eux aussi dotés de procédures de sécurité pour réduire les risques de fishing. Les DNS Google pourront par contre servir en dépannage si les DNS de votre FAI sont indisponibles.

Posté par Matt le 04/12/2009 à 22h29

1 commentaire

Source : Google Code Blog via Ptit_boeuf

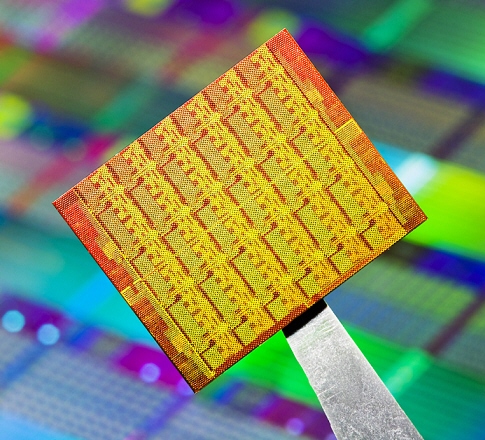

Il y a quelques temps, Intel avait présenté un prototype de puce dotée de 80 cœurs x86 et développant une puissance de calcul de l'ordre du Teraflop. Aujourd'hui, le fondeur a fait la présentation d'une nouvelle version de cette puce, baptisée SCCC (Single-Chip Cloud Computer), plus modeste et plus aboutie.

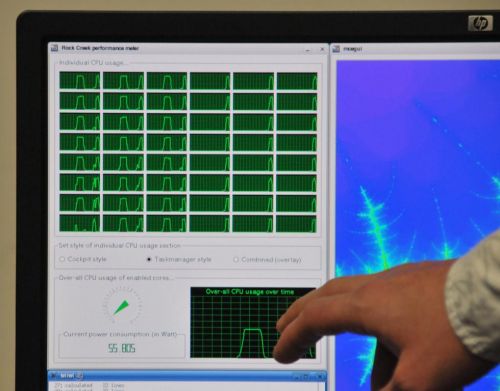

Plus modeste, car elle se contente de "seulement" 48 cœurs, similaire à un cœur Atom. Répartis en 24 paires dotées chacune d'un cache L2 partagé, ces 48 cœurs représentent un total de 1.3 milliards de transistors et occupent 576mm² sur un die gravé en 45nm. La puce embarque également quatre contrôleurs mémoire DDR3 et consomme 25W au repos et 125W en activité.

Plus aboutie, car contrairement à la puce 80 cœurs présentée précédemment, cette nouvelle puce est 100% fonctionnelle et peut assurer le fonctionnement d'un système d'exploitation Windows ou Linux.

Si Intel n'avance bien entendu pour l'instant aucune date de commercialisation pour des produits dérivés de ce prototype, le fondeur va par contre d'ores et déjà lancer la production d'une centaine d'exemplaire du SCCC qui seront fournis à des laboratoires partenaires, afin de permettre aux chercheurs de commencer à travailler sur les logiciels de demain, qui devront prendre en compte la problématique liée à l'arrivée dans l'ère de l'informatique massivement parallèle.

Posté par Matt le 03/12/2009 à 23h10

Aucun commentaire

Source : PCWorld

![]()

Si VIA a toujours du mal à aligner des produits compétitifs sur le marché du processeur, le moins que l'on puisse dire est que le constructeur taïwanais ne manque pas d'imagination quand il s'agit de pondre des formats de cartes mères mettant en valeur la faible consommation des puces VIA...

C'est ainsi que VIA vient de présenter le Mobile-ITX, basé sur une carte carrée de seulement 6cm de côté. C'est moitié moins que le Pico-ITX, qui était lui même plus petit que le Nano-ITX, qui était une version réduite du Mini-ITX, qui était lui même un petit ITX. La liste commence à être longue ! Le Mobile-ITX pourrait toutefois être la dernière itération, le constructeur ayant visiblement du mal à réduire les dimensions (et c'est compréhensible), puisqu'il a déjà dû tricher un peu avec le Mobile-ITX...

En effet, la carte de 6cm n'embarque que le processeur, le chipset et la RAM, et cette carte vient se fixer sur une carte deux fois plus grande et offrant toutes les entrées/sorties nécessaires : audio, IDE, USB, PCI-Express, SDIO, GPIO... Le tout ne consommerait que 5W et devrait être commercialisé début 2010.