Actualités du mois d'octobre 2010

À peine plus d'un an après la sortie de Windows 7, le 22 octobre 2009, Microsoft a mis en ligne une Release Candidate du Service Pack 1, la première mise à jour cumulative de Windows 7.

Cette mise à jour pèse environ 515 Mo en version 32 bits et 865 Mo en version 64 bits. Elle regroupe toutes les mises à jour publiées sur Windows Update depuis la sortie de l'OS. Elle apporte aussi quelques nouveautés mineures, comme le support natif de l'USB 3.0 et la technologie RemoteFX qui permet d'améliorer la prise en charge des fonctionnalités multimédia lors d'une connexion bureau à distance.

Vous pouvez télécharger la Release Candidate du Service Pack 1 de Windows 7 sur le site de Microsoft. Attention toutefois, il ne s'agit pas d'une version totalement finalisée, et elle peut donc encore comporter quelques bugs. La version finale devrait arriver dans quelques mois.

Notons également au passage que la version 64 bits de ce Service Pack 1 s'applique également à Windows Server 2008 R2, ce qui est à ma connaissance une grande première, et montre bien à quel point Microsoft a désormais poussé l'unification entre les branches client et serveur de Windows.

Posté par Matt le 28/10/2010 à 14h06

Aucun commentaire

Dans le cadre de son plan de relance suite à la récente crise économique, l'État a effectué un grand emprunt, dont une partie (2 milliards d'euros) a permis d'alimenter le Fond d'Aménagement Numérique du Territoire, qui œuvre a favoriser le déploiement du très haut débit dans les zones de faible densité, qui ne sont pas assez rentables pour que les opérateurs y aillent de leur propre initiative. Une nouvelle taxe pourrait s'ajouter au financement de ce fond...

En effet, maintenant qu'il est en place, le FANT nécessite un budget de 660 millions d'euros par an pour mener à bien sa mission. Les finances de l'État étant ce qu'elles sont, il faut bien aller chercher cet argent quelque part. Et pour le sénateur Hervé Maurey, "quelque part", signifie en instaurant une nouvelle taxe sur les abonnements Internet et téléphone mobile. Voir les téléviseurs et les consoles de jeu. C'est en tout cas les propositions qu'il a faites au premier ministre.

Si l'idée de taxer les abonnements Internet pour financer le déploiement d'un réseau plus moderne reste relativement acceptable, on se demande par contre ce que les téléviseurs et les consoles de jeu viennent faire là dedans... Par ailleurs, même si l'Internet français est encore parmi les moins chers du monde, on peut tout de même s'inquiéter de cette multiplication des taxes dans le secteur des télécoms, qui semble être devenu la nouvelle vache à lait que l'État va traire à chaque fois qu'il a besoin d'argent. La liste des taxes s'appliquant dans ce secteur est en effet de plus en plus longue :

- redevance copie privée sur les disques durs des box Internet,

- COSIP : 5.5% de la part du chiffre d'affaire soumise à une TVA de 5.5%,

- SACEM, SACD, SCAM, ADAGP : 3.75% de la part à 5.5%,

- ANGOA et AGICOA : 0.7% de la part à 5.5%,

- taxe Copé (compensation de la suppression de la pub sur France Télévision) : 0.9% de la part à 19.6%,

- VOD grand public : 2% du chiffre d'affaire de la VOD,

- VOD pornographique : 10% du chiffre d'affaire de la VOD X,

- "taxe Baroin-Sarkozy" : passage de la TVA à 19.6% sur tout l'abonnement (sans remise en cause des taxes s'appliquant normalement uniquement à la part à 5.5%),

- redevance UMTS : 1% du chiffre d'affaire des services sur réseau cellulaire,

- imposition forfaitaire sur les entreprises de réseau (IFER) : 1530€ par antenne-relais et par an, pour compenser la suppression de la taxe professionnelles.

Liste à laquelle s'ajoutent les différentes taxes en projet : financement du FANT, taxe Jouanno sur les antennes-relais (10% de l'IFER pour financer la recherche sur les ondes et leurs effets sur la santé), taxe pour soutenir la presse, etc...

Posté par Matt le 28/10/2010 à 10h20

1 commentaire

Source : PCWorld

Depuis son lancement, il y a déjà six ans, Ubuntu a toujours utilisé l'interface graphique de l'environnement GNOME, et a grandement contribué à la popularisation de celui-ci. Après avoir été rapidement déclinée en version KDE (Kubuntu, depuis avril 2005) et Xfce (Xubuntu, depuis octobre 2005), la distribution de Canonical se prépare à une petite révolution, avec l'abandon de l'interface GNOME !

Vous aviez l'habitude de ça ?...

En effet Mark Shuttlework, fondateur du projet, a annoncé que la prochaine version d'Ubuntu (11.04, nom de code Natty Narwhal) allait abandonner l'interface graphique de GNOME au profit de la nouvelle interface Unity Desktop, qui avait été introduite dans la version netbook d'Ubuntu 10.10.

... Il faudra vous habituer à ça.

La raison de ce choix serait les divergences entre l'orientation prise par le projet GNOME et l'orientation voulue par Ubuntu. Canonical désirerait notamment mettre en place un système de menus globaux, similaire à ce qui est fait sous Mac OS X (une seule barre de menu, au lieu d'une par fenêtre), mais aussi disposer d'une interface tirant pleinement parti du multitouch.

Reste à voir si Canonical lancera par la même occasion une "Gubuntu" qui garderait l'interface graphique GNOME. Si ce n'est pas le cas, il faudra s'habituer au changement ou installer GNOME manuellement.

Posté par Matt le 27/10/2010 à 23h38

5 commentaires

Source : PCInpact

Verbatim a présenté hier une nouvelle gamme de clés USB ciblant principalement les utilisateurs nomades : les Store'n'go Netbook USB,

Si elles ne brillent pas par leur performances (11 Mo/s en lecture, 3 Mo/s en écriture), ces clés USB se distinguent par leurs dimensions réduites : 17x15x7.7mm pour à peine 2g. Des dimensions similaires à celles des micro-récepteurs USB Bluetooth.

Malgré cette taille de guêpe, Verbatim est parvenu à assurer côté capacité, puisque les trois modèles de la gamme offriront des capacités de 8, 16 et 32 Go, pour des tarifs débutant aux environs de 15€.

Posté par Matt le 27/10/2010 à 11h30

Aucun commentaire

Source : Tom's Hardware

![]()

Après avoir présenté sa première TV OLED il y a quelques semaines , LG Display a profité de l'annonce de ses résultats financiers trimestriels pour évoquer l'avenir de cette technologie, toujours très attendue dans les salons.

Malheureusement pour les impatients, il faudra encore attendre quelques temps. En effet, selon le président de LG Display, Young Soo Kwon, la production de masse ne débutera qu'en 2013, et les tarifs ne commenceront à devenir acceptables pour le grand public qu'au mieux dans trois ans.

La technologie OLED devrait par ailleurs évoluer pas mal d'ici là, puisque les lignes de production du coréen en seront alors à leur 8ème génération, alors que le constructeur fait actuellement tourner des chaînes de production de 4ème et 5ème génération, quasiment exclusivement dédiée aux écrans des petites taille pour appareils mobiles.

Posté par Matt le 27/10/2010 à 10h10

Aucun commentaire

Source : PCWorld

Au fil de l'évolution technologique, la redevance copie privée (qui vise normalement à indémniser les ayants droits de l'audiovisuelle pour le manque à gagner induit par le droit à la copie privée) ne cesse de s'étendre à de nouveaux supports...

Ciblant à l'origine uniquement les cassettes audio, elle s'est ensuite appliquées au cassettes vidéo, puis aux CD vierges lorsque leur usage s'est popularisé, puis les disquettes, les DVD, les clés USB, les cartes mémoires, les disques durs d'appareils multimédia, les disques durs externes... Il ne restait plus beaucoup de catégories de support de stockage exemptées de cette redevance, payée même lorsque le support n'est pas utilisé pour stocker des œuvres dans le cadre de la copie privée.

À cette longue liste, il faudra ajouter les NAS pour particuliers et les SSD externes, qui devront supporter la même taxe que les disques durs externes, c'est-à-dire une taxe pouvant aller de quelques euros à 50€, en fonction de la capacité de stockage et de la connectique proposée.

On notera que pour les NAS, les modèles professionnels seront exemptés, mais avec une définition très particulière, puisque ce n'est pas l'usage qui définira un NAS professionnel, mais bien ses caractéristiques. Et plus précisément... sa présentation physique ! En clair, un joli petit NAS prévu pour bien s'intégrer dans un salon sera taxé, même s'il est utilisé en entreprise. Alors qu'un particulier se procurant un bon gros NAS d'entreprise ne devra pas un centime de taxe...

Posté par Matt le 26/10/2010 à 23h12

2 commentaires

Source : PCInpact

Parmi les technologies de communication sans-fil, deux sont aujourd'hui très répandues chez le grand public : le Bluetooth et le Wi-Fi. Avec la nouvelle norme Wi-Fi Direct, venant en complément des normes Wi-Fi actuelles, le premier pourrait bien être amené à disparaitre.

En effet, si le Wi-Fi était jusqu'à présent privilégié uniquement pour les réseaux, où son débit élevé (jusqu'à 300 Mbits/s théoriques) fait la différence par rapport au Bluetooth (10 Mbits/s), la dent bleue avait la côte pour la connexion de périphériques ou la communication directe entre deux appareils, en raison de sa configuration très simplifiée, là où le Wi-Fi nécessite la création d'un réseau, l'attribution d'adresses IP, etc...

C'est à ce niveau qu'intervient la nouvelle norme Wi-Fi Direct : elle vise à permettre la communication directe entre deux appareils Wi-Fi, avec une configuration simplifiée, et sans passage par un réseau IP. Il pourrait donc arriver en concurrence frontale avec le Bluetooth, en proposant la même simplicité d'utilisation, mais avec des débits très supérieurs.

Reste à voir si cette norme intégrera également un système de profils de périphériques, comme le fait le Bluetooth, ce qui contribue grandement à sa simplicité.

Posté par Matt le 26/10/2010 à 11h00

Aucun commentaire

Source : Branchez-vous !

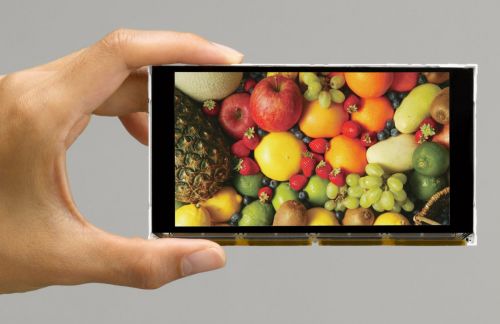

En présentant son iPhone 4 il y a quelques mois, Apple a beaucoup impressionné grâce à la résolution record de son écran Retina Display (conçu et fabriqué par LG), qui atteint 326 dpi, permettant une définition de 960x640 sur une diagonale de 3.5". Avec son HAST, ORTUS fait encore mieux...

La joint venture de Casio et Toppan Printing a en effet présenté un prototype d'écran LCD de technologie Hyper Amorphous Silicon TFT qui améliore la résolution de 40% par rapport au Retina Display de l'iPhone 4. Avec ses 458 dpi, ce prototype d'à peine 4.8" offre ainsi une image full HD. Le tout avec 16.7 millions de couleurs et des angles de visions de 160 degrés (grâce à la technologie IPS, le Retina Display fait mieux sur ce point).

Le prix et la date de commercialisation sont encore inconnus.

Posté par Matt le 26/10/2010 à 09h00

Aucun commentaire

Source : CrunchGear via Ptit_bœuf

Après les débats houleux sur le projet de loi, la censure du Conseil Constitutionnel, les retards au démarrage, le manque de coopération de certains FAI, l'HADOPI se retrouve désormais confrontée à un nouveau problème : un manque de fiabilité des identifications d'abonnés et quelques difficultés à monter en charge...

En effet, selon des sources, une part importante des IP communiquées à l'HADOPI par Trident Media Guard ne seraient pas identifiables par les FAI. Entre 8 et 10% des demandes d'identification reviennent avec une identification négative, ce qui laisse craindre un véritable manque de sérieux de la part de TMG. Rappelons en effet que pour qu'une IP soit "flashée", TMG est sensé initier le téléchargement d'une œuvre surveillée depuis l'IP en question, pour éviter d'accuser injustement les titulaires d'IP qui auraient par exemple été injectées dans les réseaux P2P via des outils tels que SeedFuck. Problème : si TMG parvient à flasher des IP non identifiables, donc probablement non valides au moment où elles ont été flashées, il y a un fort risque que parmi les autres IP flashées, certaines soient valides, mais elles aussi flashées à tort...

Par ailleurs, la volumétrie traitée actuellement par l'HADOPI est très très loin des promesses... Alors que l'industrie de la musique a commencé à envoyer des IP à l'HADOPI au rythme de 3000 par jour dès la mi-août, pour atteindre aujourd'hui 10 000 par jour et dit viser les 25 000 d'ici à la fin de l'année, l'HADOPI n'a commencé à envoyer les mails d'avertissement que depuis le début du mois d'octobre, et à un rythme d'à peine 100 mails par jour. À croire que les sept employés de l'HADOPI envoient ces messages manuellement... En fin d'année, l'HADOPI espère atteindre un rythme de 1000 à 2000 messages par jour. On restera donc loin du nombre d'IP flashées.

Autant dire qu'une bonne part des abonnés indélicats passera au travers des mails du filet. Sur quels critères ? Pour l'instant, l'HADOPI épargnerait les IP d'entreprises (sage décision, une coupure d'Internet en entreprise pouvant avoir un fort impact négatif sur son activité...) et privilégierait celles prise en flagrant délit de partage d'œuvres récentes, par exemple des films encore en salle ou des albums venant tout juste de sortir.

Rappelons que le budget de l'HADOPI est de plus de cinq millions d'euros pour la demi-année 2010, et devrait passer à 12 millions d'euros l'année prochaine. Soit au rythme actuel environ 330€ par mail d'avertissement envoyé. Aux frais du contribuable. J'ai mal à mes impôts...

Posté par Matt le 25/10/2010 à 23h42

Aucun commentaire

Source : PCInpact

Trois nouveaux logiciels ce week-end dans la logithèque :

Posté par Matt le 24/10/2010 à 22h48

Aucun commentaire

Alors que le gouvernement utilise l'excuse de la baisse du traffic P2P, et donc des coûts liés à ce trafic, pour ne pas indemniser les FAI des frais liés aux procédures HADOPI, un FAI français à révélé que depuis l'entrée en vigueur d'HADOPI, les coûts du trafic seraient en fait à la hausse...

En effet, les réseaux P2P étant surveillés, les utilisateurs ont désormais tendance à se tourner vers d'autres solutions, et en particulier le téléchargement direct sur des plateformes telles que Megaupload ou Rapidshare. En conséquence, les FAI échangent désormais beaucoup plus de données avec l'extérieur de leur réseau, alors qu'en P2P, une part importante du trafic se faisait en interne, entre les abonnés.

Or, le trafic sortant est beaucoup plus coûteux que le trafic interne, puisque les opérateurs tiers qui facturent ce trafic prennent leur marge au passage.

Une hausse des coûts qui pourrait pousser les FAI à mettre en place des filtrages de leur propre initiative, pour éviter de se retrouver dans le rouge, ce qui arrangerait particulièrement les ayant-droits. Certains représentants des ayant-droits estimaient d'ailleurs dès le début des débats qu'il était stratégique de ne pas offrir la moindre indemnisation aux FAI, pour les pousser à mettre en place des solutions de filtrage.

L'HADOPI n'a décidément pas fini de faire parler d'elle...

Posté par Matt le 21/10/2010 à 11h10

2 commentaires

Source : PCInpact

Comme nous l'annoncions il y a une semaine, Apple a tenu ce soir une conférence de presse pour présenter quelques nouveautés : le nouveau MacBook Air, la suite iLife '11 et un premier aperçu de Mac OS X 10.7 Lion, la prochaine mouture de l'OS à la pomme.

Côté MacBook air, nous avons droit à un changement de design, avec une coque Unibody plus anguleuse, qui permet de caser la connectique sans avoir recours à une trappe, avec en prime l'ajout du second port USB que beaucoup réclamaient. Est est désormais décliné en deux versions, une 11.6" 1366x768 16/9ème et une 13.3" 16/10ème 1440x900.

Les deux modèles sont tous deux dotés de 2 Go de mémoire DDR3, d'un processeur Core 2 Duo (1.4 GHz sur le 11.6" et 1.86 GHz sur le 13.3") et d'un IGP nVidia Geforce 320M. Les disques durs sont désormais exclus de la gamme, qui embarque des SSD de 64 ou 128 Go en 11.6" et 128 ou 256 Go en 13.3". Les tarifs vont de 999€ pour le 11.6" 64 Go à 1599€ pour le 13.3" 256 Go en passant par 1149€ et 1299€ pour les modèles 128 Go en 11.6" et 13.3". En option, les quatre versions pourront passer à 4 Go de RAM pour 90€. Côté processeur, le 11.6" 128 Go peut passer à 1.6 GHz, également pour 90€, tandis que le 13.3" 256 Go peut être poussé à 2.13 GHz, toujours pour 90€.

Le MacBook Air n'était pas doté de lecteur DVD, Apple fournit désormais le support de réinstallation sur une clé USB. Le MacBook Air 11.6" a des dimensions de 0.3-1.7*29.95*19.2 cm pour 1.06 kg, contre 0.3-1.7*32.5*22.7 cm et 1.32 kg pour le modèle 13.3". L'autonome est de 5h en 11.6" et 7h en 13.3".

Côté Mac OS X, les nouvelles fonctionnalités présentées ont de quoi inquiéter certains... Alors que le titres de la conférence de presse ("Back to the Mac") laissait penser qu'Apple allait tenter de satisfaire ceux qui, depuis deux ou trois ans, se plaignent que la pomme se focalise trop sur les iPhone et iPod, la principale nouveauté annoncé ce soir va dans le sens inverse, et risque encore d'amplifier la grogne : Apple va lancer un App Store pour Mac ! Comme sous iOS, il permettra d'acheter et installer en un clic des applications validées par Apple, avec des critères de validation similaires à ceux de la plateforme iOS. Heureusement, le passage par cette boutique ne sera pas obligatoire, contrairement à ce qui se fait sur iOS. Mais pour combien de temps ? On ne peut en effet s'empêcher que, dans sa volonté d'avoir toujours plus de contrôle sur ses clients, Apple rende ultérieurement impossible l'installation d'applications non validées...

Les autres nouveautés sont également tout droit tirées d'iOS : multi-touch (mais il n'y aura pas d'écrans tactiles sur les Mac), écran d'accueil reprenant les icônes de toutes les applications, possibilité d'avoir des applications plein écran, sauvegarde de l'état des applications, pour le retrouver au lancement suivent, etc...

Le nouveau Mac OS X devrait être disponible l'été prochain, tandis que l'App Store ouvrira dans 90 jours, et sera donc compatible avec Snow Leopard.

Posté par Matt le 20/10/2010 à 23h10

6 commentaires

Source : Macbidouille

Lorsqu'Apple a lancé ses Macbook, ils ont été dotés d'une nouvelle connectique pour l'adaptateur serveur, la fiche magnétique MagSafe, qui s'arrache automatiquement en cas de forte tension, évitant de faire tomber l'ordinateur quand on se prend les pieds dans le câble... Un connecteur qu'Apple a bien évidemment breveté...

Si ce brevet à empêché les constructeurs de PC d'utiliser une connectique similaire, il a aussi mis un gros frein au marché des batteries externes pour Macbook, puisque il est nécessaire de passer par ce connecteur pour connecter la batterie à la machine.

La plupart des fabricants de batteries externes se sont donc mis à proposer des batteries livrées avec les instructions nécessaires pour fabriquer soi même le câble reliant la batterie au Macbook en récupérant la fiche du chargeur, certains fournissant même le nécessaire pour fabriquer un adaptateur pouvant soit être connecte à la batterie, soit être reconnecté au chargeur original, évitant ainsi de le sacrifier totalement.

Ces solutions "Do It Yourself" rebutant plus d'un utilisateur, Sanho avait pris l'initiative de fournir directement des câbles MagSafe avec ses batteries HyperMac. Pour ce faire, ils ne fabriquaient pas de fiches MagSafe "pirates", mais achetaient tout simplement des chargeurs chez Apple pour en récupérer le connecteur MagSafe (d'où le prix élevé du câble, facturé 100$ par Sanho, sachant qu'Apple vend ses chargeurs 80$...). De leur point de vue, ceci n'était pas une violation de brevet, puisqu'ils ne fabriquaient pas eux même le connecteur.

Hélas, Apple ne l'entend pas de cette oreille. La pomme a attaqué Sanhoen justice et obtenu gain de cause, ce qui le contraint donc à stopper la commercialisation de ces câbles. Le constructeur effectue toutefois un déstockage en continuant la commercialisation sur son site jusqu'au 2 novembre. Si vous êtes intéressé, c'est le moment de sauter dessus ! Passé cette date, les batteries HyperMac seront toujours vendues, mais sans l'indispensable câble de connexion.

Voilà donc une décision de justice fort regrettable. On se demande d'ailleurs toujours pourquoi Apple s'est attaquée à Sanho. En effet, non seulement Sanho ne faisait aucune concurrence à Apple, qui ne vend pas ce type de produit, mais en plus Sanho rendait service aux clients d'Apple, contribuant donc à leur satisfaction globale vis à vis de la plateforme Mac... Et c'est d'autant plus étonnant que pendant ce temps là, Apple laisse faire les nombreux constructeurs de chargeurs MagSafe contrefaits, qui écoulent pourtant leur production sur des sites ayant pignon sur rue...

Posté par Matt le 20/10/2010 à 11h30

Aucun commentaire

Source : MacWorld

Il y a deux semaines, Motorola a déposé une plainte contre Apple pour la violation de 18 brevets concernant la téléphonie mobile. Le constructeur américain en remet une petit couche cette semaine, en déposant une nouvelle plainte, portant cette fois sur 12 brevets.

Fait original, dans son dossier déposé auprès de la cour du Delaware, Motorola ne reproche pas à Apple que le fait de violer des brevets, mais aussi le fait que la pomme ait régulièrement attaqué des constructeurs utilisant le système Android (c'est le cas d'HTC, actuellement trainé par Apple devant la justice américaine), raison pour laquelle Motorola se sent menacé par Apple. Et comme chacun le sait, la meilleure défense, c'est l'attaque !

On peut également se demander si Motorola n'aurait pas ajouté cette petite remarque dans l'idée de créer une alliance officieuse entre les différents fabricants de mobiles Android, afin de se défendre entre eux lorsqu'ils sont attaqués par Apple, Microsoft ou RIM, les maisons mères des trois principaux concurrents d'Android sur le marché des OS mobiles.

Posté par Matt le 20/10/2010 à 10h11

Aucun commentaire

Source : Clubic

![]()

Lorsque le processus d'attribution de la nouvelle licence 3G a été lancé, les trois opérateurs en place s'étaient engagés à offrir l'itinérance sur leur réseau aux abonnés du nouvel opérateur lorsqu'ils sont dans une zone non couverte. Mais alors que les opérateurs en place ne veulent proposer que l'itinérance 2G, Free Mobile réclame l'itinérance 3G.

Ainsi, lorsque Free Mobile lancera son offre commerciale en 2012, les abonnés de l'opérateur risquent fort de ne pouvoir profiter de la 3G que dans la petite portion du territoire qui sera couverte par Free (27% de la population), et donc de devoir se contenter de la 3G partout ailleurs.

Pour obtenir gain de cause, Xavier Niel, le fondateur du groupe Iliad, maison mère de Free Mobile, est prêt à lancer une procédure contentieuse s'il ne parvient pas à un accord avec les opérateurs en place avant la fin de l'année. Cette procédure n'aurait pas forcément de base légale, mais aurait le soutient de l'ARCEP et de l'Autorité de la Concurrence, toutes deux favorables à l'itinérance 3G, favorable à la compétitivité de Free Mobile, donc à la concurrence.

Xavier Niel a également donné quelques informations sur les moyens et les ambitions de sa division mobile. Tout comme Free ADSL, Free Mobile va concevoir ses propres équipements réseau, afin des les adapter au mieux à ses besoins, et donc d'en réduire le coût. Le réseau sera un réseau tout IP, interconnecté avec le réseau Free ADSL, dont les Freebox devraient se voir dotées de femtocells. Le marketing sera réduite à sa plus simple expression (le retour de Rodolphe ?), Xavier Niel comptant sur le bouche à oreilles, qui a déjà fait le succès de Free.

Sans donner de détails sur les forfaits qui seront proposés, Xavier Niel précise qu'il s'agira d'une "offre simple et au juste prix", à des années-lumières de la complexité des catalogues des opérateurs actuels.

Grâce à son offre mobile, Iliad espère doubler son chiffre d'affaire d'ici à 2015, avec 4 milliards d'euros, et le groupe vise à terme 25% de part de marché sur la téléphonie mobile.

Cool, j'ai réussi à faire une news sur la téléphonie mobile en France sans citer Orange, SFR et Bouygues... Ou pas :-)

Posté par Matt le 19/10/2010 à 12h30

Aucun commentaire

Source : Generation NT

![]()

Le réseau Internet approche de plus en plus de la saturation. En cause, le protocole IPv4, qui gère l'adressage des machines connectées au réseau mondial, et qui arrivera tout simplement bientôt à cours d'adresses !

En effet, sur les près de 4.3 milliards d'adresses disponibles, il n'y en a plus que 5% qui sont disponibles, contre 10% en début d'année. À ce rythme, la Number Ressource Organization estime que les adresses seront toutes attribuées dès le début de l'année prochaine. Une fois cette limite atteinte, toute nouvelle machine désirant se connecter à Internet devra le faire en se connectant à un réseau privé disposant d'une passerelle Internet, afin de partager une IP publique avec plusieurs machines (c'est déjà le cas par exemple chez les particuliers qui partagent leur liaison ADSL entre plusieurs postes), ce qui n'est pas sans poser quelques problèmes, puisque deux machines partageant la même IP ne peuvent pas héberger chacune un service sur le même port (impossible par exemple d'avoir derrière la même adresse IP deux serveurs web exploitant le port HTTP standard).

Pour palier à cette pénurie, la prochaine étape est le basculement vers le protocoles IPv6 qui, grâce à ses adresses sur 128 bits (32 pour l'IPv4), permet en théorie de disposer de plusieurs dizaines de milliards de milliards de milliards de milliards d'adresses... Bien que certains groupes d'adresses soient réservés à des usages spécifique et que le protocole prévoit plusieurs adresses par machines, la taille du nouvel espace d'adressage devrait permettre d'éviter toute pénurie avant la fin du monde. Le passage en IPv6 nécessitera par contre des investissements parfois coûteux, afin de renouveler les matériels et logiciels incompatibles.

Pas de panique toutefois pour le grand public : la migration de l'IPv4 à l'IPv6 devrait se faire en toute transparence.

Posté par Matt le 19/10/2010 à 10h10

Aucun commentaire

Source : Branchez-vous!

Les p'tits gars du marketing de chez nVidia ne doivent vraiment pas savoir quoi faire de leur journées... En effet, après les renommages en série des puces nVidia, le constructeur vient de présenter une nouvelle carte d'entrée de gamme, la GeForce GT 440, dotée de... 3 Go de RAM !

Cette quantité de RAM est d'ailleurs probablement le seul point qui la fera un peu sortir du lot, cette carte ne risquant pas de se distinguer par ses performances, vu ses spécifications. En effet, son GPU une une puce Fermi à 144 processeurs de flux, et cadencée à 594 MHz, ce qui lui donne une puissance de calcul théorique de 342 Gflops, soit à peu de choses près l'équivalent de la 8800 GT, une carte sortie il y a trois ans. Elle disposera d'un peu plus de puissance en texturing (14.3 Gtexels/s contre 9.6), mais d'une bande passante mémoire moindre, avec son bus mémoire 192 bits à 900 MHz, qui ne débitera que 40.2 Go/s (contre 51.6).

On peut donc se demander quel est l'intérêt d'une telle quantité de mémoire sur ce type de carte, à part pour gagner au jeu de celui qui a la plus grosse... En effet, les applications capables de tirer partie d'une très grande quantité de mémoire sont généralement aussi les plus gourmandes en puissance de calcul et en bande passante. Cette carte n'aurait donc probablement pas manqué de mémoire si elle n'en avait été dotée que de 768 Mo...

Posté par Matt le 18/10/2010 à 22h56

4 commentaires

Source : PCWorld

![]()

Depuis quelques temps, Crucial casse les prix sur ses SSD M225. On trouvait en effet le modèle 256 Go à moins de 400€ sur le site du fabricant, qui semble bien décidé à liquider ses stocks de ce modèle d'ancienne génération. Grosbill fait encore plus fort, en proposant le Crucial M225 256 Go à 299€ !

On se rapproche donc de plus en plus de la limite psychologique de 1€/Go (alors que les disques durs de grande capacité sont désormais à environ 5cts/Go). Rappelons que le Crucial M225 est un SSD basé sur le contrôleur Indilinx Barefoot, un contrôleur d'ancienne génération, mais qui reste globalement performant, sans problème majeur connu, et avec le support du TRIM.

Si vous êtes intéressé, profitez en rapidement, je ne serais pas surpris qu'il y ait une erreur de tarification, la version 128 Go étant affichée à seulement 20€ de moins.

Posté par Matt le 18/10/2010 à 11h28

Aucun commentaire

Source : Bunios sur le forum Macbidouille

Prévue depuis fort longtemps, la logithèque Infobidouille ouvre enfin ses portes.

Encore peu fournie pour l'instant, elle sera étendue petit à petit avec les logiciels dont nous jugeons qu'ils ont leur place dans notre sélection.

Elle est accessible directement depuis le menu horizontal, via l'entrée "Logiciels".

Posté par Matt le 17/10/2010 à 23h01

9 commentaires

![]()

Après avoir cherché à ralentir l'identification des abonnés, puis après avoir refusé d'envoyer les mails d'avertissement de l'HADOPI à ses clients, Free s'est finalement résigné à rentrer dans le rang, après la publication mercredi d'un nouveau décret.

Celui-ci modifie l'article R. 331-37 du code de la propriété intellectuelle, y ajoutant une obligation pour les opérateurs d'assurer la transmission des avertissements par e-mail dans un délai de 24h après la demande de la commission. En cas de non respect de ce délai, le FAI s'expose à une contravention de 5ème classe d'un montant de 1500€, pouvant monter jusqu'à 15 000€ en cas de récidive dans un délai d'un an.

Ayant décidé de ne pas contester ce décret, Free sera donc bien obligé de rentrer dans le rang, puisque n'ayant pas les moyens de se permettre de telles amendes. Free continue par contre à réclamer une indemnisation financière pour ces envois de mail, mais avec des prétentions revues à la baisse, puisqu'il serait prêt à se contenter de 30 centimes par mail, alors qu'il en réclamait initialement 65.

Posté par Matt le 15/10/2010 à 10h50

Aucun commentaire

Source : Tom's Guide

Après avoir obtenu en 2009 un brevet sur l'utilisation d'écrans tactiles multi-touch, Apple est allé encore plus loin, en déposant des brevets sur les différents gestes liés à l'utilisation des écrans multi-touch.

Déposés fin 2006, ces brevets viennent malheureusement d'être validés par l'office américain des brevets, avec effet rétroactif jusqu'à la date de dépôt de la demande. Ceci pourrait poser de sérieux problèmes aux concurrents d'Apple, que la firme pourra désormais attaquer s'ils commercialisent sur le territoire américain des produits utilisant par exemple le geste de pincement à deux doigts pour zoomer/dézoomer sur une portion de l'affichage.

Il existe pourtant sur Internet diverses traces de l'usages de ces gestes bien avant qu'Apple ne les "invente", et notamment cette impressionnante vidéo qui va bientôt fêter ses vingt ans (elle date de 1991) :

Rappelons toutefois que de notre côté de l'Atlantique les concurrents d'Apple peuvent rester sereins vis à vis de ces brevets, qui ne sont pas valide dans l'Union Européenne, qui ne reconnait pour l'instant pas les brevets logiciels.

Posté par Matt le 15/10/2010 à 09h51

Aucun commentaire

Source : Tom's Hardware

Si Duke Nukem Forever occupe actuellement une place de choix au panthéon des vaporwares. Mais Gran Turismo 5 mériterait lui aussi sa place, avec l'annonce d'un nouveau retard...

Très attendu depuis la commercialisation de la Playstation 3, le titre phare de Polyphony Digital a en effet été encore une fois retardé, alors qu'il est annoncé depuis 2004... Les choses semblaient pourtant bien se présenter, puisque depuis quelques semaines, une date officielle avait été annoncée (le 2 novembre aux États-Unis et le 3 novembre dans le reste du monde), et de nombreux revendeurs de jeux avaient commencé à prendre des pré-commandes. Hélas, un communiqué de presse de Sony a annoncé cette semaine un nouveau retard du jeu...

Officiellement, ce nouveau report serait une décision de Kazunori Yamauchi, père de la série Gran Turismo, qui souhaiterait peaufiner les derniers détails de son nouveau bébé. Officieusement, certains accusent déjà Sony d'avoir provoqué ce retard pour faire parler du jeu avant sa sortie, tandis que les détracteurs de la Playstation 3 en profitent pour souligner la difficulté du développement sur cette plateforme. Il est vrai que depuis le début du développement de GT5 chez Polyphony Digitals, Turn 10 a sorti trois versions successives de Forza Motorsports sur la plateforme Xbox...

Ceux qui comptaient s'offrir Gran Turismo 5 pour Noël peuvent toutefois dormir sur leurs deux oreilles, puisque pour l'instant, Sony promet que le jeu sortira avant. À moins qu'un nouveau retard ne vienne perturber la fête...

Posté par Matt le 15/10/2010 à 00h19

2 commentaires

Source : Gamepro

Apple a envoyé aujourd'hui à la presse des invitations pour un "Special Event" qui se tiendra mercredi prochain (20 octobre). Alors que les précédents "Special Event" avaient un peu laissé le Mac de côté, Apple annonce clairement la couleur, cette fois le Mac sera le centre d'intérêt de la conférence de presse, le titre de l'invitation étant "Back to the Mac".

Et au vu de l'image d'illustration de l'invitation, on peut s'attendre à la première présentation publique du prochain Mac OS X, la version 10.7, qui devrait répondre au nom de code "Lion". En effet, l'image présente une tête de lion cachée derrière une pomme, et le lion est effectivement un félin qui n'a pas encore servi pour nommer une version d'OS X (le guépard, le puma, le jaguar, la panthère, le tigre, le léopard et l'once ont déjà passé leur tour).

Un nom qui pourrait revêtir une importance particulière : le lion étant le plus emblématique des félins, il y a fort à parier qu'un Mac OS X portant ce nom sera le dernier avant une révision majeure de l'OS, justifiant un passage à la version 11 et peut-être à une autre famille d'animaux.

Posté par Matt le 13/10/2010 à 22h15

3 commentaires

Source : Macbidouille

![]()

Depuis quelques temps, HTC connait une forte croissance de ses ventes, grâce au succès de ses différents modèles de smartphone sous Android, dont le Desire et le Evo 4G, mais aussi le Nexus One de Google, qui est fabriqué par le taïwanais. Mais le constructeur n'oublie pas Windows...

En effet, même si ces derniers temps, les appareils Android ont totalement éclipsé les produits Windows de la marque, HTC ne compte pas bouder le système de Microsoft, surtout avec l'arrivée cette semaine de Windows Phone 7, une évolution majeure de l'OS mobile de Microsoft.

Ainsi, le PDG de la firme a indiqué qu'HTC avait fait le choix de ne pas se concentrer à priori particulièrement sur Android plutôt que que Windows Phone 7, ni l'inverse. En bon industriel, HTC suivra donc simplement la tendance du marché, en accordant un peu plus de moyens à l'OS qui sera le plus demandé.

Posté par Matt le 13/10/2010 à 10h57

Aucun commentaire

Source : Le Journal du Geek

![]()

Il y a un peu moins d'un an, Free sortait vainqueur du processus de choix de l'opérateur auquel l'ARCEP devait accorder la quatrième licence 3G. L'arrivée de Free sur ce marché n'étant pas du goût des opérateurs en place, ceux-ci avaient déposé un recours auprès du Conseil d'État.

Si les trois opérateurs ne contestaient pas les critères d'attribution de la nouvelle licence, ils n'étaient pas du tout d'accord avec le montant réclamé au nouvel opérateur : "seulement" 240 millions d'euros, alors que Orange, Bouygues et SFR avaient chacun été facturé 650 millions d'euros pour leur licence.

Free et l'ARCEP se défendaient de leur côté en justifiant cette baisse de prix par une différence importante entre les anciennes licences et la nouvelles : alors que Orange, Bouygues et SFR ont eu droit à une bande de fréquence de 15 MHz, Free n'a pour sa part obtenu que 5 MHz, ce qui complique grandement la réalisation d'un réseau d'antennes relais de forte densité. La prix quasiment divisé par trois se justifierait donc par la largeur de bande divisée elle aussi par trois.

Rendue aujourd'hui, la décision du Conseil d'État donne finalement raison à Free et à l'ARCEP, confirmant ainsi la validité de la licence de Free. L'opérateur va donc désormais pouvoir investir sereinement dans ses équipements 3G, sans risque que tout son investissement soit ruiné par l'invalidation de la licence.

Posté par Matt le 12/10/2010 à 21h25

Aucun commentaire

Source : minutebuzz

Si le succès de l'USB est incontestable pour connecter à peu près tous les types de périphériques possibles et imaginables, il lui reste un défaut qui lui est souvent reproché : sont manque de puissance d'alimentation, celle-ci étant limitée à 2.5W.

Une limite qui n'est pas gênante pour une clé USB ou un clavier, mais pose vite problème pour des périphériques plus gourmand, comme un disque dur 3.5" ou une imprimante. Le Firewire, qui fait partie des concurrents directs de l'USB, est bien plus souple à ce niveau, puisqu'il offre une puissance de plusieurs dizaines de watts, avec une tension d'alimentation pouvant atteindre 30V.

Pour permettre à l'USB de rattraper le Firewire sur ce point, après l'avoir largement surpassé sur les débits depuis l'introduction de l'USB 3.0, Intel planche donc sur une important évolution de la norme, visant à augmenter très sensiblement la puissance d'alimentation, et donc à éliminer une partie des blocs d'alimentation externes accompagnant nos périphériques.

Intel vise une tension pouvant aller jusqu'à 42V (contre 5V actuellement, et 12V dans le non officiel USB+Power) et une intensité pouvant monter à 1.8A (contre 500mA actuellement pour un port actif et 1.5A pour un port dédié à la charge), pour une puissance maximale de 35W (soit 14 fois plus que l'USB classique). Avec une telle puissance, l'alimentation des disques durs 3.5" ne sera plus un problème, et ces nouveaux ports USB devraient également permettre une recharge plus rapide des appareils mobiles.

Posté par Matt le 12/10/2010 à 09h50

2 commentaires

Source : Macbidouille

Alors qu'Intel vient tout juste de dévoiler les spécifications de ses SSD de 2011, SandForce réagit déjà en annonçant sa gamme de contrôleurs SF-2000, qui succédera aux réputés SF-1200 et SF-1500.

Cette gamme se composera de trois modèles pour entreprise (2300, 2500 et 2600) et d'une version grand public (2200). Seules les spécifications des modèles entreprise ont été dévoilées pour l'instant.

Le SF-2500 prendra en charge le SATA 6 Gbits/s (alors que le nouveau contrôleur Intel reste limité à 3 Gbits/s), ce qui lui permettra d'atteindre des débits séquentiels de 500 Mo/s, très supérieurs aux débits actuels, avec également une légère amélioration des performances en accès aléatoire (60 KIOPS contre 50). Il supportera les mémoires SLC, eMLC et MLC, qu'elles soient de la génération 30nm ou de la génération 20nm. Comme les nouveaux contrôleurs Intel, le SandForce 2500 supportera le chiffrement matériel, mais avec des clés plus longues, puisqu'ils pourront travailler en AES-128 ou AES-256. Comme les SandForce 1000, il fonctionnera sans mémoire cache externe.

Le SF-2600 reprendra les mêmes caractéristiques, mais en se dotant en plus d'un pont SATA vers SAS, et il supportera des secteurs logiques de taille différente de 512 octets. Le SF-2300 sera pour sa part un SF-2500 capable de fonctionner en environnements extrêmes.

Posté par Matt le 08/10/2010 à 12h20

Aucun commentaire

Source : SandForce

Le système d'exploitation pour smartphones de Google continue d'avoir le vent en poupe aux États-Unis, et conforte sa troisième position sur le parc installé, en équipant désormais près de 20% des smartphones en circulation aux USA selon ComScore.

Par rapport au mois de mai dernier, la part d'Android dans le parc de smartphone est passée de 13% à 19.6%, soit une progression de plus de 50%, pendant que ses deux principaux concurrents voyaient leur part diminuer au stagner : Blackberry OS est passé de 41.7% à 37.6% (-10%) et iOS de 24.4% à 24.2% (-1%).

Une progression dû à la part de marché conséquente que s'est octroyé Android sur les ventes, puisque sur ces six derniers mois, près d'un tiers des smartphone vendus aux USA (32%) ont été des appareils Android, contre "seulement" 26% de Blackberry et 25% d'iPhone.

À ce train, Android pourrait devenir l'OS mobile le plus répandu aux USA d'ici deux ou trois ans.

Posté par Matt le 08/10/2010 à 10h11

Aucun commentaire

Source : PCWorld

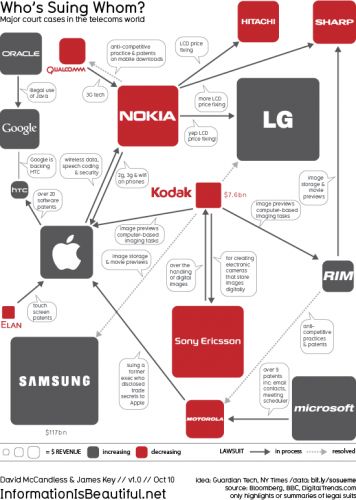

Après avoir été attaqué en justice par Microsoft pour violation de brevets avec ses smartphone, Motorola change de casquette et devient attaquant, en reprochant à Apple d'avoir violé 18 de ses brevets, toujours dans le domaine de la téléphonie mobile.

L'occasion pour de nombreux sites Internet de faire le point sur la situation judiciaire du secteur des télécoms, où les procès pour violation de brevet sont particulièrement nombreux ces derniers temps, probablement à cause de la forte croissance du marché des smartphones, marché où les acteurs historiques de la téléphonie mobile sont bousculés par de nouveaux entrants aux dents longues...

"Résumée" en image par Information is Beautiful, la situation n'est pas des plus limpides, avec des flêches dans tous les sens, les principaux acteurs du marché étant tous impliqués dans plusieurs procès, soit en tant que plaignant, soit en tant que défendant. Les avocats n'ont pas fini de s'en mettre plein les poches...

Mention spéciale pour Samsung, qui est le plus gros acteur du marché mais réussit à rester un peu à l'écart de cette folie judiciaire, le coréen n'étant actuellement impliqué dans aucun procès, après que le procès que lui a intenté Kodak se soit terminé.

(ndlr : le jeu de mot moisi du titre est ©Ptit_bœuf, qui assume pleinement son œuvre)

Posté par Matt le 07/10/2010 à 19h40

1 commentaire

Source : Information is Beautiful via Ptit_bœuf

Le plus célèbre vaporware de l'histoire du jeu vidéo fait à nouveau parler de lui, et semble enfin se rapprocher de la fin de son statu de vaporware, puisqu'une démonstration publique du jeu a été fait, et que celui-ci semble en phase de finalisation.

Pour rappel, Duke Nukem Forever est la suite de Duke Nukem 3D, le jeu de tir à la première personne qui a fait la gloire de 3D Realms en 1996. Annoncé en janvier 1997, Duke Nukem Forever a depuis connu une histoire semée d'embuches : changement de moteur 3D en 1998, obligeant à recommencer le développement, nouveau départ d'une feuille blanche en 2002, suite aux retards accumulés, changement de moteur physique deux ans plus tard...

Fin 2007, les choses semblaient se présenter mieux, avec l'apparition de captures d'écran du jeu sur Internet, puis dans la version Xbox 360 de Duke Nukem 3D, lancée fin 2008. Mais en mai 2009, 3D Realms a mis la clé sous la porte, mettant ainsi ce qui semblait alors un terme définitif au développement du jeu.

C'était sans compter sur la motivation de Gearbox Software, studio à l'origine de Borderlands et de Brothers in Arms, qui ont repris le projet en 2010, et viennent d'en faire la première démonstration en directe depuis que son développement à commencé.

Le jeu semble enfin avoir fait un vrai pas en avant, avec des graphismes au goût du jour et un moteur qui semble fonctionner convenablement.

Si tout va bien, Duke Nukem Forever arrivera sur vos écrans en 2011... ou pas !

Posté par Matt le 07/10/2010 à 10h30

Aucun commentaire

Sources : PCInpact et Wikipedia

Intel a enfin révélé les spécifications de sa prochaine génération de SSD, dont le nom de code Postville Refresh avait déjà été aperçu à diverses occasions sur les roadmap du constructeur. Ils embarqueront de la mémoire gravée en 25nm et une nouvelle version du contrôleur.

Un nouveau contrôleur qui permet des gains relativement importants sur les performances, en particulier en écriture. Ainsi, sur la version grand public hautes performances, le X25-M, les débits en écriture séquentielle passeront de 100 Mo/s à 170 Mo/s, et les écritures aléatoires de 4 Ko passeront de 8 600 opérations par seconde à 40 000. En lecture, les débits ne bougent pas en séquentiel (250 Mo/s), mais le nombre d'accès de 4 Ko par seconde atteindra 50 000, contre 35 000 actuellement.

L'endurance de ces nouveaux SSD progresse également fortement, en passant de 7.5/15 To d'écritures aléatoires de 4 Ko à 30/60 To. Une progression sans doute aidée par le nouveau contrôleur qui disposera désormais d'un vrai cache (sur les X25-M actuels, le cache ne sert que pour stocker des structures utilisées par le contrôleur, pas pour stocker des données en attente d'écriture), accompagné d'une réserve d'énergie permettant de sauver les données du cache en cas de coupure d'alimentation électrique. Enfin, le contrôleur supporte le chiffrement en AES-128.

Du côté des SSD pour entreprise, les X25-E, qui n'ont pas changé depuis la première version, on passe de la mémoire SLC 50nm à de la eMLC 25nm. La eMLC ou "Enterprise MLC" est une mémoire de type MLC, mais plus endurante que la MLC classique. Là encore, les débits séquentiels restent inchangés en lecture (250 Mo/s), mais progressent légèrement en écriture (200 Mo/s au lieu de 170 Mo/s), tandis que le débit d'I/O 4 Ko passe de 35 000 à 50 000 en lecture et de 3 300 à 5 000 en écriture (notez que la méthode de mesure n'est pas la même que pour les X25-M, d'où les chiffres inférieurs). L'endurance reste similaire à l'ancienne version, avec 900 To à 1.4 Po, selon les modèles, contre 1 à 2 Po pour le X25-E actuel. Le X25-E bénéficiera bien entendu aussi du cache protégé contre les coupures d'alimentation et du chiffrement AES-128.

Ces nouveaux modèles auront toutefois un défaut pas rapport à leurs prédécesseurs : la consommation électrique est revue à la hausse. Le X25-M passera de 3W en charge et 60mW au repos à 6W en charge et 75mW au repos, tandis que le X25-E passera de 3W/60mW à 5W/95mW. On peut toutefois espérer qu'une partie de cette augmentation soit due au chiffrement AES-128, et ne concernera donc que ceux qui l'auront activé.

Les X25-M seront déclinés en capacités de 80, 160, 300 et 600 Go, à des prix au Go qui devrait être diminué quasiment de moitié par rapport aux versions actuelles, tandis que le X25-E sera proposé en 100, 200 et 400 Go. Un nouveau X25-V de 40 Go est également au programme. Tous ces SSD devraient arriver sur le marché fin 2010 ou début 2011.

Posté par Matt le 06/10/2010 à 23h54

2 commentaires

Source : PCWorld

![]()

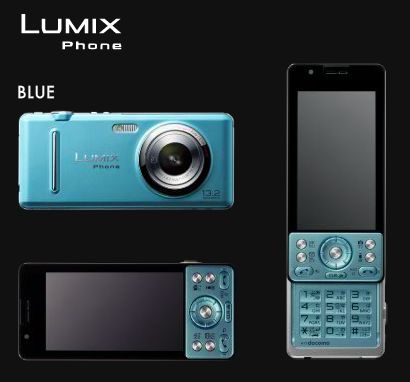

Surtout connu en Europe pour ses appareils photos et ses équipements home-cinema, Panasonic s'apprête à se lancer sur le très concurrentiel marché des téléphones mobiles. Et pour ce faire, il compte profiter de la notoriété de sa gamme d'appareils photos Lumix.

En effet, ce téléphone sera babptisé Lumix Phone et sera le croisement d'un appareil photo numérique compact avec un "feature-phone". La photo sera donc son point fort par rapport à ses concurrents, avec un capteur CMOS de 13.2 megapixels et une déclinaison mobile de la puce Venus Engine qu'on trouve déjà dans les appareils photos de la marque. En plus des photos, le Lumix Phone pourra enregistrer des vidéos en HD. L'optique est un objectif grand angle (équivalent 27mm), malheureusement à focale fixe, ce qui laissera un gros avantage aux appareils photos compacts.

Pour le reste, le Lumix Phone reprend bon nombre des fonctions qu'on peut attendre d'un téléphone haut de gamme : 3G, WiFi, Bluetooth, slot micro-SDHC, grand écran (3.3" 640x480) et même un tuner TV. Il fonctionnera sous un système Linux développé en collaboration avec l'opérateur NTT DoCoMo, leader du marché au japon. Plutôt encombrant, en raison de son appareil photo (116x52x17.7 pour 146g), ce Lumix Phone devrait surtout intéresser ceux qui veulent absolument se passer d'un appareil photo dédié, pour qui ces dimensions supérieures à la normale seront acceptables. Il devrait être lancé en Asie début 2011, à un prix non communiqué pour l'instant.

Posté par Matt le 06/10/2010 à 10h20

1 commentaire

Source : Le Journal du Geek via Ptit_bœuf

Alors qu'ATI a cessé depuis quelques temps de fabriquer et vendre des cartes graphiques directement sous sa marque, nVidia semble tenté de prendre le chemin inverse, en commençant à vendre des cartes en magasin, et non plus seulement aux constructeurs de cartes graphiques.

En effet, la chaîne américaine Best Buy commercialise depuis peux une GeForce GTX 460 vendue sous la marque nVidia. La GTX 460 est probablement le modèle qui se vend le plus actuellement chez nVidia, en étant l'un des seuls à être véritablement compétitif face aux solutions ATI, et il n'est pas surprenant que, vue la situation difficile qu'occupe actuellement nVidia sur le marché des cartes graphiques, le concepteur des GeForce ait décidé de les commercialiser directement, ce qui devrait lui permettre d'augmenter un peu sa marge.

Les constructeurs de cartes partenaires d'nVidia risquent par contre de mal accueillir la nouvelle, nVidia se plaçant ainsi en position de force, en étant capable de proposer des tarifs de détail qu'aucun constructeur tiers ne pourra se permettre. Reste toutefois à voir s'il s'agit là juste d'une offre temporaire réservée à Best Buy ou si nVidia va continuer dans cette voie.

Posté par Matt le 05/10/2010 à 23h46

4 commentaires

Source : DarkVision Hardware via Ptit_bœuf

La loi HADOPI n'en fini décidément pas de faire parler d'elle, alors qu'elle commence doucement à entrer en activité, les premiers mails ayant été envoyés en fin de semaine dernière. Et elle fait même parler à des endroits où on ne l'aurait pas imaginé, comme par exemple du côté de... la NSA (National Security Agency), l'un des services de renseignement des États-Unis.

En effet, la NSA aurait remonté à la DGSE son inquiétude vis à vis de l'HADOPI, dont la mise en place rend de plus en plus populaire les services de VPN chiffrés, qui permettent de fréquenter activement les réseaux P2P tout en limitant grandement les risques d'être "flashé" par la haute autorité.

Mais cette popularisation des solutions de chiffrement complique aussi la tâche de la NSA, qui consiste à analyser toutes les communications à la recherche d'activités suspectes potentiellement nuisibles à la sécurité américaine. En effet, les communications chiffrées doivent d'abord être décryptées pour être analysées. Une opération qui nécessite énormément de puissance de calcul, et qui risque donc de devenir particulièrement problématique si le volume de donnée venait à augmenter fortement...

Et c'est bien ce qui pourrait se produire avec l'encadrement de plus en plus strict d'Internet dans bon nombre de pays. Ainsi, selon START-vpn, un comparateur d'offres de VPN qui a vu son traff depuis la France être multiplié par cinq le mois dernier, le marché du VPN devrait doubler au niveau mondial à court terme.

Posté par Matt le 05/10/2010 à 14h42

Aucun commentaire

Source : Génération NT via Ptit_bœuf

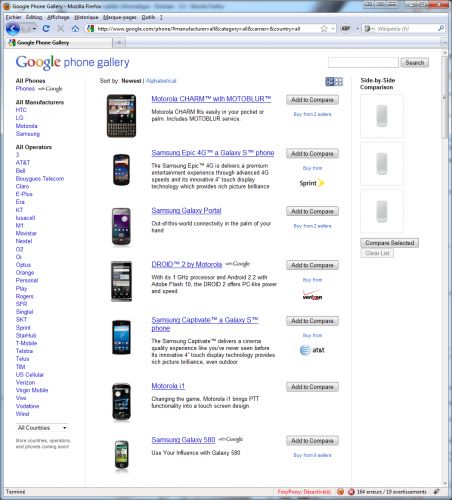

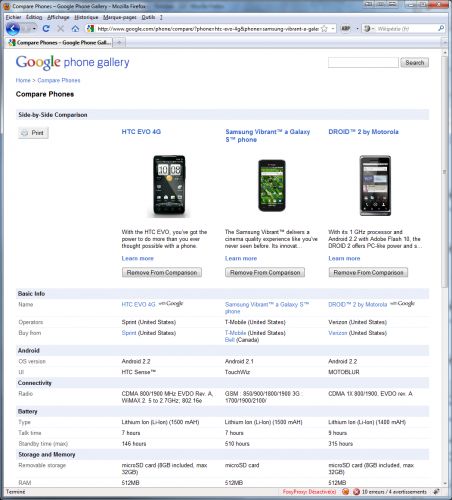

C'est incontestable, aujourd'hui Android a le vent en poupe et pourrait rapidement devenir le numéro un des OS pour smartphones et tablettes. Mais par rapport à ses deux principaux concurrents, BlackBerry OS et iOS, Android souffre d'un problème : la grande diversité de terminaux peut perturber l'acheteur en compliquant son choix...

Pour y remédier, Google vient de lancer Google Phone Gallery, un site permettant de comparer facilement différents smartphones Android. Reprenant les caractéristiques techniques de près de quarante modèles issus des quatre principaux fabricants (HTC, LG, Samsung et Motorola), il permet d'effectuer des comparaisons entre trois modèles.

Le site propose également des liens vers les boutiques des opérateurs commercialisant ces modèles (trente quatre opérateurs issus de quinze pays), et permet de filtrer la liste des appareils en fonction du constructeur, de l'opérateur et/ou du pays.

Si vous cherchez un smartphone Android, c'est par ici.