Actualités du mois de mars 2011

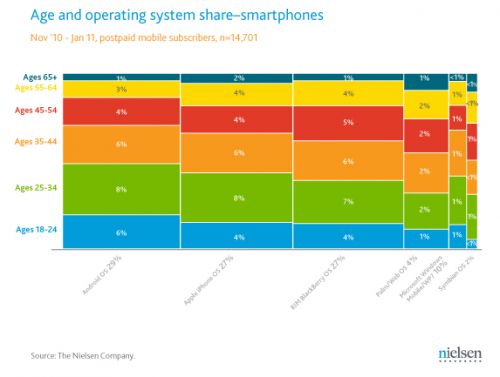

Alors que Google est toujours en conflit avec Oracle sur l'utilisation de Java, le géant américain vient de s'offrir les services de James Gosling, l'un des pères fondateurs du langage, à l'époque où il travaillait pour Sun.

Si le rôle de James Gosling au sein de son nouvel employeur n'a pas été officiellement révélé, il ne fait aucun doute qu'il aura un rapport avec Java, et donc probablement avec la plateforme Android, qui utilise massivement ce langage pour les applications tierces. Il ne serait pas étonnant que James Gosling apporte notamment son expertise dans le développement de la machine virtuelle Dalvik, interprétant du bytecode Java, et qui est justement la cause du désaccord entre Oracle et Google, le premier reprochant au second de violer la licence de Java avec sa machine virtuelle.

Google cherche depuis à mettre la pression sur Oracle en retournant la communauté Java contre l'éditeur, et il n'est pas impossible que l'arrivée de James Gosling apporte un peu de pression supplémentaire, celui-ci n'étant probablement pas un grand supporter d'Oracle, puisqu'il a quitté Sun après 16 ans de service peu après son rachat par Oracle, tout en invitant Larry Ellison à maintenir une politique d'ouverture autour de la plateforme Java.

Posté par Matt le 31/03/2011 à 14h40

Aucun commentaire

Source : Silicon.fr

Avec l'arrivée des élections présidentielles, qui se tiendront le 22 avril et le 6 mai 2012, les partis commencent à ébaucher leurs programmes. Dans ce contexte, le Parti Socialiste vient d'adopter un texte qui fera plaisir aux partisans du libre.

Destiné à "garantir le pluralisme effectif des médias" et à développer "un audiovisuel public fort et indépendant", ce texte contient différentes propositions pour l'avenir de l'audiovisuel public, et en particulier son intégration avec Internet. Un point très critiqué par le PS, qui reproche notamment au groupe France Télévisions d'avoir mis trop longtemps à lancer son offre de télévision de ratrappage (Pluzz.fr). Le PS veut donc développer tout le côté numérique de France Télévisions.

Ceci passera notamment par la mise en place d'un portail regroupant les cinq chaînes de France Télévisions, mais aussi les stations de Radio France, l'INA, l'AEF, Arte et LCP, pour faciliter l'accès aux contenus, actuellement disséminés sur de nombreux sites Internet indépendants. Ce portail aurait notamment vocation à accueillir les contenus diffusés par les différentes chaînes, et le PS souhaiterait qu'un maximum de ces contenus soient diffusés sous une licence "permettant leur réutilisation libre et gratuite".

Ce texte risque toutefois de connaitre encore quelques ajustements, puisqu'il fait aussi une proposition difficilement compatible avec la précédente... En effet, pour assurer le financement du service public, le PS ne souhaite pas rétablir la publicité, et propose donc d'augmenter la redevance, mais aussi de développer d'autres sources de revenus, notamment par la vente de contenus... Il reste tout de même envisageable d'offrir sous une licence mixte, comme souvent pratiqué dans le monde du logiciel, avec un accès gratuit pour un usage non commercial et payant dans le cas contraire.

Posté par Matt le 31/03/2011 à 12h40

Aucun commentaire

Source : Numerama

![]()

En dehors du clavier virtuel du navigateur web, quasiment inutilisable, les fonctions de détection de mouvement de la zappette de la Freebox Révolution sont encore très peu exploitées, et il y a de quoi s'inquiéter sur les capacités de la bête. Mais selon son créateur, le potentiel de la télécommande va se dévoiler petit à petit.

L'Entreprise a en effet publié un article sur Movea, l'entreprise grenobloise à l'origine de cette télécommande. Et selon cette article, les possibilités de la télécommande sont loin d'être limitées à celles activées actuellement. Ainsi, on devrait prochainement voir arriver une mise à jour qui permettra de régler le volume et de changer de chaîne par de simples mouvements de poignet, tandis que les applications tierces, et en particulier les jeux, pourront tirer parti de l'accéléromètre et du gyroscope.

Quand aux problèmes de précision rencontrés avec le clavier virtuel, ils devraient également être corrigés via une mise à jour du firmware de la télécommande, le matériel n'étant pas en cause. Il faut dire qu'à ce niveau là, la société à quelques références, et non des moindre... En effet, même si elle est totalement inconnue du grand public, Movea se définit comme étant le leader mondial dans les technologies de détection de mouvement, et elle s'est récemment offert l'américain Gyration, qui est à l'origine de la Wiimote de Nintendo. Rien que ça...

Posté par Matt le 31/03/2011 à 11h01

2 commentaires

Source : Univers Freebox

Le lancement de Google Buzz aux États-Unis avait fait grand bruit, Google ayant décidé de dévoiler automatiquement aux utilisateurs certaines données relevant de la vie privée. L'affaire avait couté près de dix millions de dollars à Google pour étouffer une class action, mais tout n'est pas encore réglé...

En effet, en plus de la class action réglée à l'amiable, la Federal Trade Commission avait été saisie du dossier par l'Electronic Privacy Information Center. Et face à la FTC, il ne suffit heureusement pas de sortir quelques millions de dollars pour se faire oublier. L'affaire est désormais terminée, mais au prix de grosses concession de la part de Google, formalisée dans un accord entre les deux entités.

Ainsi, Google a accepté d'être mis sous une surveillance régulière, visant à s'assurer que le géant de la recherche respecte bien la confidentialité des informations privées qui lui sont confiées par ses utilisateurs. Dans ce cadre, un contrôle indépendant sera effectué tous les deux ans pendant une période pouvant durer jusqu'à vingt ans.

Google s'est par ailleurs engagé à ne plus modifier la façon dont les données sont partagées sans l'accord explicite de l'utilisateur propriétaire des données. Ainsi, si Google décide par exemple de modifier la valeur par défaut du réglage de visibilité de certaines informations dans Google Profile, cette nouvelle valeur ne concernera que les nouveaux abonnés, les anciens ne passant à la nouvelle valeur que s'ils le veulent bien.

Et si la FTC allait maintenant jeter un coup d'œil du côté de Facebook ? :-)

Posté par Matt le 31/03/2011 à 08h42

Aucun commentaire

Source : Numerama

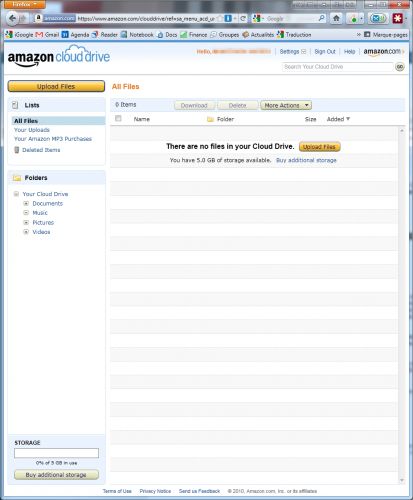

Alors que des rumeurs de plus en plus insistantes font état de l'arrivée prochaine de services de stockage de musique en ligne chez Google et Apple, Amazon vient de griller la politesse aux deux géants, avec Amazon Cloud Drive et Amazon Cloud Player.

Le premier est un service de stockage en ligne sur l'infrastructure Amazon S3. Il propose gratuitement un espace de 5 Go, mais peut être étendu à 20 Go pour une durée d'un an pour l'achat d'un album sur Amazon MP3. Des capacités supplémentaires sont également disponibles contre paiement (1$/Go/an). Cet espace de stockage peut être utilisé pour uploader n'importe quel fichier, tandis que les achats sur Amazon MP3 peuvent y être transférés directement.

Amazon Cloud Player est pour sa part une extension du service Cloud Drive, qui permet de lire la musique stockée en ligne, soit depuis un navigateur web, soit via une application Android dédiée.

Amazon Cloud Drive est proposé pour l'instant uniquement sur Amazon.com, mais il n'y a pas de filtre géographique, donc l'espace de stockage est accessible depuis la France (il est même possible de se connecter à Amazon.com avec des identifiants Amazon.fr). Cloud Player dispose par contre pour l'instant d'un filtre géographique.

MàJ le 31/03/2011 à 0h35 : Les industriels de la musique n'apprécient visiblement pas ce nouveau service lancé par Amazon. Sony Music reproche par exemple à Amazon de ne pas lui avoir demandé son accord pour la diffusion en streaming, et se dit prêt à "prendre toutes les mesures légales nécessaires". Une réaction à laquelle Amazon répond que Cloud Player permet uniquement à ses utilisateurs d'écouteur leur propre musique, et est donc à mettre au même plan que n'importe quel autre logiciel de lecture de musique lisant le contenu d'un disque dur externe. Amazon considère donc ne pas avoir besoin d'autorisation particulière des ayant-droits pour assurer ce service.

Actu originale : 30/03/2011 à 8h31

Posté par Matt le 31/03/2011 à 00h38

Aucun commentaire

Source : Génération NT

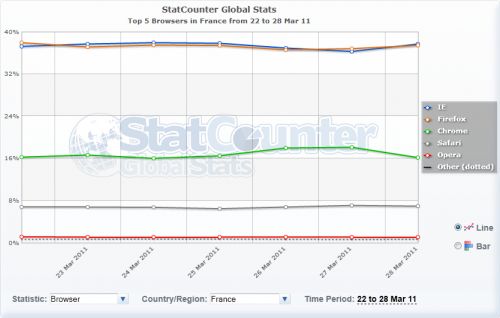

En début d'année, Firefox devenait le navigateur le plus utilisé en Europe, mais restait à l'époque seulement le second en France. Selon les chiffres de StatCounter, ce ne serait plus le cas depuis quelques jours.

En effet, les deux navigateurs sont au coude à coude depuis une grosse semaine, à environ 37-38% de parts de marché, et Firefox est déjà passé pour la première fois et à deux reprises devant le navigateur de Microsoft (le 22 et le 27), lui permettant d'atteindre une quasi égalité sur 7 jours (37.33% pour IE, 37.24% pour Firefox). Avec les très bons chiffres des téléchargements de Firefox 4, il y a fort à parier que cette tendance se confirme et que Firefox 4 passe pour de bon devant Internet Explorer.

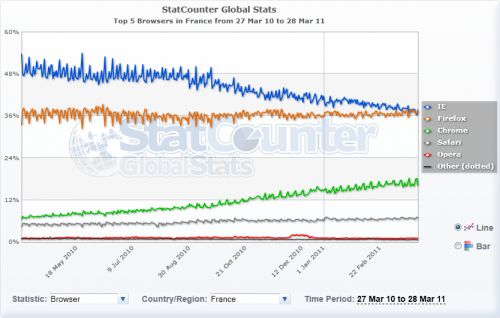

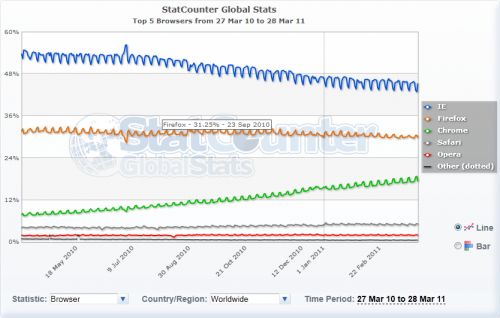

La fondation Mozilla ne pourra toutefois pas trop se venter d'avoir réussi à détrôner Microsoft sur le marché des navigateurs. En effet, si Firefox est le premier à dépasser Internet Explorer depuis de nombreuses années, il le doit avant tout au succès de Chrome ! Il suffit de regarder l'évolution des parts de marché sur un an pour s'en convaincre : celle de Firefox est quasiment stable, tandis que celles d'Internet Explorer et de Chrome suivent deux courbes opposées... Du premier au 28 mars 2010, IE atteignait 49.42% du marché, Firefox 36.53% et Chrome 6.71%, tandis que sur la même période en 2011 IE tombe à 37.98% (-11.44pts), Firefox "monte" à 36.77% (+0.24pt) et Chrome bondi jusqu'à 16.75% (+10.04pts).

Au niveau mondial, Internet Explorer reste solidement installé en tête (45% en mars) avec une marge de 15 points sur Firefox (30%) et 28 points sur Chrome (17%), et c'est également Chrome qui est le principal responsable de la baisse d'IE : sur un an, IE a perdu 9 points, Firefox a perdu 1 point et Chrome a récupéré ces 10 points abandonnés par la concurrence. À ce rythme, il faudra encore plus d'un an avant de voir IE dépassé, et d'ici là, Chrome pourrait bien avoir dépassé Firefox !

Posté par Matt le 30/03/2011 à 14h08

Aucun commentaire

Source : Silicon.fr

![]()

Après avoir plutôt mal terminé l'année 2010, avec un niveau de recrutement d'abonnés très inférieur à celui de ses concurrents, Free débuterait très bien l'année 2011, boosté par le succès de son offre Freebox Révolution.

En effet, si les chiffres officiels ne sont pas encore disponibles, les informations communiquées par le directeur financier d'Iliad aux investisseurs du groupe laissent entendre que Free aurait représenté environ 40% des recrutements du 1er trimestre 2011, contre moins de 10% au 4ème trimestre 2010. Alice continuerait pour sa part à perdre des abonnés, mais même ainsi, le groupe Iliad serait largement en tête des recrutements.

Ces bons résultats devraient donner à Free de nouveaux arguments face aux investisseurs pour débloquer les fonds nécessaires au financement de ses grands projets : la couverture fibre et la construction du réseau 3G. À noter d'ailleurs que les nouvelles sont plutôt bonnes aussi de ce côté, puisque Free estime être en mesure d'atteindre 27% de couverture dès novembre 2011 dans le meilleur des cas et juin 2012 au pire.

Posté par Matt le 30/03/2011 à 12h30

Aucun commentaire

Source : Univers Freebox

... à condition de faire n'importe quoi ! En effet, les vidéos de Rémi Gaillard devraient d'ici peu totaliser le milliard de visionnage. Un score que seuls quatre artistes américains auraient atteint pour l'instant : Lady Gaga, Justin Bieber, Eminem et Rihanna. Belle performance donc pour le français !

Pour ceux qui ne le connaitraient pas encore, Rémi Gaillard est probablement le premier gros buzz du web français, avant même qu'on parle de "buzz" d'ailleurs, grâce à ses vidéos où il se met en scène en faisant n'importe quoi (son slogan : "C'est en faisant n'importe quoi qu'on devient n'importe qui"). On le retrouve par exemple à faire du vélo d'appartement en pleine rue, utiliser un tapis de caisse de supermarché comme tapis de course, jouer à Mario Kart dans la vraie vie (avec la police en bonus), s'incruster dans le rang de l'équipe de France de Volley pendant la marseillaise, ou encore à faire l'escargot sur une route en heure de pointe...

En un peu plus de dix ans et plus de 100 vidéos, Rémi Gaillard est donc devenu le français le plus vu sur Internet, tout en restant relativement discret dans les médias plus traditionnels, à tel point que cette activité qui était originellement un hobbie pour occuper ses journées de chômeur lui permet aujourd'hui de vivre, tout en se lançant dans des défis de plus en plus dingues grâce au sponsoring. C'est ainsi par exemple qu'il a eu l'occasion de tester une monoplace dans les rues de Montpellier (et là encore, la blague n'a visiblement pas été au goût de la maréchaussée) :

Vous pouvez retrouver toutes les vidéos de Rémi Gaillard sur son site nimportequi.com.

Posté par Matt le 30/03/2011 à 11h10

1 commentaire

Source : PCInpact

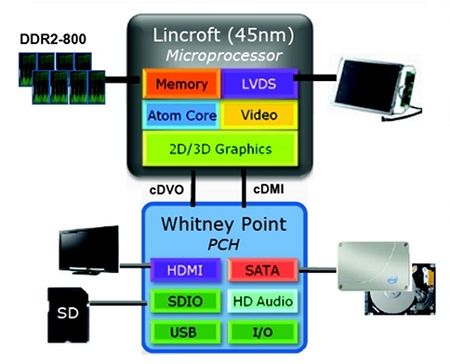

Présentée il y a bientôt un an, la plateforme Intel "Oak Trail", basée sur l'Atom, doit permettre à Intel d'entrer sérieusement sur le marché des tablettes, avec une plateforme x86 très basse consommation. Elle vient de faire son apparition dans la grille tarifaire du fondeur, donc ne devrait plus trop tarder.

Remplaçante de la plateforme Moorestown, Oak Trail se compose d'un processeur Atom Z670 "Lincroft" (1.5 GHz, mono-cœur, HyperThreading, 512 Ko de cache, contrôleur mémoire LPDDR/LPDDR2 intégré), intégrant un processeur graphique Intel GMA 600 (utilisant une architecture PowerVR SGX535), le tout couplé à un chipset SM35 (Whitney Point), descendant direct du MP20 "Langwell" de Moorestown. Ce dernier offrait des contrôleurs USB et ATA, un lecteur de cartes mémoire, un codec audio AC'97 et diverses fonctions de sécurité. SM35 y ajoute le support du SATA, un codec HD Audio et la prise en charge d'une sortie HDMI.

Proposée à 75 dollars, la plateforme Oak Trail risque toutefois d'avoir quelques difficultés à lutter contre les SoC à base de processeurs ARM, généralement bien moins onéreux. nVidia ne demande par exemple que 20$ pour son Tegra 2, le SoC star des tablettes Android de début 2011. Oak Trail aura tout de même l'avantage de pouvoir faire tourner Windows 7 (mais est-ce réellement un avantage pour une tablette ?) et pourrait peut-être aussi surpasser les solutions ARM en performance pure, mais il faudra attendre les premiers comparatifs de performances pour vérifier ce point.

Samsung, qui était déjà pressenti pour être le premier constructeur de smartphone à base de Moorestown jusqu'à l'abandon du projet, devrait être l'un des premiers constructeurs à proposer des tablettes Oak Trail, avec les 7-Series, une gamme de tablettes 10.1" 1366x768 sous Windows 7 Familiale Premium présentée en début d'année. Elles embarqueront 2 Go de RAM et 32 ou 64 Go de stockage et un clavier coulissant, pour un poids total inférieur à 1 kg et une autonomie de 9h. Le ticket d'entrée devrait être de près de 700$.

Posté par Matt le 29/03/2011 à 15h00

Aucun commentaire

Source : PCWorld

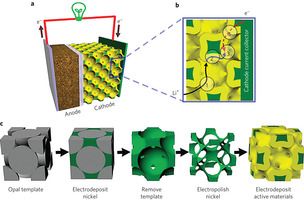

Tous les utilisateurs d'appareils mobiles le savent : la recharge des batteries est généralement une opération longue, qui fait perdre en mobilité, puisque l'appareil doit rester à proximité d'une prise électrique où brancher le chargeur, avec parfois un temps de charge supérieur à la durée d'utilisation... Une nouvelle technologie de batterie pourrait bientôt éliminer ces temps d'attente.

Pour ce faire, une équipe de chercheurs a mis au point un procédé de fabrication permettant de minimiser la distance que les électrons doivent parcourir pour passer de la cathode à l'anode. Cette minimisation est obtenue en partant d'un substrat de micro-billes (1.8µm) de polystyrène. Du nickel est injecté dans les interstices séparant ces billes, puis le polystyrène est retirée. La micro-structure de nickel ainsi obtenue est ensuite électro-polie pour l'"aérer", et les matérieux actifs de la batterie sont déposés sur cette micro-structure, formant ainsi une cathode offrant une énorme surface de contact dans un volume réduit, ce qui permet de mieux transférer les électrons.

Appliqué à des batteries Lithium-Ion, cette technique permet d'obtenir des batteries capables de récupérer 75% de charge en 1 minute et 90% de charge en 2 minutes, tandis qu'avec la technologie NiMH, ces temps diminuent respectivement à 2.7s et 20s ! De plus, la production de ces micro-structures serait relativement aisée, ce qui permet d'envisager un passage rapide à une production de masse.

Il reste toutefois un obstacle à la charge rapide : la puissance nécessaires pour les chargeurs. En effet, qui dit recharge rapide dit besoin d'une forte puissance d'alimentation. Pour recharger une batterie de smartphone de 4 Wh à 90% en 2 minutes, il faudrait en effet un chargeur de plus de 110W, soit la puissance d'un chargeur de gros ordinateur portable, tandis que pour charger en 2 minutes une batterie 60 Wh d'ordinateur portable, la puissance requise atteint plus de 1600W.

Posté par Matt le 29/03/2011 à 12h41

Aucun commentaire

Source : Tom's Hardware

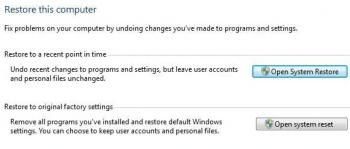

Si la stabilité et la fiabilité de Windows ont énormément progressé depuis l'époque peu glorieuse de Windows 95 et 98, il arrive encore que le système soit corrompu en profondeur pour diverses raisons, obligeant à une réinstallation complète. Windows 8 pourrait limiter le recours à cette solution.

En effet, les pré-versions de Windows 8 comporte de nouvelles fonctionnalités de restauration. Outre le système de restauration déjà présent actuellement dans Windows, qui permet de restaurer les programmes et paramètres systèmes tels qu'ils étaient à une date antérieure, sans toucher aux documents, une nouvelle fonction ferait son apparition pour réinitialiser complètement le système.

Le résultat de l'opération serait la suppression de toutes les applications installées et la restauration des paramètres de Windows, menant donc à un état quasi identique à celui d'une machine fraichement installée, seules les données utilisateurs étant éventuellement conservée (une option permettra de les effacer également). S'il faudra toujours réinstaller ses logiciels après l'opération, elle devrait s'effectuer bien plus vite qu'une réinstallation complète du système, et la procédure sera peut-être suffisamment bien faite pour conserver toutes les mises à jour du système.

Espérons également que Microsoft saura sécuriser convenablement cette opération. Les conséquences de son exploitation par un logiciel malicieux pourraient en effet être désastreuses.

Posté par Matt le 29/03/2011 à 10h50

Aucun commentaire

Source : PCInpact

![]()

Chaque année, le Google Summer of Code réunit de nombreux étudiants pour des stages rémunérés dans le domaine des solutions open-source. Pour l'édition 2011, la Document Foundation, qui gère le projet LibreOffice, sera de la partie avec une petit quarantaine de projets.

Dans cette liste, il en est un qui pourrait dont la concrétisation pourrait intéresser pas mal de monde : le portage de la suite bureautique LibreOffice sur Android. En effet, si Android pouvait bien se passer d'une suite bureautique tant qu'il était limité aux smartphones, le système de Google va cette année se retrouver dans bon nombre de tablettes et de netbooks.

Avec des grands écrans, voir des claviers, l'intérêt d'une suite bureautique devient plus marqué. Asus a d'ailleurs développé une suite bureautique basique pour ses Eee Pad. Un portage de LibreOffice pourrait donc être très intéressant, en apportant sur Android une suite bureautique réputée, et gérant différents formats de fichiers, dont le standard OpenDocument.

On notera également qu'un autre projet évoque le portage de l'interface graphique de la suite en HTML5 / Canvas, ce qui permettrait de créer une version en ligne de LibreOffice. Le sujet précise que le but de cette version en ligne serait notamment une utilisation sur des tablettes.

Les autres sujets portent essentiellement sur l'ajout de nouvelles fonctionnalités (11 sujets), le support de nouveaux formats de fichiers en lecture et en écriture (8 sujets) ou encore l'optimisation de la suite bureautique, avec un sujet portant sur la traque et le colmatage des fuites mémoire, ou encore l'uniformisation et la modernisation de l'interface graphique.

Posté par Matt le 29/03/2011 à 08h28

Aucun commentaire

Source : Silicon.fr

Baidu, vous connaissez ? Il s'agit d'un moteur de recherche chinois, très populaire dans son pays et dans quelques autres pays utilisant une écriture par idéogrammes, qui revendiquait il y a quelques temps la place de numéro un de la recherche, en annonçant traiter plus de requêtes que Google. L'américain semble d'ailleurs être le modèle du chinois...

En effet, les fonctionnalités offertes par les deux moteurs sur leur cœur de métier sont très proche, Baidu ayant lui aussi lancé petit à petit des moteurs spécialisés (images, vidéos, blogs, actualités...), des services annexes (cartographie, traduction...). Mais la ressemblance ne s'arrête pas là ! En effet, Baidu a annoncé la semaine dernière qu'il préparait à se lancer sur le marché des OS mobiles, tandis qu'un navigateur Internet Baidu serait actuellement en phase de test !

Une concurrence qui pour l'instant ne vient pas vraiment empiéter sur les terres de Google, du fait de la différenciation linguistique, mais ceci pourrait bien ne pas durer, puisque le PDG de Baidu a également indiqué son intention de racheter quelques petits moteurs de recherche anglophones, pour élargir son marché.

Posté par Matt le 28/03/2011 à 23h11

Aucun commentaire

Source : Clubic

Ces derniers temps, on a parfois l'impression que les sociétés de droits d'auteurs et les majors sont en train de jouer à celui qui aura l'idée la plus stupide pour monétiser son catalogue d'œuvre... À ce petit jeu, la SABAM, équivalent belge de la SACEM, vient de marquer de gros points, en taxant les routiers !

En effet, la SABAM considère que la cabine du chauffeur est un lieu de travail (jusqu'ici, tout va bien), et qu'elle doit donc verser la redevance au titre de la sonorisation des lieux de travail, même sil le chauffeur se contente d'écouter la radio (qui verse déjà une redevance...) ou ses propres CD. Et ce malgré le fait que le chauffeur est généralement seul dans sa cabine, donc n'entre pas dans le cadre d'une diffusion à plusieurs personnes.

L'association regroupant les professionnels de la route belges, la Transport en Logistiek Vlaanderen a signé un accord avec la SABAM pour fixer les modalités de cette redevance. Elle sera perçue auprès de toutes les entreprises de transport de plus de 9 salariés, et calculée proportionnellement au nombre d'équivalents temps plein.

La SACEM va désormais devoir rivaliser d'ingéniosité pour trouver une taxe plus idiote. Pourquoi pas une taxe sur les prothèses auditives, qui permettent d'écouter des œuvres protégées ?

Posté par Matt le 28/03/2011 à 22h49

1 commentaire

Source : Numerama

Alors que la fibre optique prend son temps pour se développer en France, une autre technologie pourrait venir la concurrencer pour l'accès Internet à très haut débit : le VDSL2+. Cette technologie pourrait en effet bientôt être proposée sur le réseau téléphonique français.

Autorisée pour l'instant uniquement sur des réseaux non connectés au réseau téléphonique, en raison des perturbations que le VDSL2+ pourrait engendrer sur les autres services, cette technologie permet de véhiculer sur une ligne téléphonique des flux pouvant atteindre 100 Mbit/s en download en mode asymétrique, ou encore 50 Mbit/s en download et en upload en mode symétrique.

Pour atteindre de tels débits, il faut toutefois une ligne de bonne qualité et de faible longueur : les 100 Mbit/s ne sont atteints que sur 500m, tandis qu'au delà de 1500m les débits sont équivalents à ceux de l'ADSL2+. Le VDSL2+ pourrait donc constituer une alternative à la fibre dans les zones denses, où on trouve beaucoup de lignes de moins de 1000m.

Selon des rumeurs de plus en plus nombreuses, y compris sur certains canaux officiels, dont le Twitter de Free, le VDSL2+ pourrait être autorisé sur le réseau français avant la fin de l'année. Rappelons d'ailleurs que la Freebox Révolution est équipée d'un chipset réseau Broadcom compatible VDSL2+. La prochaine LiveBox d'Orange, prévue pour 2012, pourrait également être compatible.

Posté par Matt le 28/03/2011 à 22h22

Aucun commentaire

Source : Freenews

Le Parlement Européen travaille actuellement à un projet de loi encadrant le commerce dans l'Union Européenne, et en particulier les ventes en ligne. Bonne nouvelle, les nouveaux textes sont plutôt en faveur du consommateur.

Parmi les nouvelles mesures proposées par ce texte, on notera par exemple :

- augmentation du délai de rétractation pour les ventes en lignes, qui passera à 14 jours pour effectuer la demande de rétractation, puis encore 14 jours de délai pour le renvoi du produit et 14 jours de délai de remboursement. Ce droit de rétractation s'appliquera aussi aux ventes aux enchères quand le vendeur est un professionnel. Par ailleurs, si le commerçant n'informe pas l'acheteur de ce droit de rétractation, le délai pourrait être porté à 3 mois, voir un an. En France, le délai de rétractation est actuellement de 7 jours.

- délai de livraison de 30 jours. Passé ce délai, le commerçant ne pourra refuser l'annulation de la commande.

- interdiction des options en "opt-out". C'est souvent le cas des assurances facultatives pour les ventes en ligne, elles sont activées par défaut et l'acheteur doit les supprimer manuellement.

- remboursement des frais de retour. En cas de rétractation, les frais de retour seront à la charge du revendeur pour tous les objets de valeur supérieure à 40€. Actuellement, en France, ces frais sont quasiment toujours à la charge de l'acheteur.

- rétractation pour les ventes par téléchargement : l'acheteur pourra se rétracter tant qu'il n'a pas téléchargé le produit acheté.

Avant d'entrer en application, ce texte doit tout de même encore être validé par le Parlement Européen, la Commission Européenne et le Conseil de l'Europe, puis être retranscrit dans le droit national.

Posté par Matt le 28/03/2011 à 09h01

Aucun commentaire

Source : PCInpact

Très populaire aux États-Unis jusqu'à sa fermeture fin 2010, le réseau P2P Limewire est actuellement trainé en justice par les industriels de la musique. Les majors sont toutefois très gourmandes, à tel point que le juge en charge du dossier à rejeté leurs demandes !

En effet, le dédommagement réclamé par les industriels de la musique à l'éditeur de Limewire sont compris dans une fourchette allant de 400 milliards de dollars à 75 mille milliards de dollars. Rien que ça...

Pour se donner une idée de l'ordre de grandeur de ces valeurs, la valeur minimale est du même ordre de grandeur que les revenus des principaux pays pétroliers, tandis que la fourchette haute dépasse largement le PIB cumulé de tous les pays de la planète ! En d'autres termes, avec une telle somme, l'industrie de la musique pourrait acheter l'ensemble de la production mondiale de biens et de services pendant plus d'un an !

Il est donc évident que ces montants sont sans commune mesure avec le préjudice réellement subi, et on comprend donc bien pourquoi le juge à rejeté la demande.

Posté par Matt le 27/03/2011 à 20h30

Aucun commentaire

Source : Macbidouille

Depuis que Google a lancé son système d'exploitation mobile Android, celui-ci a toujours été open-source, laissant ainsi à tout un chacun, et en particulier aux constructeurs, la possibilité de le modifier et de l'adapter à ses besoins spécifiques. Avec Android 3.0 Honeycomb, la donne change quelque peu...

En effet, cette version ayant été développée spécifiquement pour les tablettes tactiles, Google n'a pas pris le temps d'optimiser son fonctionnement sur d'autres types d'appareils, et en particulier les smarpthones. Le géant d'Internet ne souhaite donc pas voir Android 3.0 sur des smartphones dans l'immédiat, et, pour éviter que des constructeurs puissent l'adapter à de tels appareils, Google a décidé de ne pas publier le code source pour l'instant.

Google promet toutefois que le code source sera mis à disposition plus tard, mais sans donner la moindre précision sur la date. Espérons que cette publication ne tardera pas trop, sans quoi Android pourrait perdre définitivement son image de liberté...

Posté par Matt le 27/03/2011 à 19h00

Aucun commentaire

Source : Numerama

![]()

Le français Wysips (What you see is photovoltaic surface), spécialiste des capteurs solaires photovoltaïques, vient de présenter un projet original, qui pourrait peut-être un jour équiper les smartphones : un capteur photovoltaïque parfaitement transparent et d'à peine un dixième de millimètre d'épaisseur.

Sa transparence et sa finesse lui permettrait d'être utilisé pour couvrir l'écran, sans trop altérer sa lisibilité (il y a tout de même une légère chute de luminosité), et permettre ainsi de recharger légèrement la batterie lorsque l'appareil est exposé à la lumière. Selon la société, six heures d'exposition seraient suffisante à recharger totalement la batterie d'un smartphone classique, et la lumière reçue en usage courant pourrait suffire à couvrir tous les besoin en énergie de l'appareil.

Si le concept est intéressant d'un point de vue pratique, on peut toutefois se poser des questions sur son intérêt écologique : vu la faible quantité d'énergie récupérée (forcément, un smartphone ne passe pas sa vie en plein Soleil), les coûts énergétiques liés à la fabrication de ces capteurs pourraient bien ne pas être couverts.

Ce type de capteur seraient peut-être plus utiles pour des panneaux de grande taille : leur transparence permettrait de les utiliser sans sacrifier l'esthétique, par exemple sur les façades vitrées des immeubles de bureau ou sur les carrosseries des voitures hybrides et électriques.

Posté par Matt le 25/03/2011 à 17h00

8 commentaires

Source : French iPhone

![]()

Depuis plusieurs années, les tarifs de terminaison d'appel des opérateurs mobiles (c'est-à-dire le tarif qu'un opérateur facture à un autre opérateur pour les appels entrants dans son réseau) sont plafonnés par l'ARCEP. Ces tarifs devraient fortement diminuer dans les prochains mois...

En effet, l'ARCEP a notifié la Commission Européenne des nouveaux tarifs qu'elle souhaite mettre en place pour la période du 1er juillet 2011 au 31 décembre 2013. Actuellement, ce tarif est de 3 cts/min pour Orange et SFR et 3.4 cts/min pour Bouygues Telecom. Si le plan de l'ARCEP est validé, ce tarif serait unifié au 1er juillet 2011, avec 2cts/min pour tout le monde.

Au 1er janvier 2012, ce tarif baisserait de 25%, pour atteindre 1.5 cts/min, puis une nouvelle baisse de 0.5 cts/min interviendrait au 1er juillet 2012. Enfin, le tarif passera à 0.8 cts/min le 1er janvier 2013. Au total, la baisse atteindra donc environ 75% en moins de deux ans. L'ARCEP n'a pas évoqué le tarif maximal qui sera autorisé pour Free Mobile, dans la mesure ou son service n'est pas ouvert à ce jour, mais il y a des chances qu'il soit similaire, avec peut-être un petit bonus pour faciliter son entrée sur le marché (tout comme Bouygues a bénéficié jusqu'à aujourd'hui d'un tarif un peu plus élevé).

Cette décision devrait mener à des forfaits offrant un plus gros crédit de communication pour le même prix, voir à la multiplication des offres illimitées vers les mobiles. Elle devrait aussi beaucoup arranger Free. On se souviendra des interviews de Xavier Niel peu après l'annonce de l'offre Freebox Revolution, où le dirigeant de Free indiquait espérer une forte baisse des tarifs des terminaisons mobiles... Selon certains analystes, l'économie pour Free pourrait dépasser la dizaine de millions d'euros par an.

Posté par Matt le 25/03/2011 à 14h40

Aucun commentaire

Source : Génération NT

En attendant que les licences 4G soient attribuées officiellement, Orange, SFR et Bouygues ont été autorisés à tester la technologie LTE, retenue pour la 4G en France. Malheureusement, tout ne se passe pas aussi bien qu'espéré...

En effet, les premières expérimentations ont provoqué des perturbations de la TNT. Dans le pire des cas, certains foyers perdaient totalement le signal TV. Bien que la 4G et la TNT utilisent des fréquences différentes, certains canaux TNT sont dans des gammes relativement proches de celles des antennes LTE, et ce sont ces canaux qui seraient les plus perturbés.

Selon les opérateurs, leurs équipements de test ne seraient pas en cause. Ils expliquent en effet que les antennes-relais 4G n'interfèrent pas sur des fréquences autres que celles auxquelles elles sont censés fonctionner. Pour expliquer ces problèmes, les opérateurs pointent donc du doigt les tuners TNT. Selon eux, certains modèles de piètre qualité ne filtreraient pas suffisamment le signal, et seraient donc sensibles à des signaux utilisant des fréquences relativement proches de celles des signaux TNT.

Espérons toutefois que ces problèmes ne retarderont pas le déploiement de la 4G en France, alors que nous sommes déjà en retard par rapport à certaines de nos voisins, ou de tels réseaux sont déjà exploités.

Posté par Matt le 25/03/2011 à 12h40

Aucun commentaire

Source : Freenews

C'est la bonne blague du jour ! Gearbox nous avais promis Duke Nukem Forever pour le 6 mai, et que cette fois-ci, c'était la bonne, avec plusieurs années de retard de développement et après plusieurs annulations du projet... Et voilà-t-y-pas que l'éditeur nous annonce finalement qu'il y aura du retard...

Que les fans de la finesse et de la classe de ce cher Duke se rassurent, il ne s'agirait cette fois que de cinq petites semaines de retard, la nouvelle date de sortie étant fixée au 10 juin.

Reste à voir si le jeu saura répondre aux attentes des fans, après une si longue période de promesses non tenues...

Posté par Matt le 25/03/2011 à 10h11

Aucun commentaire

Source : NoFrag

![]()

Attaqué par l'UFC-Que Choisir, Free a été condamné mardi par le Tribunal de Grande Instance de Paris, qui lui a ordonné de mettre un terme à certaines de ses pratiques et à réviser ses conditions générales de ventes pour en retirer certaines clauses considérées comme abusives.

Cette décision concernerait notamment les frais d'activation à perception différée, nom que Free a donné à la somme perçue lors de la résiliation d'un abonnement. Cette astuce leur permettait de considérer qu'il ne s'agit pas de frais de résiliation, et que cette somme reste donc due même en cas de résiliation suite à une modification unilatérale des conditions d'abonnement.

L'UFC-Que Choisir reprochait également à Free de présenter les modes de paiement de façon trompeuse pour pousser les clients à opter pour le prélèvement automatique. Les frais supplémentaires facturés par Free en cas de paiement par chèque ou carte bancaire ont par ailleurs été jugés illégaux par le tribunal, et Free devra donc cesser de les réclamer.

Free devra de plus verser 50 000€ de dommages et intérêts à l'UFC-Que Choisir.

Posté par Matt le 25/03/2011 à 08h52

Aucun commentaire

Source : Univers Freebox

Si les utilisateurs d'ordinateurs ont à peu près intégré les risques de sécurité auxquels ils s'exposent, même s'ils ne prennent pas forcément de mesures de protection, il n'en est pas de même des utilisateurs de smartphones, qui semblent ne pas avoir pris conscience que les smartphones sont bel et bien des petits ordinateurs...

En effet, selon une étude d'AVG, éditeur de solutions de sécurité, 89% des américains ignorent qu'ils manipulent parfois des informations confidentielles avec leur smartphones. Pire, 57% des utilisateurs considèrent que les fonctions de sécurité de leur appareil ne sont pas importantes et 91% des utilisateurs ne s'imaginent pas qu'une application pour smartphone peut être infectée par un malware permettant de récupérer des informations, y compris des identifiants bancaires ou des numéros de carte de crédit.

Plus de la moitié des utilisateurs (56%) ignorent également le risque d'usurpation d'identité qu'ils courent en ne déconnectant pas leurs applications de réseaux sociaux quand ils ne les utilisent pas. En cas de pertes ou de vol du terminal, un utilisateur indélicat aurait ainsi un accès complet au profil du propriétaire de l'appareil.

Enfin, si une large majorité (66%) utilise son smartphone à la fois à des fins personnelles et professionnelles, 28% ne sont pas conscient des risques que cette mixité induit pour le SI de l'entreprise...

Notons également qu'une étude menée par un hacker sur des téléphones d'occasion a également donné des résultats édifiants, le hacker ayant réussi à récupérer bon nombre d'informations "sensibles" sur ces appareils, et notamment des données bancaires, des e-mails, des identifiants de réseaux sociaux et des photos... Si vous décidez de revendre votre ancien téléphone, assurez vous bien de faire le ménage !

Posté par Matt le 24/03/2011 à 14h48

Aucun commentaire

Sources : Business Mobile et Clubic

![]()

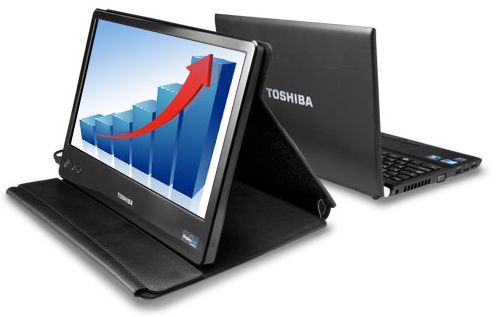

Toshiba a annoncé un nouveau périphérique plutôt original : un écran portable de 14", auto-alimenté par USB et utilisant la technologie DisplayLink, pour récupérer l'affichage via USB, en plus de son alimentation.

D'une résolution de 1366x768, il ne fait que 25mm d'épaisseur pour un poids de 1.27 kg, avec une un étui de protection intégré, qui fait également office de pied pour maintenir l'écran debout. Malheureusement, Toshiba n'y a pas intégré de connectique autre que l'USB. En l'absence de VGA ou de HDMI, il faudra donc se contenter des piètres performances du DisplayLink, qui excluent toute utilisation pour de la vidéo ou de la 3D.

Proposé à 200$, cet écran devrait surtout trouver son public auprès des professionnels, pour qui il permettra par exemple de faciliter certaines présentations, en permettant à plusieurs intervenants de consulter l'écran.

Posté par Matt le 24/03/2011 à 12h31

Aucun commentaire

Source : Le Journal du Geek via Ptit_bœuf

Une équipe de chercheurs anglais, menée par Krishna Palem, de l'Université de Rice propose une idée originale pour booster les performances des processeurs et réduire leur consommation électrique : les laisser faire des erreurs !

Et ils ne se contentent pas de l'affirmer, puisqu'ils ont réalisé une puce mettant en œuvre cette théorie : un DSP pour prothèse auditive. Grâce à leur astuce, la puce parvient à monter deux fois plus haut en fréquence, tout en consommant moitié moins que des DSP standard, et ce en introduisant un taux d'erreur de seulement 8%.

Ces performances s'expliquent en fait par la simplicité de la puce : une puce classique, garantissant un fonctionnement sans erreur, utilise énormément de transistors pour assurer le contrôle d'erreurs, ce qui augmente grandement la complexité de la puce, et donc sa consommation, tout en diminuant sa tenue aux hautes fréquences.

Bien entendu, de tels taux d'erreurs ne sont pas tolérables pour toutes les applications. Pour le calcul scientifique par exemple, il est important d'avoir une précision maximale. Mais selon les chercheurs, dans tous les domaines où la perception humaine entre en jeux, un tel taux d'erreur est tolérable, car imperceptible pour l'utilisateur. Cette astuce pourrait donc être utilisé dans les processeurs audio, mais aussi les GPU et les puces de traitement vidéo.

Cette idée est d'ailleurs assez proche de celle qui est utilisée en compression audio et vidéo, où les forts taux de compression sont atteints avec des compression dites destructrices, qui éliminent les détails les moins perceptibles par l'oreille ou l'œil humain.

Posté par Matt le 24/03/2011 à 10h11

3 commentaires

Source : Tom's Hardware

Après avoir été un des fidèles lieutenant de Steve Jobs pendant 22 ans, d'abord chez NeXT, puis chez Apple, le français Bertrand Serlet, qui occupait le poste de Senior Vice President OS X Software a annoncé qu'il allait prochainement quitter la pomme. Il était notamment en charge du développement de Mac OS X.

Après un passage à l'INRIA, Bertrand Serlet s'était expatrié aux États-Unis en 1985, pour rejoindre le Xerox PARC. Quatre ans plus tard, il a rejoint un autre français, Jean-Marie Hullot, chez NeXT, la société créé par Steve Jobs après son éviction d'Apple. Il y a a notamment travaillé sur les interfaces OpenStep et sur Interface Builder, le logiciel de conception d'interfaces graphiques, qui fait encore partie de l'environnement de développement sous OS X 20 ans plus tard.

Il rejoint ensuite Apple lors du rachat de NeXT en 1997, où il devient rapidement vice-président en charge de la plateforme technologique, et travaille au développement de Mac OS X, sous la houlette d'Avie Tevanian, créateur du micro-noyau Mach et vice-président en charge du développement de Mac OS X. Bertrans Serlet récupéra finalement ce poste en 2003, après la promotion de Tevanian au poste de directeur technique. Il n'avait plus quitté ce poste depuis.

Il sera remplacé par Craig Federighi, un autre ancien de NeXT, où il avait été à l'origine de WebObjects, mais qui avait quitté la société peu après son rachat par Apple, avant de revenir croquer la pomme en 2009 en tant que vice-président de l’ingénierie dans la division Mac OS.

Avec le départ de Serlet, c'est donc un personnage clé d'Apple qui quitte le navire, et on ne peut s'empêcher de se demander si ce départ n'est pas en rapport avec le fait qu'OS X tend de plus à plus à se fermer et à devenir un iOS pour ordinateur... La date de son départ est fixée au 1er avril (non, ce n'est pas un poisson), pile le jour des 35 ans d'Apple. Certains pensent d'ailleurs que cette date symbolique est un signe de protestation de la part de Serlet, tout comme lorsque Tevanian et Rubinstein avaient quitté Apple le 1er avril 2006, le jour de ses 30 ans. Officiellement, Serlet indique quitter Apple pour retourner dans le monde de la recherche, en travaillant plus sur la science que sur les produits.

Posté par Matt le 24/03/2011 à 09h10

Aucun commentaire

Source : MacGeneration

Maintenant que la version classique de Firefox 4 est disponible, c'est au tour de la version de faire l'actualité, avec l'arrivée de la première Release Candidate de Firefox 4 Mobile.

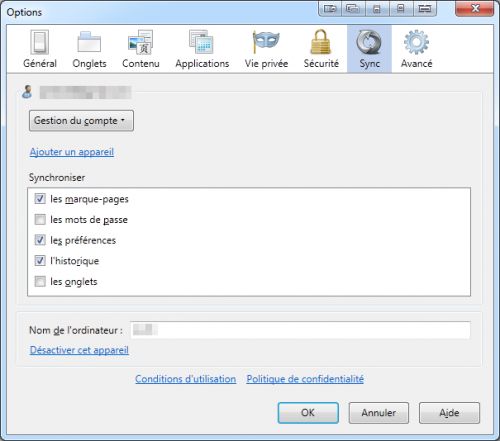

Utilisant le même moteur de rendu que la version classique, elle reprend aussi une partie de ses nouvelles fonctionnalités, en particulier Firefox Sync, qui simplifiera grandement la vie de ceux qui utilisent Firefox sur leur ordinateur et sur leur smartphone.

On retrouve aussi les performances améliorées, l'ajout d'extensions sans redémarrage, le meilleur support des normes récentes, etc... Des fonctions spécifiques à la version mobile font également leur apparition, comme par exemple une fonction de copier-coller pour faciliter la manipulation des formulaires et la séparation de l'interface et du rendu dans deux processus distincts.

Firefox 4 Mobile RC est disponible pour tous les appareils Android 2 et supérieur, via l'Android Market, ainsi que pour le Nokia N900 sous Maemo.

Posté par Matt le 23/03/2011 à 14h47

Aucun commentaire

Source : Business Mobile

![]()

Avec les GPS, on connaissait déjà la navigation guidée en mode automobile ou en mode piéton, mais dans les deux cas les logiciels de navigation se contentaient de proposer des itinéraires en extérieur. Avec Navteq Destinations Maps, la filiale de Nokia change la donne...

En effet, ce service vise à donner à l'utilisateur des informations de navigation en intérieur. Couvrant 200 centres commerciaux parmi les plus grands des USA, le service permet de localiser les ascenseurs, les escalators, les toilettes, les sorties de secours... Bref, tout le nécessaire pour aller passer son samedi dans ces temples de la consommation sans craindre de ne pas parvenir à en ressortir.

Le service sera disponible sur les principaux smartphones du marché, et sa couverture géographique s'étendra petit à petit au reste de l'Amérique du Nord, à l'Europe et à l'Asie.

Posté par Matt le 23/03/2011 à 12h40

Aucun commentaire

Source : Übergizmo

Lancée par Microsoft fin 2005, la Xbox 360 pourrait n'être qu'à la moitié de sa carrière. En effet, selon des sources internes de Microsoft, sa remplaçante pourrait n'arriver sur le marché qu'en 2015.

Si cette information se confirme, la durée de vie de la Xbox 360 serait un record pour une console, même si elle pourrait être rapidement rejointe par la PlayStation 3, à qui Sony avait également promis une durée de vie de l'ordre de la décennie. Même s'il ne s'agit là que d'une rumeur, cette information concorde avec une annonce de Microsoft, qui avait annoncé que l'interface Kinect donnerait encore 5 ans de durée de vie à la console.

Pour rappel, la première Xbox n'avait pour sa part eu droit qu'à quatre ans avant d'être remplacée par la Xbox 360. C'était la plus courte durée de vie parmi les consoles de sixième génération, la PlayStation 2 et Gamecube ayant respectivement duré 6 et 5 ans.

On notera également que nVidia, qui a déjà annoncé travailler sur les GPU des prochaines générations de consoles, a indiqué récemment voir bien plus d’opportunités pour son avenir dans le marché des mobiles que dans celui des consoles, qu'il trouve trop statique. Cette déclaration tendrait aussi à confirmer que la génération actuelle de console durera beaucoup plus longtemps que la précédente...

Posté par Matt le 23/03/2011 à 10h30

3 commentaires

Sources : Tom's Hardware et Gamepro

Annoncé et ouvert aux développeurs en janvier dernier, la boutique logicielle d'Amazon pour les terminaux Android a ouvert ses portes aujourd'hui, mais elle est pour l'instant réservée aux résidents américains.

Pour fêter l'occasion, Amazon attaque fort, avec une nouvelle version d'Angry Birds disponible en exclusivité sur l'App Store. Mieux, elle sera gratuite pendant une journée. Amazon promet par ailleurs qu'une application payante sera offerte gratuitement chaque jour. La boutique référence pour l'instant 3800 applications et est accessible soit via un simple navigateur Internet, soit via une application dédiée. Cette dernière offre de plus la possibilité de tester les applications pendant 30 minutes avant de décider ou non de les acheter.

Malheureusement pour Amazon, son arrivée sur ce nouveau marché ne se fait toutefois pas sans heurts. En effet, Apple n'a pas manqué de remarquer la similitude entre le nom de sa boutique (App Store) et celui de la boutique d'Amazon (Appstore), et la pomme a donc décidé d'attaquer Amazon, le nom App Store étant déposé. Attaqué pour le même motif, Microsoft s'était défendu en expliquant que le nom "App Store" est trop générique pour pouvoir être déposé... Nous verrons dans quelques mois si la justice ce range à cet avis.

Posté par Matt le 23/03/2011 à 09h11

Aucun commentaire

Sources : Übergizmo et Macbidouille

En lançant son Kindle il y a plus de trois ans, Amazon est devenu l'un des acteurs majeurs du livre numérique, tant du côté du matériel que du contenu. La librairie en ligne, qui a déjà beaucoup diversifié ses activités, envisagerait désormais de s'attaquer au marché des tablettes tactiles, avec un Kindle sous Android.

En effet, Amazon a publié cinq offres d'emploi pour des postes demandant une expérience professionnelle avec Android, tant dans le secteur logiciel que dans le matériel. Les analystes prévoyant une explosion du marché des tablettes tactiles en 2011, il ne serait donc pas surprenant que ces annonces soient en lien avec ce type de produit, d'autant que la hausse de leurs ventes pourrait impacter négativement les ventes de Kindle.

En lançant sa propre tablette, Amazon pourrait donc non seulement compenser l'éventuelle baisse des ventes du Kindle, mais aussi profiter de la renommé de sa marque Kindle pour se tailler une place de choix sur le marché des tablettes.

Rappelons également qu'Amazon a dévoilé il y a quelques temps l'Amazon AppStore, une boutique d'applications Android. Celle ci pourrait donc être en lien avec l'arrivée de produits Amazon basés sur Android.

Posté par Matt le 22/03/2011 à 14h20

Aucun commentaire

Source : Silicon.fr

Il y a quelques mois déjà, Mozilla avait annoncé son intention d'accélérer le rythme de sortie de Firefox, en passant à un rythme d'une version tous les trois à quatre mois. Malgré le retard de Firefox 4, Mozilla compte respecter ce nouveau rythme pour la version 5 de Firefox.

Passer à un rythme plus rapide semble en effet nécessaire de nos jours : l'époque où Firefox était la seule alternative crédible à Internet Explorer est largement révolue, et le monde des navigateurs Internet est aujourd'hui particulièrement concurrentiel et bouge très vite, principalement sous l'impulsion de Google, qui sort des nouvelles versions de Chrome à un rythme effréné.

C'est d'ailleurs des processus de développement de Google que Mozilla va s'inspirer pour accélérer le développement de Firefox. La fondation va en effet mettre en place un architecture à quatre niveaux : une branche "mozilla-central", qui remplacera les nightlies, une branche expérimentale, un peu plus stabilisée, une branche beta et une branche finale. Les fonctionnalités introduites et validées dans mozilla-central seront portées dans la version expérimentale au bout de six semaines, puis passeront en beta, et éventuellement en version finale si Mozilla valide définitivement ces fonctionnalités.

Ce nouveau processus de développement devrait apporter la souplesse et la réactivité nécessaire pour maintenir Firefox dans la bataille des navigateurs, face à Chrome et Opera qui ont déjà adopté un rythme de sorti rapide.

Posté par Matt le 22/03/2011 à 13h00

1 commentaire

Source : Tom's Guide

Depuis que la redevance copie privée a été instaurée, son montant est censé être évalué via des études d'usage, déterminant pour chaque support le manque à gagner résultant de son utilisation dans le cadre de la copie privée. Or, selon le SECIMAVI, ce manque à gagner serait aujourd'hui sur-estimé.

En effet, selon ce syndicat, qui regroupe les fabricants de matériel audio, vidéo et informatique, le nombre moyen d'œuvres licites stockées sur un disque dur multimédia aurait fortement baissé entre 2008 (étude Sofres en octobre) et 2010 (étude CSA en septembre). Pour la musique par exemple, ce nombre serait passé de 139 en 2008 à 38 en 2010, tandis que la vidéo serait passée de 15.2 à 12.9.

En estimant l'espace occupé par les fichiers, sur la base de 16 Ko/s pour l'audio et 130 Ko/s pour la vidéo, le SECIMAVI en déduit qu'entre les deux études, le volume de fichiers éligibles à la redevance copie privée est passé de 34.8 Go à 27.3 Go, alors que dans le même temps, la capacité moyenne des disques multimédias est passée de 90 Go à 251 Go. Ainsi, alors que 38.7% du disque était éligible à la redevance en 2008, il n'y aurait plus que 10.9% d'éligible aujourd'hui. Et sur les disques récents, atteignant des capacités de 500 Go à 2 To, le SEMICAVI considère que le taux d'occupation par des fichiers éligibles devient "ridiculement faible" (5.5% à 1.4%), alors que dans le même temps, de poids de la redevance dans le prix de vente explose, atteignant plus de 30% du prix sur certains modèles.

Partant de ce constat, le SEMICAVI réclame plusieurs évolutions de la redevance, pour l'adapter à la réalité des usages :

- maintien du plafonnement de la capacité dans les barèmes,

- diminution du plafond,

- utilisation du même barème pour les disques avec et sans entrée vidéo (le poids des enregistrements réalisés avec le disque étant négligeable),

- baisse du barème proportionnelle à la baisse d'usage (-73% pour l'audo, -15% pour la vidéo),

- plafonnement de la redevance à 8% du prix de vente des disques,

- suivi régulier des évolutions d'usages à venir.

Malheureusement, ce genre de proposition a peu de chances de s'imposer auprès de la Commission Copie Privée : les représentants des ayant-droits y ont autant de voix que les représentants des constructeurs et des consommateurs réunis, et le président de la Commission est dans le camp des ayant-droits...

Posté par Matt le 22/03/2011 à 10h51

Aucun commentaire

Source : PCInpact

Présentée par Apple et Intel fin février, l'interface Thunderbolt n'est pour l'instant présente que sur certains ordinateurs de la pomme. Elle pourrait toutefois bientôt arriver sur un nouveau portable Sony Vaio "hybride". Le constructeur préparerait également une nouvelle entrée de gamme Vaio, fonctionnant sous Chrome OS.

De référence encore inconnue, le Vaio Thunderbolt serait un ultra-portable très léger (1.13 kg) et autonome (8h) en sacrifiant le lecteur optique et la connectique, qui serait limité à une sortie HDMI, de l'USB et un port Thunderbolt, mais embarquant tout de même un processeur puissant, puisqu'il s'agirait d'un Core i7. Il pourra également se connecter sans-fil à un écran, via une interface Intel Wireless Display. L'intérêt du port Thunderbolt sur cette machine sera la possibilité d'y connecter un dock. Ce dernier embarquera notamment un lecteur Blu-Ray et une connectique enrichie, avec un port HDMI, un port VGA, un port Ethernet et quelques ports USB supplémentaires.

Pour l'entrée de gamme, c'est un netbook Vaio sous Chrome OS qui serait en préparation chez le nippon. Doté d'un écran 11.6" 1366x768, d'1 Go de RAM et de 16 Go de stockage flash eMMC, il s'appuiera sur la plateforme nVidia Tegra 2, star des tablettes Android de 2011. Une machine qui viendra donc concurrencer l'Eee PC sous Chrome OS d'Asus, même si le Vaio sera probablement positionné sur une tranche plus haut de gamme, comme d'habitude chez Sony.

Posté par Matt le 22/03/2011 à 08h51

Aucun commentaire

Source : Tom's Hardware

L'affaire avait fait grand bruit l'année dernière : dans une enquête sur Google Street View, la CNIL avait détecté que les Google Cars charger de prendre les rues en photo ne se contentaient pas de ce travail, puisqu'elles sniffaient aussi les réseaux Wi-Fi qu'elle croisait sur son chemin...

Officiellement, Google ne récupérait ces informations dans le but de compléter sa base de données de géolocalisation, pour qu'elle puisse fournir une position la plus précise possible via une triangulation Wi-Fi pour les appareils non dotés de puce GPS. La CNIL a alors exigé que Google lui communique l'intégralité des données capturées, afin de pouvoir les contrôler de manières plus poussée.

Surprise, la CNIL a constaté que Google capturait des trames réseau complètes. Sur un réseau non chiffré, ces trames pouvaient contenir de nombreuses informations personnelles : identifiants et mots de passe de sites web et de messagerie, adresse e-mail, contenus de certains e-mail, parfois avec des contenus "sensibles" (santé, orientation sexuelle...). Depuis, Google a cessé de collecter ces données avec les Google Cars et s'est défendu en expliquant que les données de ces captures n'ont pas été utilisées et qu'elles résultaient d'un bug de leur logiciel, normalement destiné à récupérer uniquement les noms des réseaux Wi-Fi et les adresses MAC des points d'accès.

Malgré cette défense, la CNIL a finalement décidé de condamner Google à 100 000 euros d'amende. Une décision que la CNIL justifie par quatre raisons :

- le manque de collaboration de Google, qui refuse de fournir le logiciel incriminé, empêchant donc à la CNIL de constater si les captures résultaient vraiment d'un bug,

- le fait que Google continue à collecter certaines données (identifiants des points d'accès Wi-Fi) à l'insu de leurs propriétaires, via les utilisateurs du service Google Latitude sur les terminaux mobiles,

- le fait que Google Latitude contrevient à la loi française, en n'ayant pas été déclaré à la CNIL,

- le fait que Google a tiré un avantage économique d'une partie des données collectées, qui lui ont permis de devenir l'acteur dominant du marché de la géolocalisation.

Malheureusement, vu le chiffre d'affaire de Google, il n'est pas sûr qu'une amende de 100 000€ joue un effet très dissuasif à l'avenir...

Posté par Matt le 21/03/2011 à 23h10

Aucun commentaire

Source : Clubic

Alors que les analystes estiment que le marché des SSD devraient continuer à connaitre une forte croissance en 2011, certains évoquant des chiffres supérieurs à 90%, les constructeur de SSD fourbissent leurs armes pour se faire leur place sur le marché 2011.

Ainsi, après le lancement officiel des nouveaux contrôleurs SandForce il y a quelques semaines, c'est au tour de Micron de lancer sur le marché son RealSSD C400. Successeur du RealSSD C300, qui était vendu sous la marque Crucial (filiale de Micron), le C400 embarque le contrôleur Marvell 88SS9174 de seconde génération (BKK2), à la place du contrôleur de première génération (BJP2). Doté de mémoire Flash IMFT 25nm, de 128 Mo de cache DDR3 et d'une interface SATA 6 Gbit/s, il promet des débits de 415 Mo/s en lecture séquentielle et 260 Mo/s en écriture séquentielle, pour 40 000 IOPS en lecture aléatoire et 50 000 IOPS en écriture aléatoire.

Disponible immédiatement au Japon et aux USA, il y est proposé au format 2.5" (une version 1.8" arrivera plus tard) avec des capacités de 64 Go (130$), 128 Go (245$), 256 Go (445$) et 512 Go (920$).

Côté Intel, c'est les SSD 320 Series qui sont en approche. Après les SSD 510 Series, lancés en début de mois, qui utilisent eux aussi le contrôleur Marvell, les SSD 320 Series sont considérés comme les "vrais" nouveaux SSD Intel, puisqu'ils sont basés sur un contrôleur maison. Évolution du contrôleur des X25-M, ce nouveau contrôleur restera en SATA 3 Gbit/s et exploitera de la mémoire flash 25nm, probablement aussi d'origine IMFT. En raison de la "vieille" interface SATA, le débit en lecture séquentielle ne progressera pas (250 Mo/s), limité par l'interface, tandis que le débit en écriture séquentielle pourra faire un gros bon en avant, en montant à 170 Mo/s, soit environ le double des X25-M actuels. En aléatoire, Intel promet 39 500 IOPS en lecture et 23 000 IOPS en écriture.

La gamme SSD 320 Series comportera six capacités, avec des tarifs aux environs de 2$ le Go, sauf sur l'entrée de gamme, nettement plus chère : 40 Go (110$), 80 Go (190$), 120 Go (240$), 160 Go (330$), 300 Go (570$) et 600 Go (1120$).

Posté par Matt le 21/03/2011 à 22h50

Aucun commentaire

Sources : BHMag et Clubic

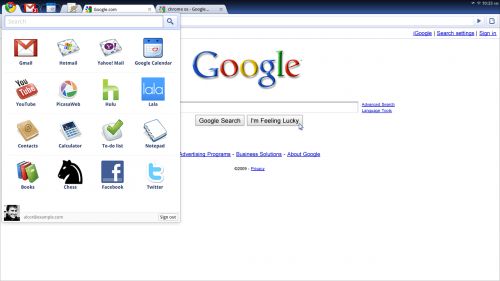

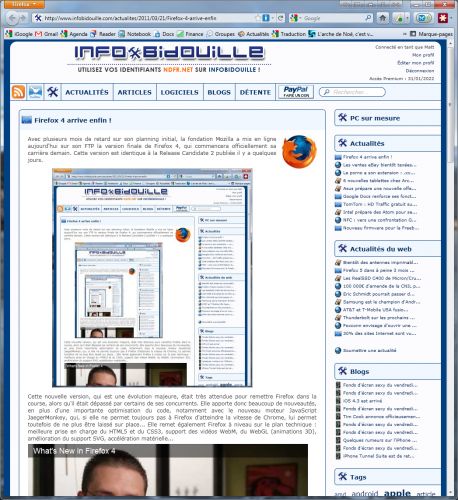

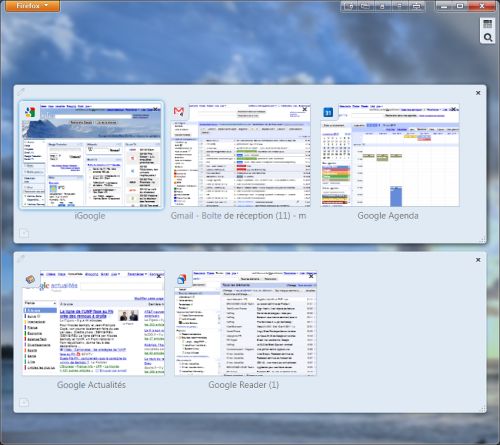

Avec plusieurs mois de retard sur son planning initial, la fondation Mozilla a mis en ligne aujourd'hui sur son FTP la version finale de Firefox 4, qui commencera officiellement sa carrière demain. Cette version est identique à la Release Candidate 2 publiée il y a quelques jours.

Cette nouvelle version, qui est une évolution majeure, était très attendue pour remettre Firefox dans la course, alors qu'il était dépassé par certains de ses concurrents. Elle apporte donc beaucoup de nouveautés, en plus d'une importante optimisation du code, notamment avec le nouveau moteur JavaScript JaegerMonkey, qui, si elle ne permet toujours pas à Firefox d'atteindre la vitesse de Chrome, lui permet toutefois de ne plus être laissé sur place... Elle remet également Firefox à niveau sur le plan technique : meilleure prise en charge du HTML5 et du CSS3, support des vidéos WebM, du WebGL (animations 3D), amélioration du support SVG, accélération matérielle...

L'évolution la plus visible est la nouvelle interface du navigateur. Le barre de menu est désormais masquée par défaut, pour gagner un peu en hauteur. Elle laisse sa place à un unique menu "Firefox" dans la barre de titre, regroupant les fonctions les plus importantes. La barre des modules disparait également, toujours pour gagner de la place en hauteur, tandis que le barre des onglets se repositionne au dessus de la barre d'adresses (mais elle peut être remise à sa position classique).

Les onglets peuvent désormais être épinglés, ce qui les réduits à une petite icône sur la gauche de la barre d'onglet. Pratique pour ne pas trop encombrer cette barre avec les onglets qui restent ouvert en permanence en tâche de fond, comme un webmail ou un lecteur de flux RSS. Ces onglets épinglés réapparaissent aussi lors de la réouverture du navigateur. Toujours pour réduire l'encombrement de cette barre, Firefox 4 introduit la notion de "Groupes d'onglet", assez similaire au principe des bureaux virtuels. Elle permet de définir des sous-ensembles d'onglet et, en passant d'un sous-ensemble à un autre, seuls les onglets du sous-ensemble sélectionné s'affichent dans la barre d'onglets.

Le gestionnaire d'extensions est également revu. Il s'intègre désormais dans un onglet, et non plus une fenêtre dédiée, et bénéficie d'une interface plus claire, permettant de trouver plus facilement son bonheur. Le nouveau framework Jetpack permettra par ailleurs l'arrivée d'une nouvelle génération d'extensions installables sans redémarrer le navigateur. L’ancien framework reste supporté, et bon nombres d'anciennes extensions sont d'ores et déjà compatibles, mais ces extensions "à l'ancienne" nécessiteront toujours le redémarrage.

Firefox Sync fait désormais partie intégrante du navigateur. Concurrent d'extensions telles que Xmarks ou LastPass, Firefox Sync permet la synchronisation des marque-pages, des mots de passe, des préférences, de l'historique et des onglets ouverts entre plusieurs instances de Firefox. Pratique pour ceux qui ont plusieurs ordinateurs.

Enfin, Firefox 4 propose la nouvelle option "Do Not Track", qui permet d'ajouter aux en-têtes des requêtes du navigateur un indicateur pour signaler aux sites que vous ne souhaitez pas être tracé, par exemple par les régies publicitaires. Encore faudra-t-il que cette en-tête soit prise en compte par les serveurs distants...

Posté par Matt le 21/03/2011 à 22h00

Aucun commentaire

Source : Génération NT

Voici revenu un sujet récurrent en matière de fiscalité : la taxation des ventes de biens entre particuliers sur Internet... Un sujet régulièrement évoqué par les législateurs, mais sans qu'il n'y ait jamais eu de décision. Une fois de plus, il est d'actualité, "grâce" à deux députés UMP : Bruno Bourg-Broc et Martine Aurillac.

Tous deux ont en effet adressé une question écrite au gouvernement, et plus précisément au ministre du Travail, qui a renvoyé la balle au ministre de l'Économie et des finances. La première évoque le cas des particuliers qui achètent des produits en mauvais état, les réparent et les revendent sur Internet, tandis que la première s'attaque aux particuliers qui achètent des produits en lots pour les revendre à l'unité.

Dans les deux cas, les députés s'attaquent au fait que ces reventes se font sans déclarations, ce qui serait selon eux une concurrence déloyale vis à vis des professionnels, mais aussi une perte de recette fiscales. Les deux députés appellent donc le gouvernement à prendre des mesures pour freiner ce marché gris.

La dernière fois que la question avait été évoquée, le Secrétariat à l'Économie Numérique, à qui elle avait été posée, avait répondu de façon très vague, indiquant que les particuliers "dont les activités commerciales dépassent le cadre de la vie courante" doivent le déclarer comme activité commerciale et s'enregistrer auprès du registre du commerce, faute de quoi ils risquent jusqu'à 3 ans de prison et 45 000 euros d'amende. Le SEN n'avait pas précisé dans quelle limite l'activité est considérée comme étant dans le cadre de la vie courante.

Posté par Matt le 21/03/2011 à 08h31

2 commentaires

Source : Numerama

Prévu depuis plus de cinq ans mais jamais validé par l'ICANN (Internet Corporation for Assigned Names and Numbers, l'organisme qui gère l'espace de nommage des sites Internet et l'attribution des adresses IP), l'extension de domaine .xxx, destinée aux sites pornographiques a finalement été acceptée par l'ICANN.

Le but de l'introduction de cette extension est d'améliorer la sécurité des transactions, en limitant les usurpations, mais aussi d'améliorer le filtrage, et en particulier le contrôle parental. ICM, qui administre le registre .xxx, indique aussi que l'adoption d'un tel nom de domaine sera un bon moyens pour les acteurs de l'industrie du porno d'améliorer leur image, en montrant qu'ils assument bien leurs responsabilités.

Ce registre sera de plus réglementé par l'IFFOR (International Foundation For Online Responsibility), un groupe à but non lucratif composé de représentants de la protection de l'enfance, d'experts informatiques, de défenseurs de la liberté d'expression et de représentants de l'industrie du porno. L'IFFOR veillera notamment à ce que cette extension ne soit utilisée qu'à des sites rattachés officiellement à l'industrie du porno. Le fonctionnement de l'IFFOR sera financé directement par les titulaires de domaines en .xxx, qui verseront une contribution annuelle de 10$ par domaine, en plus de 60$ annuels facturés par ICM pour l'enregistrement du domaine.

Malgré les réticences de l'industrie du porno, qui craignait qu'une identification trop claire des sites pornographique ne soit pas bonne pour leurs affaires, ICM a déjà enregistré plus de 280 000 réservations de domaines en .xxx.

Posté par Matt le 20/03/2011 à 20h30

Aucun commentaire

Source : PCInpact

Grâce au succès de ses tablettes, le français Archos a réussi une excellente année 2010, avec un chiffre d'affaire en hausse de 44% et un déficit en baisse de 88%. Pour continuer sur cette dynamique, le constructeur va lancer en juin sa neuvième génération de tablettes tactiles.

Archos ayant lancé il y a peu sa marque low-cost Arnova, ces nouvelles tablettes sous Android seront probablement positionnées un peu plus haut de gamme, comme le laissent entendre des premières informations sur les spécifications. On parle notamment d'un processeur ARM Cortex A9 double cœur à 1.6 GHz, annoncé comme le plus puissant du marché. À titre de comparaison, la plupart des tablettes de dernière génération sont basées sur des processeurs A9 double-cœur fonctionnant entre 1 et 1.2 GHz.

Les six nouvelles tablettes, dont les tailles d'écran iront de 5 à 10", utiliseront également un nouveau châssis à base de métal et de plastique et embarqueront un modem 3G, ce qui devrait permettre de les trouver à bon prix chez les opérateurs mobiles, en contrepartie d'un forfait 3G. Il faudra par contre se contenter de disques durs, Archos préférant privilégier la capacité et le prix plutôt que la performance.

Enfin, le constructeurs a annoncé qu'en plus de ces nouvelles tablettes, il allait diversifier son activité en lançant des "gadgets pour la maison", alors qu'il se limitait jusqu'à présent aux tablettes et baladeurs, sans toutefois préciser leur nature exacte.

Posté par Matt le 20/03/2011 à 18h30

Aucun commentaire

Source : Tom's Guide

Après avoir connu un grand succès avec la vague des netbooks en 2009, la gamme Eee PC d'Asus a depuis marqué le pas, à cause de la chute du marché des netbooks, résultant de l'arrivée des tablettes et de la hausse des prix des netbooks liée à un équipement de plus en plus complet. Mais Asus ne s'avoue pas vaincu !

En effet, le taiwanais s'apprêterait à lancer une nouvelle gamme de netbooks à bas prix. Dotés de processeurs Atom et d'écrans de 10 à 11", ces nouveaux Eee PC fonctionneront sous Google Chrome OS. Les tarifs seront particulièrement agressifs, les rumeurs évoquant à peine 200 à 250$. Asus devrait de plus commercialiser ces Eee PC via des opérateurs mobiles. Associés à des forfaits clé 3G, ces Eee PC pourraient bénéficier d'une subvention ramenant leur prix à un tarif symbolique.

Reste à voir si Chrome OS saura se trouver un public. En effet, malgré les tarifs très faibles des machines, Chrome OS reste un OS nettement plus limité qu'un OS classique, ce qui pourrait mettre un frein aux ventes.

Posté par Matt le 18/03/2011 à 13h00

Aucun commentaire

Source : Übergizmo

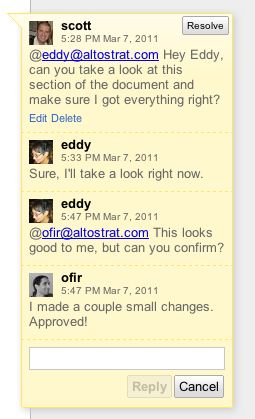

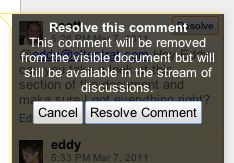

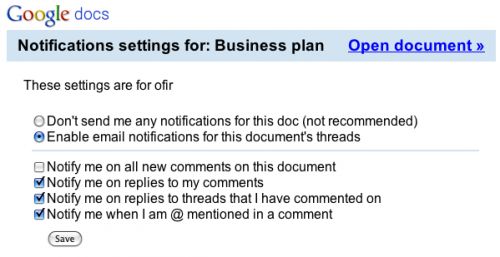

Dès son lancement, Google Docs, la suite bureautique en ligne de Google, a mis l'accent sur le travail collaboratif. Mais depuis, ces fonctionnalités ont peu évolué, et étaient devenues quelque peu obsolète. Google vient donc de dépoussiéré l'une des fonctions essentielles au travail collaboratif : les fonctionnalité de discussion.

Le but : fournir un outil de discussion plus puissant, plus complet et plus simple à utiliser. Ainsi, les commentaires sont désormais éditables par leurs auteurs et datés, tandis que les avatars font leur apparition dans les fils de discussion, facilitant identification des intervenants.

Les commentaires pourront désormais aussi être utilisé pour traiter des demandes de modification, grâce à une fonction permettant de "résoudre" un commentaire, ce qui consiste à le masquer une fois qu'il a été pris en compte. Il restera accessible dans les détails de la discussion, et pourra être ré-ouvert si la solution mise en œuvre n'a pas été satisfaisante.

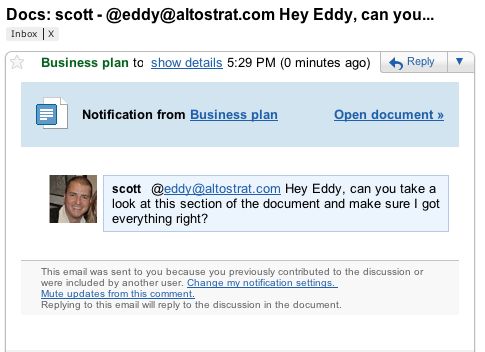

Enfin, Google a implémenté un système de notification au niveau de ceux des principaux outils professionnels de discussion collaborative, grâce à la possibilité de s'adresser directement à un intervenant dans un commentaire, en mentionnant son identifiant ou son adresse e-mail, ce qui aura pour effet de le notifier par mail.

Avec ces nouvelles fonctionnalités, Google confirme donc sa volonté de venir chasser sur les terres des spécialistes des outils collaboratif, avec une solution entièrement en ligne et gratuite.

Les changements étant importants, la nouvelle version ne sera dans un premier temps disponible que pour les documents.

Posté par Matt le 18/03/2011 à 11h08

Aucun commentaire

Source : Le Journal du Geek

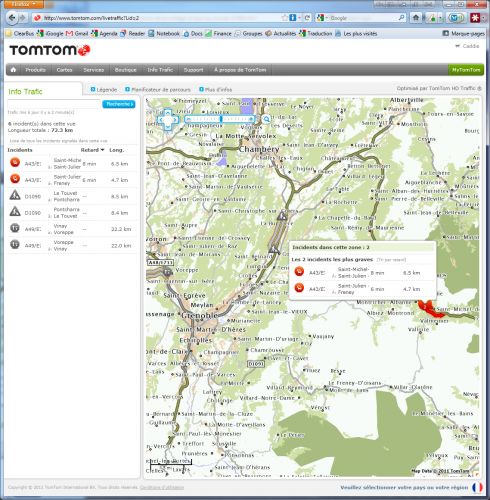

Il y a un peu plus de deux ans, TomTom lançait son service Live, permettant de recevoir sur les GPS de la marque des informations en temps réel sur les points d'intérêt, la météo, les conditions de circulation, via une carte SIM intégrée et un abonnement mensuel. Les informations de trafic en temps réel sont désormais accessibles gratuitement sur Internet.

TomTom vient en effet de lancer un site baptisé Live Traffic. Celui-ci reprend les informations trafic du service HD Traffic, inclus dans TomTom Live. Pour rappel, HD Traffic est l'un des services d'information trafic les plus avancés, grâce à une astuce tout simple : dans chaque pays couvert, TomTom a un accord avec un opérateur mobile (en France, il s'agit de SFR). Il utilise alors le réseau de cet opérateur pour fournir le service Live à ses abonnés, mais aussi pour collecter les positions des utilisateurs du service Live et de tous les abonnés de l'opérateur. En analysant leurs déplacements, TomTom peut ainsi repérer les bouchons, caractérisés par une forte concentration d'abonnés se déplaçant à faible vitesse, et déterminer leur impact sur les temps de trajet.

Malheureusement, malgré la gratuité de cette version web, le service intégré aux GPS TomTom reste payant, en raison de l'utilisation du réseau de téléphonie mobile.

Posté par Matt le 18/03/2011 à 08h22

Aucun commentaire

Source : Génération NT

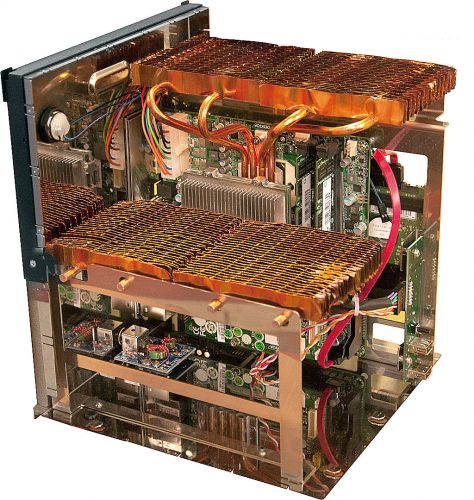

Depuis quelques temps, une nouvelle tendance est apparue sur le marché des serveurs : les "micro serveurs", des machines basées sur des processeurs de faible puissance, destinées à des applications légères, comme par exemple un site web, ou encore des applications massivement parallèles, en dotant les serveurs d'un très grand nombre de petits cœurs. Un marché parfait pour l'Atom !

Mais jusqu'à présent, l'Atom est toujours resté pour Intel un processeur destiné à des machines grand public de faible puissance, les netbooks et les nettops. Toutefois, quelques constructeurs ont fait le pari de l'utiliser dans des serveurs, comme par exemple SeaMicro, qui a monté jusqu'à 512 processeurs Atom dans des serveurs 10U.

Intel a annoncé qu'à partir de l'année prochaine, il proposera officiellement un processeur Atom pour serveur, qui viendra compléter par le bas sa gamme de processeurs Xeon basse consommation. Le fondeur n'a par contre pas donné de détail sur les caractéristiques de ces nouveaux processeurs, si ce n'est qu'ils consommeront moins de 10W, contre 20 à 45W pour les processeur Xeon basse consommation actuellement au catalogue et 15W pour les Xeon basse consommation qui seront lancés au second semestre, basés sur l'architecture Sandy Bridge.

Posté par Matt le 17/03/2011 à 14h50

3 commentaires

Source : Tom's Hardware

Dans le domaine de la téléphonie mobile, outre le développement des réseaux de quatrième génération, la prochaine évolution majeure devrait être la généralisation des fonctionnalités NFC (Near Field Communication), permettant d'utiliser le téléphone comme moyen de paiement ou comme titre de transport et qui équipent déjà certains modèles. Dans ce domaine, Apple et Google pourrait s'affronter...

En effet, alors que Google va expérimenter des services basés sur le NFC des cet été dans différentes villes américaines, notamment grâce au récent Nexus S, disposant d'une puce NFC, il se murmure qu'Apple préparerait sa propre "norme" NFC, incompatible avec les solutions existantes et s'appuyant sur iTunes pour la gestion des paiements. eBay serait également intéressé par cette technologie, via sa filiale PayPal.

Si plusieurs normes incompatibles venaient à émerger, nous assisterons probablement à une rude bataille entre les différents acteurs, pour tenter de s'attribuer ce marché, dont les analystes estiment qu'il gérera pour 110 milliards de dollars de transaction en 2015. Si la pomme se lance dans un système propriétaire, elle risque toutefois d'avoir du mal à l'imposer, sa part de marché étant désormais insuffisante par rapport à celle d'Android.

Posté par Matt le 17/03/2011 à 12h30

Aucun commentaire

Sources : The Independent et Silicon.fr

![]()

Free a publié hier un nouveau firmware pour son boîtier Freebox Player, qui passe à la version 1.0.3.2. Comme la précédente mise à jour, la 1.0.3.2 est une mise à jour mineure, corrigeant quelques uns des bugs signalés sur le bugtracker de Freeplayer.org.

Freebox Player

Corrections

- Pas de son lors de la lecture de DVD/Blu-ray (FP #5918)

- Plantage lors de la lecture du DVD Brazil (FP #3580)

- Impossible de lire certains films en vidéo à la demande (FP #5212)

- Chaînes payantes inaccessibles sur Freebox Replay (FP #3639)

- Gel de la vidéo sur les chaines TV alors que le son continue (FP #4585)

- Multiposte TNT ne fonctionne plus lorsque le Player change d’adresse IP (FP #5823)

- Le clavier virtuel du navigateur web reste affiché lorsqu’un clavier USB est branché (FP #3780)

- Le clavier virtuel du navigateur web est caché lorsqu’une souris USB est branchée (FP #4673)

Posté par Matt le 17/03/2011 à 10h50

Aucun commentaire

Source : L'actualité de la Freebox

![]()

Le récent Android 3.0 Honeycomb est officiellement réservé aux tablettes tactiles, même s'il contient tout le nécessaire pour fonctionner sur un smartphone, y compris une interface s'adaptant à leurs écrans bien moins spacieux que ceux des tablettes. HTC pourrait bien en profiter pour se démarquer en lançant un smartphone sous Honeycomb.

En effet, selon les informations révélées par le site chinois Xda.cn, le HTC Pyramid pourrait bien fonctionner sous Android 3.0. Clairement positionné sur le haut de gamme, l'appareil embarquera un écran Super-LCD de 4.3" (960x540), un processeur Qualcomm Snapdragon MSM8260 à 1.2 GHz et 768 Mo de RAM, dans un châssis ressemblant à un croisement de Desire HD et de Nexus One.

Bien entendu, tous les autres équipements classiques d'un smartphone haut de gamme seront de la partie : APN 8MP avec flash LED, Wi-Fi, Bluetooth, GPS, caméra 1.3 MP en façade, etc...

Il ne reste plus qu'à attendre une annonce officielle d'HTC pour voir s'il fonctionnera bien sous Android 3.0.

Posté par Matt le 17/03/2011 à 08h12

Aucun commentaire

Source : Le Journal du Geek

![]()

Présent sur le marché des SSD depuis qu'il a atteint le grand public, OCZ n'était jusqu'à présent qu'un intégrateur, assemblant des SSD avec des mémoires et des contrôleurs fournis par des tiers. Une stratégie qui est en train de changer, la Californien ayant racheté Indilinx, un constructeur de contrôleurs.

OCZ collaborait déjà avec Indilinx depuis quelques années, et lui doit d'ailleurs une bonne part de son succès sur le marché des SSD, les OCZ Vertex ayant connu un grand succès grâce au contrôleur Indilinx Barefoot. Depuis Indilinx a perdu un peu de sa superbe et s'est vu relégué aux SSD de milieu, voir d'entrée de gamme, mais OCZ compte bien relancer la R&D pour proposer à nouveau des contrôleurs dignes du haut de gamme.

Ce rachat marque une étape importante dans la stratégie d'OCZ, qui mise désormais clairement tout son avenir sur les SSD, après avoir annoncé il y a quelques temps l'abandon de son activité historique, les barrettes de mémoire.

OCZ précise également que cette acquisition ne remet pour l'instant pas en cause sa collaboration avec SandForce à court terme, les SSD OCZ utilisant ces contrôleurs ne devraient donc pas disparaitre des rayons dans les prochains temps.

Posté par Matt le 16/03/2011 à 15h10

Aucun commentaire

Source : Macbidouille

Comme prévu, Microsoft a publié hier la neuvième mouture de son navigateur Internet Explorer. Une évolution majeure par rapport à la précédente, pour tenter d'endiguer la fuite des utilisateurs vers Firefox, mais aussi et surtout Chrome.

En effet, si Firefox avait déjà bien entamé la part de marché d'Internet Explorer, le navigateur de Microsoft a récemment beaucoup souffert de la croissance très rapide des parts de marché de Chrome. Internet Explorer 9 à donc fort à faire pour redorer le blason de la série, et il semble s'en donner les moyens.

Au programme de cette nouvelle version :

- compatibilité partielle avec les futures normes HTML5 et CSS3,

- nouveau moteur JavaScript, plus performant,

- meilleur respect des normes HTML et CSS existantes,

- nouveau moteur d'affichage nettement plus rapide,