Actualités du mois d'avril 2011 (Matériel)

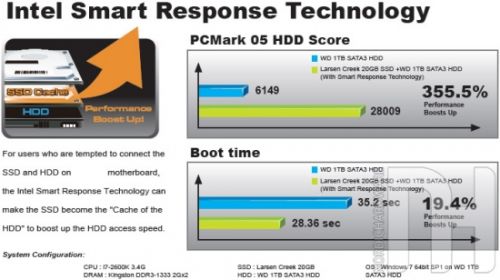

Dans son futur chipset Z68, pour processeurs Sandy Bridge, Intel va introduire une fonction baptisée Smart Response Technology, destinée à améliorer les performances des machines grâce à un SSD. On en sait désormais un peu plus sur cette fonction, pour laquelle Intel prévoirait même de sortir un nouveau modèle de SSD.

Comme on pouvait s'y attendre, le principe de cette fonction est de coupler un disque dur et un SSD en un seul volume logique, de la taille du disque dur, qui exploitera le SSD comme un énorme cache. Ainsi, sur les fichiers fréquemment accédés, les performances seront celles d'un SSD, tandis qu'on disposera de la capacité d'un disque dur. Cette solution permettra donc de se contenter d'un SSD de très petite capacité, qui n'aurait normalement même pas suffit à installer le système.

Dans cette optique, Intel aurait d'ailleurs prévu un nouveau modèle de SSD, l'Intel SSD 311 "Larsen Creek". D'une capacité de seulement 20 Go, il permettra d'exploiter pleinement le Z68 pour un prix réduit, puisqu'une telle capacité devrait permettre un prix inférieur à 50€.

Posté par Matt le 29/04/2011 à 13h00

Aucun commentaire

Source : TTHardware

Annoncé en juin dernier, en même temps que l'iPhone 4 noir, l'iPhone 4 blanc a depuis joué l'arlésienne, en étant sans cesse reporté. Il avait même fini par disparaitre du site d'Apple, laissant penser à son abandon définitif... ou pas.

En effet, alors que les amateurs de la pomme attendent déjà l'iPhone 5, Apple a finalement trouvé la recette de la peinture blanche, et l'iPhone 4 blanc est désormais disponible à la vente, au même tarif que la version noire. Cette sortie tardive tendrait d'ailleurs à confirmer que l'iPhone 5 arrivera plus tard que d'habitude, et que la sortie de l'iPhone 4 blanc arrive donc juste au bon moment pour relancer un peu les ventes et faire durer cette génération...

Alors que différentes rumeurs avaient évoqué les causes de ce retard, d'abord pour des raisons de problèmes de densité de la couleur (impossibilité de produire une peinture suffisamment dense pour ne pas être transparente, sans pour autant être trop épaisse), puis pour des problèmes de flash (la face arrière blanche aurait une influence sur la qualité des photos prise au flash, en diffusant la lumière différemment), la justification officielle, donnée par Phil Schiller, vice-président en charge du marketing, est qu'Apple aurait eu du mal à mettre au point une formule à la couleur suffisamment durable, en particulier lors de l'exposition aux rayons UV.

Posté par Matt le 29/04/2011 à 10h41

Aucun commentaire

Source : Mac 4 Ever

Présentée en début d'année, la gamme de tablette Eee Pad d'Asus devrait déjà être disponibles en France si les dates promises à l'époque avaient été respectées... Depuis, une trop forte demande et une pénurie de composants ont quelques peu perturbé les plans d'Asus, qui en a donné une nouvelle version lors d'une conférence devant les journalistes français.

Très populaire outre-Manche, l'Eee Pad Transformer, qui devait arriver en France mi-avril arrivera finalement le 6 juin, et il y a fort à parier que ceux qui n'auront pas pré-commandé ne seront pas servis par le premier arrivage. Aux USA, où elle vient d'être lancée, elle est déjà en rupture chez tous les revendeurs. Il faut dire que non seulement, Asus n'avait pas prévu une telle demande, mais en plus, sa capacité de production, qui devait être de 200 000 unités par mois, a été limité à 100 000 exemplaires au mois d'avril à cause d'une pénurie de composants. Le rythme de production devrait reprendre la normale dès le mois de mai.

L'Eee Pad Slider, très proche de la Tranformer, mais avec un clavier coulissant intégré au lieu d'un clavier amovible, qui devait sortir avant la Transformer, est finalement repoussée au quatrième trimestre. Asus en profitera pour revoir la configuration matérielle : le Tegra 2 cédera sa place à un Tegra 3 ou un Atom Z670.

Enfin, l'Eee Pad MeMo, une tablette au format 7", arrivera également au quatrième trimestre, alors qu'elle était initialement prévue pour mai.

Posté par Matt le 28/04/2011 à 10h17

Aucun commentaire

Source : PCInpact

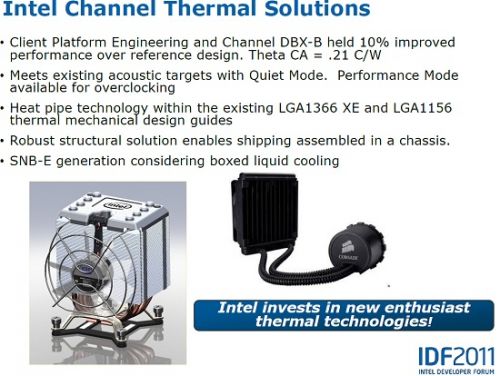

Selon un document interne d'Intel, le fondeur envisagerait le distribuer certains de ses processeurs haut de gamme avec un système de refroidissement liquide, au lieu des habituels systèmes de refroidissement à air.

Ceci concernerait les futurs processeur Sandy Bridge-E, les puces haut de gamme d'Intel destinées aux "power-users", qui prendront place sur le socket LGA2011. La plupart des acheteurs de ces processeurs "Extreme" capables d'assembler eux même leurs machines, et à qui un système de refroidissement à eau ne devrait pas faire peur, même s'il est un peu plus complexe à installer qu'un radiateur : il faut installer le bloc échangeur sur le processeur, comme un radiateur, mais il y a en plus à fixer le radiateur et son ventilateur au boîtier, généralement au niveau de l'aération arrière.

Le système proposerait deux modes de fonctionnement, un mode silencieux suffisant pour un usage normal du processeur, et un mode performance destiné à ceux qui souhaitent overclocker le processeur.

Reste à voir si une telle solution intéressera vraiment la cible des processeurs "Extreme". En effet, les utilisateurs avertis aiment généralement choisir chaque pièce de leur machine, et utilisent donc rarement les systèmes de refroidissements fournis par les constructeurs. Intel avait d'ailleurs choisi pour cette raison de vendre séparément les processeurs Core i7 haut de gamme et leurs radiateurs.

Posté par Matt le 27/04/2011 à 10h55

Aucun commentaire

Source : Tom's Hardware

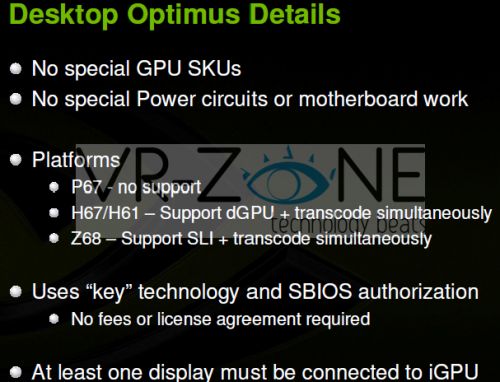

Lancée il y a un peu plus d'un an, la technologie Optimus d'nVidia est destinée aux ordinateurs portables dotés d'une puce graphique intégrée et d'une puce graphique dédiée, et permet la bascule automatique des traitements d'une puce à l'autre en fonction des besoins, pour économiser la batterie sans sacrifier les performances. Cette technologie va arriver dans les machines de bureau, sous le nom de Synergy.

Compatible avec les processeurs Intel Sandy Bridge et les chipsets Intel série 6 (sauf bien sûr le P67, qui ne supporte pas la puce graphique intégrée aux Sandy Bridge), Synergy fonctionne sans modification matérielle (une mise à jour du BIOS est toutefois requise), et permettra de basculer entre la puce graphique Intel intégrée et une carte graphique nVidia, voir plusieurs cartes en SLI sur le chipset Z68.

L'écran sera connecté à la carte mère, et c'est l'IGP Intel qui gérera donc l'affichage, en récupérant les images calculées par la carte graphique nVidia. Bonne nouvelle, cette solution sera gratuite et compatible avec toutes les puces nVidia actuelles.

Avec la généralisation des IGP dans les processeurs Intel et AMD et le développement de solutions de bascule aussi bien chez nVidia que chez AMD, voir chez des sociétés tierces, on s'oriente donc de plus en plus vers un retour au modèle de fonctionnement des deux premières générations de cartes 3dfx : une puce graphique basique pour gérer l'affichage hors 3D, et une carte accélératrice dédiée à la 3D... Souvent considéré comme un défaut des 3dfx à l'époque, ces systèmes se transforment aujourd'hui en avantages, en permettant de réduire la consommation des machines lorsqu'elles sont faiblement utilisées.

Posté par Matt le 27/04/2011 à 08h40

Aucun commentaire

Source : PCWorld

Depuis quelques temps déjà, les rumeurs annonçaient le lancement prochain d'une nouvelle console de salon chez Nintendo, pour remplacer la Wii, techniquement totalement dépassée par ses concurrentes et dont les ventes commencent à sérieusement s'essouffler. C'est désormais officiel, avec un communiqué de presse de Nintendo confirmant la rumeur.

Le communiqué ne dit toutefois pas grand chose sur la bête, si ce n'est qu'elle sera présentée officiellement lors du prochain E4, qui aura lieu à Los Angeles du 7 au 9 juin prochains. C'est à cette occasion donc que l'on en saura un peu plus sur les caractéristiques de la console, qui répond pour l'instant au nom de code "Café".

Selon les derniers rumeurs, son nom commercial pourrait être "Stream". Elle embarquerait une variante de processeur IBM PowerPC à trois cœurs (comme la Xbox 360) et une puce graphique AMD de la série R700 (Radeon 4000), là où la Xbox 360 embarque une une version intermédiaire entre le R500 et le R600. Plus volumineuse que la Wii, elle ferait par son design un clin d'œil à la Super Nintendo.

Côté manette, Nintendo pourrait de nouveau "révolutionner" les choses, avec, en plus de la classique Wiimote, une nouvelle manette intégrant un écran tactile de 6 pouces sur lesquels les jeux pourraient afficher des informations. Elle pourrait même être utiliser comme console portable, à condition de ne pas trop s'éloigner de la base, qui enverrais l'image sur la manette.

Un prototype fonctionnel devrait pouvoir être testé lors de l'E3, mais il faudra par contre attendre au mieux avril 2012 pour la commercialisation.

Posté par Matt le 26/04/2011 à 10h20

Aucun commentaire

Source : JeuxVidéo.fr

Nabaztag, le lapin hi-tech aussi inutile qu'indispensable a désormais un petit frère, baptisé Katotz, que Mindscape vient de commercialiser, après plusieurs retards. Cette nouvelle version du gadget pour geek apporte bon nombre de nouvelles fonctionnalités.

Sous un même aspect extérieur, avec son corps conique et ses deux grandes oreilles mobiles, Karotz se distingue visuellement par l'apparition d'un "nombril", qui est en fait une webcam, permettant d'utiliser le Karotz pour faire de la vidéosurveillance. Il est également livré avec deux mini-lapins, baptisés FlatNanoz, contenant une puce RFID, qui peut être lue par le Karotz. Il devient ainsi possible de déclencher certaines fonctions en approchant simplement un FlatNanoz. Le fabricant donne comme exemple la possibilité de vérifier qu'un enfant est bien rentré à la maison, en recevant par mail une photo prise avec le webcam lorsque le FlatNanoz de l'enfant passe à proximité.

Grâce à son moteur de synthèse vocale, le Karotz pourra vous lire vos flux RSS, vous annoncer la météo et, bientôt, lire les status Facebook et les tweets de vos amis. Une application devrait également permettre de lires des histoires et de chanter pour des enfants, tandis que le constructeur promet la possibilité de téléphoner gratuitement de Karotz à Karotz.

Avec cette nouvelle version plus communicante et s'intégrant avec les smartphones (il peut même être contrôlé à distance avec un iPhone), Mindscape espère vendre 120 000 lapins cette année, qui viendront compléter les 150 000 Nabaztag déjà en activité.

Il faudra tout de même compter 200€ pour adopter la bestiole...

Posté par Matt le 25/04/2011 à 10h22

Aucun commentaire

Source : 01Net

Notre confrère vient de réactualiser ses statistiques de taux de panne des composants informatiques, tirées des chiffres du SAV de LDLC sur des produits âgés de 6 mois à 1 an (vendus entre octobre 2009 et avril 2010). Les statistiques sont calculées par marques (avec un minimum de 500 ventes), mais aussi par produits plus les plus vendus (minimum 100 exemplaires).

Du côté des cartes mères, bonne nouvelle : tous les taux de retour sont en baisse, le plus mauvais de ce bilan (MSI) étant au niveau du meilleur du bilan précédent (Gigabyte), avec 2.3% de retours. Gigabyte reste en tête, avec 1.6% (-0.7pt), suivi de Asus (1.9%, -0.6pt) et ASRock (2.0%, -0.7pt). MSI est celui qui a le moins progressé, ne gagnant que 0.1pt, ce qui lui vaut de passer de la seconde à la dernière place.

Côté alimentations, Seasonic redresse fortement la barre, passant de 3.3% de retours à 1.3%, ce qui lui permet d'accrocher la 3ème place, derrière CoolerMaster (1.0%, -0.1pt) et Antec. Ce dernier conserve sa première place, malgré une forte hausse du taux de retour (1.0%, +0.4%). Derrière le podium, le classement reste très serré, avec Corsair, Akasa, Enermax et Fortron entre 1.4% et 2.0%, tandis que Thermaltake ferme la marche avec 2.3%.

Pour la fiabilité des barrettes de RAM, l'ordre reste inchangé : Kingston, Crucial, Corsair, G.skill et OCZ. Les deux premiers sont à moins de 1%, les deux suivants à moins de 2%, et OCZ, très mauvais élève, dépasse les 7%. Rappelons que l'américain a décidé de se retirer ce ce marché pour se concentrer sur les SSD...

Sur le marché des cartes graphiques, Asus pers sa première place au profit de PNY, mais reste 2ème. Les deux constructeurs ont pourtant vu leur taux de retour augmenter. Sapphire progresse légèrement, Club 3D progresse nettement. Derrière, Gainward est en légère régression, tandis que Gigabyte, MSI et XFX voient leur taux de retour augmenter fortement.

Les données semblent aujourd'hui un peu plus en sécurité. En effet, à part Western Digital, en très légère régression (1.5%, +0.1pt) mais toujours premiers, les taux de retour baissent chez tous les constructeurs. C'est Samsung qui progresse le plus (1.8%, -0.7pt), ce qui lui permet de passer de prendre la seconde place, juste devant Seagate qui vient de le racheter.

Enfin, du côté des SSD, Intel continue d'écraser ses concurrents, avec un taux de retour divisé par deux, à seulement 0.3%. Kingston prend la seconde place, en divisant également son taux de retour par deux, mais reste quatre fois moins fiable qu'Intel. Crucial complète le podium, en progressant un peu, tandis que Corsair et OCZ ferment la marche, avec des taux en nette hausse.

Posté par Matt le 21/04/2011 à 14h41

Aucun commentaire

Source : Hardware.fr

Intel vient d'annoncer ses résultats financiers du premier trimestre 2011 et, encore une fois, le géant des semi-conducteurs atteint des chiffres record, avec un CA en progression de 25% (12.8 milliards de dollars) et un bénéfice net en hausse de 29% (3.2 milliards de dollars).

Cette progression, Intel la doit principalement au marché des composants pour serveurs (+32%) et celui des processeurs pour PC, en hausse de 17% malgré l'arrivée des tablettes, dont beaucoup d'analystes annonçaient qu'elles allaient cannibaliser les ventes de PC. Intel prévoit aussi une forte croissance sur le marché des micro-serveurs, pour lesquels il va bientôt lancer une gamme dédiée de processeurs Atom.

L'Atom qui, justement, donne pour sa part un bilan plus mitigé. La croissance est bien là, mais elle est faible (seulement 4%), et, avec 370 millions de dollars de chiffre d'affaire, l'Atom ne représente même pas 3% du chiffre d'affaire d'Intel. Intel compte sur sa plateforme Oak Trail pour doper ces chiffres, ainsi que sur le développement du marché des set-top-box à base d'Atom. Free est d'ailleurs le plus gros client d'Intel dans ce domaine, et il devrait bientôt être rejoint par Orange et Bouyges Télécom, mais aussi par ces opérateurs étrangers.

Ce trimestre record ne devrait par contre pas le rester bien longtemps, Intel tablant sur une croissance de 20% pour le reste de l'année, ce qui devrait rapidement amener à de nouveaux records.

Posté par Matt le 21/04/2011 à 10h10

Aucun commentaire

Source : Silicon.fr

![]()

Notre confrère Hardware.fr vient de publier un nouveau comparatif de SSD, reprenant les principales références de ce début d'année 2011, ainsi que quelques modèles représentatifs de 2010. Mauvaise nouvelle, ce comparatif laisse entrevoir une hausse de la consommation des SSD...

En effet, si les SSD de début 2011 sont impressionnant par leurs débits, tirant largement parti de l'adoption du SATA 6 Gbit/s, cette hausse de performances s'est accompagnée d'une hausse de consommation, aussi bien au repos qu'en activité. Ainsi, alors que dans le comparatif des modèles 2009/2010, la consommation moyenne au repos s'établissait à 0.55W (0.2W pour le plus sobre, 1.2W pour le plus gourmand), elle atteint 0.86W (0.74W sans le Vertex 3 240 Go, dont la consommation élevée est mise sur le compte d'un firmware de pré-série) avec les modèles 2011 (0.6W minimum, 1.65W maximum).

Et ce n'est pas mieux en utilisation. Les modèles 2009/2010 consommaient en moyenne 2.32W en activité (1.5W minimum, 4.7W maximum) et plusieurs modèles descendaient sous les 2W. Parmi les modèles 2011, aucun ne parvient à descendre sous la limite des 2W, et la moyenne s'établit à 3.2W.

Si cette hausse de consommation est en partie liée à la hausse des capacités, il semblerait toutefois que les contrôleurs soient responsables d'une partie de cette hausse. Espérons que les constructeurs auront rapidement l'idée de se concentrer sur la consommation de leurs produits, plutôt que de se battre uniquement sur les performances, sans quoi les SSD pourraient perdre une part de leur intérêt dans les ordinateurs portables, avec des consommations qui deviennent supérieures à celles des disques durs 2.5".

Posté par Matt le 20/04/2011 à 13h00

Aucun commentaire

Source : TT-Hardware

![]()

Le marché des disques durs sera-t-il bientôt limité à deux constructeurs ? C'est en tout cas le chemin qu'il prend, avec le rachat par Seagate de la division disques durs de Samsung. Il ne reste donc plus que trois constructeurs : Western Digital (Hitachi), Toshiba (Fujitsu) et Seagate (Samsung, Maxtor, Quantum).

Avec ce rachat, Seagate porte sa part de marché à environ 40%, dont plus du quart provenant de Samsung. Le coût de l'opération est de près de 1.4 milliards de dollars, dont environ la moitié versée à Samsung sous forme d'actions Seagate. Ainsi, Samsung devient un important actionnaire de Seagate, avec 9.6% du capital. Le Coréen siégera d'ailleurs désormais au conseil d'administration de l'Américain et participera à l'élaboration de certains produits à venir. Les deux entreprises vont également partager leurs brevets.

Seagate a également négocié une position de client privilégié sur la mémoire flash NAND, utilisée dans les SSD. En effet, Seagate a obtenu la garantie que Samsung répondra prioritairement à ses commandes, évitant ainsi tout risque en cas de pénurie.

Posté par Matt le 20/04/2011 à 10h20

Aucun commentaire

Source : Clubic

Annoncé en janvier lors du CES, l'Eee Pad Slider d'Asus devait être une tablette Android 3.0 à clavier coulissant basée sur une plateforme nVidia Tegra 2, comme l'Eee Pad Transformer qui commence petit à petit à être disponible dans différents pays. Mais la Slider pourrait finalement adopter la plateforme Intel Oak Trail...

En effet, dans le kit presse proposé par Intel pour cette plateforme, le fondeur présente l'Eee Pad Slider comme étant une tablette exploitant la plateforme Oak Trail... Le kit presse évoquait également une autre tablette chez Asus, dans un format un peu plus classique. La présence de ces tablettes Asus dans le kit presse d'Intel est visiblement une erreur, le kit ayant rapidement été mis à jour par Intel pour supprimer toute référence à ces deux produits. Reste à voir si l'erreur était simplement une mise en ligne anticipée par rapport aux annonces d'Asus, où carrément une annonce erronée sur l'utilisation de la plateforme Oak Trail dans ces produits.

Pour rappel, la plateforme Oak Trail a été lancé il y a peu par Intel et vise principalement à imposer l'architecture x86 dans le monde des tablettes, avec le processeur Atom Z670 qui l'équipe. Si Asus sortait effectivement une Slider à base d'Atom, il sera donc intéressant de comparer ses performances et son autonomie à celles de la Transformer, pour voir qui de Oak Trail ou de Tegra 2 s'en tire le mieux en exploitant la même couche logicielle...

Mise à jour le 19/04/2011 à 22h20 : Asus a finalement confirmé travailler sur une tablette exploitant la plateforme Oak Trail. Mais Intel a tout de même fait une erreur dans son kit presse, la tablette Oak Trail d'Asus n'était pas l'Eee Pad Slider, mais un nouveau modèle non encore présenté par le taiwanais, tandis que la Slider conservera bien le Tegra 2 initialement prévu.

Actu originale : 19/04/2011 à 12h30

Posté par Matt le 19/04/2011 à 22h20

Aucun commentaire

Sources : Tom's Hardware

![]()

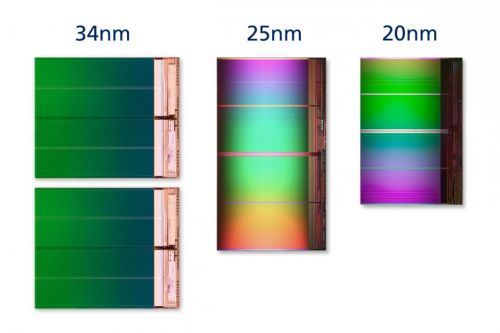

Moins d'un an après la commercialisation de sa mémoire flash gravée en 25nm, IMFT (une joint-venture entre Intel et Micron) vient d'annoncer préparer une nouvelle génération de mémoire flash NAND, gravée en 20nm.

D'une capacité de 8 Go, la première puce adoptant cette finesse de gravure n'occupe plus que 118mm² sur un wafer de silicium, contre 167mm² pour son équivalent en 25nm. Le gain en surface est donc de près de 30%, ce qui devrait se traduire par une baisse de prix du même ordre.

Par ailleurs, le fondeur a annoncé que cette nouvelle finesse de gravure devrait permettre d'atteindre les mêmes durée de vie qu'en 25nm, soit entre 3000 et 5000 cycles écriture-effacement pour les mémoires MLC à 2 bits par cellule. Enfin, ces nouvelles puces étant très proches des puces 25nm, leur adoption ne devrait nécessiter que des modifications mineures des produits les utilisant. Elles pourraient donc se répandre rapidement dans les produits à base de mémoire flash.

La fabrication débutera dans l'usine de Lehi (Utah). Intel et Micron adapteront ensuite les usines de Manassas (Virginie) et de Singapour à cette nouvelle finesse, au fil de la hausse de la demande.

Posté par Matt le 18/04/2011 à 14h51

Aucun commentaire

Source : PCWorld

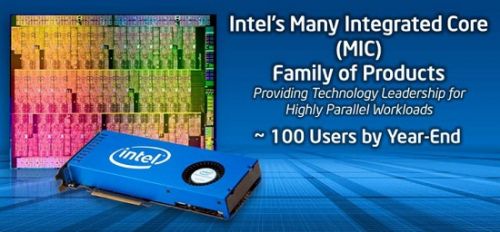

Depuis quelques années, les cartes graphiques nVidia et AMD se retrouvent de plus en plus souvent dans des calculateurs, en exploitant le principe du GP-GPU, qui consiste à utiliser la puissance des GPU pour effectuer des calculs non graphiques. Intel répond enfin à ce concept, avec son "Many Integrated Core", présenté lors du dernier IDF.

Many Integrated Core (MIC) est probablement une résurgence du projet Larrabee, abandonné depuis quelques temps déjà. Ce dernier consistait à mettre au point un GPU basé sur un grand nombre de petits cœurs x86. Et c'est exactement ce que propose MIC : une carte de calcul prenant place sur un port PCI-Express et contenant pas moins de 50 cœurs x86, gravés en 22nm.

Selon Intel, cette solution aura l'avantage d'être plus simple à utiliser que les solutions GP-GPU car, utilisant un jeu d'instruction x86, elle pourra être exploitée avec les outils de développement habituels. Bien que la puissance brute soit inférieure, cette solution a également l'avantage d'une grande indépendance entre les cœurs, alors que sur un GPU, les unités de calcul sont regroupés en "cluster", toutes les unités d'un même cluster devant traiter la même opération (mais sur des données différentes).

D'ici la fin de l'année, une centaine d'exemplaires de pré-série seront fournis par Intel a certains de ses partenaires. La date de sortie définitive n'a par contre pas été communiquée, et Intel n'a pas non plus évoqué de plans pour transformer MIC en carte graphique.

Posté par Matt le 18/04/2011 à 11h11

Aucun commentaire

Source : Clubic

Bien que les contrôleurs USB 3 soient disponibles depuis un bon bout de temps, les deux principaux fabricants de chipsets, Intel et AMD, n'ont toujours pas intégré cette norme à leurs produits. C'est finalement AMD qui sera le premier des deux à sortir des chipsets USB 3.0, dès cette année, alors qu'il faudra attendre 2012 chez Intel.

Les premiers chipsets AMD supportant l'USB 3.0 seront les chipsets A75 et A70M, qui devraient normalement accompagner le lancement de la plateforme Llano, prévue pour les semaines ou les mois à venir.

Chez Intel, les premiers chipsets intégrant l'USB 3.0 devraient être les chipsets accompagnant les processeurs Ivy Bridge, prévus pour le premier trimestre 2012.

Posté par Matt le 15/04/2011 à 10h50

Aucun commentaire

Source : Macbidouille

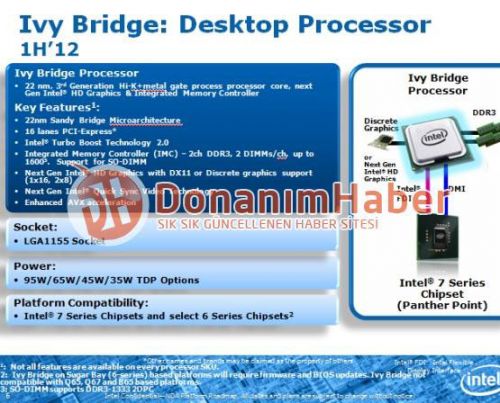

Il y a un peu plus de deux mois, on apprenait que les futurs processeurs Ivy Bridge d'Intel allaient prendre place sur le socket 1155, actuellement utilisé par les Sandy Bridge, ce qui laissait entrevoir une compatibilité avec les cartes mères actuelles. De nouvelles sources confirment cette compatibilité.

En effet, le site turc DonanimHaber a mis la main sur un document interne d'Intel, qui donne plus de précisions sur le futur processeur. Le document confirme le passage à une gravure 22nm, le support de la DDR3 1600, l'amélioration du jeu d'instructions AVX et le passage à une nouvelle génération de puce vidéo Intel HD Graphics compatible avec DirectX 11.

Mais surtout, ce nouveau document indique explicitement la compatibilité avec les chipsets utilisés actuellement avec les processeurs Sandy Bridge (chipsets série 6). Cette compatibilité ne sera toutefois que partielle, en se limitant aux chipsets grand public Z68, P67, H67 et H61, tandis que les versions professionnelles Q67, Q65 et B65 seront laissées de côté.

Dans ce document, Intel précise tout de même aussi que la compatibilité ne sera assurée que sous réserve de disponibilité d'une mise à jour du BIOS/EFI. La compatibilité dépendra donc en partie de la bonne volonté des constructeurs de cartes mères.

Posté par Matt le 15/04/2011 à 08h30

Aucun commentaire

Source : Hardware.fr

Il y a quelques mois, un développeur avait réalisé une application permettant de synchroniser un iPhone avec iTunes via Wi-Fi. Rejetée de l'App Store par Apple au motif qu'elle posait des problèmes de sécurité, l'application est depuis disponible pour les iPhone jailbreakés. La synchronisation via Wi-Fi pourrait toutefois arriver officiellement, en commençant par la prochaine génération d'iPod.

En effet, selon Cult of Mac, Apple serait sur le point de finaliser sa propre solution de synchronisation via Wi-Fi, et elle pourrait donc être proposée sur la prochaine génération d'iPod, qui devrait arriver au mois de septembre, période habituelle du renouvellement de la gamme. pour ce faire, il faudra bien entendu ajouter une puce Wi-Fi aux iPod Shuffle, Nano et Classic, qui en sont absolument dépourvu.

Toujours selon Cult of Mac, ces nouveaux iPod pourraient par la même occasion changer de design, avec l'adoption d'une coque en fibre de carbone, qui laisserait mieux passer les ondes que les coques métalliques actuellement utilisées par la pomme. Une rumeur appuyée par le fait qu'Apple a récemment embauché un spécialiste des matériaux composites, qui avait travaillé au préalable sur des cadres de vélo en carbone.

Si une telle fonctionnalité était proposée pour les iPod, il y a fort à parier qu'elle arrive aussi quelques semaines ou quelques mois plus tard pour les différents appareils sous iOS, d'autant plus qu'ils ont l'avantage d'être déjà tous dotés d'une connectivité Wi-Fi. Une simple mise à jour logicielle serait donc suffisante.

Posté par Matt le 14/04/2011 à 14h30

2 commentaires

Source : Macbidouille

Après l'annonce de son accord avec Microsoft pour la production de smartphones sous Windows 7, Nokia avait précisé que Symbian ne serait pas abandonné à court terme. Le finlandais vient de le prouver avec le lancement de deux nouveaux smartphones, accompagnés d'une nouvelle version de Symbian.

Baptisé E6, le premier est smartphone destiné au marché professionnel, reprenant un design façon BlackBerry, avec un écran en mode paysage et un clavier complet sur la partie inférieure de la façade. Avec son processeur à 680 MHz, ses 8 Go de stockage et son écran de 2.5", il risque toutefois de souffrir de la comparaison avec les smartphones d'autres marques, même s'il se distingue avec son APN de 8MP. Il pourrait par contre profiter de son tarif contenu (430€ TTC), de son port USB hôte et de son excellente autonomie (annoncée à 5 jours en utilisation normale) pour se faire sa place sur le marché.

Nettement plus orienté grand public, le X7 embarque la même base matérielle que le E6, mais troque l'écran paysage et le clavier contre un écran portrait AMOLED 640x360 couvrant la façade de l'appareil. Il sera vendu 450€ TTC. Comme le E6, il risque de souffrir du manque de puissance de son processeur, mais Nokia se défend en indiquant qu'une puce à 680 MHz suffit pour un appareil sous Symbian, le système étant peu gourmand et capable de tirer parti de l'accélération matérielle. Cette fréquence réduite est aussi un plus pour l'autonomie.

Côté système, des nouveaux Nokia embarqueront la toute nouvelle version de Symbian, baptisée Anna. Dotée d'une ergonomie améliorée, d'un navigateur web plus rapide et de la nouvelle version d'Ovi Cartes gérant les transports en commun, cette nouvelle version du système vise également les professionnels, avec la prise en charge du chiffrement matériel et de nouvelles fonctions collaboratives au niveau de la messagerie.

Cette version de Symbian ne sera pas réservée aux nouveaux appareils. Les actuels N8, E7, C7 et C6-01 auront droit à une mise à jour dans les mois à venir.

Posté par Matt le 13/04/2011 à 11h00

Aucun commentaire

Source : Business Mobile

Lancée par Apple et Intel il y a six semaines, cette interface est très intéressante sur le papier, mais souffre pour l'instant de l'absence de périphériques l'exploitant, même si LaCie et Promise ont déjà annoncé des solutions de stockage à cette norme. Avec le NAB 2011, la situation commence toutefois à évoluer...

Constructeur d'accessoires pour Mac, principalement dans le domaine du stockage et des cartes d'extensions, Sonnet a ainsi dévoilé une nouvelle gamme de produits, qui sera présentée en détail au NAB 2011.

La gamme commence avec du très classique, trois périphériques de stockage externe. Le premier embarque deux SSD en RAID0, le second offre quatre baies pour disque dur 3.5" SATA et le troisième en propose huit. Sonnet commercialisera également deux adaptateurs, l'un offrant une connectique Gigabit Ethernet, le second offrant un port Firewire 800.

Mais les deux produits les plus originaux et les plus intéressants sont probablement deux boîtiers permettant de connecter une carte PCI-Express via Thunderbolt. Le premier est destiné à des cartes de petite taille (pas plus longue que le port PCI-E 16x) et ne consommant pas plus de 75W, tandis que le second pourra accepter des cartes deux fois plus longues et consommant jusqu'à 150W. Dans les deux cas, le connecteur interne est un connecteur au format 16x, mais câblé seulement en 4x. Ces boîtiers permettront par exemple d'ajouter une carte graphique à un ordinateur portable.

Le NAB 2011 a également être l'occasion de présenter des périphériques Thunderbolt pour d'autres constructeurs spécialisés dans les solutions audio/vidéo. Par exemple, Matrox y a montré un adaptateur Thunderbolt pour ses boîtiers MXO2 (qui se connectent actuellement via une interface PCI-Express externe dans un format propriétaire), tandis que Blackmagic Design a présenté l'UltraStudio 3D, un boîtier d'acquisition vidéo haut de gamme.

Posté par Matt le 13/04/2011 à 08h21

Aucun commentaire

Source : Tom's Hardware

Après avoir fait ses armes sur le marché des smartphones et lancé une offensive sur celui des tablettes, Android va prochainement faire son entrée sur celui des autoradio, mais de manière officieuse.

L'initiative ne vient en effet pas de Google, mais du français Parrot, qui va lancer le mois prochain un autoradio sous Android. Sous le nom Asteroid, il regroupera les fonctionnalités classiques d'un autoradio, mais aussi d'un GPS. Couplé à une clé 3G, il permettra également d'accéder à Internet, notamment pour des services de cartographie (Google Maps), de musique en streaming (Deezer) ou encore d'alertes GPS (Coyote).

Il coûtera un peu moins de 300€ et pourra être commandé par la voix, aussi bien pour le système de base que pour les applications additionnelles, si elles sont adaptées à un tel contrôle. Reste à convaincre les utilisateurs de l'utilité d'un tel système, par rapport à un smartphone doté d'un kit automobile, certes moins intégré, mais qui peut aussi servir en dehors de la voiture...

Posté par Matt le 12/04/2011 à 08h41

Aucun commentaire

Source : Numerama

Profitant de l'arrivée des nouveaux processeurs Intel Xeon E7-4800 embarquant dix cœurs, HP a annoncé la sortie prochaine d'un nouveau monstre, le ProLiant DL980 G7, embarquant pas moins de 80 cœurs et pouvant être doté de 4 To de RAM !

Si ces 80 cœurs restent "peu" comparé aux serveurs 512 cœurs proposés par Seamicro, il s'agit là de cœurs Nehalem à 2.4 GHz, bien plus performants que les cœurs Atom des serveurs de Seamicro. Les dix processeurs prennent place dans un châssis rackable 8U, doté de 128 slots mémoire DDR3L fonctionnant à tension réduite (selon HP, le gain atteindrait près de 2500W pour une configuration dotée de 4 To de RAM). Le stockage est limité à seulement 8 disques durs, au format SAS, mais ce genre de machines est généralement couplé à un stockage SAN, qui pourra être connecté via les 4 ports Gigabit Ethernet de la bête.

Elle risque par contre de ne pas être accessible à toutes les bourses, le processeur Xeon E7-4800 à lui tout seul étant déjà facturé près de 4400$ par Intel... Ce serveur sera disponible en juin. En attendant, j’accepte les dons pour le renouvellement du serveur d'Infobidouille :-)

Posté par Matt le 11/04/2011 à 10h50

1 commentaire

Source : PCWorld

Avec l'arrivée sur le marché de nombreux nouveaux acteurs, l'année 2011 devrait être une année importante pour le marché des tablettes tactiles, qui devrait progressivement passer d'un quasi monopole de l'iPad d'Apple à une offre plus diversifiée. Mais pas forcément facile à décoder pour l'acheteur potentiel...

En effet, les tablettes vont se décliner sur une large gamme de prix (80 à 800€ !), avec des tailles d'écran variables (7" à 10", voir 12"), des résolutions allant du 800x480 au 1280x800, de gros écarts de performances en fonction du processeur (du ARM simple cœur à quelques centaines de MHz jusqu'à des solutions double cœur à plus d'1 GHz), des quantités de stockage très variées, différentes technologies de communications sans fil, une connectique plus ou moins riche, etc...

Et bien sûr, il faudra aussi compter sur le choix du système d'exploitation, avec au moins cinq systèmes différents (iOS, Android, Windows 7, Web OS, BlackBerry OS)... Et ce sans compter les différentes déclinaisons d'Android, qui peuvent encore compliquer le choix, certaines tablettes embarquant la version 3.0, spécialement adaptée à ce type d'appareils, tandis que d'autres se contentent d'un vieillissant Android 2, plutôt conçu pour les smartphones...

Pour vous aider à vous retrouver, notre confrère PCWorld a mis en ligne un tableau comparatif, permettant de vérifier en un coup d'œil les caractéristiques de 6 modèles déjà disponibles sur le marché et de dix modèles à venir.

Posté par Matt le 08/04/2011 à 12h20

Aucun commentaire

Source : PCWorld

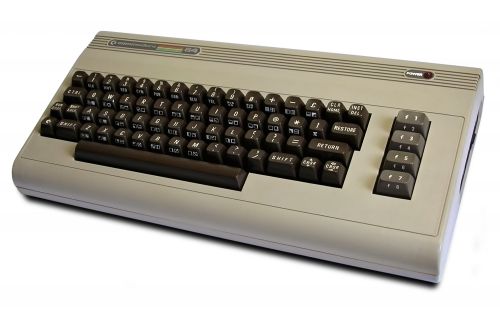

Commodore USA vient d'ouvrir les commandes pour le... Commodore 64 ! Mais cette fois, le 64 fait référence à son processeur 64 bits, et non à 64 Ko de RAM, comme pour son vénérable ancêtre, lancé en 1982.

Le Commodore 64 de 1982...

Il avait à l'époque été la star des débuts de l'informatique personnelle, en étant le premier ordinateur vendu à plus d'un million d'exemplaire. Et il reste aujourd'hui l'ordinateur le plus vendu, avec 17 à 25 millions d'exemplaires écoulées selon les sources. En plus de 64 Ko de RAM qui lui ont donné son nom, il embarquait un processeur MOS 6510 à 0.985 ou 1.023 MHz selon les modèles, 20 Ko de ROM pour le système, et un "GPU" surpuissant, capable d'afficher en 320x200 monochrome ou 160x200 en 16 couleurs !

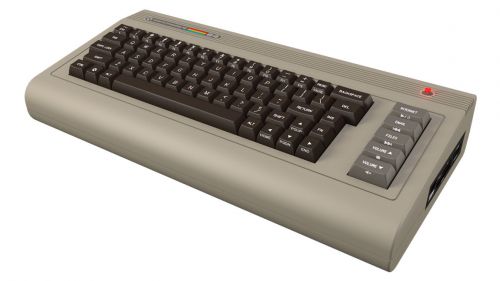

... et son petit frère de 2011

Reprenant le design du modèle original, le Commodore 64 de 2011 est reconnaissable à sa face arrière, dotée de connectiques modernes, tandis que ses faces latérales sont ornées d'un lecteur DVD (à gauche) et d'un lecteur de cartes mémoire (à droite). À l'intérieur, on trouve un processeur Intel Atom D525 double cœur à 1.8 GHz accompagné de 2 à 4 Go de RAM et d'une puce graphique nVidia ION 2 doté de 512 Mo de mémoire dédiée. Il gère es connexions sans-fil Bluetooth et Wi-Fi et un disque dur de 160 Go à 1 To.

Côté logiciel, Commodore livrera sa machine sous Ubuntu 10.04, mais fournira aussi Commodore OS 1.0 et un lot de jeux tirés de la machine originale, qui fonctionneront probablement via un émulateur. Selon la configuration, il faudra compter entre 250 et 900 dollars, et les livraisons devraient débuter au moins de juin.

Posté par Matt le 08/04/2011 à 08h20

4 commentaires

Source : Clubic

Viking Modula Solution vient de présenter des SSD dans un format très original, qu'ils ont baptisé SATADIMM. Oui, DIMM, comme les barrettes de RAM, ces SSD étant faits pour s'installer dans des slots pour RAM DDR3 !

Bien entendu, il ne s'agit toutefois pas d'utiliser des SSD comme de la RAM, les performances seraient catastrophiques. Ces SSD se branchent à un port DIMM uniquement pour en tirer leur alimentation électrique, et ils proposent un port SATA pour les raccorder à la carte mère, comme un SSD classique.

Malgré ce format exotique, le constructeur n'a pas lésiné sur les performances, puisque ces SSD embarquent un contrôleur SandForce SF-2000 de toute dernière génération, capable de dépasser les 500 Mo/s en accès séquentielle via une interface SATA 6 Gbit/s et promettant 60 000 IOPS en accès aléatoire.

Proposé en format standard (25mm de hauteur) et en "Very Low Profile" (18.75mm), ces SSD originaux ont toutefois peu de chances de se retrouver un jour dans les boutiques traditionnelles, leur constructeur visant une toute petite niche de marché : les serveurs rackables 1U, où l'espace très exigu peut justifier de payer très cher un produit plus compact que ses concurrents...

Posté par Matt le 07/04/2011 à 14h11

Aucun commentaire

Source : Le Comptoir du Hardware

![]()

Ces dernières années, la stratégie d'Acer était claire : rogner sur la qualité et sur les marges pour faire de gros volumes (et donc des économies d'échelle) et tenter de devenir le premier constructeur mondial d'ordinateurs. Un objectif qui devrait être atteint cette année sur les portables et l'année prochaines sur les machines de bureau. Mais le taiwanais s'apprêterait à changer de stratégie...

En effet, si la stratégie a été efficace sur les volumes, elle ne l'est pas sur les marges, trop faibles au goût des investisseurs. La situation a mené au départ du PDG du groupe, l'italien Gianfranco Lanci. Le groupe semble désormais vouloir suivre les conseils de son fondateur, Stan Shih, qui suggérait il y a quelques jours qu'Acer devrait suivre l'exemple d'Apple.

Ainsi, JT Wang, le nouveau PDG par interim a-t-il annoncé que la stratégie d'Acer a été chamboulée par l'arrivée des tablettes, obligeant le groupe à s'adapter. Acer va donc désormais viser un peu moins les volumes, mais plutôt proposer des produits plus haut de gamme, sur lesquels le constructeur pourra faire plus de marges, tout en se donnant les moyens d'investir dans les secteurs porteurs actuels, les smartphones et les tablettes. Le taiwanais vise ainsi 10% du marché des tablettes en 2011, mais reste moins ambitieux sur les smartphones, dont il se contenterait de 2%.

Posté par Matt le 06/04/2011 à 08h30

Aucun commentaire

Source : PCInpact

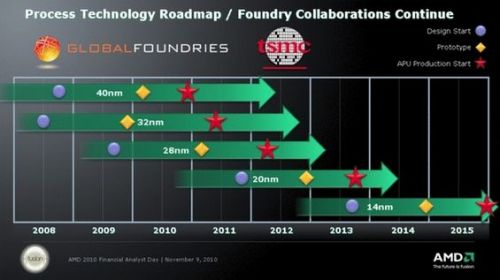

Depuis qu'AMD s'est séparé de ses usines en les confiant à GlobalFoundries, une société créée pour l'occasion, cette dernière reste le principal fournisseur d'AMD pour la fabrication de ses processeurs. Mais AMD devient un client de plus en plus exigeant...

En effet, AMD ne serait pas du tout satisfait des faibles rendements offerts par GlobalFoundries sur la gravure en 32nm, d'autant plus que ces problèmes l'ont forcé à retarder le lancement de sa nouvelle gamme de processeurs à GPU intégré Llano, au profit de la gamme Ontario, gravée en 40nm chez un autre fondeur (TSMC).

Pour l'année 2011, AMD a donc décidé de renégocier son contrat avec le fondeur, pour lui mettre un peu plus la pression. Traditionnellement, les clients des fondeurs achètent les wafers à un tarif prédéterminé, quelque soit le nombre de puces fonctionnelles sur le wafer. AMD accepte de rester sur ce modèle pour les wafers 45nm, mais va par contre payer les wafers 32nm en fonction du taux de puces défectueuses. GlobalFoundries a donc intérêt à faire progresser son processus de gravure 32nm, les rebuts étant désormais à sa charge.

Ce différend est également l'occasion de constater l'avance prise par Intel sur son concurrent dans ce domaine... En effet, alors qu'AMD se bat pour obtenir un taux acceptable de puces fonctionnelles en 32nm et sortir son premier processeur de cette finesse, Intel distribue des Core i en 32nm depuis plus d'un an, et s'apprête déjà à passer au 22nm pour la fin de l'année... AMD pour ça part n'envisage pas mieux que du 28nm pour début 2012, et vise la commercialisation de ses premières puces 20nm fin 2013...

Posté par Matt le 05/04/2011 à 12h11

Aucun commentaire

Source : Tom's Hardware

Jusqu'à présente, la plateforme Android était une plateforme très ouverte, que n'importe quel constructeur pouvait adopter pour n'importe quel appareil, quasiment sans condition. De plus, les constructeurs avaient la possibilité de modifier plus ou moins le système. Il semblerait que Google veuille mettre un terme à tout ça...

En effet, alors que Google avait annoncé il y a quelques jours que les sources d'Android 3.0 ne seraient pas disponibles immédiatement, pour éviter que n'importe qui puisse sortir un appareil sous cette version du système, ceci ne serait pas la seule mesure de Google. En effet, pour faciliter le développement d'applications et le déploiement des mises à jour du système, Google voudrait une plus grande uniformité du parc d'appareils Android.

Et cette uniformisation ne passera pas que par une limitation des modifications logicielles, puisque Google serait également en négociation avec ARM pour la définition d'une architecture matérielle standardisée pour les appareils Android. Ainsi, Google pourrait s'affranchir des constructeurs et diffuser directement les mises à jour du système.

Ce ne serait pas forcément une mauvaise chose, tant certains constructeurs trainent la patte pour fournir des mises à jour compatibles avec leur matériel, mais on peut par contre craindre qu'une telle solution soit un frein à l'évolution des appareils Android, en l'absence d'une vraie concurrence sur le matériel.

Posté par Matt le 04/04/2011 à 14h30

Aucun commentaire

Source : Tom's Hardware

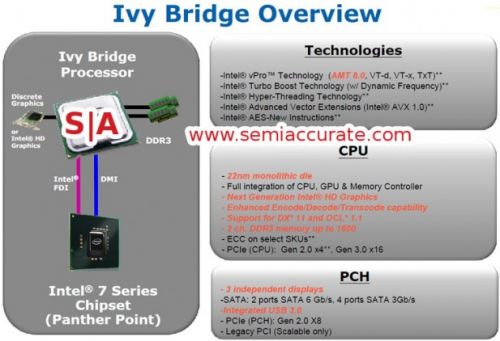

Prévu pour succéder à la plateforme Sandy Bridge en fin d'année , la plateforme Ivy Bridge sera essentiellement un die-shrink en 22nm du Sandy Bridge (32nm). Mais il apportera aussi quelques nouveautés, notamment au niveau du PCI-Express.

Ainsi, le contrôleur PCI-Express intégré au processeur va proposer 20 lignes PCI-Express, contre 16 actuellement, et les 16 premières lignes, généralement utilisées par la carte graphique, seront à la norme PCI-Express 3.0, qui offrira une bande passante doublée par rapport à l'actuelle norme PCI-Express 2.0.

La partie graphique intégrée sera également améliorée, avec le support de DirectX 11 et d'OpenCL 1.1 et pourra gérer trois écrans indépendants, tandis que le southbridge accompagnant le processeur supportera enfin l'USB 3.0.

Posté par Matt le 04/04/2011 à 08h22

Aucun commentaire

Source : Macbidouille

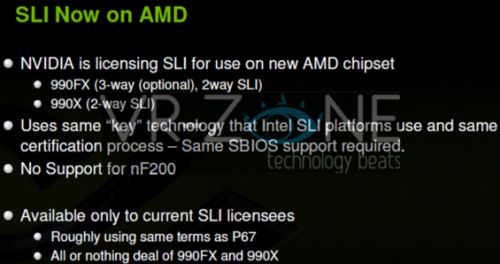

Lorsqu'nVidia avait relancé le SLI en 2005, c'était pour la firme au caméléon un bon moyen de rendre ses chipsets plus attractifs : le SLI n'était supporté que sur les chipsets nForce. Plus tard, nVidia l'a autorisé sur certains chipsets Intel via une puce additionnelle, puis sans cette puce... Et désormais, ce sont des chipsets AMD qui vont y avoir droit !

En effet, maintenant qu'nVidia n'est plus du tout présent sur le marché des chipsets haut de gamme, il a tout intérêt à ce que sa technologie SLI fonctionne sur un maximum de chipsets, dans la mesure ou le CrossFire d'AMD est ouvert depuis longtemps à quasiment tous les chipsets. Ce sont donc deux chipsets AMD qui vont avoir droit aux SLI : le 990X et le 990FX. Ces deux chipsets ne sont pas encore disponibles, mais équiperont la nouvelle plateforme AMD, qui ne devrait plus trop tarder.

Ces deux chipsets pourront supporter le SLI sans ajout de puce additionnelle, comme les derniers chipsets Intel. Le 990X aura droit au SLI à deux cartes, tandis que le 990FX, plus haut de gamme, pourra en exploiter jusqu'à trois.