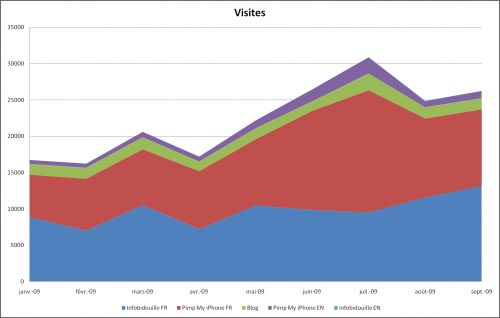

Comme l'annoncent fièrement nos politiciens, la croissance est de retour :-) En effet, en ce mois de septembre, vous avez été 5.4% de plus qu'en août à visiter nos sites et vous avez visualisé 10.1% de pages supplémentaires.

Cette croissance s'est concentrée sur Infobidouille (+13.6%) et la version anglaise de Pimp My iPhone (+17.8%), tandis que mon blog et la version française de Pimp My iPhone ont légèrement regressés (-1.4% et -2.8%).

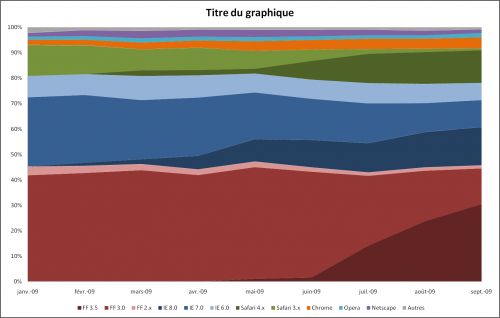

Côté navigateur, peu de changements. La migration de Firefox 3.0 à Firefox 3.5 continue (-5.8pts pour le 3.0, +6.7pts pour le 3.5) et ce dernier reste nettement le navigateur favori des visiteurs, avec près d'un tiers des visites (30.4%). La famille Firefox progresse également un peu (45.9%, +0.7pt), au détriment d'Internet Explorer (32.4%, -0.4pt) et Safari (13.8%, -0.4pt).

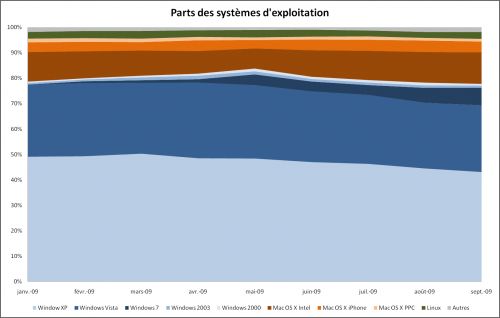

Un mois avant sa sortie, Windows 7 continue sa progression (6.9%, +1pt). Une part 3 fois supérieure à celle qu'occupait Windows Vista un mois avant sa sortie grand public (2.2%).

Posté par Matt le 01/10/2009 à 23h20

3 commentaires

Après une fin de mois de septembre durant laquelle ATI était à l'honneur avec ses Radeon HD 5850 et 5870, c'est au tour de nVidia de faire parler de ses produits, avec l'annonce ce soir des nouveautés à venir. Mais contrairement à ATI, la disponibilité ne sera pas immédiate.

La grosse information concerne bien entendu la future GeForce, qui était connue jusqu'à présent sous le nom de GT300, et qu'il faudra désormais baptiser Fermi, un nom qui annonce clairement la couleur : avec cette gamme, nVidia veut mettre l'accent sur le domaine du calcul hautes performances (HPC). Gravée en 40nm, comme les Radeon 5800, cette nouvelle puce embarquera trois milliards de transistors (près d'un milliard de plus que les Radeon 5800) qui constitueront pas moins de 512 processeurs de flux (désormais appelés des cœur CUDA), soit plus du double des 240 embarqués sur l'actuelle GeForce GTX285.

Le bus mémoire restera en 384 bits, via 6 contrôleurs mémoire 64 bits, et il s'agira de mémoire GDDR5. La puce pourra en théorie en gérer jusqu'à 1 To, mais en pratique, les produits à base de Fermi devraient proposer jusqu'à 6 Go de mémoire, une quantité qui restera probablement réservée aux modèles Tesla, destinées au marché des supercalculateurs. Toujours pour conquérir ce marché du calcul, nVidia a annoncé le support de l'ECC au niveau de la mémoire, pour détecter et corriger les erreurs. Une protection inutile pour les jeux vidéos, mais qui peut être indispensable dans les longs calculs scientifiques, où les erreurs peuvent petit à petit se propager et s'amplifier.

Pour optimiser l'utilisation de cette mémoire, Fermi va également être doté de deux niveaux de cache. Tout d'abord, chaque groupe de 32 cœurs disposera de 64 Ko de mémoire partitionnable dynamiquement, soit en 16 Ko de mémoire partagée (comme sur le GT200) et 48 Ko de cache L1 (inexistant sur le GT200), soit en 48 Ko de mémoire partagée et 16 Ko de cache L1. La différence entre ces deux types de partition réside dans le fait que la mémoire partagée est gérée par l'application, alors que le cache est transparent. En plus ce ces caches L1, Fermi embarquera également un cache L2 partagé entre tous les cœurs, avec une capacité de 768 Ko. Selon nVidia, ces caches permettraient de multiplier les performances par 5 à 20 par rapport au GT200 lors de certaines opérations mémoire.

Côté programmation, la puce supportera bien entendu DirectX 11 (y compris DirectCompute), OpenGL 3.2, PhysX, OpenCL, CUDA, mais également, et c'est une grande nouvelle, le C++, ce qui pousse nVidia à qualifier désormais sa puce de cGPU, et non plus de GPU. Ceci devrait permettre de faciliter grandement le portage de certaines applications pour les faire tourner sur la puce d'nVidia. Un argument de poids pour contrer Larrabee, qui promet également une grande facilité de programmation, et qui devrait permettre à nVidia d'assoir sa domination sur le marché du GPGPU, les dernières puces ATI se limitant à OpenCL, certes prometteur, mais qui semble peiner à décoller. Des plug-ins Visual Studio seront également disponibles, pour permettre de programmer la puce dans cet IDE très répandu.

Si Fermi s'avère effectivement très prometteur du côté du HPC, les annonces de nVidia ont par contre de quoi laisser les joueurs sur leur faim. En effet, nVidia a très peu parlé de l'aspect ludique de cette nouvelle puce et n'a parlé ni du prix, ni des performances. nVidia semble en fait s'intéresser beaucoup moins au marché du jeu vidéo. Selon nos confrères d'Anantech, ceci pourrait s'expliquer par le fait que les jeux sont de plus en plus souvent développés pour PC et consoles, ce qui diminue leur besoin en GPU puissants sur les versions PC, d'autant plus que les résolutions ont désormais tendance à stagner.

Les premières cartes devraient être disponibles pour les testeurs avant la fin de l'année, tandis que la production en masse n'est pas prévue avant le premier trimestre 2010.

Posté par Matt le 30/09/2009 à 23h09

Aucun commentaire

Source : Anandtech

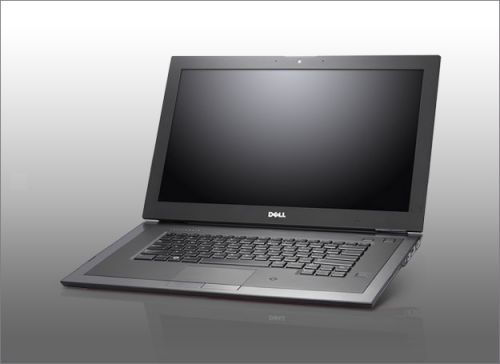

Un ordinateur portable est souvent considéré comme une machine sans-fil, permettant de travailler et de surfer sur Internet librement en se "posant" n'importe où. Mais c'est oublier qu'il faut régulièrement lui remettre un fil à la patte pour recharger sa batterie...

Pire, en usage professionnel, il n'est pas rare d'accompagner l'ordinateur d'un clavier, d'une souris et d'un écran de bureau pour disposer d'un poste de travail plus confortable. Autant de câbles supplémentaires à débrancher et rebrancher à chaque déplacement. Avec le nouveau Latitude Z de Dell, ceci ne sera bientôt plus qu'un souvenir !

En effet, cet ultraportable haut de gamme peut se venter d'être le tout premier ordinateur portable totalement sans-fil, grâce à une station d'accueil innovante (en option). En effet, il suffit de poser la machine dessus pour mettre la batterie en charge, grâce à un système à induction, tandis qu'un boîtier (lui aussi optionnel...) connecté à l'ordinateur par une liaison sans fil prend en charge les connectiques nécessaires pour une utilisation fixe (écran, réseau, USB...). Ainsi, plus de câbles à brancher, une fois le portable posé sur sa station d'accueil, le poste de travail fixe est opérationnel. Le rendement du système à induction ne serait par contre que de 70%...

Mais l'innovation ne s'arrête pas là. Le Latitude Z est en effet également doté d'une zone tactile le long du côté droit de l'écran. Un clic sur un bouton au bas de cette zone fera apparaître une barre de raccourcis, et il suffira ensuite d'une touche en face de l'icône désirée pour lancer l'application désirée. Cette zone tactile permettra également de faire défiler les documents et les pages web. Du côté du trackpad, on retrouve des fonctions à deux doigts similaires à celle proposées sur les Macbook d'Apple, avec des gestes permettant de zoomer, de faire tourner un document, etc...

La webcam 2MP propose aussi quelques fonctions destinées au monde professionnel. Tout d'abord, grâce à son auto-focus, elle permet de "scanner" des petits documents placés à quelques centimètres de l'objectif, puis d'effectuer dessus une reconnaissance de caractères. Vous pourrez ainsi transformer en un instant une carte de visite papier en carte de visite virtuelle. Autre atout de cette webcam : la reconnaissance de visages. Une fonction couramment utilisée sur les webcam pour suivre le sujet lors d'une vidéoconférence, mais qui trouve ici une nouvelle utilité : détecter automatiquement quand l'utilisateur s'éloigne de sa machine, et verrouiller la session après quelques instants, pour la protéger des regards indiscrets.

Enfin, Dell a poussé encore plus loin le concept "instant-on" déjà proposé sur plusieurs machines concurrentes. Pour rappel, il s'agit d'embarquer sur la machine un second système d'exploitation ultra léger, comprenant un navigateur web, un client mail, un agenda... Mais alors que ce système était utilisé jusqu'à présent uniquement pour accélérer le démarrage, Dell a aussi cherché à offrir une grande autonomie lors de son utilisation : le Latitude Z comprend un second processeur dédié à cet usage, processeur similaire à ceux qu'on trouve dans les smartphone, et garantissant donc une très bonne autonomie.

Le reste de la configuration est plus classique : écran 16/9ème de 16 pouces 1600x900 rétroéclairé par LED, processeur Intel Core 2 Duo SU de 1.4 à 1.6 GHz, jusqu'à 4 Go de mémoire et 512 Go de stockage sur un à deux SSD, le Wi-Fi N, une puce graphique intégrée Intel GMA 4500MHD, un clavier rétroéclairé, garantie 3 ans extensible à 5 ans... La machine pèse moins de 2 kg et ne mesure que 14.5mm d'épaisseur (!!!), ce qui en fait le 16" le plus fin et le plus léger du marché. Mais cette taille de guêpe est obtenue au détriment du lecteur optique, qui sera obligatoirement externe (graveur DVD 8x eSATA ou lecteur Blu-Ray 4x/graveur DVD eSATA) et probablement de l'autonomie, puisque la batterie n'est qu'une 4 cellules (8 cellules en option), qui risque de ne pas être très à l'aise, même avec un processeur ULV... La connectique est également assez limitée, avec seulement 1 port USB, un port partagé USB/eSATA, un DisplayPort, un RJ-45 et un connecteur pour casque-micro. En option, on trouvera également un lecteur d'empreinte digitales, un lecteur de cartes à puces RFID, une carte 3G/GPS.

La version de base, dotée d'un processeur à 1.4 GHz, de 2 Go de RAM, de 64 Go de SSD et du lecteur DVD est facturée 1999$. À ce prix, il faudra ajouter 398$ pour profiter de la recharge sans-fil, 349$ pour le dock sans-fil, 125$ pour la 3G et le GPS... Toutes options, on atteint la coquette somme de 4667$ ! Ouch, va falloir gagner au loto :'(

Pour la plaisir, la vidéo de présentation :

Posté par Matt le 30/09/2009 à 09h47

4 commentaires

Source : 59Hardware

Voici une information insolite qui sera sans doute très appréciée du côté de Redmond : alors que le gouvernement de la Wallonie avait entamé un virage vers le monde ouvert, en optant pour des logiciels et des formats de fichiers libres, il a entamé aujourd'hui une migration de Firefox vers... Internet Explorer 6 !

Officiellement, ce retour à Internet Explorer serait motivé par des raisons de compatibilité et de... sécurité ! Oui oui, vous avez bien lu, il y a encore des gens qui croient que ce bon vieux IE6 est un navigateur sûr, alors que Microsoft en "personne" a déjà plus d'une fois recommandé à ses utilisateurs de migrer vers IE7 ou IE8, qui ont énormément progressé en termes de sécurité.

La raison de la compatibilité est pour sa part bien plus crédible : IE6 était un navigateur très (trop) peu respectueux des standards, et qui dominait très largement le marché en son temps, à tel point qu'énormément d'applications web ont été développées en respectant la "norme IE6" plutôt que les véritables normes du web, ce qui rend ces applications incompatibles avec les navigateurs alternatifs. On peut alors comprendre que le coût de mises à jour de ces applications soit rédhibitoire et puisse pousser une administration à conserver IE6 tant que cela reste possible, pour retarder au maximum l'échéance du portage de ses applications.

Posté par Matt le 29/09/2009 à 22h58

Aucun commentaire

Source : Generation NT

Aujourd'hui, un des membres de la rédac' a connu une mésaventure avec son disque dur... Pour protéger son anonymat et lui éviter une humiliation publique, nous l'appellerons Gros_taureau. Cette mésaventure nous a permis de découvrir TestDisk, un petit logiciel qui peut s'avérer fort utile dans certaines situations.

Qu'est ce qui nous a ammené à découvrir ce logiciel ? Commençons par un résumé des faits. Peu avant 20h, Gros_taureau me contacte sur Gtalk, en mode panique :

Gros_taureau: Bon je viens de supprimer la partiti de sauvegarde de ecxt 3

Je vais me pendre

Matt: boulet

Gros_taureau: Ça a pas du formater c'est récupérable ?

En résumé, une partition de 1 To volatilisée, et bien sûr les données n'étaient qu'en un seul exemplaire (même si Gros_taureau appelle ça une partition "de sauvegarde"... prochaine étape, lui expliquer le concept de "sauvegarde" :-p), il fallait donc trouver une solution pour récupérer la partition en question.

Face à mon absence de solution, Gros_taureau a demandé à notre ami Google, qui lui a trouvé TestDisk, un logiciel sous licence GPL censé être capable de retrouver des partitions effacées de toutes sortes : NTFS, FAT, HFS, ext2, ext3, et bien d'autres... Restait à tester tout ça, mais Gros_taureau n'était pas très chaud à l'idée de tester directement sur son disque de 1 To. Comme j'avais sous le coude un disque "sacrifiable" contenant une partition système OS X (HFS+) et une partition FAT32, je me suis dévoué pour le test. Suppression des partitions sous Windows, lancement de TestDisk, analyse du disque (très rapide, une fraction de seconde !), et hop, il voit mes deux partitions :-) Réécriture de la table des partitions, vérification : les fichiers de la partition FAT32 sont tout a fait lisibles et le OS X de la partition HFS+ boote sans broncher. Mission accomplie pour TestDisk, qui connaitra le même succès avec le To de Gros_taureau.

TestDisk est distribué sous licence GPL et proposé précompilé pour DOS, Windows 9x, Windows NT (du 4 jusqu'à Vista et probablement 7), Linux et Mac OS X. En plus de la récupération de partition, il sait aussi réparer certaines structures de système de fichiers et retrouver des fichiers effacés. Il est également accompagné de PhotoRec, un logiciel de récupération de fichiers, capable de retrouver différents types de fichiers effacés, et en particulier les photos, d'où son nom.

Posté par Matt le 28/09/2009 à 22h46

3 commentaires

Même si Windows 7 reste avant tout une version optimisée de Vista, visant à en gommer certains défauts, il propose tout de même quelques nouveautés. Bonne nouvelle pour ceux qui utilisent Vista et n'ont pas l'intention de passer à 7 : une partie de ces nouveautés sera également disponibles sous Vista.

En effet, une "Plateform Upgrade" est proposée depuis peu aux beta testeurs. Au programme de cette mise à jour, les nouveautés suivantes :

- Windows Automation 3.0, pour faciliter la mise au point d'applications accessibles,

- Direct2D, la future remplaçante de GDI/GDI+, l'API 2D de Windows,

- Direct3D 11,

- DirectWrite, une API d'affichage de texte avec filtrage ClearType,

- une API de manipulation des documents XPS,

- Windows Ribbon Framework, pour la création d'application utilisant des rubans similaires à ceux d'Office 2007 au lieu des habituelles barres de menus et d'outils,

- Windows Animation Manager, pour la réalisation d'animations graphiques.

Vous pouvez d'ores et déjà télécharger cette mise à jour (à vos risques et périls, elle est encore en phase de beta) en téléchargeant un petit script sur le site de Microsoft, puis en lançant Windows Update ou Microsoft Update après avoir exécuté le script.

Posté par Matt le 24/09/2009 à 21h54

2 commentaires

Source : PCInpact

C'est cette semaine que se tient à San Francisco l'Intel Developer Forum 2009 (IDF), grande messe du fondeur, où il présente ses futurs produits et les grandes lignes prévues pour les évolutions futures. Parmi les prototypes présentés, il y a notamment un SSD PCI-Express particulièrement impressionnant...

Photo : PCWorld.fr

En effet, alors qu'Intel est pour l'instant encore absent de ce marché de niche, "colonisé" pour l'instant par OCZ et Super Talent, le prototype présenté à l'IDF risque bien de faire très mal à la concurrence : au format PCI-E 8x, il offrirait un débit de 4 Go/s, y compris sur les petites accès, puisqu'un test IOMeter annonce fièrement 1 millions d'I/O par seconde !

Peu d'informations ont par contre filtrées sur l'architecture du bestiau. Il semble être constitué de 4 ou 8 contrôleurs montés en RAID0 et associés à 40 ou 80 puces de mémoire flash. Cela signifierait également que les puces flash sont particulièrement rapide, en offrant des débits de 50, voir 100 Mo/s !

Intel n'a pour l'instant communiqué ni sur le prix, ni sur la disponibilité de ce SSD.

Posté par Matt le 24/09/2009 à 14h07

8 commentaires

Source : PCWorld.fr

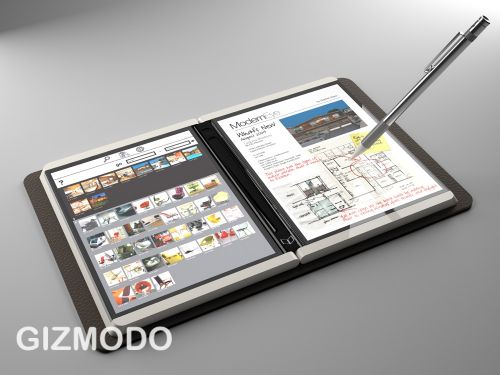

Après les relatifs échecs du Tablet PC, de l'UMPC et de sa table multimédia Surface, Microsoft semble bien décidé à ne pas baisser les bras et à continuer de proposer de nouveaux concepts à base d'écrans tactiles. Et le dernier en date semble particulièrement prometteur !

Baptisé Courier, il s'agit d'une tablette tactile multi-touch composée de deux écrans 7" positionnés de part et d'autre d'une charnière, permettant de plier l'appareil en deux pour le transport. Les dalles tactiles semblent être de type capacitif (c'est-à-dire ne nécessitant pas d'appuyer dessus, comme l'écran de l'iPhone) et pourra être contrôlé du bout des doigts ou avec un stylet pour des tâches nécessitant une plus grande précision (écriture par exemple).

La tablette embarquera bien entendu une connexion réseau sans-fil (3G ? Wi-Fi ?), mais aussi un appareil photo 3MP doté d'un zoom 4x et capable de filmer en 640x480. On n'en sait pour l'instant pas beaucoup plus sur le côté matériel.

Pour la partie logicielle, Microsoft a réalisé une interface très soignée, qui vise clairement à offrir une expérience utilisateur proche de celle que l'on pourrait avoir en manipulant un vrai carnet de notes en papier. Cette expérience est poussé jusque dans les moindre détails, puisque même la saisie des adresse web se fera de façon manuscrite, tandis qu'il sera possible de découper un morceau de document pour aller le coller dans le carnet de notes, sous forme d'image. Notre confrère Gizmodo propose une présentation vidéo de l'interface, à voir absolument !

Le meilleur pour la fin : la bestiole est déjà bien avancée et a largement dépassé le stade du prototype. On pourrait donc la voir sur le marché dans à peine quelques mois.

Posté par Matt le 23/09/2009 à 22h37

8 commentaires

Source : Gizmodo via Ptit_boeuf

C'est aujourd'hui qu'ATI a lancé sa nouvelle génération de cartes graphiques Radeon, en commençant par deux modèles haut de gamme : la Radeon HD 5870 et la Radeon HD 5850.

Pour ces cartes, les premières à être compatibles DirectX 11, ATI a sorti l'artillerie lourde. Ainsi, la Radeon HD 5870 embarque pas moins de 1600 Stream Processors, 80 unités de filtrage et 32 ROP, soit le double de ce dont la HD 4890 était doté, pour une même fréquence de fonctionnement. Elle embarque 1 Go de mémoire GDDR5 à 1.2 GHz sur un bus 512 bits. Grâce à la gravure en 40nm, sa consommation est similaire à celle d'une HD 4870 en charge, et très inférieure au repos. Elle sera facturée 350€.

Sa petite soeur, la HD 5850, reprend bien sûr la même architecture, mais dans une version légèrement amputée. On passe de 1600 à 1440 Stream Processors et de 80 à 72 unités de filtrage (les ROP restent au nombre de 32), tandis que les fréquences diminuent de 850 à 725 MHz pour le GPU et de 1.2 à 1.0 GHz pour la mémoire. Elle est disponible pour 240€, ce qui, compte tenu des caractéristiques, devrait lui conférer un bien meilleur rapport performances/prix.

Les deux cartes utilisent le même PCB, le même système de refroidissement et proposent quatre sorties vidéo (deux DVI, un HDMI et un DisplayPort), dont trois peuvent être utilisées en simultané. Une version de la HD 5870 dotée de 6 sorties mini-DisplayPort sera également proposé sous peu.

Côté performances, la Radeon 5870 emporte haut la main le titre de carte mono-GPU la plus performante du marché. Un titre qui n'était pas tombé entre les mains d'ATI depuis un certain temps... Selon les tests de nos confrères, la 5870 serait en pratique 60 à 70% plus rapide que la 4870 et 30 à 40% plus rapide que la 4890. Si ces performances sont plus que correctes, et même plutôt très bonnes, elles restent tout de même en dessous de ce qu'on aurait pu espérer, probablement à cause d'une bande passante mémoire un peu légère : alors que les performances brutes ont doublé par rapport à la 4890, la bande passante mémoire n'a augmenté que de 23%. La consommation en pratique tient également largement ses promesses, en particulier au repos, où la Radeon HD 5870 est et de loin la plus sobre des cartes haut de gamme actuelles, avec plus de 40W de gagnés par rapport aux Radeon 4870 et 4890.

Posté par Matt le 23/09/2009 à 21h53

Aucun commentaire

Au printemps dernier, MSI lançait le Wind U115, un netbook basé sur la plateforme Poulsbo (Atom Z) et doté d'un système de stockage hybride, lui permettant de revendiquer une autonomie record de 12h. Aujourd'hui le constructeur en remet une couche, avec le U110 ECO.

Ce petit frère du U115 en reprend les grandes lignes, avec un écran 10.1" 1024x600, un Atom Z530 à 1.6 GHz, 160 Go de disque dur et 1 Go de RAM. "ECO" oblige, il sacrifie par contre le système de stockage hybride, mais sera par contre proposé pour moins de 400$.

Mais là où MSI frappe fort, c'est que l'abandon du système de stockage hybride se fait sans perte d'autonomie. Au contraire, même, celle-ci atteindrait désormais les 15h. Comment ? En remplaçant tout simplement la batterie 6 cellules par une 9 cellules, permettant ainsi de compenser la consommation légèrement supérieure. Ce choix se ressent par contre sur la balance, avec 1.45 kg, contre 1.3 kg pour le U115.

Avec de tels chiffres sans le stockage hybride, on se prend à rêver également d'un "U115 ECO", doté du système hybride du U115 et de la batterie du U110 ECO. De quoi aller titiller les 20h d'autonomie ?