Actualités du mois de mai 2010 (Matériel)

En effet, avec 2984 TFlops (milliards d'opérations en virgule flottante par seconde) de puissance brute théorique, le calculateur Nebulae du National Supercomputing Centre in Shenzhen surpasse de 28% la puissance brute de Jaguar, un supercalculateur américain appartenant à l'Oak Ridge National Laboratory, qui était le plus puissant depuis la liste de novembre 2009.

Fabriqué par le chinois Dawning, ce calculateur n'est toutefois pas de technologie chinoise, puisqu'il est construit sur la base de processeurs Intel Xeon X5650 et de cartes graphiques nVidia Tesla Fermi C2050. Le processeur chinois Godson n'a pas encore sa place dans ce genre de machines ! De plus, les Chinois ne semblent pas encore complètement maitriser cette débauche de puissance brute, puisque les mesures sous Linpack, le benchmark officiel du Top500, ne donnent "que" 1271 TFlops, soit un rendement de 42%, alors que le Jaguar, construit par Cray et basé uniquement sur des processeur classiques (AMD Opteron 6 cœurs à 2.6 GHz) atteint un rendement de 75%, qui lui permet de conserver la première place du classement officiel, avec 1759 TFlops.

Le second calculateur chinois (à base de Xeon et de Radeon) souffre d'ailleurs du même problème de rendement, avec seulement 47%, ce qui le classe 7ème, alors qu'il pointe au 4ème rang en puissance brute, tandis que le 3ème calculateur chinois fait encore pire : 5ème en puissance brute, il est seulement 19ème au Linpack, avec un rendement de seulement 18%. À la décharge des Chinois, ce faible rendement peut en grande partie être imputé à l'architecture hybride CPU/GPU, tous les calculateurs utilisant ce type d'architecture ayant un rendement inférieur à ceux utilisant exclusivement des CPU.

Côté français, le calculateur le plus puissant est une machine SGI Jade basé sur des processeurs Intel Xeon et appartenant au GENCI-CINES (Grand Equipement National de Calcul Intensif - Centre Informatique National de l'Enseignement Supérieur), qui se classe 18ème, avec 237.8 TFlops, tandis que la plus puissante machine d'un constructeur français est située au Forschungszentrum Juelich en Allemagne, et occupe la 14ème position avec 274.8 TFlops au compteur. Il s'agit d'une machine à base de processeur Intel Xeon, fabriquée par Bull et Sun.

Posté par Matt le 31/05/2010 à 22h19

Aucun commentaire

Source : Tom's Hardware

Après avoir annoncé il y a quelques mois le report du lancement de ses premières cartes graphiques issues du projet Larrabee, Intel a finalement annoncé l'abandon total de ce projet.

En effet, le fondeur a indiqué sur son blog ne plus avoir l'intention de lancer des cartes graphiques dans un avenir proche, préférant se concentrer sur les puces graphiques intégrées, qu'Intel intègre depuis peu directement dans certains de ses processeurs Core i et Atom, et non plus simplement dans le chipset.

Intel justifie ce choix par le fait que le marché des puces vidéo intégrées est un marché plus important et disposant d'un potentiel bien plus grand. L'arrivée prochaine de la très prometteuse architecture AMD Fusion, qui pousse l'idée de l'intégration CPU-GPU encore plus loin que l'architecture Intel Clarkdale : alors qu'Intel se contente de placer deux dies dans un même packaging, AMD prévoit de graver le CPU et le GPU dans un même die, les deux unités allant même jusqu'à partager la mémoire cache, et non plus seulement la RAM.

Posté par Matt le 27/05/2010 à 23h16

Aucun commentaire

Source : NotebookReview via Ptit_boeuf

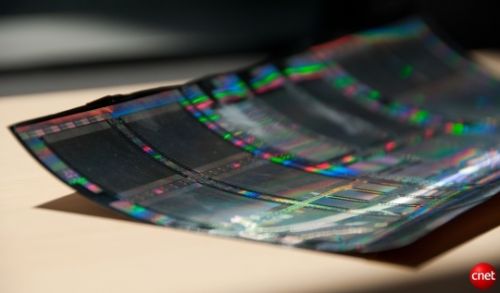

Comme nous le disions il y a à peine deux jours, les prototypes d'écrans OLED se suivent mais ne se ressemblent pas. Après Samsung et ses dalles transparentes, c'est maintenant au tour de Sony de le prouver, avec un prototype d'écran OLED enroulable.

D'une diagonale de 4.1" et d'une résolution de 432x240, ce prototype peut, grâce à sa souplesse et à son épaisseur de seulement 80 µm (soit un peu moins qu'une feuille de papier 80 g/m², dont l'épaisseur est de l'ordre de 100 µm), s'enrouler avec un rayon de courbure de seulement 4mm, y compris en fonctionnement. En outre, il gère 16.7 millions de couleurs et offre un taux de contraste de 1000:1 avec une luminosité de 100 cd/m², ce qui lui confère d'ores et déjà un rendu tout a fait correct comparé à la majorité des écrans LCD actuels.

Si Sony parvient à industrialiser ce procédé tout en conservant un coût raisonnable, il pourrait grandement contribuer au succès des livres électroniques, en permettant de les rendre beaucoup moins encombrants.

Posté par Matt le 27/05/2010 à 10h13

Aucun commentaire

Source : Tom's Hardware

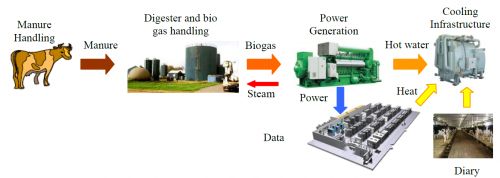

Après son datacenter refroidit à l'eau de pluie, qui permet d'économiser de l'électricité en réduisant grandement les besoins en climatisation. Les chercheurs de HP viennent de proposer une autre solution originale pour rendre les datacenters plus écologiques, en s'attaquant cette fois à la production électrique.

L'idée est cette fois d'utiliser un résidu très indésirable de l'agriculture : le méthane. Il s'agit d'un gaz à effet de serre très puissant (21 fois plus que le CO2) résultant de la décomposition des matières organiques en milieu anaérobie (sans oxygène). Mais contrairement au CO2, le méthane a l'avantage de pouvoir servir de source d'énergie, soit par combustion directe, soit dans une pile à combustible, en ne rejetant dans les deux cas que du CO2 et de l'eau.

Ainsi, les chercheurs d'HP estiment que la production de bouses d'un cheptel de 10 000 vaches (plus de 500 tonnes par jour !), récupérée dans une zone de stockage contenant des bactéries méthanogènes et chauffée à 40° (pour accélérer la réaction) pourrait produire suffisamment d'énergie pour alimenter un gros datacenter d'1 MW, tout en réduisant les nuisances émises par l'exploitation agricole.

Mieux, ce système pousse le concept du recylage dans ces derniers retranchements, puisque les résidus non gazeux de la méthanisation constituent un fertilisant biologique, tandis que la chaleur nécessaire pour accélérer la méthanisation est extraite du système de refroidissement des serveurs.

Avec un tel procédé, les "fermes de serveurs" n'auront jamais aussi bien mérité leur nom ! On notera toutefois que HP n'est pas le premier à avoir eu cette idée, certaines fermes étant déjà équipées de cuves de méthanisation et de générateurs électriques, qui réinjectent la production dans le réseau de distribution.

Posté par Matt le 26/05/2010 à 23h30

Aucun commentaire

Source : PCWorld

![]()

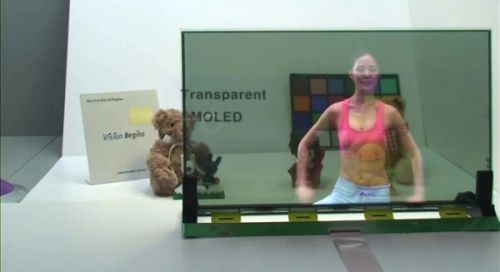

Alors que les écrans OLED sont toujours aussi "arlésiens" dans les diagonales supérieures à quelques pouces, les prototypes d'écrans OLED se suivent et ne se ressemblent pas... Pour preuve, le dernier prototype 19" de Samsung, qui se distingue des prototypes précédents par sa transparence.

En effet, la dalle que Samsung vient de présenter est une dalle AMOLED semi-transparente (laissant passer environ 30% de la lumière) de 19". Une telle dalle pourrait par exemple avoir son utilité pour les systèmes informatiques embarqués dans les voitures, et en particulier les GPS, en permettant d'offrir une plus grande surface d'affichage sans empiéter sur le champ de vision du conducteur. Toutefois, avant d'en arriver là, il faudra bien entendu une baisse du coût de revient, mais aussi probablement une transparence accrue, 30% pouvant s'avérer assez faible dans certaines situations.

Posté par Matt le 25/05/2010 à 23h15

Aucun commentaire

Source : Tom's Hardware

![]()

Si la supériorité des SSD en termes de performances ne fait aujourd'hui plus aucun doute, le problème du prix par rapport aux disques dur ne se résorbe que lentement, au fil de l'affinement des processus de gravure. Dans ce domaine, IMFT (Intel-Micro Flasg Technology) vient de se lancer dans la production d'une nouvelle génération de puces, gravées en 25nm.

Par rapport aux "anciennes" puces en 34nm, ces nouvelles puces offrent une densité deux fois supérieure (167mm² pour une puce de 8 Go, contre 172mm² pour une puce de 4 Go en 34nm), ce qui devrait donc quasiment diviser les prix par deux. Utilisant une interface ONFI 2.2, ces puces se distinguent aussi de la génération précédente par une augmentation de la taille des pages (8 Ko au lieu de 4 Ko) et de la taille des blocs (256 pages au lieu de 128 pages, soit 2 Mo au lieu de 512 Ko).

Ces changements d'organisation risquent malheureusement de compliquer la tâche des contrôleurs, puisque les principales difficultés rencontrées sont justement causées par la grande taille des unités d'adressage. On en saura un peu plus sur ce point en fin d'année, quand Intel lancera ses X25-M de troisième génération, qui devraient être proposées avec des capacités doublées au prix des modèles actuels.

Posté par Matt le 19/05/2010 à 22h29

Aucun commentaire

Source : PCWorld

![]()

Le constructeur Seagate devrait être en mesure de proposer cette année le premier disque dur de 3 To. Si cette capacité est dans l'ordre des choses et n'a rien de surprenant à l'heure actuelle, puisque les disques de 2 To existent depuis quelques temps déjà, elle risque de poser de sérieux problèmes de compatibilité, à cause de choix techniques faits dans les années 1980...

En effet, c'est à cette époque sur le système d'adressage LBA (Logical Block Addressing, rien à voir avec le jeu) a remplacé le CHS (Cylinder, Head, Sector). Avec ce système, le disque est divisé en blocs de 512 octets (les secteurs), disposant chacun d'une adresse. Celle-ci était initialement codée sur 28 bits, limitant donc la capacité des disques à 128 Gio (137 Go), puis est passée sur 48 bits depuis l'ATA6 (2002), repoussant ainsi la limité à 128 Pio (144 Po).

En théorie, donc, pas de problème pour un disque de 3 To. Mais en même temps que le LBA pour l'adressage, les constructeurs d'ordinateurs et éditeurs de systèmes d'exploitation ont adopté le MBR (Master Boot Record), un standard de définition de la "cartographie" des partitions du disque dur. Et là, c'est le drame : dans le MBR, la taille des partitions, en nombre de secteurs, est codée sur 32 bits. On se retrouve donc limité à 2^32 adresses, soit 2 Tio d'espace disque (2.2 To). Un disque de 3 To devra donc obligatoirement être coupé en au moins deux partitions, tandis qu'un disque ne pourra pas dépasser les 8 To (un MBR n'acceptant que 4 partitions physiques).

Il existe heureusement déjà une solution : le partitionnement GPT (GUID Partition Table), qui fait partie des spécifications EFI. Ce nouveau système de partitionnement a été défini bien plus récemment, et prend donc en compte les problématiques des grandes capacités. En théorie, le système GPT permet jusqu'à 128 partitions, sur des disques dur comportant jusqu'à 2^64 secteurs (soit 8 388 608 Pio... de quoi voir venir, d'autant plus que la taille des secteurs peut être revue à la hausse...). En formatant les disques de 3 To en GPT, il sera donc possible de les formater en une seule partition.

Tout va bien donc ? Non, pas tout a fait... En effet, les OS les plus répandus actuellement ne supportent pas tous le GPT dans toutes les situations... Ainsi (d'après l'articule sur la GPT de Wikipedia) :

- Windows XP 32 bits ou toute version antérieure : le GPT n'est pas du tout supporté,

- Windows 2003/Vista/2008/7 32 bits, XP/2003 64 bits : le GPT est supporté, mais pas pour le disque de démarrage,

- Windows Vista/2008/7 64 bits : le GPT est supporté et peut être utilisé sur le disque de démarrage, à condition de disposer d'une carte mère EFI,

- Mac OS X Intel : le GPT est supporté et peut être utilisé sur le disque de démarrage, à condition de disposer d'une carte mère EFI (ce qui est le cas de tous les Mac Intel).

- les pingouins sont les plus chanceux, puisque la plupart des distributions Linux 32 et 64 bits sont capables d'utiliser un disque GPT et de démarrer dessus, même avec une carte mère dotée d'un BIOS.

Au final, selon une responsable de chez Seagate, ce sont 80% des ordinateurs actuellement en service qui ne seraient pas pleinement compatibles avec les disques durs de plus de 2.2 To . Ouch !

Posté par Matt le 19/05/2010 à 10h18

Aucun commentaire

Source : PCInpact

Apple a discrètement (sans l'habituelle fermeture de leur boutique en ligne) mis à jour ce matin son Macbook "polycarbonate", le dernier ordinateur portable de sa gamme à être encore proposé avec un châssis en plastique.

Extérieurement, rien n'a changé, ni au niveau du design ou des dimensions, ni au niveau de la connectique (Ethernet, mini-DisplayPort, USB, jack audio), mais l'intérieur révèle quelques petites améliorations : le processeur Intel Core 2 Duo passe de 2.26 GHz à 2.4 GHz, le chipset passe du nVidia GeForce 9400M au nVidia GeForce 320M (qui équipe déjà les Macbook Pro 13" de dernière génération), et l'autonomie est revue à la hausse, la batterie 63.5 Wh affichant désormais 10 heures d'autonomie, au lieu de 7. Le reste des caractéristiques reste inchangé : 2 Go de mémoire (seulement !), écran 13" LED 1280x800 et 250 Go de disque dur.

Cette mise à jour apporte par contre une mauvaise nouvelle que les européens risquent d'avoir du mal à accepter : le prix américain reste inchangé, mais le prix européen augmente de 100€. La faute à la récente dégringolade de l'euro, qui avait d'ailleurs rendu le prix européen de ce modèle plus attractif que le prix américain ces dernières semaines. Le ticket d'entrée des ordinateurs portables Apple est donc désormais de 999€.

Posté par Matt le 18/05/2010 à 23h00

Aucun commentaire

Source : Macbidouille

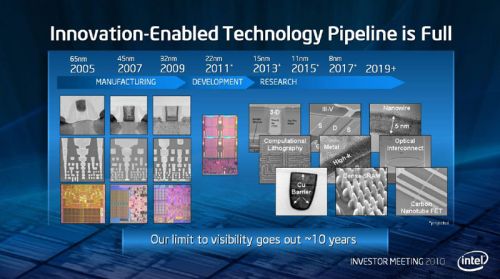

À l'occasion d'une conférence avec ses investisseurs, Intel a évoqué l'avenir des technologies de gravure et sa roadmap jusqu'au 8nm, alors que le fondeur travaille actuellement en 45 et en 32nm pour le gros de sa production.

Le passage vers le 8nm ne devrait selon Intel pas poser de problème majeur, si ce n'est le fait que chaque nouveau processus de gravure nécessite des étapes supplémentaires dans la fabrication des wafers. Le fondeur estime avoir dans ses cartons les technologies nécessaires pour arriver au 8nm d'ici à 2017, avec une étape intermédiaire tous les deux ans (22nm dès l'année prochaine, 15nm en 2013 et 11nm en 2015). Au delà de 2017, Intel évoque déjà quelques idées pour passer à 5nm, mais cette finesse n'arrivera pas avant 2019, année au delà de laquelle Intel manque encore pour l'instant de visibilité.

Investisseurs oblige, Intel a également évoqué la pérennité de ses installations. En effet, avec une finesse de gravure qui change tous les deux ans, la rentabilisation des équipements n'est pas toujours chose facile. Pour arriver à mieux amortir les équipements, Intel profite en fait de la diversité des puces qu'il produit : les processeurs bénéficient toujours d'une production dans les usines dernier cri, usine qui basculent ensuite sur la production de chipsets une fois qu'elle commence à être obsolète, puis termine sur la production de puces graphiques... C'est sans doute pour celà que les premières générations d'Atom, gravées en 45nm, étaient accompagnées d'IGP gravés en 90nm, tandis qu'aujourd'hui, les processeurs Core i gravés en 32nm sont packagés avec un IGP gravé en 45nm.

Posté par Matt le 13/05/2010 à 23h52

Aucun commentaire

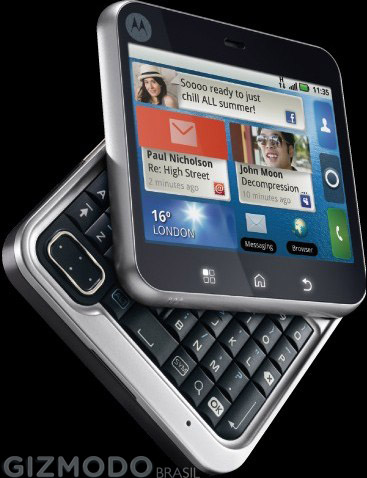

Depuis le lancement de l'iPhone, on peut déplorer une certaine uniformité du marché des smartphones, les modèles dotés d'un grand écran "wide" couvrant quasiment toute la surface sont devenus la norme, et seuls quelques modèles à clavier coulissant ou à clavier numérique subsistent. C'est pourquoi le FlipOut, futur modèle de Motorola mérite qu'on parle de lui...

En effet, non content de ne pas arborer les classique design "iPhone-like", il n'exploitera pas non plus un des autres formats éprouvé, puisqu'il va se présenter sous la forme d'un bloc... carré ! En usage normal, l'écran de 2.8" se retrouve du coup en mode paysage, avec une bordure noire en haut, comportant l'écouteur, et une en bas, qui comportera trois boutons, qui ont l'air tactiles d'après les photos. Bon par contre, faut pas déconner quand même, on retrouve tout autour de l'écran et de son cadre noire une bordure métallisée, qui pourrait presque faire passer l'appareil pour un prototype Apple, si un logo Motorola dans le coin supérieur gauche ne trahissait pas son origine.

Mais le FlipOut ne se limite pas à cette forme originale, puisqu'il embarque également un clavier alphanumérique coulissant, qui semble se dévoiler via un mouvement rotatif, et non pas un simple glissement longitudinal.

Côté technique, le FlipOut serait doté d'un processeur 700 MHz, de 256 Mo de RAM, d'un module GPS, d'un appareil photo 3MP et de (seulement) 512 Mo d'espace de stockage, le tout fonctionnant sous un système d'exploitation Android 2.1 accompagné de la surcouche Motorola Blur 1.5. Cette couche logicielle orientée réseaux communautaires et les coloris proposés par Motorola pour la coque (noir, vert et rose) trahissent laissent supposer que Motorola cible un public plus jeune qu'avec ses premiers smartphones Android.

Posté par Matt le 12/05/2010 à 10h50

1 commentaire

Source : Clubic

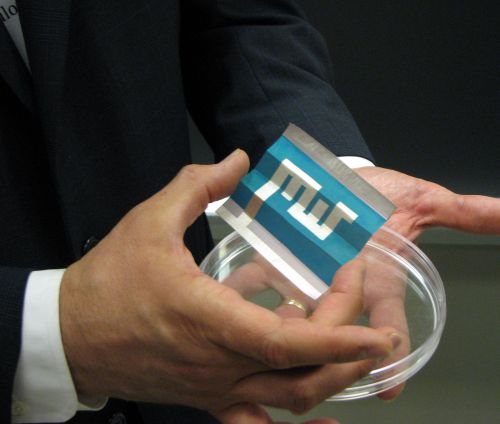

Bien que les moniteurs LCD puissent sembler être constitués de plastique, puisqu'ils sont quasiment toujours surmontés d'une couche de protection en plastique, leur dalle est en fait constituée de deux plaques de verre entourant la couche de cristaux liquides. Selon HP, ces deux couches de verre pourraient n'être qu'un lointain souvenir d'ici à une dizaine d'années.

En effet, le constructeur américain travaille activement à remplacer ces deux couches de verre par des films plastiques. Ceci pourrait permettre de réduire le prix des écrans, mais aussi leur poids, les films plastiques étant quarante fois plus légers que les plaques de verre.

Autre avantage, l'utilisation de plastique en lieu et place du verre devrait permettre d'arriver enfin à industrialiser les écrans souples promis depuis de nombreuses années. C'est d'ailleurs la première application commerciale envisagé par HP, qui prévoit de fournir de tels écrans dès l'année prochaine pour des applications militaires (donc probablement hors de prix...).

Il faudra donc sans doute encore quelques années avant que ces écrans se démocratisent pour le grand public, mais le premier pas est fait.

Posté par Matt le 11/05/2010 à 23h39

Aucun commentaire

Source : Tom's Hardware

Alors qu'Apple a démarré hier les pré-ventes de son iPad en France, Archos a lancé aujourd'hui un nouveau membre de sa gamme de tablettes, l'Archos 7 Home Tablet, qui vient se positionner entre l'Archos 5 Internet Tablet et l'Archos 9 PC Tablet.

Comme son nom l'indique, cette tablette embarque un écran 7" (18cm), plus petit que celui de l'iPad, mais en format "wide" (800x480, soit un ratio compris entre le 16/10 et le 16/9), ce qui devrait offrir une taille d'image équivalente à celle de l'iPad pour le visionnage de films, et une largeur suffisamment confortable pour le surf (mais il faudra scroller plus que sur la tablette Apple !).

Dotée au choix de 2 ou 8 Go d'espace de stockage (mémoire flash), elle fonctionne sous Android 1.5 et est animée par un processeur de type ARM Cortex A8 à 600 MHz (équivalent à un processeur d'iPhone 3GS) couplé à une puce dédiée au décodage vidéo HD 720p. Ces deux puces lui permettent d'atteindre une excellente autonomie (7h de vidéo, 44h de musique !) sans trop d'embonpoint (12mm d'épaisseur, 350g). Elle dispose d'une connectivité Wi-Fi et USB (soit en mode client, pour la connecter à un ordinateur, soit, en option, en mode hôte pour y connecter un disque dur ou une clé USB).

Mais là où Archos frappe particulièrement fort, c'est sur le prix de la bestiole : l'Archos 7 sera proposée à partir de 149€ pour la version 2 Go et 179€ pour la version 8 Go ! Même si ses caractéristiques techniques restent nettement inférieures à celles de l'iPad, vous aurez donc quasiment trois tablettes françaises de 8 Go pour le prix d'une américaine de 16 Go (499€). Voilà qui devrait ravir ceux qui trouvaient l'iPad trop cher et ceux qui voudraient s'amuser avec l'OS de Google à moindre goût, le tarif de 149€ étant également très inférieur à celui des smartphones Android.

On notera également que cette tablette pourra bénéficier des applications diffusées sur l'Appslib, une boutique en ligne spécifique à Archos, qui propose déjà un millier de références gratuites, mais aussi bien entendu de celles diffusées sur l'Android Market.

Posté par Matt le 11/05/2010 à 11h47

Aucun commentaire

Source : PCWorld

Décidément, les cartes graphiques nVidia occupent pas mal la rumeur ces derniers jours ! Ainsi, après la GTX 480M, la GTX 465, la GT 440 et la GT 420, c'est une hypothétique GTX 490 qui pointe le bout de son nez, pour constituer le nouveau haut de gamme de la marque.

La rumeur provient de Drew Henry, cadre haut placé de chez nVidia, selon qui la sortie d'une carte Fermi dotée de 512 cœurs ne serait pas exclue chez le caméléon. Pour rappel, les 512 cœurs étaient prévus depuis le début par nVidia, et toutes les GTX 470 et 480 actuelles sont en fait bien dotées d'un GPU à 512 cœurs, mais seuls 448 ou 480 sont actifs. Officiellement, la raison de cette activation partielle est la consommation élevée de la puce GF100, qui ne pourrait pas se contenter des 300W autorisés par la norme PCI-Express si tous les cœurs étaient activés. Officieusement, il se murmure que c'est le rendement particulièrement faible de la production du Fermi par TSMC qui serait à l'origine de ce choix, trop peu de puces ayant leurs 512 cœurs fonctionnels.

Cette future version dotée des 512 cœurs devrait être permise par l'amélioration des processus de gravure de TSMC, dont les rendements progressent petit à petit, et par la future révision B de la puce, prévue pour juillet, qui devrait permettre une nette baisse de la consommation, autorisant ainsi à faire fonctionner les 512 cœurs sans dépasser la limite des 300W.

La GTX 490 pourrait être disponible cet automne, soit à peu près en même temps que les GT 420 et GT 440.

Posté par Matt le 07/05/2010 à 11h21

Aucun commentaire

Source : Cowcotland

![]()

Réussir à exploiter la source d'énergie renouvelable et inépuisable que constitue le Soleil est aujourd'hui au cœur des préoccupations de nombreux programmes de recherche, principalement dans le domaine du thermique et celui du photovoltaïque. C'est dans ce dernier domaine que les chercheurs du MIT viennent de présenter une avancée importante, avec les premiers capteurs photovoltaïque sur papier.

Pour arriver à ce résultat, les chercheurs ont développée une technologie similaire au principe des imprimantes à jet d'encre, mais utilisant une "encre" à base de composés organiques semi-conducteurs, permettant ainsi la réalisation de capteurs photovoltaïques sur un substrat bien moins coûteux que le silicium ou le plastique. On peut également espérer que ce procédé soit moins polluant à la fabrication et permette un recyclage plus facile, voir qu'il permette un jour d'"imprimer" directement sur des toits ou des façades.

Revers de la médaille, ce procédé n'offre pour l'instant qu'un rendement de 2%, contre 20% pour les panneaux solaires classiques, ce qui signifie que pour une même capacité de production, il faudra multiplier par dix la surface couverte par les panneaux.

C'est pourquoi les chercheurs se donnent une dizaine d'année avant les premières applications commerciales, le temps d'industrialiser le procédé et d'améliorer son rendement.

Posté par Matt le 06/05/2010 à 22h09

Aucun commentaire

Source : Tom's Guide

Alors que les SSD allouent en général 7% de leur espace physique comme réserve d'espace libre (et donc non visible pour l'utilisateur), les SSD à base de contrôleurs SandForce SF-1200 et SF-1500 réservent 27% d'espace pour cet usage (d'où les capacités inhabituelles, multiples de 50 Go). Si cette augmentation est un bon signe pour la fiabilité, il n'en est pas de même pour la compétitivité...

En effet, le prix des SSD étant en grande partie dû au prix de la mémoire flash, le prix au Go "utile" s'envole forcément quand l'espace de réserve augmente : par rapport à un SSD classique, on passe d'un surcoût de 7.5% à un surcoût de 37%. Pour palier partiellement à ce surcoût, certains constructeurs de SSD à base de contrôleur SandForce SF-1200 vont prochainement déployer de nouveaux firmwares, qui réduiront cette espace de réserve à environ 13%, passant ainsi les capacités des SSD de multiples de 50 Go à multiples de 60 Go.

D'après les tests d'AnandTech sur un OCZ Agility 2 doté d'un tel firmware, les performances ne seraient pas impacté, ce qui est plutôt bon signe, puisqu'on disposera alors de 20% d'espace en plus pour le même prix, sans pertes de performances.

Il est d'ailleurs à noter que cet espace de réserve de 13% pour le SF-1200 faisait partie des plans initiaux de SandForce, ajoutant ainsi une distinction supplémentaire par rapport au SF-1500.

Du côté des constructeurs de SSD, il faudra donc surveiller à l'avenir ceux qui proposeront ces nouveaux firmware. Corsair à d'ores et déjà annoncé que les modèles Force 100 et Force 200 seront remplacé par des Force 120 et Force 240, sans préciser toutefois si les 100/200 pourront être mis à jour en 120/240. Chez OCZ, des Agility 2 de 60, 120 et 240 Go seront lancés, mais les versions 50, 100 et 200 Go resteront commercialisées si la demande existe, et OCZ envisage d'offrir la possibilité de les mettre à jour en réduisant l'espace de réserve. Le Vertex 2 restera par contre à 50/100/200 Go.

Posté par Matt le 06/05/2010 à 19h41

Aucun commentaire

Source : Hardware.fr

Alors que la précédente génération de GPU nVidia, les G200, avait été peut déclinée, le gros de l'entrée et du milieu de gamme étant resté sur la génération précédente (G90), nVidia semble bien décider à enfin renouveler son entrée et son milieu de gamme avec des GPU de dernière génération dérivés du GF100, plus connu sous le nom de Fermi.

Ainsi, après les très décriées GTX 470 et GTX 480, nVidia aurait dans les cartons différents modèles dont les prix s'échelonneraient entre 100 et 250$ et basées sur les GPU GF104, GF106 et GF108.

Le GF104, le plus haut de gamme des trois, serait constitué de 352 cœurs CUDA cadencés à 1215 MHz (contre 607 pour le reste du GPU), contre 448 cœurs à la même fréquence pour les GTX 470 et 480 cœurs sur le GTX 480. Le bus mémoire DDR5 passerait à 256 bits au lieu de 320 et 384 bits, avec une fréquence très légèrement revue à la baisse (1603 MHz au lieu de 1674 et 1848 MHz). Le nom commercial serait GTX 465 et la carte devrait être vendue environ 250$ dès le mois prochain.

Quasiment aucune caractéristique n'est connue pour les GF106 et GF108. Il s'agira probablement comme d'habitude de versions dotées d'un moins grand nombre d'unités de traitement et/ou d'une fréquence revue à la baisse. La puce GF106 équipera les cartes GT 440, vendus environ 180$, tandis que la GF108 amènera le ticket d'entrée DirectX 11 de nVidia à environ 100$ au sein des cartes GT 420. Ces cartes graphiques devraient arriver pour la rentrée, en septembre prochain.

Posté par Matt le 05/05/2010 à 23h56

Aucun commentaire

Sources : TT-Hardware et PCWorld

Bien que particulièrement peu gourmande pour du x86, la plateforme Atom est encore beaucoup trop gourmande pour lutter contre les processeur ARM dans le domaine des smartphones et des mobile Internet devices (MID). Un domaine auquel Intel compte toutefois bien s'attaquer avec la plateforme Moorestown.

Déjà promise depuis plus d'un an, cette plateforme est désormais disponible, sous la référence Atom Z600. Composée d'un SoC comprenant le processeur Atom (cadencé de 1.5 à 1.9 GHz selon les versions), le contrôleur mémoire, la puce graphique et un encodeur-décodeur vidéo HD (lecture 1080p, encodage 720p), cette nouvelle plateforme est gravée en 45nm.

Comme annoncé il y a un an, cette nouvelle plateforme consomme 50x moins que la précédente en standby (soit environ 30 mW), 20 fois moins en lecture audio et 2 à 3 fois moins en lecture vidéo et un utilisation Internet. Deux nouveaux modes d'économie d'énergie pourront même faire chuter la consommation encore bien plus bas, à seulement 100 µW. Les performances ont également été fortement améliorés pour l'exécution du JavaScript et pour la lecture et l'enregistrement vidéo, grâce à la puce d'encodage/décodage dédiée. En option, une puce réseau pourra gérer les connectivités sans-fil indispensables à un MID (Wi-Fi, WiMAX, 3G).

Il ne reste maintenant plus qu'à attendre les premiers produits basés sur cette nouvelle plateforme, pour vérifier sur le terrain si elle peut se mesurer aux solutions ARM.

Posté par Matt le 05/05/2010 à 22h29

Aucun commentaire

Source : Generation NT

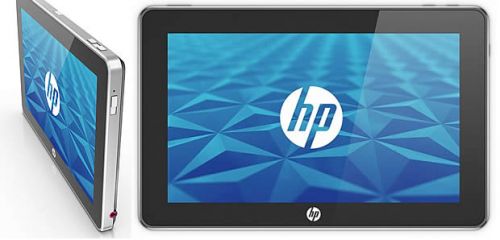

HP n'aura pas trainé bien longtemps après son rachat de Palm pour faire les premières annonces de ces intentions. En effet, alors que leur tablette tactile Slate sous Windows 7, présentée par Steve Balmer il y a quelques mois, était annoncée comme abandonné il y a quelques jour, la voici renaître, marquée par le sceau de Palm...

En effet, la principale motivation à l'abandon de la tablette Slate était son système d'exploitation Windows 7, qui imposait l'utilisation d'un processeur x86, bien trop gourmand pour pouvoir réaliser une tablette compétitive face à celle d'Apple en termes d'autonomie et de dimensions, tandis que la licence de Windows 7 représentait en plus un surcoût non négligeable sur le coût de revient de la machine.

Mais en rachetant Palm, HP a mis la main par la même occasion sur webOS, le système qu'avait développé Palm pour son smartphone Pre. Celui-ci fonctionnant sur processeur ARM, HP va ainsi pouvoir réaliser une tablette dotée d'une meilleure autonomie et moins coûteuse à fabriquer. Le reste des caractéristiques devrait rester à peu près équivalent, avec un écran tactile multi-touch 1024x600, un port USB, un slot SD, deux capteurs photo. Une version 3G serait également prévu, ce qui ne devrait pas poser de problème pour webOS. On peut également espérer que le passage au ARM permettra d'affiner un peu plus la tablette, pour la rapprocher de la finesse de l'iPad.

Posté par Matt le 04/05/2010 à 21h07

Aucun commentaire

Source : Tom's Hardware

Bien qu'nVidia n'ait pas encore évoqué l'arrivée d'une déclinaison mobile de sa récente puce Fermi, une fuite en provenance du site du fabricant Eurocom laisse présager l'arrivée prochaine d'une puce Fermi dédiée aux ordinateurs portables.

En effet, le site référence une machine haut de gamme "transportable", le X8100 Leopard, dont les options de cartes graphiques comportent une GTX 480M, accompagnée de 2 Go de mémoire GDDR5. Malgré les habitudes de nVidia en matière de nommage de cartes, il y a fort à parier qu'il s'agisse bien là d'une déclinaison mobile de la puce Fermi qui équipe les GeForce GTX 470 et 480.

Par rapport à sa version pour ordinateurs de bureau, cette puce mobile risque toutefois d'être fortement amputée. En effet, les cartes graphiques GeForce GTX 480 ont un TDP de 250W, et une consommation réelle frisant les 300W, ce qui est totalement incompatible avec un châssis d'ordinateur portable. Selon Eurocom, le TDP de la GTX 480M aurait été ramené à 100W, ce qui reste énorme pour une puce mobile, mais devrait être refroidissable dans les châssis "transportables".

Reste à attendre l'annonce officielle de nVidia pour voir comment le caméléon a pu obtenir cette baisse de consommation. On peut s'attendre à des fréquences revues à la baisse, mais aussi à un nombre d'unités de traitement fortement diminué.